Nvidia è sempre più attiva nel campo dell’intelligenza artificiale e dell’HPC, l’high performance computing, con soluzioni tese a spingere sempre più in alto le prestazioni e la produttività in questi settori.

Nvidia Magnum IO è una nuova suite software progettata per aiutare data scientist e ricercatori che operano negli ambiti dell’intelligenza artificiale e dell’high performance computing a elaborare enormi quantità di dati in un breve lasso di tempo.

L’azienda parla di miglioramenti che consentono di processare dati in minuti anziché ore.

Magnum IO, ha spiegato Nvidia, è ottimizzato per eliminare i colli di bottiglia presenti nello storage e nell’input/output: offre un’elaborazione dei dati fino a 20 volte più veloce per nodi di calcolo multi-server e multi-GPU che lavorano con enormi dataset per eseguire complesse attività di analisi finanziaria, modellizzazione climatica e altri workload di high performance computing.

Magnum IO, ha spiegato Nvidia, è ottimizzato per eliminare i colli di bottiglia presenti nello storage e nell’input/output: offre un’elaborazione dei dati fino a 20 volte più veloce per nodi di calcolo multi-server e multi-GPU che lavorano con enormi dataset per eseguire complesse attività di analisi finanziaria, modellizzazione climatica e altri workload di high performance computing.

Magnum IO è stato sviluppato in stretta collaborazione con aziende leader dei settori del networking e dello storage, tra cui DataDirect Networks, Excelero, Ibm, Mellanox e WekaIO.

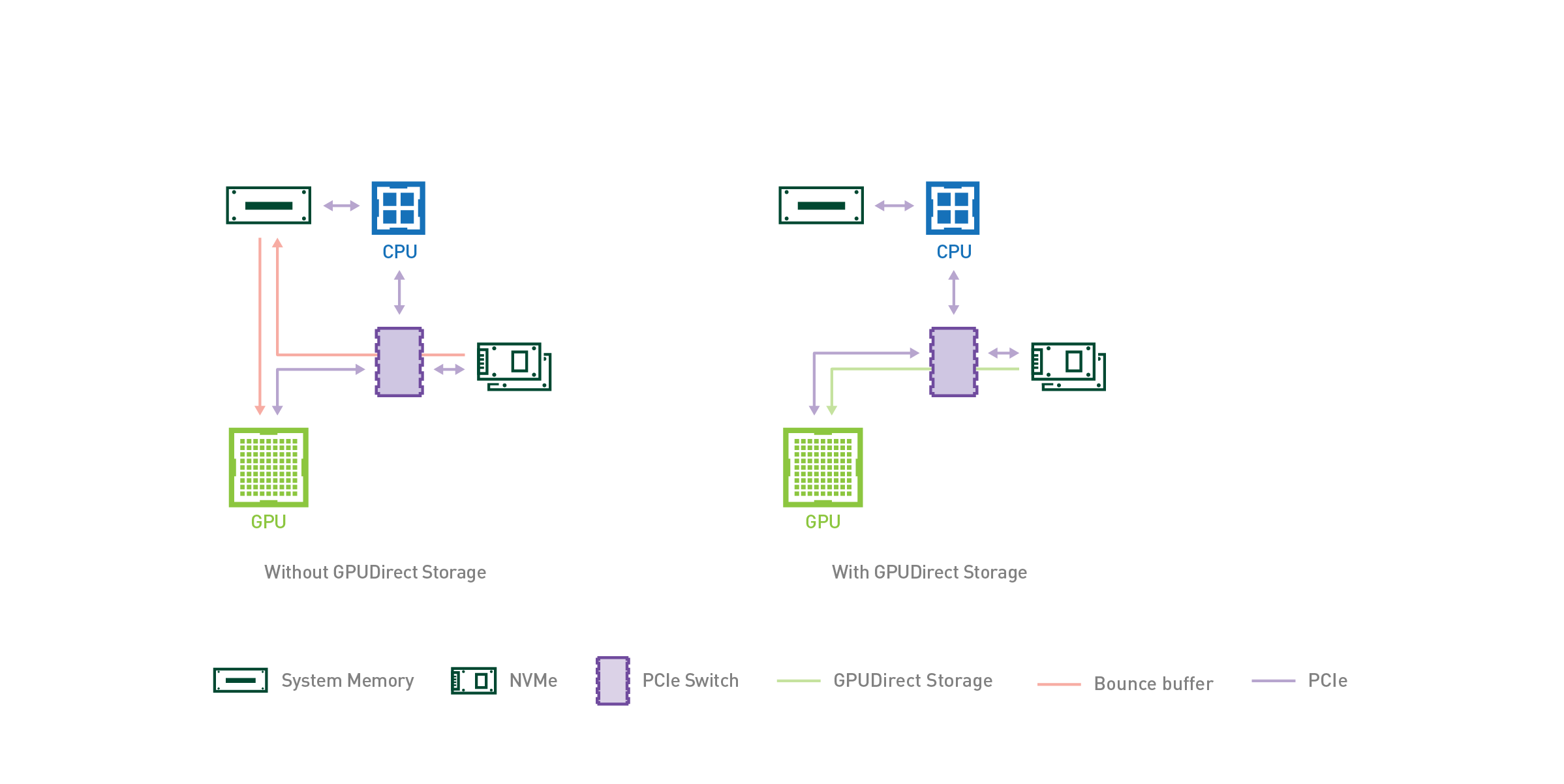

Al nucleo di Magnum IO c’è GPUDirect, che fornisce un percorso con cui i dati possono bypassare le CPU per accedere a GPU, dispositivi di archiviazione e di rete. GPUDirect è compatibile con una vasta gamma di interconnessioni e API di comunicazione, tra cui Nvidia NVLink e NCCL, nonché OpenMPI e UCX, ed è composto da elementi peer-to-peer e RDMA.

Il suo componente più recente, GPUDirect Storage, consente di bypassare le CPU quando è richiesto l’accesso allo storage e pertanto permette di accedere in modo diretto e rapido ai file, un miglioramento importante ad esempio per i ricercatori che elaborano grandi quantità di dati per simulazioni, analisi o visualizzazioni.

Il suo componente più recente, GPUDirect Storage, consente di bypassare le CPU quando è richiesto l’accesso allo storage e pertanto permette di accedere in modo diretto e rapido ai file, un miglioramento importante ad esempio per i ricercatori che elaborano grandi quantità di dati per simulazioni, analisi o visualizzazioni.

Il software Nvidia Magnum IO è già disponibile, tranne per GPUDirect Storage, di cui c’è al momento solo un early-access per alcuni clienti selezionati e di cui è previsto un rilascio su più ampia scala nella prima metà del 2020.

Nvidia sui server Arm-based

Non è questa l’unica novità dell’azienda californiana. Nvidia ha infatti svelato una reference design platform che aiuta le aziende a creare rapidamente server basati su Arm con accelerazione GPU. Tale piattaforma di progettazione di riferimento, ha spiegato Nvidia, è costituita da componenti hardware e software e risponde alla crescente domanda della comunità HPC di impiegare una gamma più ampia di architetture CPU.

L’obiettivo è quello di consentire ai centri di supercomputer, agli operatori di cloud hyperscale e al mercato enterprise di sfruttare i vantaggi di entrambe le piattaforme, quella di elaborazione accelerata di Nvidia insieme alle più recenti soluzioni server basate su Arm.

Nella costruzione della reference platform Nvidia sta collaborando naturalmente con Arm e con i partner del suo ecosistema, tra i quali Ampere, Fujitsu e Marvell, per garantire che le GPU dell’azienda funzionino perfettamente con i processori Arm-based. La piattaforma di riferimento beneficia anche, sottolinea Nvidia, di una forte collaborazione con Cray, società Hewlett Packard Enterprise, e HPE, due tra gli early provider di server Arm-based.

Nella costruzione della reference platform Nvidia sta collaborando naturalmente con Arm e con i partner del suo ecosistema, tra i quali Ampere, Fujitsu e Marvell, per garantire che le GPU dell’azienda funzionino perfettamente con i processori Arm-based. La piattaforma di riferimento beneficia anche, sottolinea Nvidia, di una forte collaborazione con Cray, società Hewlett Packard Enterprise, e HPE, due tra gli early provider di server Arm-based.

Inoltre, una vasta gamma di società di software HPC ha utilizzato le librerie Nvidia Cuda-X per creare strumenti di gestione e monitoraggio abilitati dalla GPU che girano su server Arm-based.

Facendo seguito al suo annuncio di qualche mese fa, Nvidia sta rilasciando una preview del suo software development kit compatibile con Arm, costituito da librerie Nvidia Cuda-X e strumenti di sviluppo per l’accelerated computing.