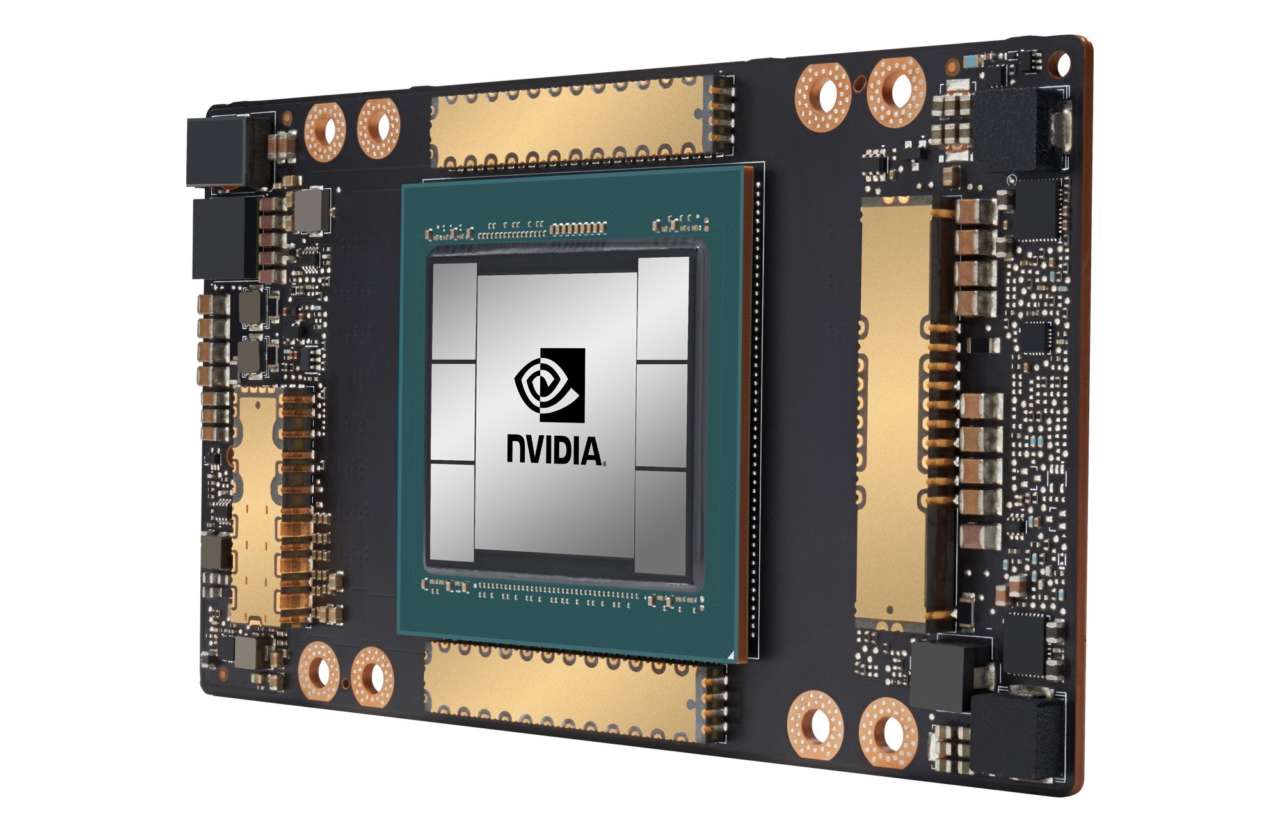

Nvidia ha annunciato che la sua prima Gpu basata sull’architettura Ampere, Nvidia A100, è in piena produzione e pronta per essere spedita ai clienti di tutto il mondo.

Per l’azienda specializzata in processori grafici, la Gpu Nvidia A100 rappresenta una svolta nella progettazione tecnica, alimentata da cinque innovazioni chiave.

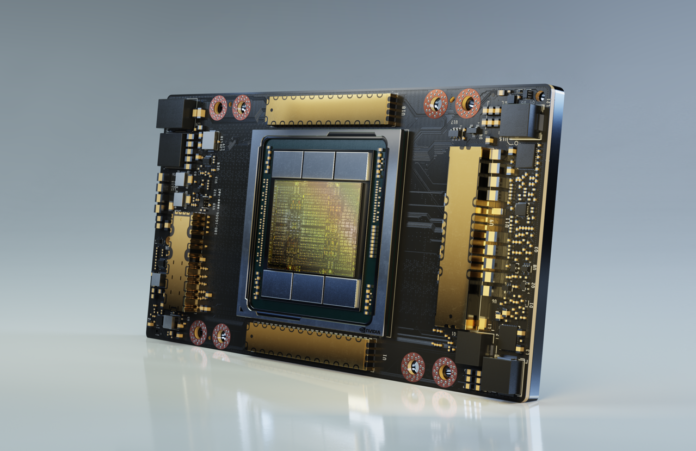

Al centro dell’A100 c’è l’architettura Gpu Nvidia Ampere, che, con gli oltre 54 miliardi di transistor, è il più grande processore al mondo con tecnologia a 7 nanometri.

La tecnologia Tensor Core di terza generazione è ora ancora più flessibile, veloce e facile da usare. Tra le funzionalità avanzate dei Tensor Core c’è il nuovo formato TensorFloat-32 (TF32), che consente di raggiungere fino a 20 volte le prestazioni di intelligenza artificiale della precisione FP32, senza alcuna modifica del codice. Inoltre, i Tensor Core ora supportano FP64, offrendo fino a 2,5 volte più capacità di calcolo rispetto alla generazione precedente, per le applicazioni di high-performance computing (Hpc).

Multi-Instance Gpu, o Mig, è una nuova funzionalità tecnica che consente di partizionare una singola Gpu A100 in fino a sette Gpu separate, in modo da poter fornire vari gradi di capacità di computing per carichi di lavoro di diverse dimensioni, offrendo un utilizzo ottimale e massimizzando il ritorno sugli investimenti.

La tecnologia di interconnessione Nvidia NVLink di terza generazione raddoppia la connettività ad alta velocità tra le Gpu per fornire un efficiente ridimensionamento delle prestazioni in un server.

Infine, le nuove tecniche di ottimizzazione dell’efficienza dell’architettura Ampere sfruttano la natura intrinseca delle reti neurali e della matematica dell’intelligenza artificiale per raddoppiare le prestazioni, ottenendo il 50% di “sparsity”.

Queste caratteristiche portano Nvidia a dichiarare che l’architettura Ampere offre il più grande balzo in avanti delle prestazioni fino ad oggi, tra le sue otto generazioni di Gpu, per unificare il training e l’inferenza di intelligenza artificiale e incrementare le prestazioni fino a 20 volte rispetto ai prodotti predecessori.

Combinate, le nuove funzionalità rendono la Gpu Nvidia A100, sottolinea la società produttrice, ideale per carichi di lavoro diversi e impegnativi, tra cui training e inferenza di intelligenza artificiale, così come simulazione scientifica, intelligenza artificiale conversazionale, sistemi di raccomandazione, genomica, data analytics ad alte prestazioni, modellazione sismica e previsioni finanziarie.

Nvidia ha anche reso noto che i principali fornitori di servizi cloud e costruttori di sistemi al mondo prevedono di incorporare Gpu A100 nelle loro offerte; tra questi: Alibaba Cloud, Amazon Web Services (Aws), Atos, Baidu Cloud, Cisco, Dell Technologies, Fujitsu, Gigabyte, Google Cloud, H3C, Hewlett Packard Enterprise (Hpe), Inspur, Lenovo, Microsoft Azure, Oracle, Quanta/QCT, Supermicro e Tencent Cloud.

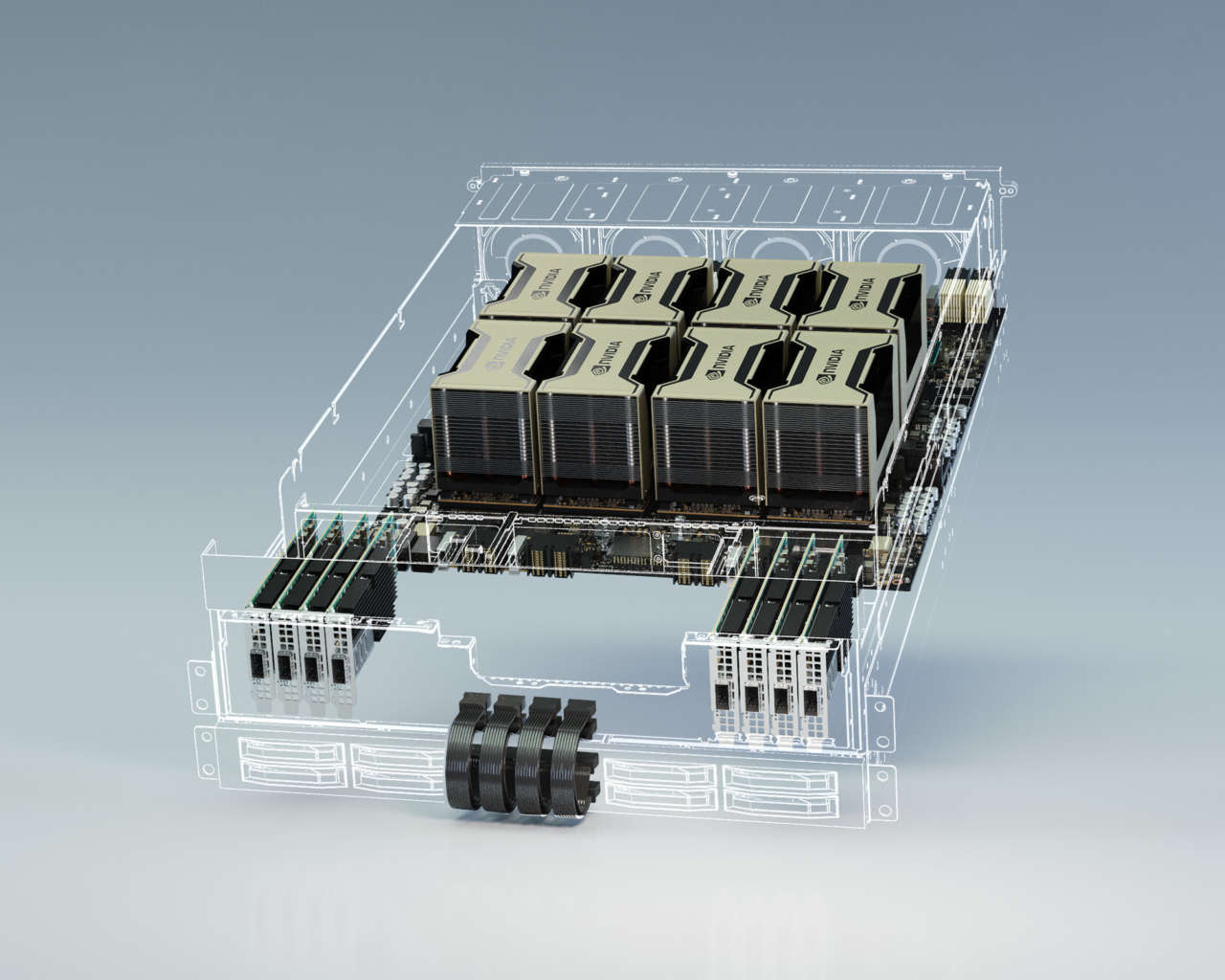

Inoltre l’azienda ha annunciato il sistema Nvidia DGX A100, che dispone di otto Gpu A100 interconnesse con Nvidia NVLink. Nvidia DGX A100 è una soluzione universale per tutti i carichi di lavoro di intelligenza artificiale, che offre densità di elaborazione, prestazioni e flessibilità, in un sistema da 5 petaFlops. Consente alle aziende di consolidare training, inferenza e analisi in un’infrastruttura per l’intelligenza artificiale unificata e di facile implementazione.

Oltre a questo sistema, Nvidia ha creato anche HGX A100, una baseboard integrata per server disponibile in più configurazioni Gpu.

HGX A100 a quattro Gpu offre una completa interconnessione tra le Gpu mediante NVLink, mentre la configurazione da otto Gpu offre una larghezza di banda piena Gpu-to-Gpu tramite Nvidia NVSwitch.

La piattaforma HGX A100, grazie alla nuova tecnologia Mig, può essere configurata come 56 Gpu più piccole, ciascuna più veloce di una Nvidia T4, fino a un potente server da otto Gpu con 10 petaflop di prestazioni di intelligenza artificiale.