Google Cloud ha annunciato l’ampliamento alle altre regioni in tutto il mondo della disponibilità generale delle Gpu T4 di Nvidia. L’aggiunta delle Nvidia T4 da parte di Big G era avvenuto dapprima con una fase alpha e poi, all’inizio dell’anno, con la versione beta.

L’azienda aveva poi annunciato la disponibilità in otto regioni in occasione del Google Cloud Next 19. Quale primo tra i maggiori provider cloud a implementare la Gpu T4 di Nvidia basate su tecnologia Tensor Core.

Queste Gpu sono progettate per accelerare e scalare un’ampia varietà di carichi di lavoro su cloud. Dall’High Performance Computing (Hpc) alle attività di training e inferenza del machine learning, dai data analytics alla grafica avanzata.

Queste Gpu sono progettate per accelerare e scalare un’ampia varietà di carichi di lavoro su cloud. Dall’High Performance Computing (Hpc) alle attività di training e inferenza del machine learning, dai data analytics alla grafica avanzata.

Nvidia T4, velocità ed efficienza su Google Cloud

Ogni Gpu T4 dispone, spiega Google Cloud, di 16 GB di memoria grafica incorporati. Offre inoltre il supporto per una vasta gamma di tipi di dati e di precisioni: FP32, FP16, INT8 e INT4. La Gpu si basa sulla tecnologia Nvidia Tensor Core per un training più veloce. Nonché sulla accelerazione hardware RTX per calcoli di ray tracing più rapidi.

I clienti Google Cloud, spiega ancora l’azienda, possono creare configurazioni VM personalizzate che soddisfino al meglio le loro esigenze. Con fino a quattro GPU T4, 96 vCPU, 624 GB di memoria host e opzionalmente fino a 3 TB di SSD locale in-server.

L’architettura Turing di Nvidia porta con sé la seconda generazione di Tensor Core sulla Gpu T4. Tensor Core ha debuttato nella Gpu per data center Nvidia V100, disponibile anch’essa su Google Cloud Platform. Tensor Core supporta la precisione mista per accelerare le operazioni di moltiplicazione di matrici, particolarmente diffuse nei workload di machine learning.

L’architettura Turing di Nvidia porta con sé la seconda generazione di Tensor Core sulla Gpu T4. Tensor Core ha debuttato nella Gpu per data center Nvidia V100, disponibile anch’essa su Google Cloud Platform. Tensor Core supporta la precisione mista per accelerare le operazioni di moltiplicazione di matrici, particolarmente diffuse nei workload di machine learning.

Accelerazione con costi più bassi

Se il workload di training del cliente non sfrutta appieno la più potente V100, spiega Google, il modello T4 offre i vantaggi dell’accelerazione Tensor Core, ma a un prezzo inferiore.

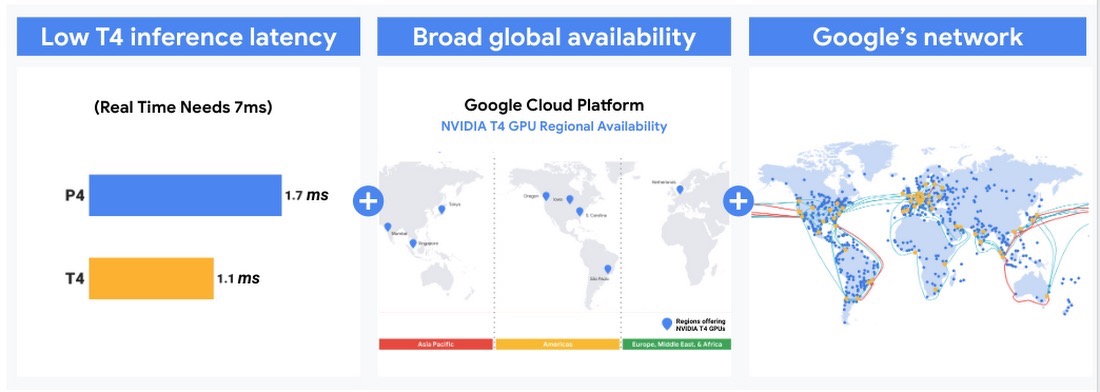

Tensor Core accelera anche l’inferenza, o le previsioni generate dai modelli di machine learning, per bassa latenza o throughput elevato. Quando i Tensor Core sono attivati con precisione mista, le Gpu T4 su GCP possono accelerare l’inferenza su ResNet-50 più di 10 volte più velocemente con TensorRT rispetto all’esecuzione solo su FP32.

Grazie alla disponibilità globale e alla rete ad alta velocità di Google, Nvidia T4 su GCP può servire servizi globali che richiedono un’esecuzione rapida a un prezzo più conveniente.

Grazie alla disponibilità globale e alla rete ad alta velocità di Google, Nvidia T4 su GCP può servire servizi globali che richiedono un’esecuzione rapida a un prezzo più conveniente.

Le Gpu Nvidia T4 offrono anche valore nei carichi di elaborazione in batch di HPC e rendering. Fornendo le prestazioni e l’efficienza necessari a ottimizzare i deployment su larga scala. Sono inoltre un’ottima opzione per l’esecuzione di workstation virtuali da parte di ingegneri e professionisti della creatività.

Maggiori informazioni e prezzi sono disponibili sulla pagina dedicata alle Gpu del sito di Google Cloud, a questo link.