Nvidia ha annunciato il lancio di TensorRT 8, l’ottava generazione del kit di sviluppo software di intelligenza artificiale della società, per l’inferenza di deep learning ad alte prestazioni.

La nuova versione, ha affermato l’azienda, dimezza il tempo di inferenza per le query relative al linguaggio. Ciò consentirà agli sviluppatori di costruire soluzioni quali motori di ricerca, suggerimenti pubblicitari e chatbot ancora più performanti, e di offrirli dal cloud all’edge.

Le ottimizzazioni di TensorRT 8 forniscono, ha sottolineato Nvidia, significativi incrementi della velocità per le applicazioni basate sul linguaggio che eseguono BERT-Large, uno dei modelli transformer-based più usati al mondo.

In passato, le aziende dovevano ridurre le dimensioni del modello, il che si traduceva in risultati significativamente meno accurati. Ora, con TensorRT 8, Nvidia è fiduciosa che le aziende possano raddoppiare o triplicare le dimensioni del loro modello per ottenere miglioramenti significativi nella precisione.

In cinque anni, ha sottolineato inoltre Nvidia, più di 350.000 sviluppatori in 27.500 aziende in settori diversi, tra cui sanità, automotive, finanza e retail, hanno scaricato TensorRT quasi 2,5 milioni di volte.

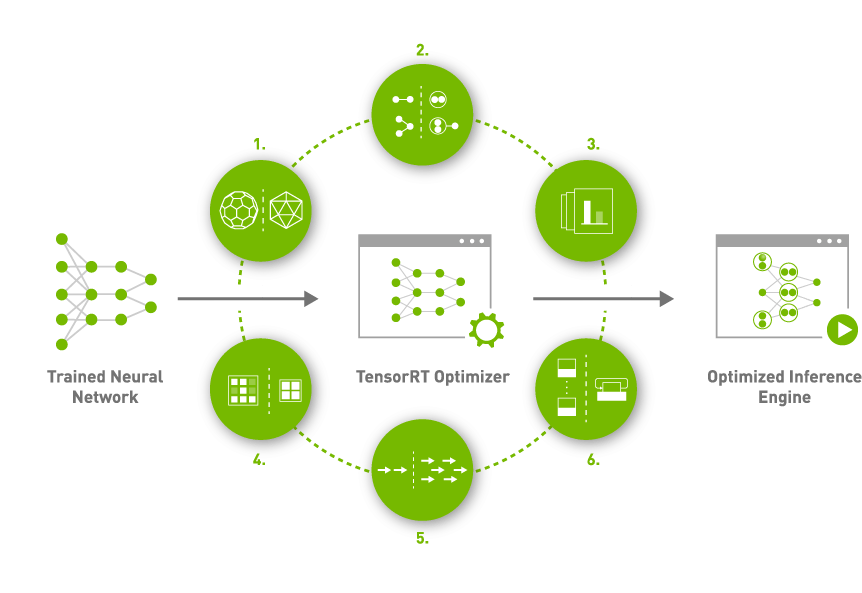

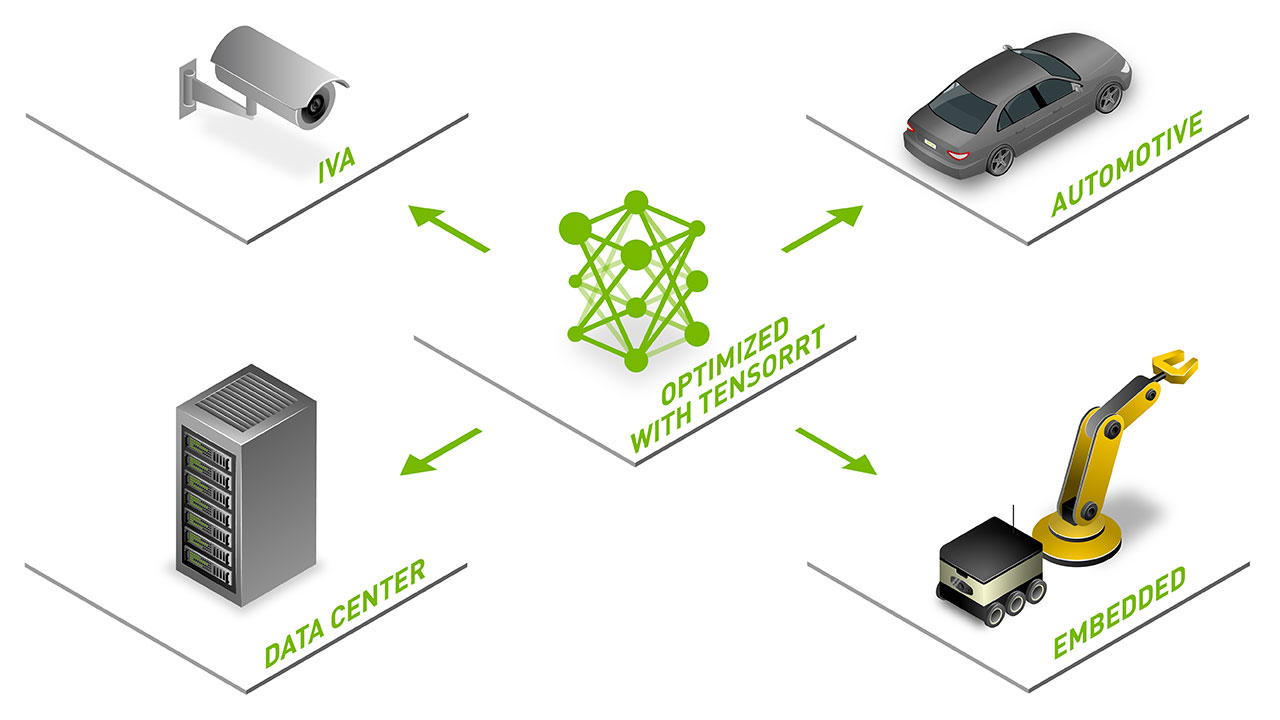

Le applicazioni TensorRT possono essere distribuite in data center hyperscale, piattaforme di prodotti embedded o automotive.

Aziende leader nei rispettivi settori hanno adottato TensorRT per le loro applicazioni di inferenza di deep learning nell’intelligenza artificiale conversazionale e in una serie di altri campi.

Oltre alle ottimizzazioni menzionate, i progressi di TensorRT 8 nell’inferenza dell’intelligenza artificiale, ha specificato Nvidia, sono stati resi possibili da altre due caratteristiche chiave.

Sparsity è una nuova tecnica per la performance implementata nelle GPU con architettura Nvidia Ampere per aumentare l’efficienza, che permette agli sviluppatori di accelerare le loro reti neurali riducendo le operazioni di calcolo.

Il Quantization aware training, invece, permette agli sviluppatori di utilizzare i modelli addestrati per eseguire l’inferenza in precisione INT8 senza perdere precisione. Questo riduce significativamente l’overhead di calcolo e di archiviazione per un’inferenza efficiente sui Tensor Core.

TensorRT 8 è ora generalmente disponibile, gratuitamente, per i membri del Developer Program di Nvidia.

Le ultime versioni di plug-in, parser e sample sono anch’essi disponibili come open source dal repository GitHub di TensorRT.