All’evento Advancing AI di San Jose, AMD ha annunciato la disponibilità della famiglia di acceleratori AMD Instinct MI300 e dell’ecosistema software aperto AMD ROCm 6, offrendo nuovi avanzamenti nel campo dell’AI generativa.

L’azienda ha, inoltre, svelato i processori Ryzen serie 8040, per rendere ancora più avanzata la propria offerta in ambito mobile, con potenza, efficienza e prestazioni maggiori.

Nel corso del keynote, il presidente e CEO di AMD, Lisa Su, ha parlato dei partner – tra cui Dell, HPE, Lenovo, Microsoft, Oracle Cloud e altri – che utilizzano l’hardware AI dell’azienda per abilitare applicazioni di High Performance Computing e AI generativa, tra cui:

- La serie di macchine virtuali (VM) Microsoft Azure ND MI300X v5, ottimizzate per i carichi di lavoro AI, alimentate dagli acceleratori AMD Instinct MI300X.

- El Capitan – il supercomputer da 2 exaflop atteso presso il Lawrence Livermore National Laboratory, alimentato da APU AMD Instinct MI300A.

- I server PowerEdge XE9680 di Dell, dotati di acceleratori AMD Instinct 300X e di un Dell Validated Design con framework AI alimentato da ROCm.

- L’acceleratore blade HPE Cray Supercomputing EX255a, annunciato di recente da HPE, anch’esso alimentato da APU AMD Instinct MI300A.

A consolidamento della posizione di AMD nel settore degli ‘AI PC’, nel primo trimestre 2024 sono attesi i laptop con processori AMD Ryzen serie 8040 di diversi partner, tra cui Acer, Asus, Dell, HP, Lenovo e altri. È inoltre disponibile il nuovo Ryzen AI software, che semplifica l’implementazione dei modelli sui pc Ryzen AI.

Gli acceleratori della serie AMD Instinct MI300

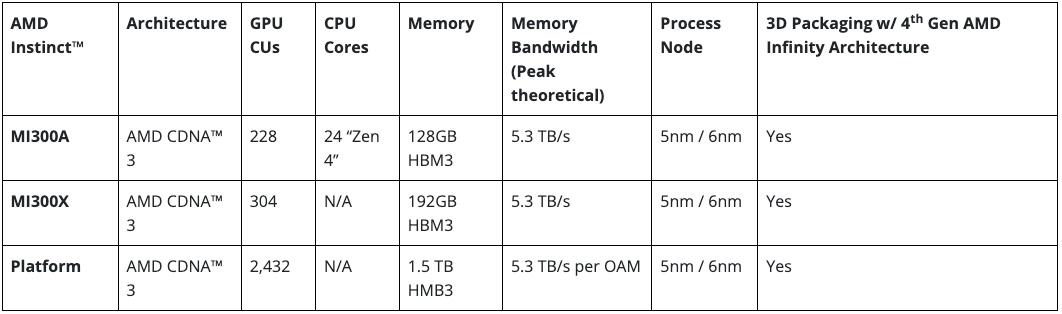

AMD ha dunque annunciato la disponibilità degli acceleratori AMD Instinct MI300X, che presentano un’ampiezza di banda di memoria all’avanguardia nel settore per l’AI generativa e prestazioni da primato per l’addestramento e l’inferenza di modelli linguistici di grandi dimensioni (LLM) – e dell’unità di elaborazione accelerata (APU, accelerated processing unit) AMD Instinct MI300A, che combina la più recente architettura CDNA 3 e le CPU “Zen 4” per offrire prestazioni che l’azienda definisce rivoluzionarie per i carichi di lavoro HPC e AI.

“Gli acceleratori AMD Instinct serie MI300 sono progettati con le nostre tecnologie più avanzate, che garantiscono prestazioni da primato, e saranno utilizzati per implementazioni cloud ed enterprise su larga scala“, ha dichiarato Victor Peng, presidente di AMD. “Sfruttando la nostra leadership in termini di hardware, software e approccio aperto all’ecosistema, i fornitori di cloud, gli OEM e gli ODM stanno introducendo sul mercato tecnologie che consentono alle imprese di adottare e implementare soluzioni basate sull’AI“.

Gli acceleratori AMD Instinct MI300X sono basati sulla nuova architettura CDNA 3 dell’azienda. Rispetto alla precedente generazione di acceleratori AMD Instinct MI250X, MI300X offre quasi il 40% in più di unità di calcolo, 1,5 volte in più di capacità di memoria, 1,7 volte in più di larghezza di banda teorica di picco della memoria e il supporto di nuovi formati matematici come FP8 e sparsity, tutti orientati ai carichi di lavoro AI e HPC.

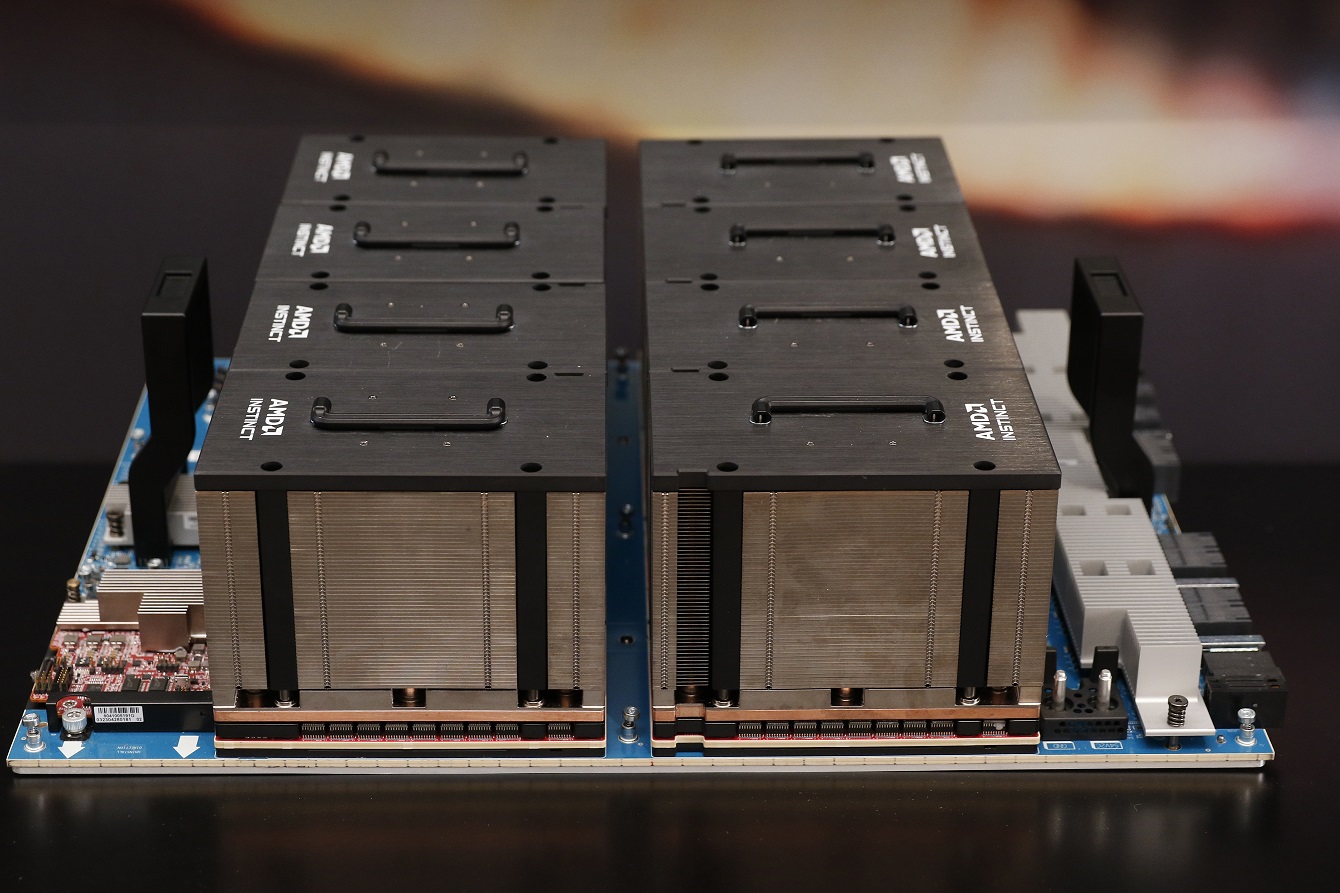

Gli LLM di oggi continuano a crescere in dimensioni e complessità, richiedendo enormi quantità di memoria e calcolo. Gli acceleratori Instinct MI300X dispongono di una capacità di memoria HBM3 di 192 GB e di una larghezza di banda di memoria di picco di 5,3 TB/s per offrire le prestazioni necessarie per carichi di lavoro AI sempre più impegnativi. La AMD Instinct Platform è una piattaforma di AI generativa costruita su un design OCP standard del settore con otto acceleratori MI300X per offrire una capacità di memoria HBM3 di 1,5 TB. Il design standard di AMD Instinct Platform consente ai partner OEM di inserire gli acceleratori MI300X nelle offerte AI esistenti, semplificando la distribuzione e accelerando l’adozione dei server basati sugli acceleratori AMD Instinct.

Le APU AMD Instinct MI300A, le prime APU per data center per HPC e AI, sfruttano il packaging 3D e l’architettura AMD Infinity di quarta generazione per offrire prestazioni da primato sui carichi di lavoro critici che si trovano alla convergenza di HPC e AI. Le APU MI300A combinano core GPU CDNA 3 ad alte prestazioni, i più recenti core CPU “Zen 4” basati su x86 e 128 GB di memoria HBM3 di nuova generazione, per offrire prestazioni ~1,9 volte superiori per watt su carichi di lavoro FP32 HPC e AI, rispetto alla precedente generazione di AMD Instinct MI250X.

L’efficienza energetica è di estrema importanza per le comunità HPC e AI, tuttavia questi carichi di lavoro sono estremamente intensivi in termini di dati e risorse. Le APU AMD Instinct MI300A traggono vantaggio dall’integrazione dei core di CPU e GPU in un unico package, offrendo una piattaforma altamente efficiente e le prestazioni di calcolo necessarie per accelerare la formazione dei più recenti modelli di AI. AMD intende dettare il ritmo dell’innovazione nel campo dell’efficienza energetica con l’obiettivo 30×25 dell’azienda, che mira a fornire un miglioramento dell’efficienza energetica di 30 volte nei processori server e negli acceleratori per l’addestramento dell’AI e l’HPC nel periodo 2020-20256.

Il vantaggio dell’APU significa che le APU AMD Instinct MI300A sono dotate di risorse di memoria e cache unificate e offrono ai clienti una piattaforma GPU facilmente programmabile, un computing altamente performante, un training AI veloce e un’efficienza energetica sorprendente per alimentare i carichi di lavoro HPC e AI più esigenti.

Software ROCm e partner dell’ecosistema

AMD ha inoltre annunciato l’ultima open software platform AMD ROCm 6 e l’impegno dell’azienda a contribuire con librerie all’avanguardia alla comunità open-source, portando avanti la visione dell’azienda sullo sviluppo di software AI open-source.

Il software ROCm 6 – sottolinea l’azienda – rappresenta un significativo balzo in avanti per gli strumenti software di AMD, aumentando le prestazioni di accelerazione dell’AI di circa 8 volte quando viene eseguito sugli acceleratori della serie MI300 nella generazione di testo Llama 2 rispetto all’hardware e al software della generazione precedente.

Inoltre, ROCm 6 aggiunge il supporto a diverse nuove funzionalità chiave per l’AI generativa, tra cui FlashAttention, HIPGraph e vLLM.

In questo modo, afferma l’azienda, AMD si trova in una posizione unica per sfruttare i modelli, gli algoritmi e i framework software AI open-source più diffusi, come Hugging Face, PyTorch, TensorFlow e altri, promuovendo l’innovazione, semplificando l’implementazione delle soluzioni di AI AMD e liberando il vero potenziale dell’AI generativa.

AMD continua inoltre a investire in capacità software attraverso le acquisizioni di Nod.AI e Mipsology, nonché attraverso partnership strategiche con l’ecosistema, come Lamini – che esegue LLM per i clienti aziendali – e MosaicML, che sfrutta AMD ROCm per consentire l’addestramento di LLM sugli acceleratori AMD Instinct senza modifiche al codice.