Grazie alle GPU AMD Instinct e alle CPU EPYC, il supercomputer LUMI – recentemente classificato come il supercomputer più veloce d’Europa e uno dei più efficienti dal punto di vista energetico – sta permettendo al gruppo TurkuNLP di creare nuovi modelli in tempi ragionevoli.

In particolare, mette in evidenza AMD, LUMI è di due ordini di grandezza superiore rispetto alle macchine della generazione precedente disponibili in Finlandia. In precedenza, il team impiegava sei mesi per il pre-training di un modello linguistico da 1 miliardo di parametri su un computer, mentre ora bastano due settimane perché LUMI elabori circa 40 miliardi di token, costituiti da caratteri, sillabe o parole.

A questo proposito, Väinö Hatanpää, Machine Learning Specialist di CSC, ha dichiarato: “La capacità di calcolo e la possibilità di espandersi ulteriormente con LUMI consentono ai nostri clienti di spingersi oltre i confini del machine learning/IA“.

LUMI (Large Unified Modern Infrastructure), uno dei supercomputer di livello mondiale di EuroHPC e tra le principali piattaforme per l’intelligenza artificiale, si trova presso il data center di CSC a Kajaani, in Finlandia. Il supercomputer è hosted dal consorzio LUMI, che comprende dieci Paesi europei.

Il TurkuNLP Group è un gruppo di ricercatori dell’Università di Turku e della scuola di specializzazione UTU (UTUGS). L’ambito della loro ricerca è l’elaborazione del linguaggio naturale, la tecnologia del linguaggio e la linguistica digitale.

I modelli linguistici di grandi dimensioni (LLM) hanno suscitato grande interesse, grazie alla popolarità di ChatGPT. Ma il training di un LLM richiede un’enorme quantità di potenza di calcolo e i modelli come ChatGPT sono solitamente proprietari e basati sull’inglese. Quando Sampo Pyysalo, ricercatore dell’Università di Turku, ha voluto estendere il valore degli LLM ad applicazioni di ricerca più ampie, ha avuto bisogno di prestazioni elevate per addestrare i modelli in tempi utili.

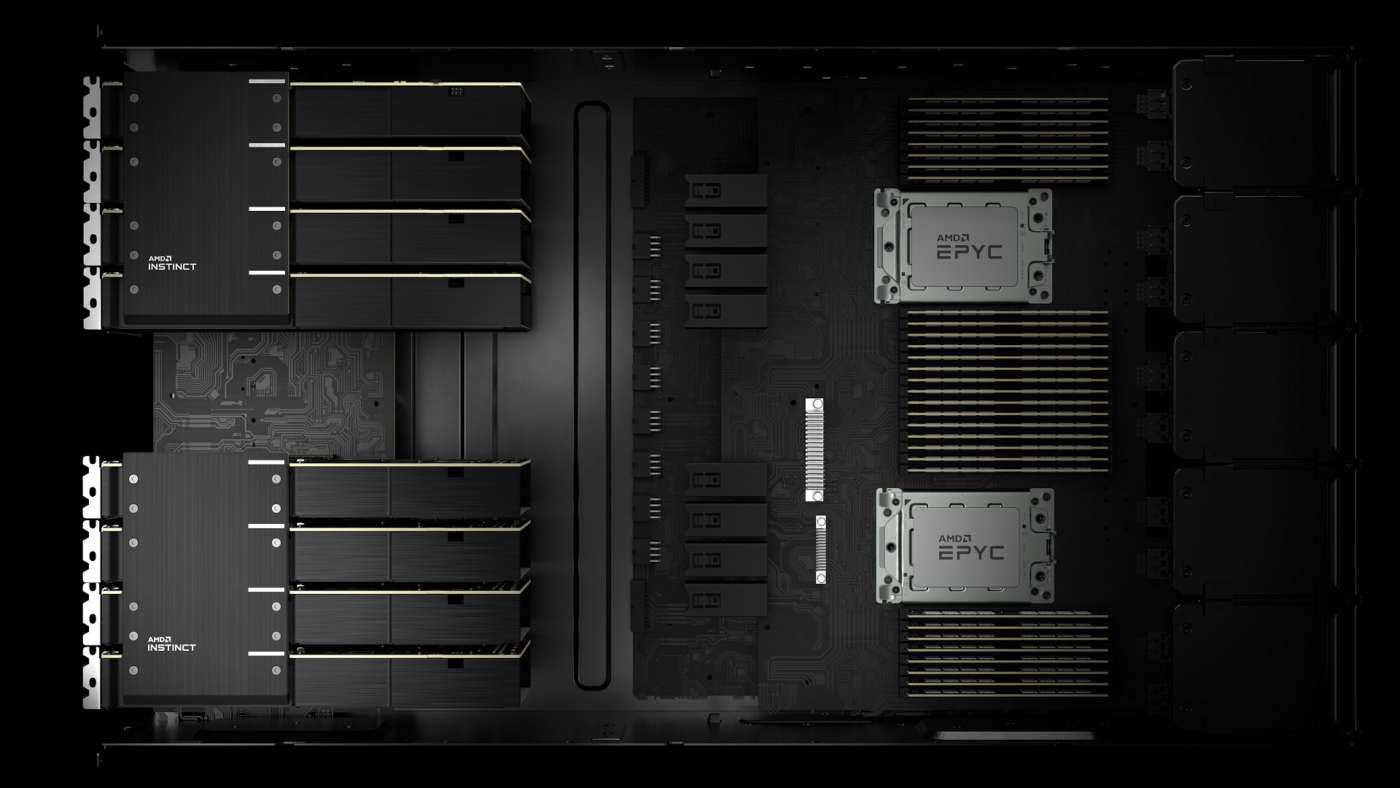

Il supercomputer LUMI, basato sull’architettura del supercomputer HPE Cray EX e potenziato da CPU AMD EPYC e GPU AMD Instinct, ha fornito la scala necessaria ai carichi di lavoro.

L’obiettivo di Pyysalo con i partner Risto Luukkonen e Ville Komulainen nel progetto TurkuNLP, è stato quello di aprire i Large Language Model all’uso accademico. Il finlandese era il punto di partenza naturale per un’università con sede in Finlandia, come quella di Turku. Quindi il gruppo di ricercatori ha creato dei modelli foundation da perfezionare per esigenze specifiche di ricerca. I prossimi passi, spiegano i ricercatori, riguarderanno l’addestramento di questi modelli in modo che possano seguire le istruzioni in modo sensato o funzionare come parte di un dialogo come ChatGPT.

Pyysalo ha collaborato con Hugging Face su diversi progetti, spiega il ricercatore, facendo parte delle iniziative BigScience che hanno creato BLOOM, il più grande modello linguistico open. Il modello maggiore che il gruppo di ricerca ha addestrato in questo sforzo durante la fase pilota di LUMI è stato quello per insegnare a BLOOM il finlandese. I ricercatori hanno preso il modello da 176 miliardi di parametri creato da Hugging Face e lo hanno combinato con il finlandese utilizzando altri 40 miliardi di parole.

Modelli di queste dimensioni richiedono un’immensa scala di calcolo, ed è qui che LUMI si è rivelato essenziale. LUMI vanta 2.560 nodi alimentati da processori AMD EPYC, ciascuno con quattro acceleratori AMD Instinct MI250x, per un totale di 10.240 GPU e 20.480 Graphics Compute Dies (GCD).

AMD ha fornito un’assistenza completa per far sì che gli LLM di Pyysalo funzionassero su LUMI, importando sulla propria piattaforma i software necessari per questo task.

Circa quattro anni fa il gruppo di ricerca ha addestrato il suo primo modello BERT finlandese sul supercomputer di precedente generazione del CSC, spiega Pyysalo. Si trattava di un progetto pilota sul CSC, un modello da 110 milioni di parametri. Ma il più grande che i ricercatori hanno addestrato su LUMI era di 176 miliardi, più di mille volte più grande.

LUMI, sottolinea Pyysalo, è due ordini di grandezza più grande delle macchine di precedente generazione disponibili in Finlandia. Sarebbe stato inconcepibile fare qualcosa su questa scala con l’hardware precedentemente a disposizione del gruppo di ricerca.

“Il tempo impiegato per sottoporre a BLOOM circa 40 miliardi di token, che possono essere caratteri, sillabe o parole, è stato di circa due settimane su LUMI, dice Pyysalo, che aggiunge: “È teoricamente possibile gestire un piccolo cluster per un paio d’anni e ottenere lo stesso risultato, ma sarà in larga misura irrilevante quando verrà pubblicato. Abbiamo scalato a 192 nodi e 1.536 GCD per il modello da 176 miliardi di parametri con 40 miliardi di token. Attualmente siamo a 512 nodi su LUMI, quindi 4.096 GCD“.

Pyysalo sta ora cercando di sfruttare questa scalabilità per il futuro del suo programma di LLM. “TurkuNLP è uno dei 10 laboratori di ricerca universitari che collaborano“, spiega. “Facciamo parte del progetto High Performance Language Technologies, finanziato dall’UE, un progetto triennale che ha appena superato i primi sei mesi. Quello che abbiamo fatto per il finlandese è stato un banco di prova per la creazione di modelli foundation per almeno per tutte le lingue ufficiali dell’UE e, si spera, anche per altre. Ci baseremo sulla tecnologia che abbiamo messo insieme per iniziare a generare questi modelli linguistici. Li rilasceremo nei prossimi due anni e alcuni modelli iniziali nel corso di quest’anno“.

Questo richiederà una scalabilità ancora maggiore, ma Pyysalo si aspetta che LUMI sia all’altezza della sfida. “L’ambizione è quella di creare il più grande modello aperto con supporto per le lingue europee“, afferma. “Andremo oltre i 10 milioni di ore GPU. Circa 1,5 milioni di ore sono state impiegate nei nostri modelli precedenti, quindi questo sarebbe un ordine di grandezza più ambizioso. LUMI sta diventando una piattaforma matura per lavori di AI su larga scala. In futuro, faremo training per un numero molto maggiore di token. È probabile che si tratterà di un trilione di parole e più“.

“Ci auguriamo che i modelli che abbiamo costruito per il finlandese servano da base per la prossima generazione di intelligenza artificiale finlandese“, conclude Pyysalo. Con i futuri programmi multilingue di TurkuNLP, Pyysalo spera di estendere questa visione a tutte le lingue europee e oltre.