A Barcellona, in occasione del VMware Explore 2023, VMware ha annunciato una collaborazione con Intel per ampliare gli oltre vent’anni di innovazione delle due aziende e aiutare i clienti ad accelerare l’adozione dell’intelligenza artificiale (AI) e ad abilitare la Private AI ovunque: nei data center, nei cloud pubblici e negli ambienti edge.

VMware e Intel stanno lavorando per fornire uno stack AI convalidato congiuntamente che consentirà ai clienti di utilizzare l’infrastruttura VMware e Intel e il software open source esistenti per semplificare la creazione e l’implementazione di modelli AI.

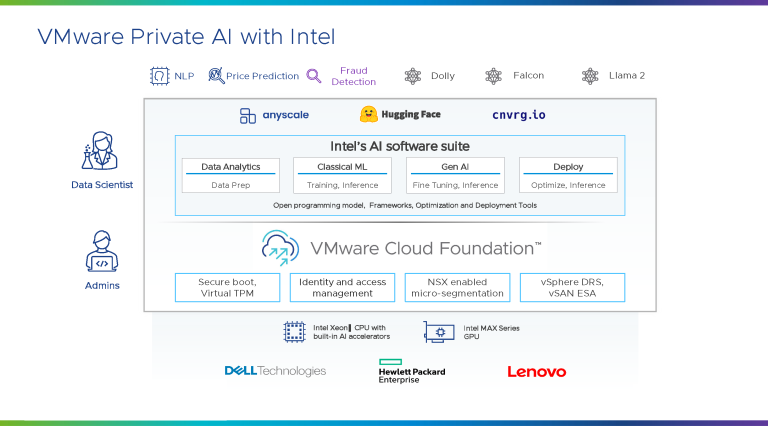

La combinazione di VMware Cloud Foundation e della suite di software Intel per l’AI, dei processori Intel Xeon con acceleratori AI integrati e delle GPU Intel Max Series, fornirà uno stack AI convalidato e sottoposto a benchmark per la preparazione dei dati, l’addestramento dei modelli, la messa a punto e l’inferenza per accelerare la scoperta scientifica e arricchire i servizi per le aziende e i consumatori.

Oltre 300.000 clienti utilizzano VMware Cloud a livello globale – sottolinea l’azienda – e il software di virtualizzazione VMware è utilizzato quasi ovunque dalle organizzazioni lì dove i dati vengono creati, elaborati o consumati. Ciò rende VMware Cloud una soluzione rapida per portare l’elaborazione e i modelli accelerati dall’intelligenza artificiale ovunque si svolga l’attività. Analogamente, Intel offre soluzioni aperte, scalabili e affidabili a centinaia di migliaia di clienti. Secondo le due società hi-tech, la diffusione dei prodotti VMware e Intel nelle aziende è una combinazione estremamente efficace che aumenterà l’accessibilità della scienza dei dati e consentirà alle organizzazioni di tutto il mondo di adottare Private AI, un approccio architetturale che mira a bilanciare i vantaggi aziendali dell’AI con le esigenze pratiche di privacy e conformità.

“Quando si parla di AI, non c’è più motivo per scendere a compromessi in termini di scelta, privacy e controllo. La Private AI offre ai clienti tutte e tre le caratteristiche, consentendo loro di accelerare l’adozione dell’AI e di rendere la loro infrastruttura AI a prova di futuro“, ha dichiarato Chris Wolf, vicepresidente dei VMware AI Labs. “VMware Private AI e Intel aiuteranno i nostri clienti in comune ad aumentare enormemente la produttività dei lavoratori, a dare il via alla trasformazione delle principali funzioni aziendali e a generare un impatto economico“.

“Per decenni, Intel e VMware hanno offerto funzionalità data center-to-cloud di nuova generazione che consentono ai clienti di muoversi più velocemente, innovare di più e operare in modo efficiente“, ha dichiarato Sandra Rivera, vicepresidente esecutivo e direttore generale del Data Center and AI Group (DCAI) di Intel. “Con il potenziale dell’intelligenza artificiale di sbloccare nuove e potenti possibilità e di migliorare la vita delle persone, Intel e VMware sono ben equipaggiate per guidare le imprese in questa nuova era dell’AI, alimentata da silicio e software“.

Aumentare le prestazioni dell’intelligenza artificiale e ottenere un’infrastruttura AI più sicura con un TCO inferiore

VMware Private AI porta la capacità di calcolo e i modelli di AI dove i dati aziendali vengono creati, elaborati e consumati, sia in un cloud pubblico, sia in un data center aziendale, sia nell’edge, a supporto dei carichi di lavoro AI/ML tradizionali e dell’AI generativa.

VMware e Intel consentono la messa a punto di modelli specifici per le attività in pochi minuti o in poche ore e l’inferenza di modelli linguistici di grandi dimensioni a una velocità superiore a quella umana, utilizzando i dati aziendali privati del cliente. VMware e Intel consentono ora di mettere a punto modelli allo stato dell’arte, più piccoli ed economici, più facili da aggiornare e mantenere su sistemi virtuali condivisi, che possono poi essere restituiti al pool di risorse IT una volta completati i lavori di AI in batch. Casi d’uso come la generazione di codice assistita dall’intelligenza artificiale, i sistemi di raccomandazione dei centri di assistenza clienti e l’analisi statistica delle macchine classiche possono ora essere co-localizzati sugli stessi server general purpose che eseguono l’applicazione.

VMware e Intel stanno progettando un’architettura di riferimento che combina la suite software AI di Intel, i processori Intel Xeon e le GPU per data center con VMware Cloud Foundation per consentire ai clienti di creare e distribuire modelli AI privati sull’infrastruttura di cui dispongono, riducendo così il costo totale di proprietà e rispondendo alle esigenze di sostenibilità ambientale. L’architettura di riferimento VMware Private AI con Intel AI comprenderà:

- Processori Intel Xeon di quarta generazione con Intel Advanced Matrix Extensions (Intel AMX) che offrono miglioramenti significativi fino a 10 volte delle prestazioni out-of-box utilizzando framework e librerie standard del settore, strumenti di produttività end-to-end per la scienza dei dati e modelli AI ottimizzati.

- Intel Data Center GPU Max che contiene fino a 128 core Xe ed è il blocco di calcolo GPU fondamentale di Intel, destinato ai carichi di lavoro AI più impegnativi. Le GPU Intel Max Series saranno disponibili in diversi fattori di forma per soddisfare le diverse esigenze dei clienti.

- La suite di software Intel per l’intelligenza artificiale che è composta da software open source end-to-end e da componenti opzionali in licenza per consentire agli sviluppatori di eseguire la pipeline completa di flussi di lavoro per l’intelligenza artificiale, dalla preparazione dei dati alla messa a punto fino all’inferenza, accelerando la creazione di uno scaling multi-nodo e l’implementazione dell’intelligenza artificiale nell’infrastruttura IT aziendale. Il framework aperto oneAPI consente lo sviluppo di software indipendenti dai processori e dagli acceleratori hardware, permettendo agli sviluppatori di scrivere il codice una sola volta e di eseguirlo su architetture diverse, eliminando la necessità di basi di codice multiple e linguaggi specializzati. Le estensioni Transformer di Intel e la profonda integrazione di PyTorch Extension con le librerie open source Hugging Face, preferite dagli sviluppatori, forniscono soluzioni di ottimizzazione automatica per la messa a punto e la compressione dei modelli per un’inferenza efficiente.

VMware Cloud Foundation offre un’infrastruttura coerente di classe enterprise, semplicità operativa e maggiore sicurezza a VMware Private AI attraverso funzionalità quali:

- VMware vSAN Express Storage Architecture che offre prestazioni fino al 30% superiori e un overhead minimo per funzionalità importanti come la crittografia per i carichi di lavoro AI/ML ad alta intensità di I/O e inferenza.

- vSphere Distributed Resources Scheduler che consente di utilizzare in modo efficiente la capacità di calcolo inutilizzata per l’addestramento e l’inferenza dei modelli di AI, sfruttando gli stessi cluster utilizzati da altre applicazioni di AI, massimizzando così la capacità e riducendo il TCO.

- VMware NSX per creare microsegmentazione e funzionalità avanzate di protezione dalle minacce.

- Avvio sicuro e Virtual TPM per consentire la riservatezza dei modelli e dei dati.

VMware Private AI sarà supportato da server di Dell Technologies, Hewlett Packard Enterprise e Lenovo con CPU Xeon di quarta generazione con Intel Advanced Matrix Extensions (Intel AMX) e GPU Intel Max Series.

Per ulteriori informazioni su VMware Private AI con Intel, è possibile visitare il sito dell’azienda.