I big data rappresentano una formidabile forza motrice per innumerevoli organizzazioni. Quali sono i dati di maggior valore? Senza dubbio quelli inerenti alle persone fisiche.

Si tratta di un bacino di informazioni preziose, quasi indispensabili per lo sviluppo di strategie di business efficaci, soprattutto nell’economia post-Covid.

Tuttavia, proprio per il loro grande valore e legame con l’individuo, i big data si prestano a riflessioni profonde e per molti versi indispensabili. Sono tre i punti fondamentali che abbiamo voluto evidenziare.

La trasposizione digitale di un individuo richiede che venga garantita la sua “integrità digitale”. Si tratta di una forma di rispetto morale; inoltre è innegabile che vi siano anche potenziali risvolti legali anche alla luce del GDPR.

La qualità dei dati è un altro punto fermo in una big data strategy. È evidente che un database scarsamente affidabile risulti quasi privo di valore. Certamente nessuna società baserebbe le proprie strategie su dati inaffidabili.

Il terzo pilastro, senza il quale nulla sarebbe possibile, è la sicurezza del dato.

Una sicurezza che va intesa nella sua accezione più ampia. Le organizzazioni devono garantire il rispetto delle normative vigenti, prima di tutto. Inoltre, i data breach sono in costante aumento: la cybersecurity è chiaramente parte della sicurezza. Infine, i dati vanno tutelati anche con adeguate policy di backup e strategie di ridondanza: un fattore da non sottovalutare per tutti i data center e per le aziende che ne fanno uso.

Qual è la posizione di Red Hat su questi tre pilastri dei big data? Una domanda che abbiamo rivolto a Mike Piech, che nella società americana riveste il ruolo di Vice President and General Manager of Data Services

Affrontiamo queste tematiche in modo congiunto, cominciando con il tema della sicurezza, in quanto fondamento di qualsiasi soluzione digitale che coinvolga i dati. Prima di tutto, è importante notare che la sicurezza è molto più di una funzione puramente tecnologica: è il risultato di una combinazione di tecnologia, persone e comportamenti. Il compito della tecnologia è quello di offrire la giusta visibilità, verificabilità e controllo, per consentire alle persone che la utilizzano di raggiungere la massima sicurezza e trasparenza possibile nell’uso dei dati. Red Hat fornisce tale tecnologia, insieme a indicazioni sulle pratiche raccomandate.

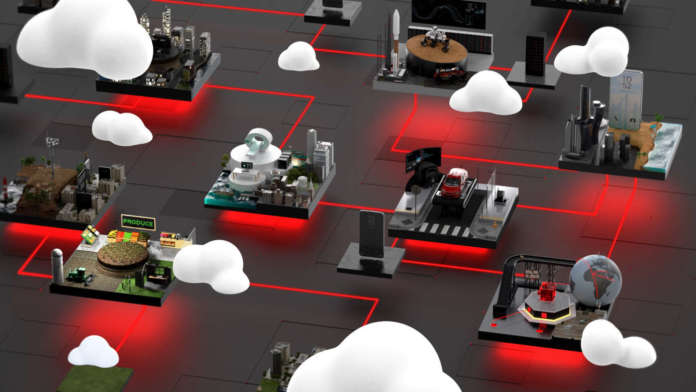

Tempo addietro, quando l’informatica era più monolitica e meno distribuita rispetto a oggi, gli sforzi per la sicurezza si concentravano sul concetto di network security basato sul perimetro: un controllo di massima degli accessi eseguito sui confini più importanti, come quello tra la rete locale e Internet. I sistemi software di oggi, invece, comprendono molti distinti elementi di elaborazione, distribuiti in un’infrastruttura molto più complessa dove ogni elemento comunica dati con altri elementi attraverso numerosi livelli di confine di rete: all’interno del network locale, su Internet, presso i vari cloud provider e tra di loro. Questo richiede un approccio stratificato, di difesa approfondita, dove la sicurezza viene implementata su molti livelli di granularità. A livello basso, come è il caso del sistema operativo, ci sono funzionalità di Security-Enhanced Linux (componente di Red Hat Enterprise Linux) che proteggono i dati attraverso uno stretto controllo degli accessi locali.

Salendo a livello del cluster cloud di Red Hat OpenShift (kubernetes), sono numerosi i meccanismi di visibilità e controllo, abbinati a pratiche raccomandate, progettati per aiutare le imprese a raggiungere i loro obiettivi di sicurezza; c’è naturalmente il controllo degli accessi, anche se in questo contesto si tratta di un aspetto ben più complesso rispetto a un utente con una password per un’applicazione – sono diversi i sottosistemi che accedono ad altri sottosistemi con differenti livelli di autorizzazione… C’è l’integrità delle immagini utilizzate per istanziare i container. C’è la protezione dei certificati e dei secret, così come la crittografia di vari dati operativi e dei dati dell’applicazione stessa. Ci sono scelte di design riguardanti l’abilitazione di certi tipi di account utente e capacità di sistema di basso livello a livello di nodo e di cluster. E c’è anche il concetto di “shift-left”, nel quale la sicurezza è considerata e inserita all’interno di un’applicazione o componente mentre viene sviluppata, non più applicata o aggiunta in fase di esecuzione. OpenShift fornisce meccanismi di visibilità e controllo, così come pratiche raccomandate, in tutte queste aree e altro ancora.

Ma questi sono solo alcuni dei molti modi in cui la tecnologia Red Hat può aiutare a proteggere i big data in un ambiente informatico enterprise. Su questa base – con la fiducia che i dati siano protetti da manipolazioni non autorizzate e malevole – passiamo ad affrontare la qualità dei dati. Man mano che saliamo di livello nello stack, passando dalla sicurezza alla qualità, fino ad arrivare all’integrità, l’equilibrio tra ciò che fa la tecnologia e ciò che dipende dalle persone e dai processi si sposta verso il secondo aspetto. In altre parole, il successo dipende sempre più da come viene usata la tecnologia.

La data quality ha moltissime dimensioni. Al livello più elementare e intuitivo, possiamo chiederci se un dato è accurato. Ma, non appena questo fa parte di un insieme, la nozione di qualità si espande includendo fattori come la costanza nella precisione e tempestività, la completezza, le eventuali duplicazioni e così via. Funzionalità e strumenti per rispondere a queste esigenze di base come database e ETL (extract/transform/load) esistono da lungo tempo, e il ruolo di Red Hat è quello di contribuire ad abilitare tali capacità mature e consolidate in un modo moderno e cloud-native attraverso i partner su OpenShift.

Andando oltre queste basi, la nozione di data quality diventa ancor più complessa quando si considerano dati più dinamici come i dati in streaming, i dati “evento” e i dati provenienti dall’edge. In casi d’uso come questi, il concetto di “qualità” diventa più complesso rispetto a quello a cui facciamo riferimento per valutare che la lista dei clienti sia aggiornata o che tutte le transazioni di acquisto siano state catturate accuratamente. Ora si tratta di capre quali dati è possibile ignorare o eliminare. E’ più o meno lo stesso livello di granularità da usare quando si cercano i modelli. Ed è stesso come trovare un ago in un pagliaio.

Sostenere il raggiungimento della qualità dei dati in tali ambienti dinamici dipende quindi dal consentire i giusti tipi di integrazione così come i giusti tipi di visualizzazione. OpenShift fornisce numerose funzionalità fondamentali per l’inserimento e la persistenza di questi dati così diversi, come load balancing, Istio service mesh e lo storage Ceph, estremamente scalabile. Anche in questo caso, l’ecosistema di partner di OpenShift ne espande significativamente la gamma di funzionalità.

Un’altra area emergente che porta nuovi concetti di qualità dei dati è il machine learning. Quando un data scientist prepara un modello da utilizzare per valutare gli effetti in tempo reale su un’applicazione di produzione, ha bisogno di essere sicuro che i dati di test rappresentino accuratamente i dati di produzione in modo da non produrre risultati distorti o comunque non validi. In questo contesto, sostenere la qualità significa non solo ottimizzare l’ambiente di training come nel caso dei notebook Jupyter, ma anche in un’architettura efficace di data aggregation, data pipeline, model deployment, model observation e model lifecycle management.

Il machine learning è un altro esempio in cui l’approccio di Red Hat consiste nel fornire solide funzionalità di base in combinazione con le offerte dei partner, creando così una soluzione completa. Da diversi anni collaboriamo alla crescita di un progetto open source chiamato Open Data Hub (opendatahub.io), che riunisce Kubeflow, notebook Jupyter, e numerose altre tecnologie legate ai dati in una piattaforma completa di data science. «Nelle prossime settimane lanceremo un servizio gestito basato proprio su questo chiamato Red Hat OpenShift Data Science.» ha aggiunto Mike Piech

Passiamo ora all’integrità digitale per i dati individuali, che dipende significativamente dalle pratiche impiegate da un’organizzazione nella gestione dei dati sensibili. Le funzionalità di sicurezza delineate sopra sono certamente critiche nel prevenire un possibile accesso malevolo dall’esterno, ma sono i processi interni, le impostazioni di accesso e altre configurazioni che proteggono i dati dalla compromissione interna, intenzionale o accidentale. Questa è stata e continuerà ad essere un’area di attenzione primaria per OpenShift, in modo da fornire sia la granularità che la visibilità del controllo degli accessi e consentire alle organizzazioni di impostare e mantenere un efficace regime di protezione dei dati.

Inoltre, in casi d’uso emergenti come lo streaming dall’edge di dati massivi, il cui gradi di rilevanza e sensibilità potrebbe non essere pienamente compresa, o l’uso di dati di comportamento individuale per definire modelli di apprendimento, continueremo a elaborare i migliori meccanismi possibili per consentire ai decision maker di rilevare rischi imprevisti e prevenire possibili compromissioni.

Sicurezza, qualità e privacy dei big data sono elementi che continueranno a crescere in importanza e complessità negli ambienti cloud ibridi altamente distribuiti di oggi. Per Red Hat rappresentano una priorità assoluta, tanto che continuiamo ad impegnarci per garantire le migliori funzionalità possibili e fornire pratiche raccomandate abbinate alle nostre offerte, in modo che le organizzazioni possano combinarle con le proprie esigenze specifiche, i loro processi e il loro personale per garantire successo al proprio business, mantenendo al contempo la massima sicurezza possibile.