L’intelligenza artificiale ha trasformato la sintesi vocale dal tono monocorde delle robocall e dei sistemi di navigazione GPS vecchi di decenni in quello raffinato degli assistenti virtuali integrati negli smartphone e negli smart speaker, ha messo in evidenza Nvidia.

La stessa azienda ha però sottolineato anche che c’è ancora un divario tra il parlato sintetizzato dall’intelligenza artificiale e quello umano che sentiamo nelle conversazioni quotidiane e nei mezzi di comunicazione.

Ciò avviene, spiega Nvidia, perché le persone parlano con un ritmo, un’intonazione e un timbro complessi, che sono difficili da emulare per l’intelligenza artificiale.

Secondo l’azienda però il divario si sta riducendo rapidamente. I ricercatori di Nvidia stanno infatti costruendo modelli e strumenti per una sintesi vocale di alta qualità e controllabile che cattura la ricchezza del parlato umano, senza artefatti audio.

Gli ultimi progetti dei ricercatori Nvidia sono stati mostrati nelle sessioni della recente conferenza Interspeech 2021.

Questi modelli – ritiene l’azienda specializzata in intelligenza artificiale – possono aiutare a dare voce a linee di servizio clienti automatizzate per banche e rivenditori, a dare vita a personaggi di videogiochi o libri e a fornire una sintesi vocale in tempo reale per avatar digitali.

Il team creativo interno di Nvidia utilizza tale tecnologia persino per produrre una narrazione espressiva per una serie di video sulla potenza dell’intelligenza artificiale.

Fino a poco tempo fa, questi video erano narrati da un essere umano. I precedenti modelli di sintesi vocale – ha sottolineato Nvidia – offrivano un controllo limitato sul ritmo e sull’intonazione della voce sintetizzata, quindi i tentativi di narrazione con l’intelligenza artificiale non evocavano negli spettatori la reazione emotiva che un oratore umano di talento poteva avere.

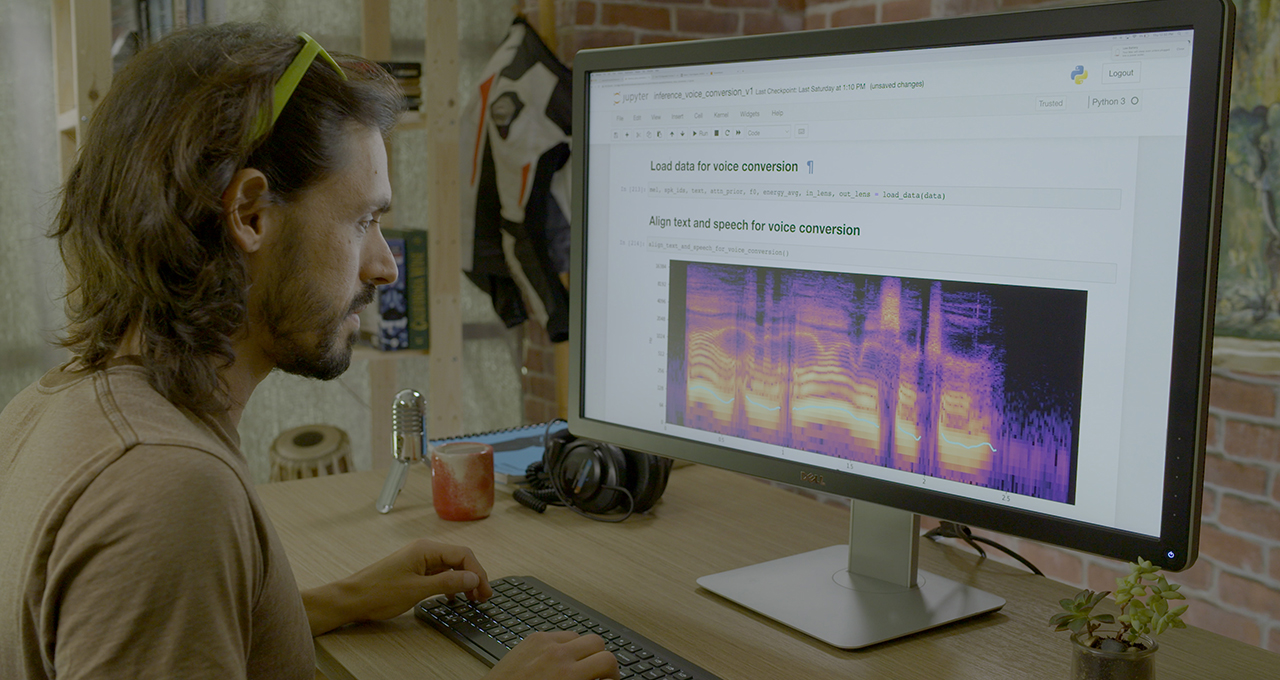

Ciò è cambiato nel corso dell’ultimo anno, in cui il team di ricerca text-to-speech di Nvidia ha sviluppato modelli di sintesi vocale più potenti e controllabili come RAD-TTS, utilizzato nella demo vincitrice alla competizione Real-Time Live del Siggraph.

Addestrando il modello text-to-speech con l’audio del discorso di un individuo, RAD-TTS può convertire qualsiasi messaggio di testo nella voce dell’oratore.

La sintesi vocale espressiva è solo uno degli elementi del lavoro di NVIDIA Research nell’intelligenza artificiale conversazionale: un campo che comprende anche l’elaborazione del linguaggio naturale, il riconoscimento automatico del parlato, il rilevamento delle parole chiave, il miglioramento dell’audio e altro ancora.

Ottimizzato per essere eseguito in modo efficiente sulle GPU dell’azienda, parte di questo lavoro all’avanguardia è stato reso open source attraverso Nvidia NeMo.

Grazie a Nvidia NeMo – un toolkit Python open source per l’intelligenza artificiale conversazionale accelerata dalle GPU – ricercatori, sviluppatori e creatori di contenuti ottengono un vantaggio nella sperimentazione e nella messa a punto di modelli vocali per le proprie applicazioni.

API facili da usare e modelli preaddestrati in NeMo aiutano i ricercatori a sviluppare e personalizzare i modelli per il text-to-speech, l’elaborazione del linguaggio naturale e il riconoscimento vocale automatico in tempo reale.