L’obiettivo di SafeCoder, spiega Hugging Face, è quello di sbloccare la produttività dello sviluppo software per le aziende, con un assistente programmatore pienamente conforme e self-hosted. Una sorta di “copilota GitHub on-prem”: così viene descritto dallo specialista del machine learning.

SafeCoder – sottolinea Hugging Face – non è un modello, ma una soluzione commerciale completa end-to-end, costruita con principi fondamentali di sicurezza e privacy: il codice non lascia mai il VPC durante il training o l’inferenza.

SafeCoder è progettato per il self-hosting da parte del cliente sulla propria infrastruttura e per consentire ai clienti di possedere il proprio modello di Code Large Language Model, language model per il codice.

Le soluzioni di code assistant basate su LLM, come GitHub Copilot, stanno dando un forte impulso alla produttività, mette in evidenza Hugging Face. Per le aziende, la possibilità di fare fine-tuning dei Code LLM sulla code base aziendale per creare Code LLM proprietari migliora l’affidabilità e la pertinenza dei completamenti, creando un ulteriore livello di aumento della produttività. Ad esempio, l’assistente al codice basato su LLM interno di Google riporta un tasso di accettazione del completamento del 25-34% grazie alla formazione su una base di codice interna.

Tuttavia, affidarsi a Code LLM closed-source per creare assistenti al codice interni espone le aziende a problemi di conformità e sicurezza, sottolinea Hugging Face. In primo luogo durante il training, poiché la messa a punto di un Code LLM closed-source su una base di codice interna richiede l’esposizione di questa code base a una terza parte. E poi durante l’inferenza, poiché è probabile che i Code LLM con ottimizzazione possano “perdere” codice dal set di dati di addestramento durante l’inferenza. Per soddisfare i requisiti di conformità, le aziende devono implementare Code LLM ottimizzati all’interno della propria infrastruttura, cosa che non è possibile con gli LLM closed source.

Con SafeCoder, Hugging Face intende aiutare i clienti a costruire i propri Code LLM, perfezionati sulla loro base di codice proprietaria, utilizzando modelli e librerie aperte allo stato dell’arte, senza condividere il proprio codice con Hugging Face o con altre terze parti. Con SafeCoder, Hugging Face offre una soluzione di inferenza di Code LLM containerizzata e accelerata dall’hardware, che può essere implementata dal cliente direttamente all’interno della propria infrastruttura sicura, senza che gli input e i completamenti del codice escano dal suo ambiente IT sicuro.

Al nucleo centrale della soluzione SafeCoder c’è la famiglia di Code LLM StarCoder, creata dal progetto BigCode, una collaborazione tra Hugging Face, ServiceNow e la comunità open source.

I modelli StarCoder secondo Hugging Face offrono caratteristiche uniche, ideali per le soluzioni self-hosted aziendali. Innanzitutto, risultati di completamento del codice allo stato dell’arte. Poi, è progettato con le prestazioni di inferenza come obiettivo: un modello a 15 miliardi di parametri con ottimizzazioni del codice, Multi-Query Attention per ridurre l’ingombro in memoria e Flash Attention per scalare fino a un contesto di 8.192 tokens.

Inoltre, è addestrato su The Stack, un dataset di codice open source di provenienza etica contenente solo codice concesso in licenza commercialmente consentito, con un meccanismo di opt-out per gli sviluppatori fin dall’inizio, perfezionato attraverso un’intensa attività di rimozione e deduplicazione delle PII.

Privacy e sicurezza sono indicate come principio fondamentale della soluzione. Un principio fondamentale di SafeCoder è che la code base interna del cliente non sarà mai accessibile a terzi (incluso Hugging Face) durante l’addestramento o l’inferenza.

Nella fase iniziale di SafeCoder, il team di Hugging Face fornisce container, script ed esempi per lavorare fianco a fianco con il cliente per selezionare, estrarre, preparare, duplicare e deidentificare i dati della base di codice interna in un training dataset da utilizzare in un training container fornito da Hugging Face e configurato in base all’infrastruttura hardware a disposizione del cliente.

Nella fase di implementazione di SafeCoder, il cliente distribuisce i container forniti da Hugging Face sulla propria infrastruttura per esporre gli endpoint interni privati all’interno del proprio VPC. Questi container sono configurati in base all’esatta configurazione hardware disponibile per il cliente, tra cui GPU NVIDIA, GPU AMD Instinct, CPU Intel Xeon, acceleratori AWS Inferentia2 o Habana Gaudi.

Allo stesso modo, spiega Hugging Face, sono stati fatti molti sforzi per ridurre il rischio legale per gli utenti dei modelli StarCoder e per i clienti di SafeCoder. Per gli utenti di SafeCoder, questi sforzi si traducono in funzioni di compliance: quando gli sviluppatori di software ottengono il completamento del codice, questi suggerimenti vengono verificati con The Stack, in modo che gli utenti sappiano se il codice suggerito corrisponde a quello esistente nel dataset di origine e quale sia la licenza. I clienti possono specificare quali licenze preferiscono e comunicare tali preferenze ai loro utenti.

SafeCoder è una soluzione commerciale completa, che comprende assistenza, software e supporto. StarCoder è stato addestrato in più di 80 linguaggi di programmazione e offre prestazioni all’avanguardia su diversi benchmark, afferma Hugging Face. Per offrire migliori suggerimenti di codice specificamente per un cliente SafeCoder, l’engagement inizia con una fase di formazione opzionale, in cui il team di Hugging Face lavora direttamente con il team del cliente per guidarlo attraverso le fasi di preparazione e costruzione di un dataset di codice di formazione, e per creare il proprio modello di generazione del codice attraverso la messa a punto, senza mai esporre la propria base di codice a terzi o a Internet.

Il risultato finale è un modello adattato ai linguaggi di, agli standard e alle pratiche riguardanti il codice del cliente. Attraverso questo processo, i clienti SafeCoder imparano il processo e costruiscono una pipeline per la creazione e l’aggiornamento dei propri modelli, garantendo l’assenza di vendor lock-in e mantenendo il controllo delle proprie capacità di intelligenza artificiale.

Durante la fase di setup, i clienti di SafeCoder e Hugging Face progettano e predispongono l’infrastruttura ottimale per supportare la concurrency richiesta e offrire un’ottima esperienza agli sviluppatori. Hugging Face costruisce quindi i container di inferenza SafeCoder, accelerati dall’hardware e ottimizzati per il throughput, che possono essere distribuiti dal cliente sulla propria infrastruttura.

L’inferenza di SafeCoder supporta diversi hardware per offrire ai clienti un’ampia gamma di opzioni: GPU NVIDIA Ampere, GPU AMD Instinct, Habana Gaudi2, AWS Inferentia 2, CPU Intel Xeon Sapphire Rapids e altro ancora.

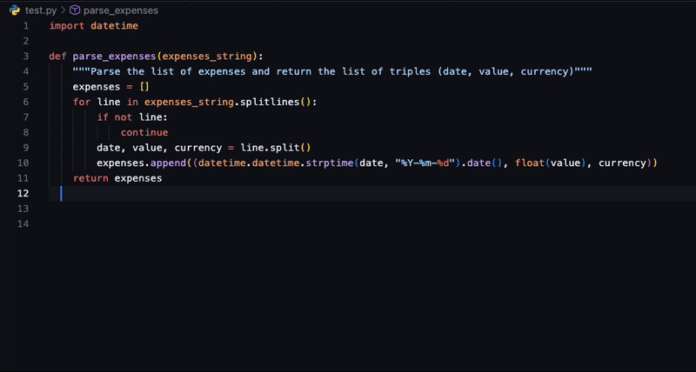

Una volta eseguito il deployment di SafeCoder e che i suoi endpoint sono attivi all’interno del VPC del cliente, gli sviluppatori possono installare i plugin IDE SafeCoder compatibili per ottenere suggerimenti sul codice mentre lavorano. Oggi SafeCoder supporta gli IDE più diffusi, tra cui VSCode, IntelliJ e altri plugin sono in arrivo dai partner.

Per quanto riguarda il come ottenere SafeCoder, inizialmente Hugging Face ha annunciato SafeCoder in collaborazione con VMware e sta rendendo SafeCoder disponibile ai clienti aziendali VMware. La collaborazione con VMware – spiega Hugging Face – contribuisce a garantire il successo dell’implementazione di SafeCoder sull’infrastruttura VMware Cloud dei clienti, qualunque sia lo scenario di infrastruttura cloud, on-premise o ibrida preferito dal cliente. Oltre all’utilizzo di SafeCoder, VMware ha pubblicato un’architettura reference con esempi di codice per consentire il time-to-value più rapido possibile durante l’implementazione e il funzionamento di SafeCoder sull’infrastruttura VMware. La Private AI Reference Architecture di VMware semplifica la possibilità per le aziende di sfruttare rapidamente progetti open source popolari come ray e kubeflow per implementare servizi di AI adiacenti ai loro set di dati privati, collaborando al contempo con Hugging Face per garantire che le aziende mantengano la flessibilità necessaria per trarre vantaggio dalle ultime novità dei modelli open source. Il tutto senza compromettere il costo totale di proprietà o le prestazioni.

“La nostra collaborazione con Hugging Face su SafeCoder è perfettamente in linea con l’obiettivo di VMware di consentire ai clienti di scegliere le soluzioni più adatte, mantenendo la privacy e il controllo dei dati aziendali. In effetti, stiamo utilizzando SafeCoder internamente da mesi e abbiamo riscontrato ottimi risultati. Soprattutto, la nostra collaborazione con Hugging Face è appena iniziata e sono entusiasta di portare la nostra soluzione alle centinaia di migliaia di clienti in tutto il mondo“, ha dichiarato Chris Wolf, Vice President di VMware AI Labs.