OpenAI, laboratorio di ricerca la cui attività è focalizzata sullo sviluppo di Artificial General Intelligence, intelligenza artificiale generale, ha rilasciato Procgen Benchmark, 16 ambienti dall’utilizzo semplice, generati proceduralmente, adatti a fornire una misurazione della rapidità con cui un reinforcement learning agent, cioè un agente artificiale autonomo in grado di apprendere mediante tecnica di rinforzo, apprende abilità generalizzabili.

I ricercatori di OpenAI hanno affermato di aver scoperto che tutti gli ambienti di Procgen Benchmark richiedono un training su 500-1000 livelli diversi prima di poter generalizzare su nuovi livelli. Ciò suggerirebbe, prosegue OpenAI, che i benchmark standard di reinforcement learning (apprendimento per rinforzo) necessitano di molta più diversità all’interno di ciascun ambiente.

Procgen Benchmark è ora diventata la piattaforma di ricerca standard utilizzata dal team di RL di OpenAI. L’organizzazione spera inoltre che questa piattaforma possa accelerare le attività della community tese a creare algoritmi di reinforcement learning migliori e più efficienti.

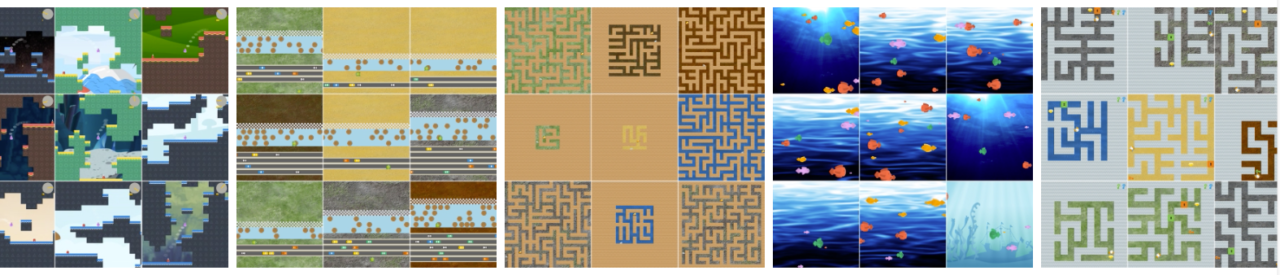

La piattaforma di Procgen Benchmark è costituita da 16 giochi che rappresentano altrettanti ambienti unici, progettati per misurare sia l’efficienza sui campioni che la generalizzazione nell’apprendimento per rinforzo. Questo benchmark, ha spiegato OpenAI, è ideale per la valutazione della generalizzazione, poiché in ciascun ambiente possono essere generati set di training e test distinti.

È adatto anche per valutare la sample efficiency, poiché tutti gli ambienti pongono sfide diverse e convincenti, e questa diversità richiede che gli agenti apprendano delle solide policy di comportamento. In pratica, la capacità di generalizzare diventa una componente integrante del successo, dato che gli agenti devono affrontare livelli in continua evoluzione.

Non è questo l’unico strumento rilasciato di recente da OpenAI, che spiega: i reinforcement learning agents hanno bisogno di esplorare i loro ambienti per apprendere i comportamenti ottimali. Essi, in pratica, operano secondo il principio “trial and error”: provano le cose, vedono cosa funziona e cosa no, e quindi aumentano le probabilità di comportamenti positivi e diminuiscono quelle di comportamenti negativi.

Tuttavia, sottolinea ancora OpenAI, l’esplorazione è rischiosa: gli agenti potrebbero provare comportamenti pericolosi che portano a errori inaccettabili. Questo, in sintesi, è ciò che viene definito il problema della “safe exploration”.

Per questo scopo OpenAI ha pertanto rilasciato Safety Gym, una suite di ambienti e strumenti atti a misurare i progressi degli agenti che rispettano i vincoli di sicurezza durante il training. OpenAI fornisce anche un metodo standardizzato per confrontare gli algoritmi e valutare quanto bene gli agenti evitano gravi errori durante il training.

Se il deep reinforcement learning viene applicato al mondo reale, come nella robotica o nelle attività basate su Internet, sottolinea OpenAI, sarà importante disporre di algoritmi che siano sicuri anche durante il training: come ad esempio nel caso di un’auto a guida autonoma che può imparare a evitare incidenti senza doverli realmente sperimentare.

Maggiori informazioni sono disponibili sul sito di OpenAI.