Opera ha annunciato che, nell’ambito del programma AI Feature Drops dell’azienda, sta aggiungendo al browser il supporto sperimentale per 150 varianti di LLM locali di circa 50 famiglie di modelli.

È la prima volta che gli LLM locali possono essere facilmente accessibili e gestiti da un browser tra quelli principali grazie a una funzione integrata, mette in evidenza la società norvegese.

L’utilizzo di un LLM (Large Language Model) è un processo che in genere richiede l’invio di dati a un server, sottolinea Opera. Gli LLM locali sono diversi, in quanto consentono di elaborare i prompt direttamente sul proprio computer senza che i dati inviati all’LLM locale lascino il computer.

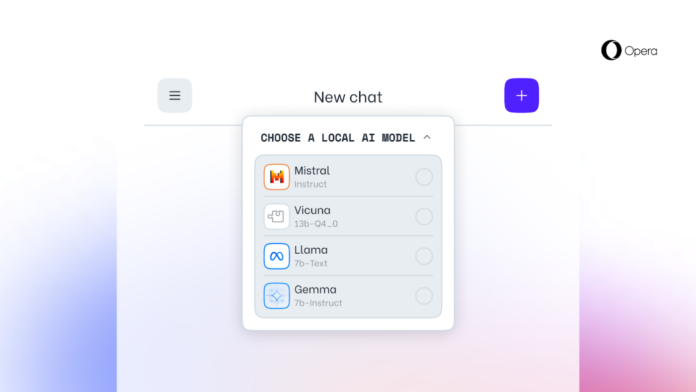

Tra gli LLM locali disponibili in Opera One Developer, è possibile trovare:

Tra gli LLM locali disponibili in Opera One Developer, è possibile trovare:

- Llama di Meta

- Vicuna

- Gemma di Google

- Mixtral di Mistral AI

- E molte altre famiglie

I modelli sono disponibili nello stream developer di Opera One.

L’utilizzo di Local Large Language Models – sottolinea Opera – significa che i dati degli utenti sono conservati localmente, sul loro dispositivo, consentendo loro di utilizzare l’IA senza la necessità di inviare informazioni a un server.

L’azienda sta testando questo nuovo set di LLM locali nello stream per sviluppatori di Opera One come parte del suo AI Feature Drops Program, che consente di testare le prime versioni, spesso sperimentali, del set di funzioni AI.

La community di Opera One Developer ha quindi la possibilità di scegliere il modello con cui elaborare i propri input, il che è molto vantaggioso per gli early adopter che potrebbero avere una preferenza per un modello piuttosto che un altro. Si tratta di una soluzione talmente all’avanguardia – avvisa l’azienda – che potrebbe andare incontro a malfunzionamenti, come accade per i progetti sperimentali.

La community di Opera One Developer ha quindi la possibilità di scegliere il modello con cui elaborare i propri input, il che è molto vantaggioso per gli early adopter che potrebbero avere una preferenza per un modello piuttosto che un altro. Si tratta di una soluzione talmente all’avanguardia – avvisa l’azienda – che potrebbe andare incontro a malfunzionamenti, come accade per i progetti sperimentali.

La scelta di un LLM locale lo scaricherà sul proprio computer, spiega Opera, che fa presente che ognuno di essi richiede tra i 2 e i 10 GB di spazio di archiviazione locale e che un LLM locale è probabilmente molto più lento nel fornire l’output rispetto a uno basato su server, poiché dipende dalle capacità di calcolo dell’hardware. L’LLM locale verrà utilizzato al posto di Aria, il browser nativo di Opera, fino a quando non si inizierà una nuova chat con Aria o semplicemente si riattiverà Aria.