Durante il keynote del DevDay, OpenAI ha annunciato numerose novità, tra nuove aggiunte e miglioramenti, a partire dalla riduzione dei prezzi in molte parti della sua piattaforma di intelligenza artificiale e dai nuovi GPT, le versioni personalizzate di ChatGPT.

Per quanto riguarda le novità tecnologiche, OpenAI ha lanciato un’anteprima della prossima generazione del modello GPT-4: GPT-4 Turbo.

GPT-4 Turbo – ha spiegato lo specialista dell’AI generativa – fornisce maggiori capacità e ha una conoscenza degli eventi mondiali fino ad aprile 2023; inoltre, dispone di un contesto da 128k che consente di inserire l’equivalente di oltre 300 pagine di testo in un singolo prompt.

Il team ha anche ottimizzato le sue prestazioni, ed è per questo che OpenAI è in grado di offrire GPT-4 Turbo a un prezzo 3 volte inferiore per i token di input e 2 volte inferiore per i token di output, rispetto a GPT-4.

GPT-4 Turbo è disponibile in versione preview per tutti gli sviluppatori paganti per provarlo, e l’azienda ha in programma di rilasciare il modello stabile pronto per la produzione nelle prossime settimane.

OpenAI ha introdotto miglioramenti per le funzionalità di function calling e sottolineato che GPT-4 Turbo si comporta meglio dei modelli precedenti nei task che richiedono di seguire attentamente le istruzioni, come la generazione di formati specifici (ad esempio, “always respond in XML“). Inoltre, GPT-4 Turbo supporta la nuova modalità JSON, che garantisce che il modello risponda con JSON valido.

Il nuovo modello include ulteriori miglioramenti progettati per gli sviluppatori e, oltre a GPT-4 Turbo, l’azienda ha rilasciato anche una nuova versione di GPT-3.5 Turbo che supporta una finestra di contesto da 16K per impostazione predefinita e presenta altri aggiornamenti.

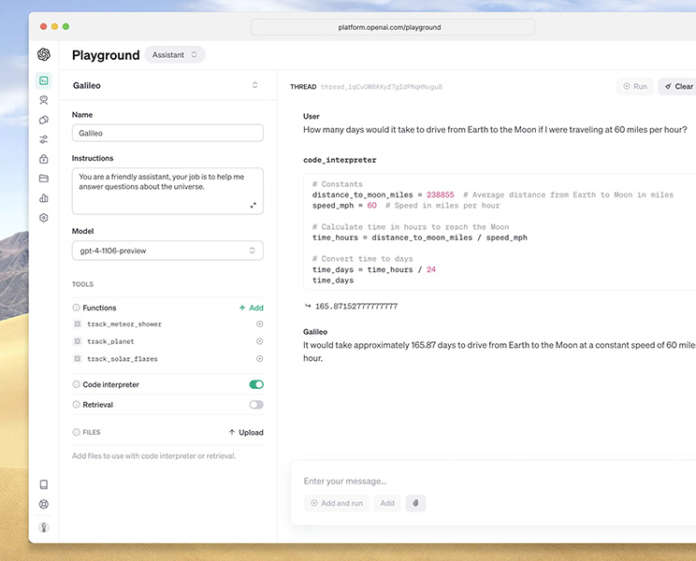

Un altro annuncio importante è il rilascio dell’API Assistants, in beta, descritta come il primo passo di OpenAI per aiutare gli sviluppatori a creare esperienze simili a quelle degli agent nelle loro applicazioni. Un assistant è un’intelligenza artificiale costruita ad hoc che dispone di istruzioni specifiche, sfrutta conoscenze aggiuntive e può richiamare modelli e strumenti per eseguire compiti.

La nuova API Assistants offre nuove capacità, come Code Interpreter, Retrieval e Function calling, per gestire gran parte del lavoro pesante che in precedenza gli sviluppatori dovevano fare da soli e consentire la creazione di applicazioni AI di alta qualità.

Questa API, spiega OpenAI, è stata progettata per essere flessibile: i casi d’uso spaziano da un’applicazione per l’analisi dei dati in linguaggio naturale, a un assistente di programmazione, a un pianificatore di vacanze alimentato dall’intelligenza artificiale, a un DJ a comando vocale, a un canvas visuale smart, e altro ancora.

Un cambiamento fondamentale introdotto da questa API sono i thread persistenti e infinitamente lunghi, che consentono agli sviluppatori di demandare a OpenAI la gestione dello stato dei thread e di aggirare i vincoli della finestra di contesto. Con l’API Assistants, è sufficiente aggiungere ogni nuovo messaggio a un thread esistente.

Ci sono poi nuove modalità nell’API. GPT-4 Turbo può accettare immagini come input nell’API Chat Completions, abilitando casi d’uso quali la generazione di didascalie, l’analisi dettagliata di immagini del mondo reale e la lettura di documenti con figure.

Gli sviluppatori possono integrare DALL-E 3, che l’azienda ha recentemente lanciato per gli utenti di ChatGPT Plus ed Enterprise, direttamente nelle loro applicazioni e nei loro prodotti attraverso l’API Images, specificandolo come modello. Inoltre, gli sviluppatori possono ora generare un parlato di qualità umana a partire dal testo tramite l’API text-to-speech. Il nuovo modello TTS offre sei voci preimpostate tra cui scegliere e due varianti di modello.

OpenAI sta anche creando un programma di accesso sperimentale per il fine-tuning di GPT-4. I risultati preliminari, sottolinea l’azienda, indicano che il fine-tuning di GPT-4 richiede più lavoro per ottenere miglioramenti significativi rispetto al modello di base, in confronto a quelli sostanziali ottenuti con il fine-tuning di GPT-3.5.

Per le organizzazioni che hanno bisogno di una customizzazione ancora maggiore di quella che può fornire il fine-tuning, l’azienda sta anche lanciando un programma Custom Models, che offre a organizzazioni selezionate l’opportunità di lavorare con un gruppo dedicato di ricercatori OpenAI per addestrare GPT-4 personalizzati per il loro dominio specifico.

L’azienda ha poi annunciato il rilascio di Whisper large-v3, la prossima versione del modello di riconoscimento vocale automatico (ASR) open source, che offre prestazioni migliori in tutte le lingue, e ha affermato di avere anche in programma di supportare Whisper v3 nella propria API, nel prossimo futuro.

OpenAI sta inoltre aprendo in open source il Consistency Decoder, un sostituto del decoder Stable Diffusion VAE. Questo decoder migliora tutte le immagini compatibili con il VAE di Stable Diffusion 1.0+, con miglioramenti significativi per testo, volti e linee rette.

Per quanto riguarda gli annunci di carattere commerciale, la novità più significativa è quella dei prezzi più bassi. OpenAI sta diminuendo diversi prezzi in tutta la sua piattaforma per trasferire i risparmi agli sviluppatori.

Gli input token di GPT-4 Turbo sono 3 volte più economici rispetto a GPT-4, a 0,01 dollari, e gli output token sono 2 volte più economici, a 0,03 dollari (i prezzi, come i successivi, sono espressi per 1.000 token).

I token di input GPT-3.5 Turbo sono 3 volte più economici del precedente modello 16K a 0,001 dollari e i token di output sono 2 volte più economici a 0,002 dollari. Gli sviluppatori che in precedenza utilizzavano GPT-3.5 Turbo 4K beneficiano di una riduzione del 33% sui token di input a 0,001 dollari. Questi prezzi più bassi si applicano solo al nuovo GPT-3.5 Turbo presentato al DevDay.

I token di input del modello GPT-3.5 Turbo 4K Fine-tuned sono ridotti di 4 volte a 0,003 dollari e gli output token sono più economici di 2,7 volte a 0,006 dollari. Con il nuovo modello GPT-3.5 Turbo, il fine-tuning supporta anche il contesto 16K allo stesso prezzo del 4K.

Oltre al pricing, per aiutare le imprese a scalare le proprie applicazioni, OpenAI sta raddoppiando il limite di token al minuto per tutti i clienti GPT-4 paganti. È possibile visualizzare i nuovi limiti nella pagina dei rate limits. L’azienda ha anche pubblicato i tier di utilizzo che determinano gli aumenti automatici dei limiti tariffari, in modo che i clienti sappiano cosa aspettarsi dal modo in cui i loro limiti di utilizzo scaleranno automaticamente. Ed è ora possibile richiedere l’aumento dei limiti di utilizzo dalle impostazioni dell’account.

Infine, OpenAI ha sottolineato il suo impegno a proteggere i propri clienti con misure di salvaguardia del copyright integrate nei propri sistemi. E ha presentato un ulteriore passo avanti con l’introduzione del Copyright Shield: OpenAI ha annunciato che interverrà in difesa dei propri clienti e pagherà i costi sostenuti in caso di azioni legali per violazione del copyright. Questo vale – spiega OpenAI – per le funzionalità generalmente disponibili di ChatGPT Enterprise e della piattaforma per sviluppatori.