In occasione della conferenza GTC, oltre alla rivoluzionaria piattaforma Blackwell, NVIDIA ha lanciato decine di microservizi di AI generativa di livello enterprise che le aziende possono utilizzare per creare e distribuire applicazioni personalizzate sulle proprie piattaforme, mantenendo la piena proprietà e il controllo della loro proprietà intellettuale.

Costruito sulla base della piattaforma NVIDIA CUDA, il catalogo di microservizi cloud-nativi include microservizi NVIDIA NIM per l’inferenza ottimizzata su oltre due dozzine di modelli AI popolari di NVIDIA e del suo ecosistema di partner. Inoltre, i kit di sviluppo software accelerati, le librerie e gli strumenti di NVIDIA sono ora accessibili come microservizi NVIDIA CUDA-X per la retrieval-augmented generation (RAG), i guardrail, l’elaborazione dei dati, l’HPC e altro ancora.

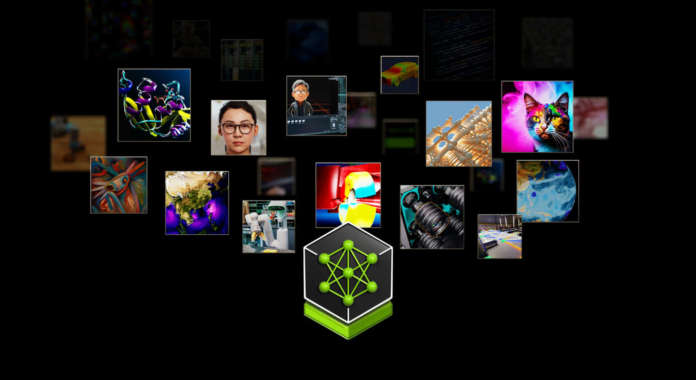

La selezione curata di microservizi aggiunge un nuovo livello alla piattaforma di computing full-stack di NVIDIA. Questo livello collega l’ecosistema AI di sviluppatori di modelli, fornitori di piattaforme e aziende con un percorso standardizzato per l’esecuzione di modelli AI personalizzati ottimizzati per la base installata di centinaia di milioni di GPU NVIDIA CUDA su cloud, data center, workstation e PC.

Fra i primi ad accedere ai nuovi microservizi di intelligenza artificiale generativa di NVIDIA disponibili in NVIDIA AI Enterprise 5.0 ci sono i principali fornitori di applicazioni, dati e piattaforme di cybersecurity, fra cui Adobe, Cadence, CrowdStrike, Getty Images, SAP, ServiceNow e Shutterstock.

“Le piattaforme aziendali consolidate sono sedute su una miniera d’oro di dati che possono essere trasformati in copiloti di AI generativa“, ha dichiarato Jensen Huang, fondatore e CEO di NVIDIA. “Creati in collaborazione con il nostro ecosistema di partner, questi microservizi di AI containerizzati sono i mattoni che permettono alle imprese di ogni settore di diventare aziende di AI“.

I microservizi di inferenza NIM velocizzano le implementazioni da settimane a minuti

I microservizi di inferenza NIM velocizzano le implementazioni da settimane a minuti

I microservizi NIM forniscono container precostituiti basati sul software di inferenza NVIDIA – fra cui Triton Inference Server e TensorRT-LLM – che consentono agli sviluppatori di ridurre i tempi di implementazione da settimane a minuti, afferma l’azienda.

Forniscono API standard di settore per domini quali il linguaggio, il parlato e la scoperta di farmaci, per consentire agli sviluppatori di creare rapidamente applicazioni di IA utilizzando i loro dati proprietari ospitati in modo sicuro nella propria infrastruttura. Queste applicazioni possono scalare su richiesta, offrendo flessibilità e prestazioni per l’esecuzione di IA generativa in produzione su piattaforme di elaborazione accelerate da NVIDIA.

I microservizi NIM – dichiara NVIDIA – forniscono il container di AI di produzione più rapido e performante per la distribuzione di modelli di NVIDIA, A121, Adept, Cohere, Getty Images e Shutterstock, nonché di modelli open di Google, Hugging Face, Meta, Microsoft, Mistral AI e Stability AI.

ServiceNow ha annunciato oggi l’utilizzo di NIM per sviluppare e distribuire nuovi copiloti specifici per il dominio e altre applicazioni di IA generativa in modo più rapido e conveniente.

I clienti potranno accedere ai microservizi NIM da Amazon SageMaker, Google Kubernetes Engine e Microsoft Azure AI, e integrarsi con framework di AI popolari come Deepset, LangChain e LlamaIndex.

Microservizi CUDA-X per RAG, elaborazione dati, Guardrail, HPC

I microservizi CUDA-X forniscono building block end-to-end per la preparazione dei dati, la personalizzazione e il training per accelerare lo sviluppo dell’IA in produzione in tutti i settori.

Per accelerare l’adozione dell’IA, le aziende possono utilizzare i microservizi CUDA-X, fra cui NVIDIA Riva per l’IA vocale e di traduzione personalizzabile, NVIDIA cuOpt per l’ottimizzazione del routing e NVIDIA Earth-2 per le simulazioni climatiche e meteorologiche ad alta risoluzione.

I microservizi NeMo Retriever consentono agli sviluppatori di collegare le loro applicazioni di IA ai dati aziendali – inclusi testo, immagini e visualizzazioni come grafici a barre, grafici a linee e grafici a torta – per generare risposte altamente accurate e contestualmente rilevanti. Grazie a queste funzionalità RAG, le aziende possono offrire più dati ai copilot, ai chatbot e agli strumenti di produttività dell’intelligenza artificiale generativa per aumentare l’accuratezza e la comprensione.

Sono in arrivo altri microservizi NVIDIA NeMo per lo sviluppo di modelli personalizzati. Questi includono NVIDIA NeMo Curator per la creazione di set di dati puliti per l’addestramento e il recupero, NVIDIA NeMo Customizer per la messa a punto degli LLM con dati specifici del dominio, NVIDIA NeMo Evaluator per l’analisi delle prestazioni dei modelli di AI e NVIDIA NeMo Guardrails per gli LLM.

L’ecosistema potenzia le piattaforme aziendali con microservizi di IA generativa

Oltre ai principali fornitori di applicazioni, i fornitori di piattaforme di dati, infrastrutture e calcolo dell’ecosistema NVIDIA stanno lavorando con i microservizi NVIDIA per portare l’IA generativa nelle aziende.

I principali fornitori di piattaforme di dati, fra cui Box, Cloudera, Cohesity, Datastax, Dropbox e NetApp, stanno collaborando con i microservizi NVIDIA per aiutare i clienti a ottimizzare le loro pipeline RAG e a integrare i loro dati proprietari nelle applicazioni di IA generativa. Snowflake si basa su NeMo Retriever per sfruttare i dati aziendali per la creazione di applicazioni di IA.

Le aziende possono distribuire i microservizi NVIDIA inclusi in NVIDIA AI Enterprise 5.0 sull’infrastruttura di loro scelta, come i principali cloud Amazon Web Services (AWS), Google Cloud, Azure e Oracle Cloud Infrastructure.

I microservizi NVIDIA sono inoltre supportati da oltre 400 sistemi certificati NVIDIA, fra cui server e workstation di Cisco, Dell Technologies, Hewlett Packard Enterprise (HPE) , HP, Lenovo e Supermicro.

I microservizi NVIDIA AI Enterprise stanno arrivando sulle piattaforme software di infrastruttura, fra cui VMware Private AI Foundation con NVIDIA. Red Hat OpenShift supporta i microservizi NVIDIA NIM per aiutare le aziende a integrare più facilmente le capacità di AI generativa nelle loro applicazioni con funzionalità ottimizzate per la sicurezza, la conformità e i controlli. Canonical sta aggiungendo il supporto di Charmed Kubernetes per i microservizi NVIDIA attraverso NVIDIA AI Enterprise.

L’ecosistema di NVIDIA, composto da centinaia di partner AI e MLOps, fra cui Abridge, Anyscale, Dataiku, DataRobot, Glean, H2O.ai, Securiti AI, Scale AI, OctoAI e Weights & Biases, sta aggiungendo il supporto per i microservizi NVIDIA attraverso NVIDIA AI Enterprise.

Apache Lucene, Datastax, Faiss, Kinetica, Milvus, Redis e Weaviate sono fra i fornitori di ricerca vettoriale che collaborano con i microservizi NVIDIA NeMo Retriever per alimentare le funzionalità RAG reattive delle aziende.

Gli sviluppatori possono sperimentare gratuitamente i microservizi NVIDIA su ai.nvidia.com. Le aziende possono implementare microservizi NIM di livello produttivo con NVIDIA AI Enterprise 5.0 in esecuzione su sistemi certificati NVIDIA e sulle principali piattaforme cloud.

Per ulteriori informazioni, è possibile guardare il keynote di Huang al GTC.