NVIDIA ha annunciato l’arrivo della piattaforma NVIDIA Blackwell, progettata per consentire alle organizzazioni di tutto il mondo di creare ed eseguire l’IA generativa in tempo reale su modelli linguistici di grandi dimensioni da un trilione di parametri con costi e consumi energetici fino a 25 volte inferiori rispetto al suo predecessore.

L’architettura delle GPU Blackwell è caratterizzata da sei tecnologie trasformative per l’accelerazione del calcolo, che contribuiranno a sbloccare le innovazioni nell’elaborazione dei dati, nella simulazione ingegneristica, nell’automazione della progettazione elettronica, nella progettazione di farmaci assistita da computer, nell’elaborazione quantistica e nell’IA generativa, tutte opportunità emergenti per NVIDIA.

“Per tre decenni abbiamo perseguito l’accelerated computing, con l’obiettivo di rendere possibili innovazioni trasformative come il deep learning e l’IA“, ha dichiarato Jensen Huang, fondatore e CEO di NVIDIA. “L’IA generativa è la tecnologia più importante del nostro tempo. Blackwell è il motore di questa nuova rivoluzione industriale. Lavorando con le aziende più dinamiche del mondo, realizzeremo la promessa dell’IA per ogni settore“.

Tra le numerose organizzazioni che si prevede adotteranno Blackwell vi sono Amazon Web Services, Dell Technologies, Google, Meta, Microsoft, OpenAI, Oracle, Tesla e xAI.

Denominata così in onore del matematico e statistico americano David Harold Blackwell, la nuova architettura succede a NVIDIA Hopper, lanciata due anni fa.

Le sei tecnologie di Blackwell che NVIDIA descrive come rivoluzionarie e che, insieme, consentono l’addestramento dell’IA e l’inferenza in tempo reale per modelli LLM che arrivano a 10 trilioni di parametri, comprendono:

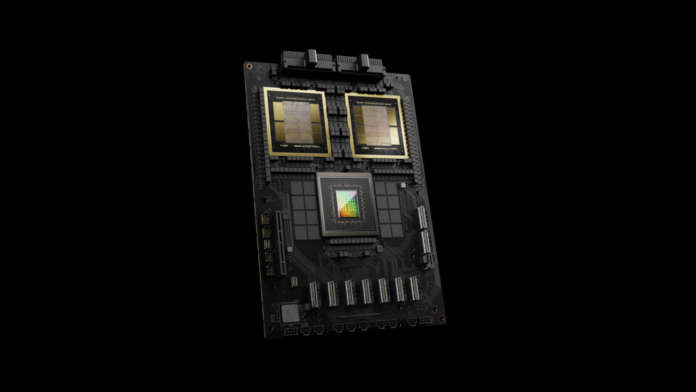

- Il chip che NVIDIA definisce il più potente del mondo – Dotate di 208 miliardi di transistor, le GPU con architettura Blackwell sono prodotte utilizzando un processo TSMC 4NP personalizzato con due die di GPU collegati da un link chip-to-chip di 10 TB/secondo in un’unica GPU unificata.

- Transformer Engine di seconda generazione – Grazie al nuovo supporto per il micro-tensor scaling e agli algoritmi avanzati di gestione della gamma dinamica di NVIDIA integrati nei framework NVIDIA TensorRT-LLM e NeMo Megatron, Blackwell supporterà dimensioni di calcolo e modelli raddoppiate con nuove capacità di inferenza AI in virgola mobile a 4 bit.

- NVLink di quinta generazione – Per accelerare le prestazioni dei modelli di intelligenza artificiale a parametri multipli e mixture-of-experts, l’ultima iterazione di NVIDIA NVLink offre un throughput bidirezionale di 1,8 TB/s per GPU, garantendo una comunicazione ad alta velocità senza soluzione di continuità tra un massimo di 576 GPU per gli LLM più complessi.

- Motore RAS – Le GPU Blackwell includono un motore dedicato per l’affidabilità, la disponibilità e la manutenibilità. Inoltre, l’architettura Blackwell aggiunge capacità a livello di chip per utilizzare la manutenzione preventiva basata sull’intelligenza artificiale per eseguire la diagnostica e prevedere i problemi di affidabilità. In questo modo si massimizza il tempo di attività del sistema e si migliora la resilienza per le implementazioni di IA su larga scala, che possono funzionare ininterrottamente per settimane o addirittura mesi e ridurre i costi operativi.

- AI sicura – Le funzionalità avanzate di confidential computing proteggono i modelli di AI e i dati dei clienti senza compromettere le prestazioni, con il supporto dei nuovi protocolli di crittografia dell’interfaccia nativi, fondamentali per i settori sensibili alla privacy come la sanità e i servizi finanziari.

- Motore di decompressione – Un motore di decompressione dedicato supporta i formati più recenti, accelerando le query di database per offrire le massime prestazioni nell’analisi dei dati e nella scienza dei dati. Nei prossimi anni l’elaborazione dei dati, per la quale le aziende spendono decine di miliardi di dollari all’anno, sarà sempre più accelerata dalle GPU, sottolinea NVIDIA.

Il superchip NVIDIA GB200 Grace Blackwell collega due GPU NVIDIA B200 Tensor Core alla CPU NVIDIA Grace tramite un’interconnessione chip-to-chip NVLink a bassissimo consumo da 900 GB/s.

Per ottenere le massime prestazioni AI, i sistemi GB200 possono essere collegati con le piattaforme NVIDIA Quantum-X800 InfiniBand e Spectrum-X800 Ethernet, anch’esse annunciate oggi, che offrono networking avanzato con velocità fino a 800Gb/s.

GB200 è un componente chiave di NVIDIA GB200 NVL72, un sistema multi-nodo, raffreddato a liquido e su scala rack per i carichi di lavoro più intensivi. Combina 36 Grace Blackwell Superchip, che comprendono 72 GPU Blackwell e 36 CPU Grace interconnesse tramite NVLink di quinta generazione. Inoltre, GB200 NVL72 include le unità di elaborazione dati NVIDIA BlueField-3 per consentire l’accelerazione della rete cloud, lo storage composito, la sicurezza zero-trust e l’elasticità del calcolo GPU nei cloud AI hyperscale. GB200 NVL72 offre un aumento delle prestazioni fino a 30 volte rispetto allo stesso numero di GPU NVIDIA H100 Tensor Core per i carichi di lavoro di inferenza LLM e riduce i costi e il consumo energetico fino a 25 volte, afferma il produttore.

GB200 è un componente chiave di NVIDIA GB200 NVL72, un sistema multi-nodo, raffreddato a liquido e su scala rack per i carichi di lavoro più intensivi. Combina 36 Grace Blackwell Superchip, che comprendono 72 GPU Blackwell e 36 CPU Grace interconnesse tramite NVLink di quinta generazione. Inoltre, GB200 NVL72 include le unità di elaborazione dati NVIDIA BlueField-3 per consentire l’accelerazione della rete cloud, lo storage composito, la sicurezza zero-trust e l’elasticità del calcolo GPU nei cloud AI hyperscale. GB200 NVL72 offre un aumento delle prestazioni fino a 30 volte rispetto allo stesso numero di GPU NVIDIA H100 Tensor Core per i carichi di lavoro di inferenza LLM e riduce i costi e il consumo energetico fino a 25 volte, afferma il produttore.

La piattaforma agisce come una singola GPU con 1,4 exaflop di prestazioni AI e 30 TB di memoria veloce ed è un elemento costitutivo del nuovissimo DGX SuperPOD.

NVIDIA offre HGX B200, una scheda server che collega otto GPU B200 tramite NVLink per supportare piattaforme di AI generativa basate su x86. HGX B200 supporta velocità di networking fino a 400 Gb/s attraverso le piattaforme di networking NVIDIA Quantum-2 InfiniBand e Spectrum-X Ethernet.

I prodotti basati su Blackwell – annuncia NVIDIA – saranno disponibili presso i partner a partire dalla fine dell’anno.

AWS, Google Cloud, Microsoft Azure e Oracle Cloud Infrastructure saranno tra i primi fornitori di servizi cloud a offrire istanze basate su Blackwell, così come le aziende del programma NVIDIA Cloud Partner Applied Digital, CoreWeave, Crusoe, IBM Cloud e Lambda. Anche i cloud AI sovrani forniranno servizi e infrastrutture cloud basati su Blackwell, tra cui Indosat Ooredoo Hutchinson, Nebius, Nexgen Cloud, Oracle EU Sovereign Cloud, i cloud governativi di Oracle US, UK e Australian, Scaleway, Singtel, Northern Data Group’s Taiga Cloud, Yotta Data Services’ Shakti Cloud e YTL Power International.

GB200 sarà disponibile anche su NVIDIA DGX Cloud, una piattaforma di AI progettata in collaborazione con i principali fornitori di servizi cloud che offre agli sviluppatori aziendali un accesso dedicato all’infrastruttura e al software necessari per costruire e distribuire modelli avanzati di AI generativa. AWS, Google Cloud e Oracle Cloud Infrastructure prevedono di ospitare nuove istanze basate su NVIDIA Grace Blackwell nel corso dell’anno.

Cisco, Dell, Hewlett Packard Enterprise, Lenovo e Supermicro dovrebbero fornire un’ampia gamma di server basati sui prodotti Blackwell, così come Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn e ZT Systems.

Inoltre, una rete crescente di produttori di software, tra cui Ansys, Cadence e Synopsys – leader mondiali nella simulazione ingegneristica – utilizzerà i processori basati su Blackwell per accelerare il proprio software di progettazione e simulazione di sistemi e parti elettriche, meccaniche e di produzione. I loro clienti possono utilizzare l’intelligenza artificiale generativa e l’elaborazione accelerata per portare i prodotti sul mercato più velocemente, a costi inferiori e con una maggiore efficienza energetica.

Il portafoglio di prodotti Blackwell è supportato da NVIDIA AI Enterprise, il sistema operativo end-to-end per l’IA di livello produttivo. NVIDIA AI Enterprise include i microservizi di inferenza NVIDIA NIM – anch’essi annunciati oggi – oltre a framework, librerie e strumenti di AI che le aziende possono distribuire su cloud, data center e workstation accelerati da NVIDIA.

Sundar Pichai, CEO di Alphabet e Google: “Scalare servizi come Search e Gmail a miliardi di utenti ci ha insegnato molto sulla gestione dell’infrastruttura di calcolo. Mentre entriamo nel passaggio alla piattaforma AI, continuiamo a investire profondamente nell’infrastruttura per i nostri prodotti e servizi e per i nostri clienti Cloud. Siamo fortunati ad avere una partnership di lunga data con NVIDIA e non vediamo l’ora di portare le rivoluzionarie capacità delle GPU Blackwell ai nostri clienti Cloud e ai team di Google, fra cui Google DeepMind, per accelerare le scoperte future“.

Andy Jassy, presidente e CEO di Amazon: “La nostra profonda collaborazione con NVIDIA risale a più di 13 anni fa, quando abbiamo lanciato la prima istanza cloud di GPU al mondo su AWS. Oggi offriamo la più ampia gamma di soluzioni GPU disponibili in cloud, in grado di supportare i carichi di lavoro accelerati tecnologicamente più avanzati del mondo. Questo è il motivo per cui la nuova GPU NVIDIA Blackwell funzionerà così bene su AWS e il motivo per cui NVIDIA ha scelto AWS per co-sviluppare Project Ceiba, che combina i Superchip Grace Blackwell di nuova generazione di NVIDIA con la virtualizzazione avanzata e il networking ultraveloce Elastic Fabric Adapter del sistema AWS Nitro, per la ricerca e lo sviluppo dell’intelligenza artificiale di NVIDIA. Grazie a questo sforzo congiunto degli ingegneri di AWS e NVIDIA, continuiamo a innovare insieme per rendere AWS il luogo migliore per l’esecuzione delle GPU NVIDIA nel cloud“.

Michael Dell, fondatore e CEO di Dell Technologies: “L’intelligenza artificiale generativa è fondamentale per creare sistemi più intelligenti, affidabili ed efficienti. Dell Technologies e NVIDIA stanno lavorando insieme per dare forma al futuro della tecnologia. Con il lancio di Blackwell, continueremo a offrire la prossima generazione di prodotti e servizi accelerati ai nostri clienti, fornendo loro gli strumenti necessari per guidare l’innovazione in tutti i settori“.

Demis Hassabis, cofondatore e CEO di Google DeepMind: “Il potenziale di trasformazione dell’IA è incredibile e ci aiuterà a risolvere alcuni dei problemi scientifici più importanti del mondo. Le capacità tecnologiche rivoluzionarie di Blackwell forniranno il calcolo critico necessario per aiutare le menti più brillanti del mondo a tracciare nuove scoperte scientifiche“.

Mark Zuckerberg, fondatore e CEO di Meta: “L’intelligenza artificiale è già alla base di tutto, dai nostri modelli linguistici alle raccomandazioni di contenuti, agli annunci pubblicitari e ai sistemi di sicurezza, e in futuro diventerà sempre più importante. Non vediamo l’ora di utilizzare Blackwell di NVIDIA per contribuire all’addestramento dei nostri modelli Llama open-source e alla creazione della prossima generazione di prodotti Meta AI e consumer“.

Satya Nadella, presidente esecutivo e CEO di Microsoft: “Siamo impegnati a offrire ai nostri clienti l’infrastruttura più avanzata per alimentare i loro carichi di lavoro AI. Con l’introduzione del processore GB200 Grace Blackwell nei nostri datacenter a livello globale, ci basiamo sulla nostra lunga storia di ottimizzazione delle GPU NVIDIA per il nostro cloud, per rendere reale la promessa dell’IA per le organizzazioni di tutto il mondo“.

Sam Altman, CEO di OpenAI: “Blackwell offre enormi balzi prestazionali e accelererà la nostra capacità di fornire modelli all’avanguardia. Siamo entusiasti di continuare a lavorare con NVIDIA per migliorare l’elaborazione dell’intelligenza artificiale“.

Larry Ellison, presidente e CTO di Oracle: “La stretta collaborazione di Oracle con NVIDIA consentirà di ottenere progressi qualitativi e quantitativi nell’IA, nell’apprendimento automatico e nell’analisi dei dati. Affinché i clienti possano scoprire intuizioni sempre più interessanti, è necessario un motore ancora più potente come Blackwell, costruito appositamente per l’elaborazione accelerata e l’IA generativa“.

Elon Musk, CEO di Tesla e xAI: “Attualmente non esiste nulla di meglio dell’hardware NVIDIA per l’IA“.