Ciao a tutti. Questo è l’episodio nove di Le voci dell’AI.

Oggi parliamo di come le aziende di tutto il mondo si stanno organizzando per assumere personale in grado di sviluppare progetti basati sull’intelligenza artificiale per l’uso interno o la commercializzazione.

In particolare, voglio ragionare con voi su una serie di passi falsi che è molto facile osservare.

Uno degli errori più frequenti, commesso sia dalle aziende che consumano AI che da quelle che vendono soluzioni basate sull’AI, è quello di trattare l’intelligenza artificiale moderna, come per esempio l’intelligenza generativa, alla stessa stregua delle altre tecnologie che nei decenni sono state rilasciate dall’industria informatica.

Assegnare la responsabilità di un progetto AI a un product manager che non ha nessuna competenza sull’AI è un errore che può costare il fallimento dell’intero progetto perché, a differenza di un progetto software tradizionale, i tempi di sviluppo di un progetto AI sono dettati dal tempo necessario per il training del modello di AI che è stato selezionato.

Questo processo è estremamente laborioso per due ragioni.

La prima ragione: la nostra comprensione di come funzionano i modelli di intelligenza artificiale che abbiamo inventato è ancora parziale.

Ci sono una serie di cose che non abbiamo ancora la capacità di spiegare del tutto e quindi il training di un modello di AI procede per tentativi al fine di trovare la configurazione adatta per milioni o bilioni di parametri che eventualmente producono il risultato desiderato.

Immaginate la console di un aereo di linea moderna come l’airbus A380. Immaginate di avere un risultato in mente: l’atterraggio dell’aereo sulla pista. Ma immaginate di sapere come funziona solo una piccola parte dei bottoni e delle leve che vedete nella foto.

Per ottenere questo risultato, il risultato sperato, cioè un atterraggio perfetto, dovete provare a modificare la posizione di tutti gli switch, le leve e i bottoni finché la loro combinazione non è perfetta.

Questa è una delle ragioni per cui una delle aziende più esperte del mondo nello sviluppo di modelli di AI considera i propri ricercatori alla stessa stregua di un gruppo di artisti e li tratta come tali, menzionando questo approccio manageriale pubblicamente.

Io preferisco pensare ai ricercatori e agli ingegneri di machine learning come un gruppo di maghi. Ed è così che li ho sempre chiamati, quando sono stato alla guida di un team di AI nel passato.

I lunghi tempi del training

Seconda ragione per cui il processo di sviluppo di un modello di AI è estremamente laborioso: usiamo ancora l’analogia dell’aereo di linea: gli ingegneri di machine learning non possono sapere se la combinazione di switch, leve e bottoni che hanno scelto è quella giusta finché l’aereo non tenta l’atterraggio alla fine di un volo.

Il processo è lungo perché l’aereo deve prima decollare per tentare l’atterraggio e perché prima di arrivare alla combinazione giusta, l’aereo tenta un atterraggio pericoloso moltissime volte, consumando enormi quantità di carburante per ogni tentativo.

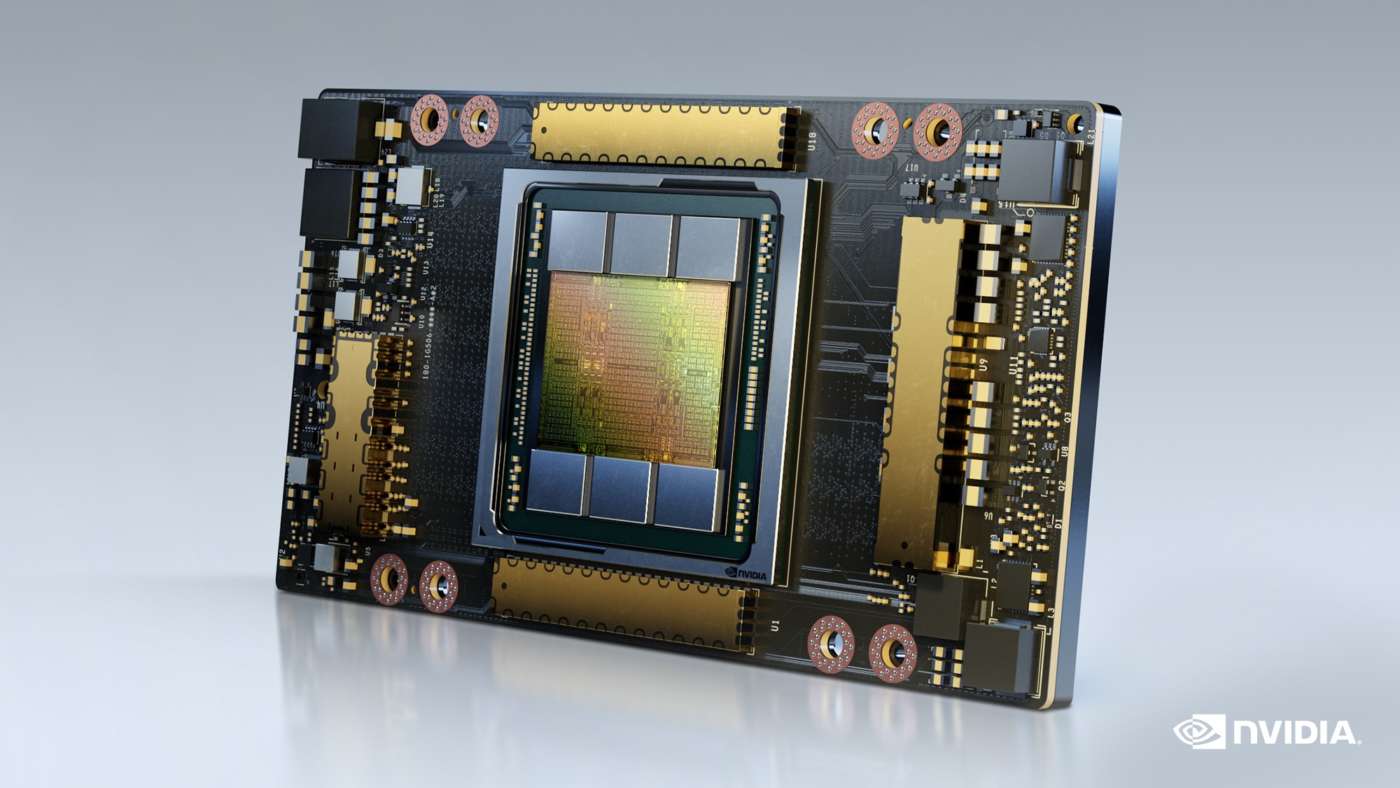

Gli ingegneri machine learning devono decidere la combinazione di parametri del modello prima di cominciare la fase di training, e solo alla fine di questo lungo e costoso processo che richiede l’uso di centinaia di migliaia di GPU per giorni, settimane, mesi, è possibile capire se la combinazione è la migliore possibile per ottenere quello che si intende ottenere.

Per esempio, i ricercatori che lavorano per Meta AI hanno usato 2048 Gpu di tipo Nvidia A100 Tensor Core per cinque mesi per rilasciare il set di modelli chiamato LLama, cioè 7,4 milioni di ore.

Alcuni stimano che il training di GPT 3 sviluppato da OpenAI abbia richiesto un milione di ore con la stessa configurazione di GPU, mentre GPT-4 potrebbe aver richiesto cento milioni di ore.

il training dei modelli finali di solito è un quarto del tempo totale dedicato ai vari tentativi per trovare la configurazione perfetta.

Mentre è vero che pochissime aziende nel mondo sviluppano internamente modelli AI enormi come quelli che abbiamo menzionato, il punto vale anche per i modelli più modesti. I tempi di training dei modelli di AI sono difficilissimi da stimare in anticipo.

Oltre a tutto questo, ci sono varie altre complessità uniche legate a un progetto di AI.

Per esempio, i risvolti legali relativi all’uso del materiale che viene utilizzato per il training dei modelli. Anche un’azienda che non sviluppa i propri modelli, ma si limita all’ operazione di fine tuning del modello di qualcun altro, deve considerare quali sono i diritti d’autore delle foto, dei documenti, delle porzioni di codice, dei brani musicali, delle registrazioni di voci e così via, che sta utilizzando per il fine tuning.

Un product manager che non ha chiari tutti questi aspetti, e molti altri che oggi non abbiamo il tempo di discutere, e che tratta un progetto AI alla stessa stregua di un qualunque altro progetto software, finisce irrimediabilmente per sottostimare i tempi di consegna di quel progetto.

Lo stesso product manager probabilmente comunicherà in maniera inadeguata le sfide del progetto all’ufficio legale, ai dirigenti dell’azienda, al dipartimento di marketing, a quello delle relazioni pubbliche e così via.

Per non correre questo rischio, alcune aziende fanno l’errore opposto: assegnano la responsabilità di un progetto di AI a un ricercatore o a un machine learning engineer.

Chiaramente queste figure professionali sono assolutamente competenti su molti degli aspetti che abbiamo menzionato, ma non sono necessariamente i profili più adatti per sviluppare altri aspetti critici legati a un progetto AI, come la strategia di business, la roadmap di prodotto, la narrativa di marketing e così via.

Spesso questi profili non hanno nemmeno una grande dimestichezza, o un grande interesse a comunicare con gli altri dipartimenti dell’azienda.

Mi è capitato più volte di sentire esperti di machine learning assegnati alla guida di un progetto di che lamentarsi delle grandi difficoltà nella comunicazione con l’ufficio legale o quello di marketing.

E quindi in questo scenario l’azienda si ritrova con un progetto AI gestito in maniera esemplare dal punto di vista tecnico, ma finisce per essere comunque un fallimento a causa di una mancata comprensione del mercato, una scarsa dimestichezza con le dinamiche aziendali.

La raccomandazione è chiara spero se proprio avete deciso di assumere o promuovere un Chief AI Officer o un product manager che guidi un progetto di AI specifico, siate certi di scegliere una persona con competenze di intelligenza artificiale, ma non una persona che abbia esclusivamente competenze tecniche ed esclusivamente legate all’intelligenza artificiale.

Considerate che di questo passo gli utenti di tutto il mondo si aspetteranno molto presto che qualunque software in commercio o qualunque soluzione utilizzata internamente includa una componente di intelligenza artificiale, per ridurre la frizione d’uso e aumentare la produttività.

Il vostro Chief AI Officer, o in qualunque altro modo vogliate chiamarlo, dovrà avere una visione più complessiva del mercato di un esperto di AI puro.

Breve esperienza, pochi esperti, molta richiesta

La settimana scorsa ho partecipato a un evento qui a Londra, dove vivo, organizzato da una startup specializzata del training dei modelli di AI. La startup è molto popolare e il Ceo di Stability AI era tra gli ospiti. Quindi oltre mille esperti di machine learning sono arrivati da tutte le parti di Londra e da varie altre città come Cambridge e Oxford.

Prima dell’evento, uno dei reclutatori della startup, avvisa i potenziali partecipanti che sarà presente di persona per assumere, ma ammonisce che considererà solo candidati con almeno cinque anni di esperienza.

Il problema è che le tecnologie per le quali questo reclutatore cerca cinque anni di esperienza come per esempio GPT, sono state rilasciate a ottobre e novembre dell’anno scorso.

È impossibile trovare un candidato con cinque anni di esperienza su una cosa che esiste da meno di due anni.

Qui probabilmente il reclutatore intende un’esperienza di cinque anni con i Large Language Model in generale e non con GPT nello specifico. Ma anche in questo caso il problema è enorme.

La prima versione del modello GPT è stata rilasciata da OpenAI esattamente cinque anni fa.

E quindi il reclutatore sta probabilmente cercando dei candidati che hanno cominciato a lavorare con queste tecnologie dal giorno in cui sono state rilasciate.

Il reclutatore è fortunato perché il mercato inglese è uno dei pochissimi nel mondo che vanta un numero ragionevole di esperti disponibili con quel tipo di esperienza. Un reclutatore in un altro mercato avrebbe enormi difficoltà a fare lo stesso.

E anche quando gli esperti di AI con quel tipo di esperienza sono disponibili sul mercato, il loro profilo è molto ricercato dalle aziende leader dell’industria e dagli istituti di ricerca più prestigiosi.

Proprio la settimana scorsa ho incontrato un ricercatore che sta per finire il suo PhD sui Large Language Model, e mi diceva che ha già dieci proposte di lavoro da famose aziende tecnologiche, da startup già finanziate con capitali di ventura e da alcune delle più famose università qui in UK.

Qual è il punto qui? Se intendete assumere un esperto di AI sarà necessario ridimensionare le vostre aspettative in termini di esperienza ed essere preparati a offrire un salario estremamente generoso.

E anche in quest’ultimo caso, potrebbe essere necessario cercare i vostri esperti in un mercato più ampio di quello nazionale.

Ok, ci fermiamo qui per questa settimana, come sempre, scrivetemi all’indirizzo di posta elettronica che trovate qui sotto con i vostri commenti, le domande e i feedback.

Ciao!