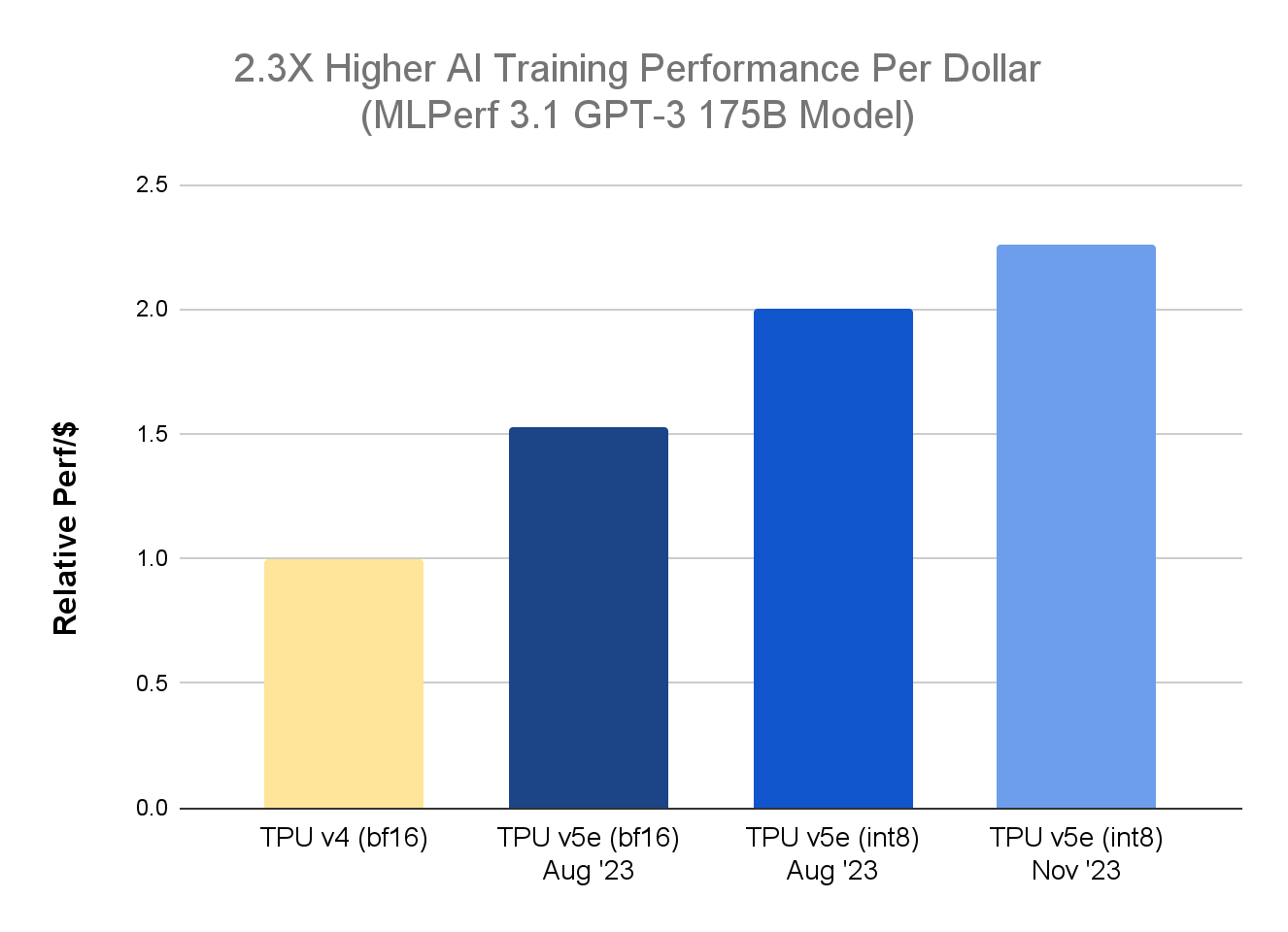

Google Cloud ha annunciato due importanti aggiornamenti per la sua piattaforma Cloud TPU. In primo luogo, negli ultimi risultati di MLPerf Training 3.11, la TPU v5e ha dimostrato un miglioramento di 2,3 volte nel rapporto prezzo-performance rispetto alla precedente generazione di TPU v4 per l’addestramento di modelli linguistici di grandi dimensioni (LLM). Questo risultato – afferma l’azienda – si aggiunge al vantaggio di 2,7 volte in termini di prezzo rispetto alla TPU v4 per l’inferenza di LLM che il team di Google Cloud ha condiviso a settembre per il benchmark MLPerf Inference 3.1.

In secondo luogo, Cloud TPU v5e è ora generalmente disponibile, così come le tecnologie Singlehost inference e Multislice Training di Google Cloud. Questi progressi – dichiara l’azienda – portano ai clienti di Google Cloud efficienza economica, scalabilità e versatilità, con la possibilità di utilizzare una piattaforma TPU unificata per i carichi di lavoro sia di training che di inferenza.

Da quando è stata introdotta in agosto, sottolinea Google Cloud, i clienti hanno adottato TPU v5e per una vasta gamma di carichi di lavoro che spaziano dall’addestramento dei modelli di intelligenza artificiale al loro utilizzo: Anthropic sta utilizzando TPU v5e per scalare in modo efficiente il suo LLM Claude.

Hugging Face e AssemblyAI utilizzano TPU v5e per servire in modo efficiente rispettivamente i carichi di lavoro di generazione di immagini e di riconoscimento vocale. Inoltre, la stessa Google si affida alle TPU v5e per l’addestramento su larga scala e i carichi di lavoro di tecnologie interne all’avanguardia come Google Bard.

Nel benchmark MLPerf Training 3.1 per il modello GPT-3 175B, l’azienda ha avanzato il suo nuovo approccio di addestramento a precisione mista per sfruttare il formato di precisione INT8 oltre al BF16 nativo. Questa nuova tecnica, chiamata Accurate Quantized Training (AQT), utilizza una libreria di quantizzazione che sfrutta i numerici low-bit e high-performance degli acceleratori hardware AI contemporanei ed è disponibile per gli sviluppatori su Github.

Il modello GPT-3 175B ha raggiunto la convergenza (il punto in cui l’addestramento aggiuntivo non migliorerebbe ulteriormente il modello) scalando a 4.096 chip TPU v5e grazie alla tecnologia Multislice Training. Il miglior rapporto qualità-prezzo implica che i clienti possono continuare a migliorare l’accuratezza dei loro modelli spendendo meno, spiega Google.

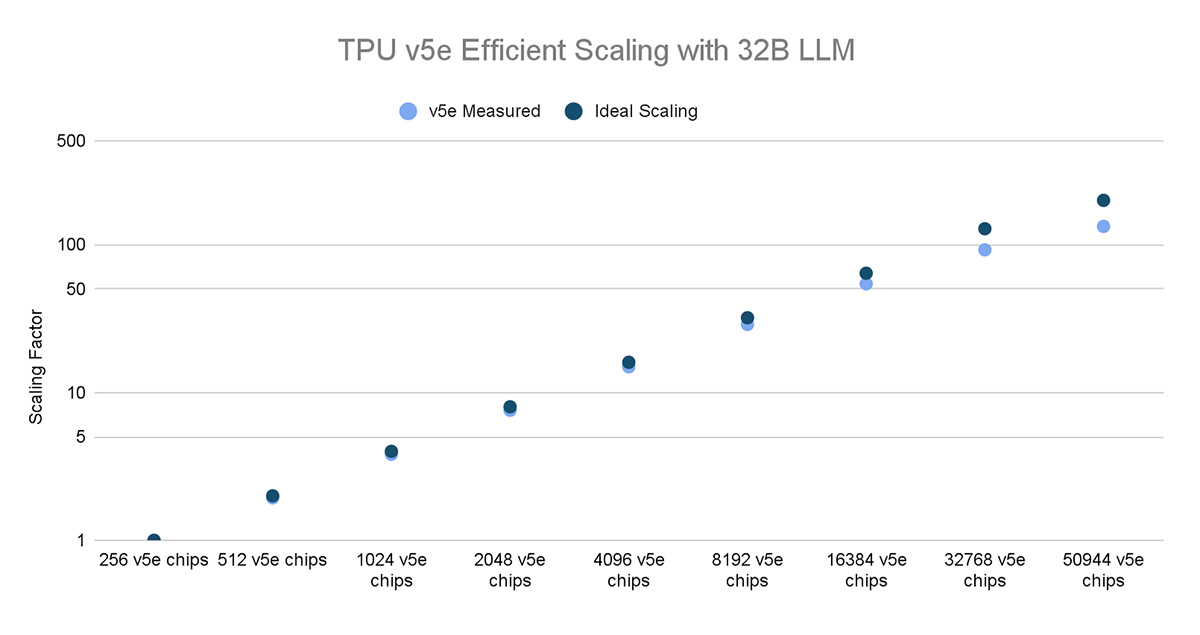

Cloud TPU Multislice Training è una tecnologia full-stack che consente l’addestramento di modelli AI su larga scala attraverso decine di migliaia di chip TPU. Permette di addestrare in modo semplice e affidabile modelli di AI generativa di grandi dimensioni, che possono accelerare il time-to-value e l’efficienza dei costi.

Di recente, Google Cloud ha eseguito uno dei più grandi lavori di addestramento distribuito al mondo per LLM sul maggior numero di chip di acceleratori AI: utilizzando Multislice e il formato di precisione INT8 guidato da AQT, l’azienda ha scalato a oltre 50.000 chip TPU v5e per addestrare un modello LLM denso da 32B parametri, ottenendo il 53% di model flop utilization (MFU) effettivo. A titolo di confronto, l’azienda ha ottenuto il 46% di MFU quando ha addestrato un PaLM-540B su 6.144 chip TPU v4.

Inoltre, i test di Google Cloud hanno evidenziato un’efficiente scalabilità, consentendo a ricercatori e professionisti di addestrare rapidamente modelli complessi e di grandi dimensioni, per contribuire a un’innovazione più rapida in un’ampia gamma di applicazioni di intelligenza artificiale.

Google Cloud sta anche continuando a investire in nuove tecniche software per spingere i confini della scalabilità e delle prestazioni, in modo che i clienti che hanno già implementato carichi di lavoro per l’addestramento dell’AI su TPU v5e possano trarre vantaggio dalle nuove funzionalità disponibili.