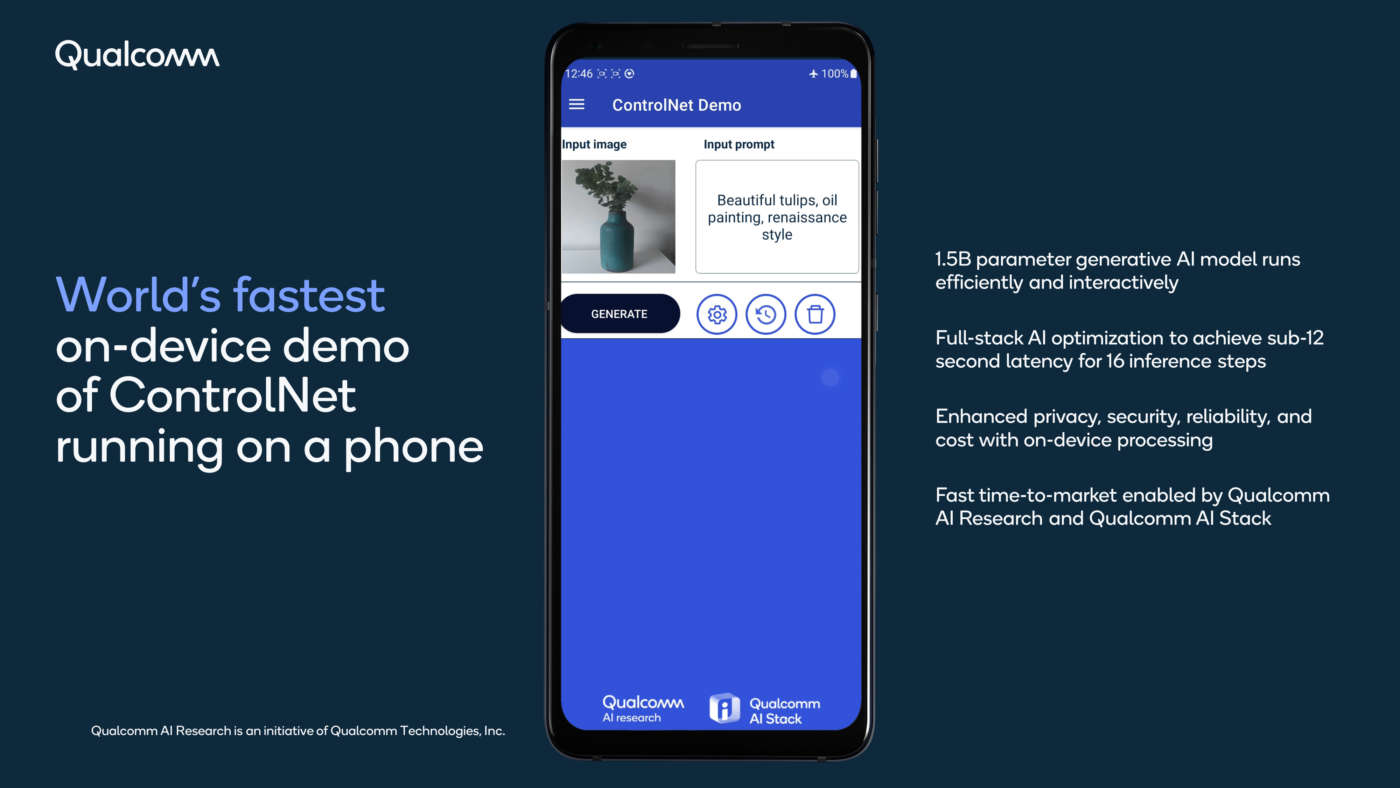

Durante il CVPR (Computer Vision and Pattern Recognition Conference), Qualcomm ha mostrato ControlNet, un modello di visione linguistica (LVM) da immagine a immagine con 1,5 miliardi di parametri, che funziona interamente su uno smartphone Android.

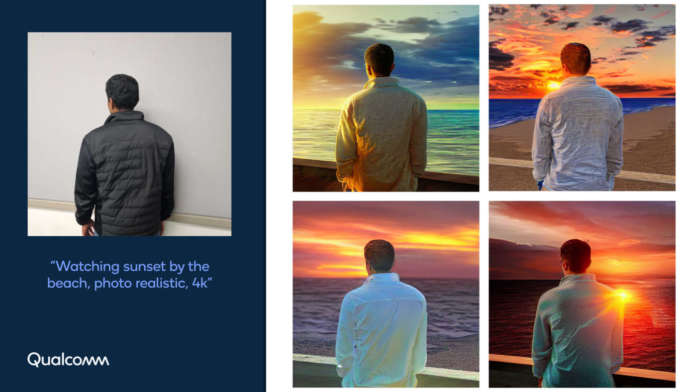

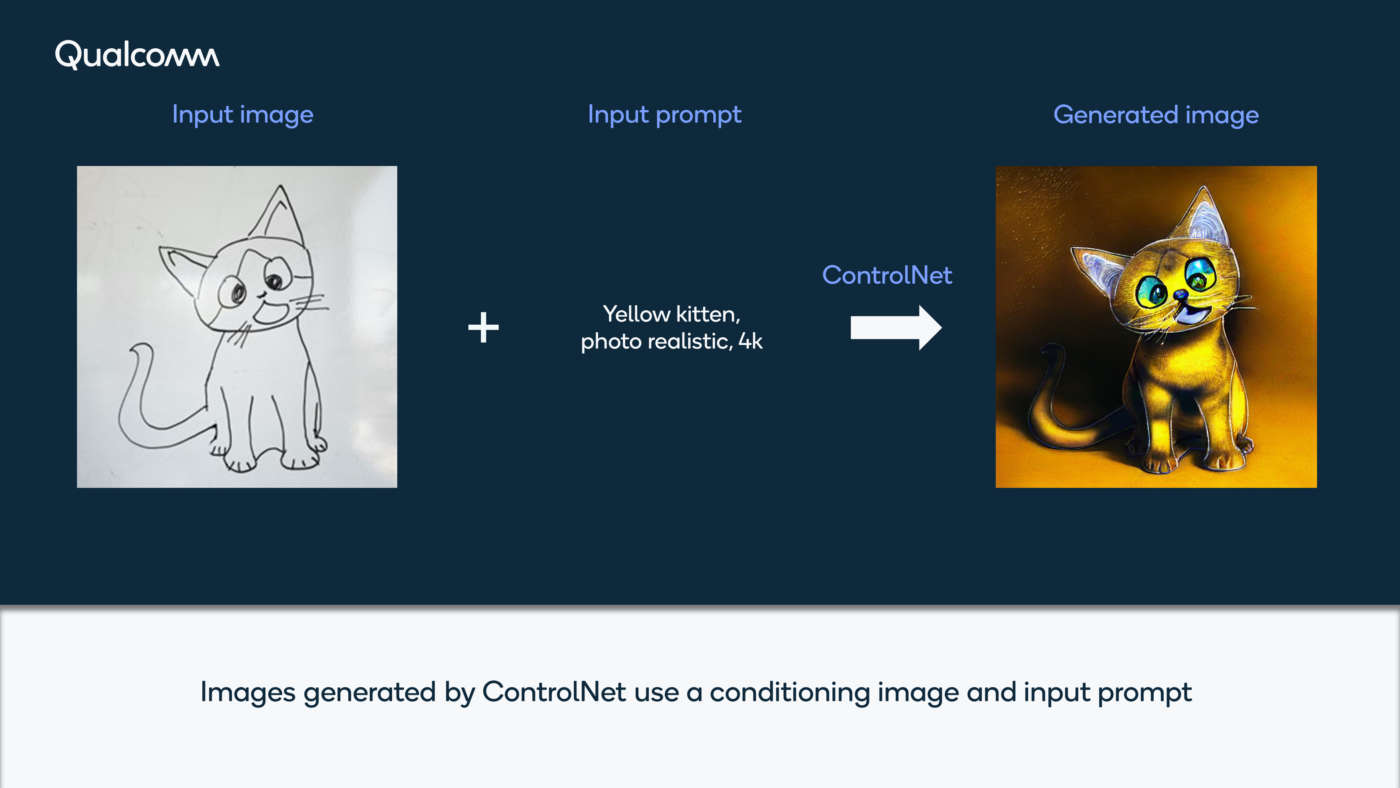

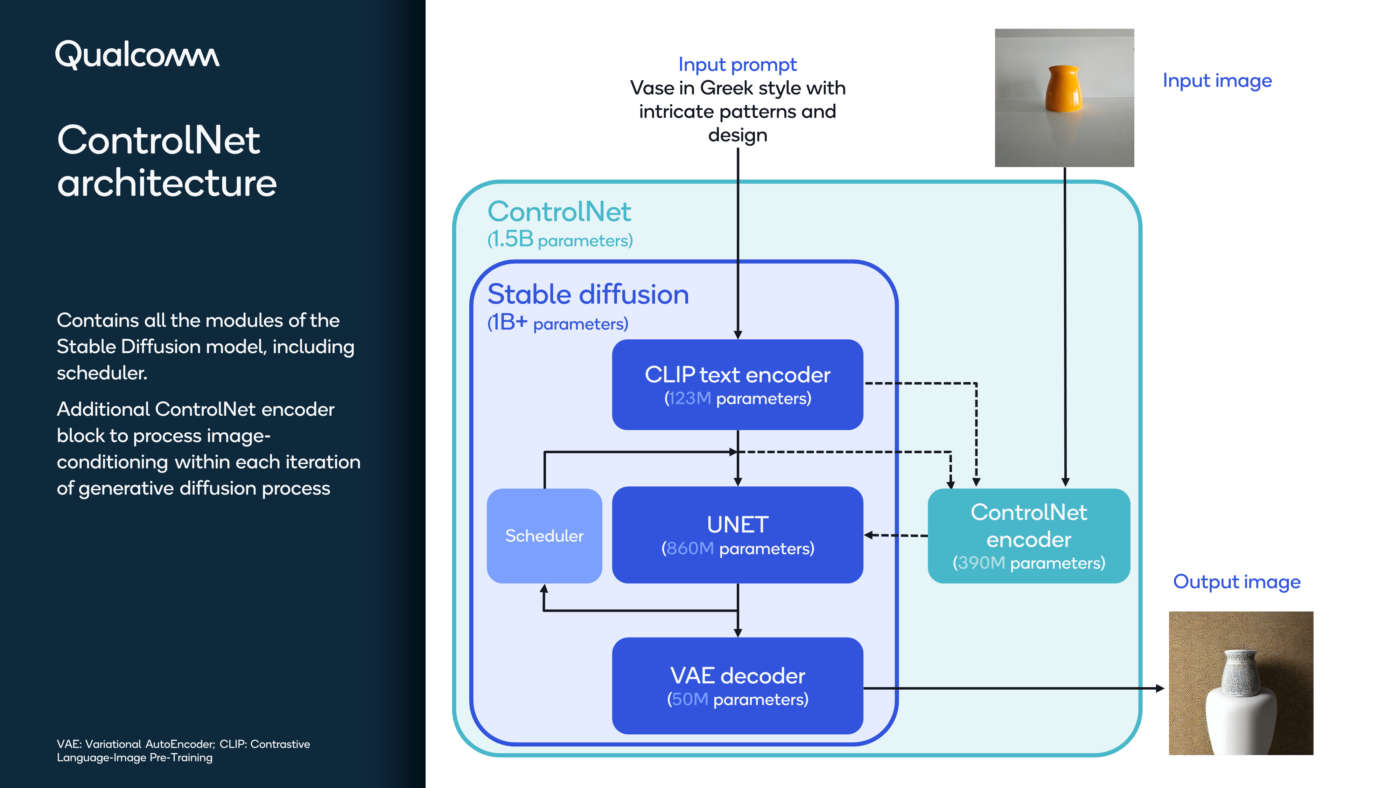

ControlNet – spiega Qualcomm – è una classe di soluzioni di AI generativa nota come modelli di visione linguistica o LVM (language-vision models), che consente un controllo più preciso per la generazione di immagini sulla base di un’immagine di input e una descrizione testuale di input.

In questa dimostrazione, le immagini AI vengono generate sul dispositivo mobile in meno di 12 secondi senza richiedere alcun accesso al cloud, consentendo un’esperienza utente interattiva efficiente, piacevole, affidabile e privata.

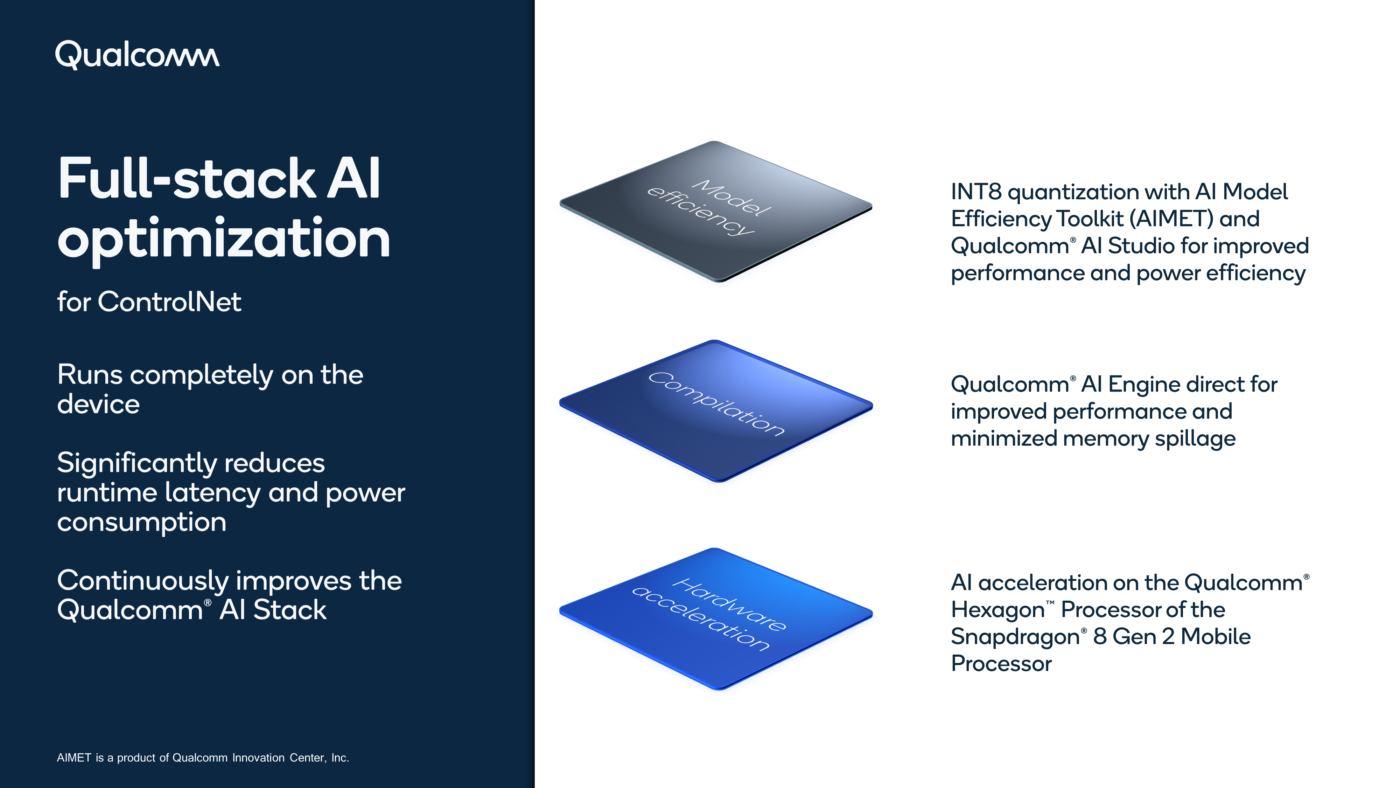

Una tale performance è stata ottenuta grazie a una suite di ottimizzazioni AI full-stack nell’architettura del modello, nel software AI e negli acceleratori hardware neurali. Gli strumenti avanzati di intelligenza artificiale e l’hardware dell’azienda utilizzati per questo processo includono l’AI Model Efficiency Toolkit (AIMET), il Qualcomm AI Stack e il Qualcomm AI Engine.

Oltre alla demo di ControlNet, Qualcomm ha presentato una serie di nuove dimostrazioni tecnologiche che evidenziano la ricerca dell’azienda in materia di IA generativa, computer vision, XR e veicoli autonomi.

Tra queste, Qualcomm AI Research ha utilizzato l’intelligenza artificiale generativa per sviluppare un fitness coach digitale che migliora le soluzioni esistenti in termini di precisione e realismo. L’allenatore di fitness fornisce un’interazione in tempo reale incoraggiando, correggendo e aiutando l’utente a raggiungere i propri obiettivi di fitness. La demo mostra come un modello linguistico di grandi dimensioni (LLM) con base visiva possa consentire interazioni naturali, contestuali, multimodali e in tempo reale.

Un flusso video dell’utente che si allena viene elaborato dal modello di riconoscimento delle azioni. In base all’azione riconosciuta, l’orchestratore stateful imposta la richiesta e la trasmette all’LLM. L’allenatore di fitness fornisce la risposta dell’LLM all’utente attraverso un avatar text-to-speech. Tutto ciò è possibile grazie a tre innovazioni chiave: un modello di visione addestrato per rilevare le attività di fitness a grana fine, un modello linguistico addestrato per generare un linguaggio basato sui concetti visivi e un orchestratore che coordina l’interazione fluida tra queste due modalità per facilitare il feedback del coach con un dialogo dal vivo. Il risultato è un fitness coach che fornisce un’interazione in tempo reale per un’esperienza utente coinvolgente e dinamica.

Qualcomm ha poi dimostrato la prima codifica video neurale a 1080p su un telefono. I codec neurali – spiega l’azienda – sono versatili: possono essere personalizzati per esigenze video specifiche, possono essere ottimizzati per la qualità percettiva grazie ai progressi dell’intelligenza artificiale generativa, possono essere estesi a nuove modalità e possono essere eseguiti su hardware AI di uso generale. Tuttavia, presentano numerose sfide che ne rendono difficile l’implementazione su dispositivi con limitazioni di calcolo.

Qualcomm ha progettato un’architettura di compressione video interframe neurale innovativa ed efficiente che rende possibile la codifica video a 1080p su un dispositivo. Nella demo, si può vedere che le ricche strutture visive e i movimenti complessi dei video di alta qualità sono accuratamente preservati dal codec video neurale.

Qualcomm ha inoltre sviluppato con successo un sistema all’avanguardia di ricostruzione 3D in tempo reale che eccelle per precisione ed efficienza, consentendo la creazione di modelli 3D altamente dettagliati di qualsiasi ambiente. La soluzione dell’azienda viene eseguita su un dispositivo mobile, genera mappe di profondità da singole immagini e le combina in una rappresentazione della scena 3D. Con una mappa 3D accurata e in tempo reale, gli sviluppatori possono sbloccare una vasta gamma di applicazioni di realtà aumentata e virtuale.

Per illustrare le capacità della nostra innovazione, Qualcomm ha progettato una dimostrazione accattivante in cui gli utenti possono tirare palline virtuali contro gli oggetti reali della scena, come pareti e mobili, assistendo a rimbalzi realistici basati su calcoli fisici accurati. Questa tecnologia di percezione favorisce esperienze coinvolgenti e promette di accelerare l’adozione diffusa del metaverso.

L’acquisizione di foto e video continua a migliorare ogni anno grazie a nuove funzionalità rese possibili dai progressi della computer vision basata su AI. La demo di computer vision per smart camera di Qualcomm mostra la segmentazione semantica, la stima monoculare della profondità e la segmentazione delle istanze che consentono di ottenere effetti Bokeh, sostituzione dello sfondo, modalità cinematografica e miglioramento della qualità dell’immagine in base alla classe di appartenenza in termini di nitidezza, morbidezza, chiarezza e contrasto. Queste reti neurali eseguono il miglioramento video in tempo reale su dispositivi dotati di piattaforme Snapdragon.

Un’ulteriore dimostrazione riguarda la tecnologia di monitoraggio del conducente per una maggiore sicurezza. La demo del driver monitoring system (DMS) utilizza la computer vision per dedurre le condizioni di guida pericolose e migliorare la sicurezza. Utilizzando telecamere attive a infrarossi all’interno dell’abitacolo, il DMS monitora in tempo reale lo stato del conducente, compresa la distrazione e la sonnolenza, in base all’apertura degli occhi, allo sguardo, alla posizione della testa, all’espressione del viso, alle attività del corpo e molto altro ancora. Il sistema avverte il conducente quando viene rilevata una guida pericolosa e può contribuire a salvare vite umane. Il DMS funziona in parallelo con i sistemi avanzati di assistenza alla guida (ADAS) sul SoC Snapdragon Ride Flex.

Gli avatar, infine, sono un ingrediente essenziale per consentire esperienze XR immersive nel metaverso, siano essi fotorealistici o in stile cartoon. Con una o più foto 2D, Qualcomm utilizza l’intelligenza artificiale del dispositivo per generare una mesh personalizzata e la texture corrispondente. Per il rendering in tempo reale dell’avatar, vengono utilizzate le videocamere degli headset che vedono i movimenti degli occhi e della bocca dell’utente. La dimostrazione che ne risulta è un avatar ricostruito e animato in modo vicino ai dati veri e re-illuminato in base all’ambiente. L’obiettivo di Qualcomm è quello di rendere disponibile un essere umano digitale sulla piattaforma Snapdragon XR, utilizzata nel metaverso e nelle interfacce uomo-macchina.

Con queste demo Qualcomm ha dimostrato che l’AI generativa non verrà eseguita esclusivamente nel cloud. I carichi di lavoro saranno suddivisi tra il cloud e i dispositivi connessi all’edge.

In questo campo, l’esperienza di Qualcomm nell’AI on-device posiziona l’azienda in modo unico per il passaggio a un’architettura di intelligenza artificiale ibrida.