In occasione del SIGGRAPH, oltre alla piattaforma GH200 Grace Hopper di nuova generazione, lo specialista dell’accelerated computing ha annunciato NVIDIA AI Workbench.

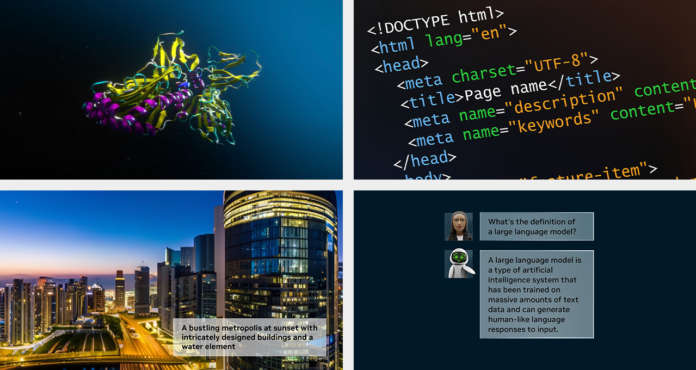

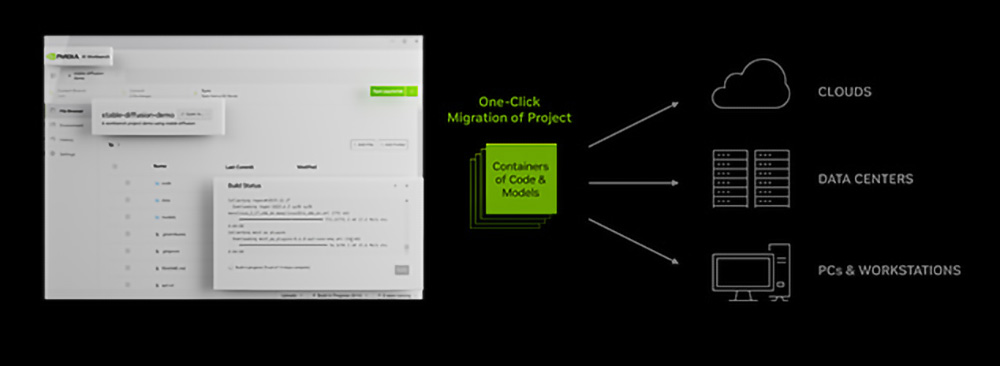

Si tratta di un toolkit unificato e di facile utilizzo che consente agli sviluppatori di creare, testare e personalizzare rapidamente modelli di intelligenza artificiale generativa pre-addestrati su un pc o una workstation, per poi scalarli praticamente su qualsiasi data center, cloud pubblico o NVIDIA DGX Cloud.

AI Workbench – spiega NVIDIA – elimina la complessità di iniziare un progetto di AI aziendale. Accessibile tramite un’interfaccia semplificata in esecuzione su un sistema locale, consente agli sviluppatori di personalizzare i modelli da repository popolari come Hugging Face, GitHub e NVIDIA NGC utilizzando dati custom. I modelli possono poi essere condivisi facilmente su più piattaforme.

“Le imprese di tutto il mondo stanno facendo a gara per trovare l’infrastruttura giusta per creare modelli e applicazioni di AI generativa“, ha dichiarato Manuvir Das, vicepresidente dell’enterprise computing di NVIDIA. “NVIDIA AI Workbench offre un percorso semplificato ai team trasversali per la creazione di applicazioni basate sull’AI che stanno diventando sempre più essenziali nelle aziende moderne“.

Una nuova era per gli sviluppatori di intelligenza artificiale

Sebbene siano ora disponibili centinaia di migliaia di modelli pre-addestrati, sottolinea NVIDIA, la loro personalizzazione con i numerosi strumenti open source può richiedere la ricerca di molteplici repository online per trovare il framework, gli strumenti e i container giusti e l’impiego delle giuste competenze per personalizzare un modello per un caso d’uso specifico.

Con NVIDIA AI Workbench, gli sviluppatori possono personalizzare ed eseguire l’intelligenza artificiale generativa in pochi clic. Permette di riunire tutti i modelli, i framework, i kit di sviluppo software e le librerie di livello enterprise necessari, provenienti da repository open source e dalla piattaforma NVIDIA AI, in un toolkit unificato per gli sviluppatori.

I principali fornitori di infrastrutture per l’intelligenza artificiale – fra cui Dell Technologies, Hewlett Packard Enterprise, HP Inc., Lambda, Lenovo e Supermicro – stanno adottando AI Workbench per la sua capacità di potenziare la loro ultima generazione di workstation desktop con capacità multi-GPU, workstation mobili di fascia alta e workstation virtuali, afferma NVIDIA.

Gli sviluppatori che dispongono di un pc o di una workstation NVIDIA RTX basata su Windows o Linux potranno inoltre avviare, testare e mettere a punto progetti di intelligenza artificiale generativa di livello enterprise sui propri sistemi RTX locali e accedere facilmente a risorse di data center e di cloud computing per scalare in base alle esigenze.

AI Workbench è in arrivo in accesso anticipato: è possibile registrarsi per ricevere una notifica quando sarà disponibile.

Il nuovo software NVIDIA AI Enterprise 4.0 favorisce il deployment

Per accelerare ulteriormente l’adozione dell’intelligenza artificiale generativa, NVIDIA ha inoltre annunciato l’ultima versione della sua piattaforma software aziendale, NVIDIA AI Enterprise 4.0. Questa piattaforma fornisce alle aziende gli strumenti necessari per adottare l’AI generativa, offrendo al contempo la sicurezza e la stabilità delle API necessarie per implementazioni di produzione affidabili.

I nuovi software e strumenti supportati da NVIDIA AI Enterprise che aiutano a semplificare l’implementazione dell’intelligenza artificiale generativa includono:

- NVIDIA NeMo, un framework nativo del cloud per costruire, personalizzare e distribuire modelli linguistici di grandi dimensioni. Con NeMo, NVIDIA AI Enterprise offre un supporto end-to-end per la creazione e la personalizzazione di applicazioni LLM.

- NVIDIA Triton Management Service, che aiuta ad automatizzare e ottimizzare le implementazioni di produzione. Consente alle aziende di distribuire automaticamente più istanze di NVIDIA Triton Inference Server in Kubernetes con orchestrazione del modello per un funzionamento efficiente dell’intelligenza artificiale scalabile.

- Il software di gestione dei cluster NVIDIA Base Command Manager Essentials, che aiuta le aziende a massimizzare le prestazioni e l’utilizzo dei server di intelligenza artificiale in ambienti data center, multi-cloud e hybrid-cloud.

Il software NVIDIA AI Enterprise – che consente agli utenti di costruire ed eseguire soluzioni NVIDIA AI-enabled in cloud, data center e edge – è certificato per l’esecuzione sui principali sistemi certificati NVIDIA, sui sistemi NVIDIA DGX, su tutte le principali piattaforme cloud e sulle workstation NVIDIA RTX annunciate di recente.

Le società di software ServiceNow e Snowflake, nonché il fornitore di infrastrutture Dell Technologies, che offre le soluzioni Dell Generative AI, hanno recentemente annunciato la loro collaborazione con NVIDIA per abilitare nuove soluzioni e servizi di intelligenza articiciale generativa sulle loro piattaforme. L’integrazione di NVIDIA AI Enterprise 4.0 e NVIDIA NeMo fornisce ai clienti una base per l’AI generativa pronta per la produzione, evidenzia l’azienda.

NVIDIA AI Enterprise 4.0 sarà integrata nei marketplace dei partner, fra cui AWS Marketplace, Google Cloud e Microsoft Azure, nonché tramite il partner cloud NVIDIA Oracle Cloud Infrastructure.

Inoltre, i fornitori di MLOps, fra cui Azure Machine Learning, ClearML, Domino Data Lab, Run:AI e Weights & Biases, stanno aggiungendo una perfetta integrazione con la piattaforma NVIDIA AI per semplificare lo sviluppo di modelli di AI generativa di livello da produzione.