Nel dicembre 2021, Amazon Web Services (Aws) ha introdotto Amazon SageMaker Serverless Inference in preview, come nuova opzione in Amazon SageMaker per fare il deployment di modelli di machine learning (ML) per l’inferenza senza dover configurare o gestire l’infrastruttura sottostante.

L’opzione Amazon SageMaker Serverless Inference è ora generalmente disponibile (GA).

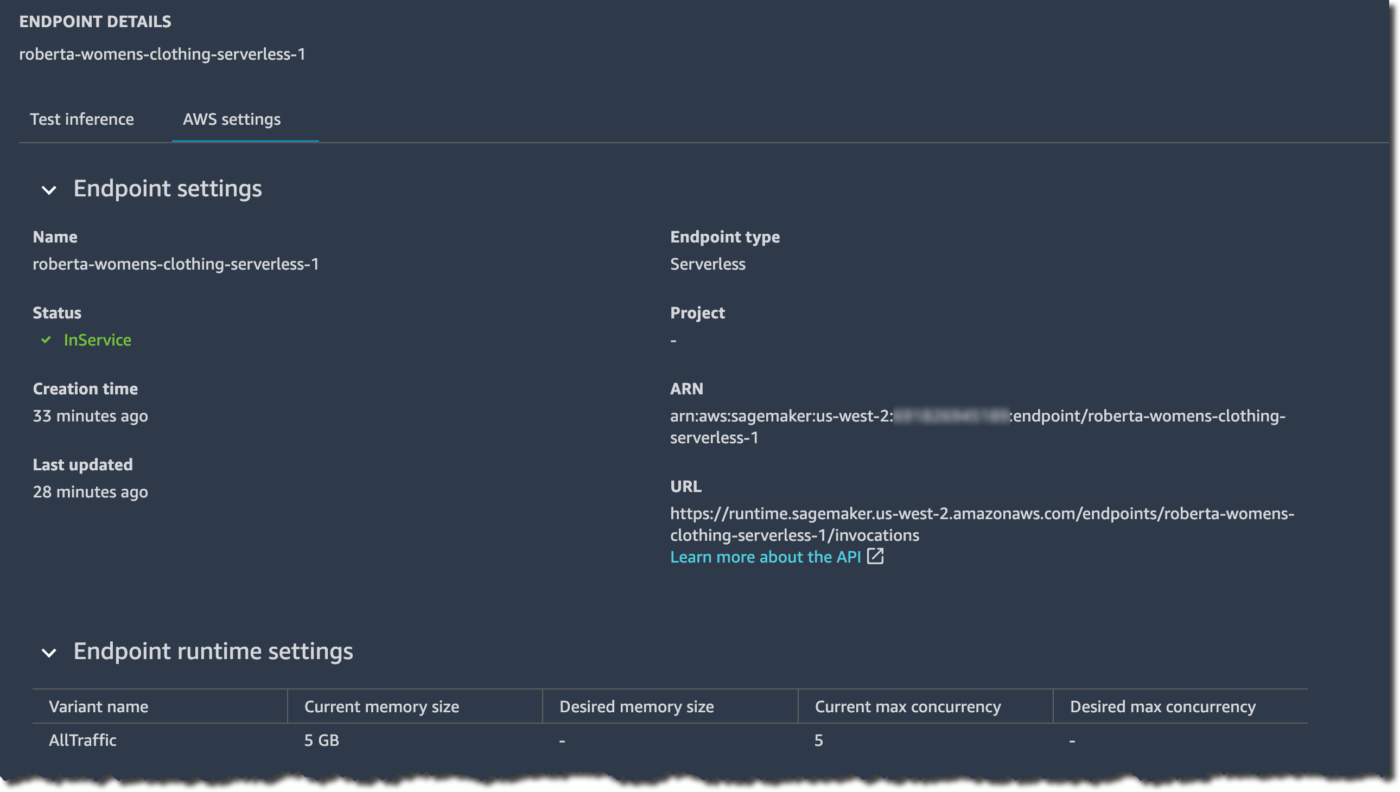

È possibile creare, aggiornare, descrivere ed eliminare un serverless inference endpoint usando la console SageMaker, gli SDK Aws, l’SDK SageMaker Python, la CLI Aws o Aws CloudFormation.

Svariati casi d’uso di inferenza del machine learning – sottolinea Amazon Web Services – pongono requisiti diversi sulla infrastruttura di hosting del modello.

Se il cliente Aws lavora su casi d’uso come l’ad serving, il rilevamento delle frodi o le raccomandazioni personalizzate di prodotti, molto probabilmente cerca un’inferenza online basata su API con tempi di risposta di pochi millisecondi.

Se lavora con grandi modelli di machine learning, come nelle applicazioni di computer vision (CV), potrebbe richiedere un’infrastruttura ottimizzata per eseguire l’inferenza su payload di grandi dimensioni in pochi minuti.

Invece, se vuole eseguire previsioni su un intero set di dati, o su batch di dati più grandi, potrebbe voler eseguire un lavoro di inferenza on-demand, una tantum, invece di ospitare un endpoint che serva i modelli.

Ed è ancora diverso se si ha un’applicazione con modelli di traffico intermittenti, come un servizio di chatbot o un’applicazione per elaborare moduli o analizzare dati da documenti.

In questo caso, si potrebbe desiderare un’opzione di inferenza online che sia in grado di fornire e scalare automaticamente la capacità di calcolo in base al volume delle richieste di inferenza.

E che, durante il tempo di inattività, dovrebbe essere in grado di spegnere completamente la capacità di calcolo in modo da non fare pagare.

Il machine learning dal deployment facile

Amazon SageMaker, il servizio di machine learning completamente gestito di Aws, offre diverse opzioni di inferenza del modello per supportare tutti questi casi d’uso.

SageMaker Real-Time Inference per carichi di lavoro con requisiti di bassa latenza nell’ordine dei millisecondi.

SageMaker Asynchronous Inference per inferenze con payload di grandi dimensioni o che richiedono lunghi tempi di elaborazione.

Poi: SageMaker batch transform per eseguire previsioni su lotti di dati

E SageMaker Serverless Inference per carichi di lavoro con modelli di traffico intermittenti o poco frequenti.

Molti professionisti del machine learning hanno però bisogno di un’inferenza ML completamente gestita che permetta di concentrarsi sullo sviluppo del codice senza gestire tutta l’infrastruttura, sottolinea Aws.

SageMaker Serverless Inference ora offre questa facilità di implementazione.

In base al volume di richieste di inferenza che il proprio modello riceve, SageMaker Serverless Inference fornisce, scala e spegne automaticamente la capacità di calcolo.

Come risultato, il cliente paga solo il tempo di calcolo per eseguire il proprio codice di inferenza e la quantità di dati processati, non per il tempo inattivo.

Usando l’inferenza serverless, si possono sfruttare anche le caratteristiche di SageMaker, tra cui le metriche integrate come il conteggio delle invocazioni, i guasti, la latenza, le metriche dell’host e gli errori in Amazon CloudWatch.

Dal suo lancio in preview, SageMaker Serverless Inference ha aggiunto il supporto per SageMaker Python SDK e il model registry.

SageMaker Python SDK è una libreria open source per costruire e distribuire modelli di machine learning su SageMaker. Il model registry di SageMaker permette di catalogare, versionare e distribuire i modelli in produzione.

Come novità per il lancio GA, SageMaker Serverless Inference ha inoltre aumentato il limite massimo di invocazioni concorrenti per endpoint a 200 (da 50 della preview), permettendo di usare Amazon SageMaker Serverless Inference per carichi di lavoro ad alto traffico.