Secondo episodio di voci dell’AI: oggi volevo parlarvi di come l’intelligenza artificiale sta cambiando il settore dell’educazione. Ma la sera prima di registrare questo episodio openAI ha rilasciato le API per l’accesso programmatico a ChatGPT e a un altro modello di intelligenza artificiale chiamato Whisper. E quindi oggi parliamo di questo.

Non entro nel merito dell’annuncio di OpenAI, che probabilmente avrete già letto su 01net, ma voglio sottolineare una cosa di grande importanza: in concomitanza con questo annuncio openAI ha ridotto il costo per il consumo di ChatGPT del 90%. L’utilizzo del modello di intelligenza artificiale che sta alla base di ChatGPT, che è stato ribattezzato GPT 3.5 Turbo, adesso costa 0,002 $ per 1.000 token.

Ricordiamo cos’è un token: quando abbiamo un’interazione con un sistema di intelligenza artificiale generativa come ChatGPT o Stable Diffusion, la richiesta che facciamo all’AI, quello che è Il nostro prompt, viene spezzettato in tante piccole unità chiamate token.

Nella maggior parte dei casi, queste unità, questi token, corrispondono alla singola parola. Ma non sempre. A volte un token corrisponde a una porzione di una parola. Quindi a grandi linee possiamo dire che openAI ha abbassato il costo di mille parole a meno della metà della metà di un centesimo.

Sì, ma in pratica? Facciamo un esempio.

Prima dell’annuncio un documento – cinque paragrafi – generato da GPT con un paio di revisioni generate dopo un’interazione con l’utente costava dieci centesimi. Adesso costa un centesimo.

Perché questa cosa è così tanto importante? Il primo motivo è che questa drastica riduzione di costo dipende da un’ottimizzazione del modello di intelligenza artificiale che openAI è riuscita ad ottenere in soli tre mesi.

Chat GPT è stato rilasciato il trenta novembre dell’anno scorso e questo ci porta a una considerazione di grande importanza sottolineata da Emad Mostaque, il fondatore di Stability.ai, la società che ha sviluppato il sistema di intelligenza artificiale generativa chiamato Stable Diffusion, quello che ho usato la scorsa settimana per modificare alcuni frame del video che forse avete visto.

E a proposito di quei frame modificati con Stable Diffusion, c’è una ragione del perché li ho inseriti nel video.

In uno dei prossimi episodi di Voci delle AI parleremo di come intelligenza artificiale generativa sta cambiando il mondo del design: design di interni, design industriale, design di applicazioni web.

Ritorniamo al fondatore di Stable Diffusion. Qualche giorno fa su Twitter Emad scrive che durante una cena con un investitore, l’investitore ha fatto una considerazione importante: Le tecnologie di intelligenza artificiale non sono ancora entrate in una fase di ottimizzazione.

Was at a dinner last week where a very smart chap (and investor!) noted that generative AI has not entered the engineering/optimisation phase yet.

Libraries and models are still bloated and unoptimised and yet..

— Emad (@EMostaque) February 22, 2023

Il che significa che i modelli AI che esistono oggi consumano molte più risorse, sono molto più lenti di quelli che potrebbero essere una volta ingegnerizzati per il consumo su scala e ottimizzati per la massima performance, questi modelli saranno significativamente meno costosi e potranno essere utilizzati in contesti particolari come edge computing o implementazioni private invece che via un servizio centralizzato come quello di OpenAI.

La riduzione dei costi che openAI ha appena annunciato è l’esempio perfetto di quello che vedremo in un prossimo futuro.

Il secondo motivo per cui questo annuncio è così importante è questo: prima del rilascio di queste nuove, un numero impressionante di prodotti e servizi si integrava già con chatGPT attraverso tutta una serie di acrobazie più o meno stabili.

Faccio vedere due esempi in un secondo.

Queste nuove API porteranno a un’esplosione di applicazioni integrate con GPT molto superiore a quello che esiste già oggi. E questa esplosione di applicazione ci permetterà di fare cose estremamente interessanti e produttive in tutti i settori dell’industria.

Produrre contenuti con AI

Il primo esempio che vi faccio vedere è a proposito della produzione di contenuto per un ipotetico sito web aziendale.

Per farvi vedere cosa si può fare in questo scenario utilizzo WordPress. Per chi non lo sapesse, WordPress è un content management system completamente open-source che esiste da quasi vent’anni e oggi è alla base del 43% percento dei siti web mondiali.

A WordPress aggiungiamo un plugin chiamato Uncanny Automator. I plugin di WordPress sono estensioni che varie aziende e individui offrono gratuitamente o a pagamento per arricchire le funzionalità di WordPress.

Uncanny Automator è uno dei plugin più potenti che esiste oggi perché ci permette di automatizzare tutta una serie di operazioni in una maniera estremamente intuitiva.

Se avete mai utilizzato altra piattaforma di automazione come IFTT (IfThisThenThat) o la mia preferita, Zapier, anche Uncanny Automator è simile.

Qualche giorno fa gli sviluppatori di Uncanny Automator hanno rilasciato un aggiornamento che introduce l’integrazione con i modelli di intelligenza artificiale di OpenAI sono stati così gentili da darmi accesso alla versione premium del loro plugin per fare questa dimostrazione. Okay.

Per farvi vedere come funziona questa cosa, utilizziamo il WordPress che ho configurato per Synthetic Work, una newsletter sull’intelligenza artificiale che scrivo in inglese ogni settimana.

Andiamo qui e vediamo la dashboard di WordPress che è questa.

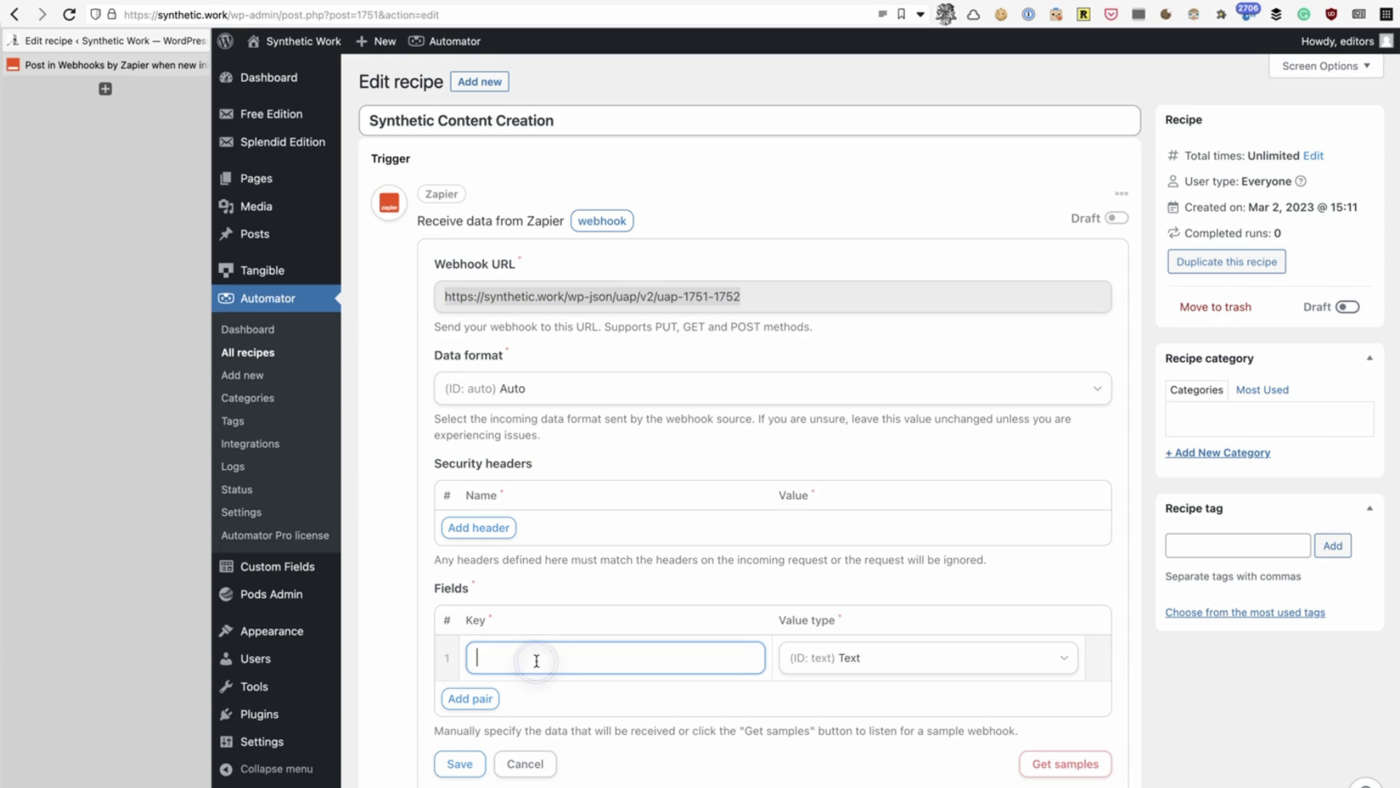

Andiamo nella sezione dedicata al plugin di cui ho parlato anche in Uncanny Automator, che è questa, e andiamo a creare una nuova ricetta che è un modo, il loro modo, di definire un workflow di automazione.

Chiamiamo questa ricetta Synthetic Content Creation e chiediamo al sistema di integrarsi con Zapier dove ho già configurato un altro workflow di automazione che prende delle e-mail che arrivano a un certo indirizzo, fornito da Zapier, estrae il contenuto delle e-mail e lo manda qui a Synthetic Work.

Quindi quello che dobbiamo fare è attivare questa integrazione e poi dire al sistema cosa deve fare.

Una volta che riceve il contenuto delle mail, chiediamo al sistema di mandare quel contenuto a OpenAI. A OpenAI chiediamo di scrivere un trattato di cinque paragrafi sul contenuto che abbiamo ricevuto, che era all’interno di quelle e-mail, ed estraiamo quell’informazione da Zapier.

Eccoci. A questo punto una volta che OpenAI ha risposto al nostro prompt con la sua risposta chiediamo a Uncanny Automator di pubblicare un nuovo post con quella risposta. Chiamiamo il titolo ”trattato sul soggetto che abbiamo ricevuto per e-mail” e all’interno del contenuto del blog post mettiamo la risposta che abbiamo ricevuto da OpenAI, che è questa.

A questo punto dobbiamo solo mandare l’email all’indirizzo che abbiamo creato precedentemente chiedendo un nuovo blog post sugli elefanti. Inviamo le mail. Se tutto ha funzionato correttamente, a questo punto L’e-mail è stata processata da Zapier.

Il contenuto che elefanti è stato estratto e inviato a Uncanny Automator plugin all’interno di Synthetic Work. La richiesta è stata inoltrata a OpenAI e abbiamo ricevuto una risposta. La risposta è finita all’interno del sistema come un nuovo blog post.

Per simulare tutto questo, andiamo all’interno di Zapier, facciamo un test dell’azione – perché questa attività non è live al momento – e vediamo che il passaggio del testo “elefanti” è avvenuto con successo.

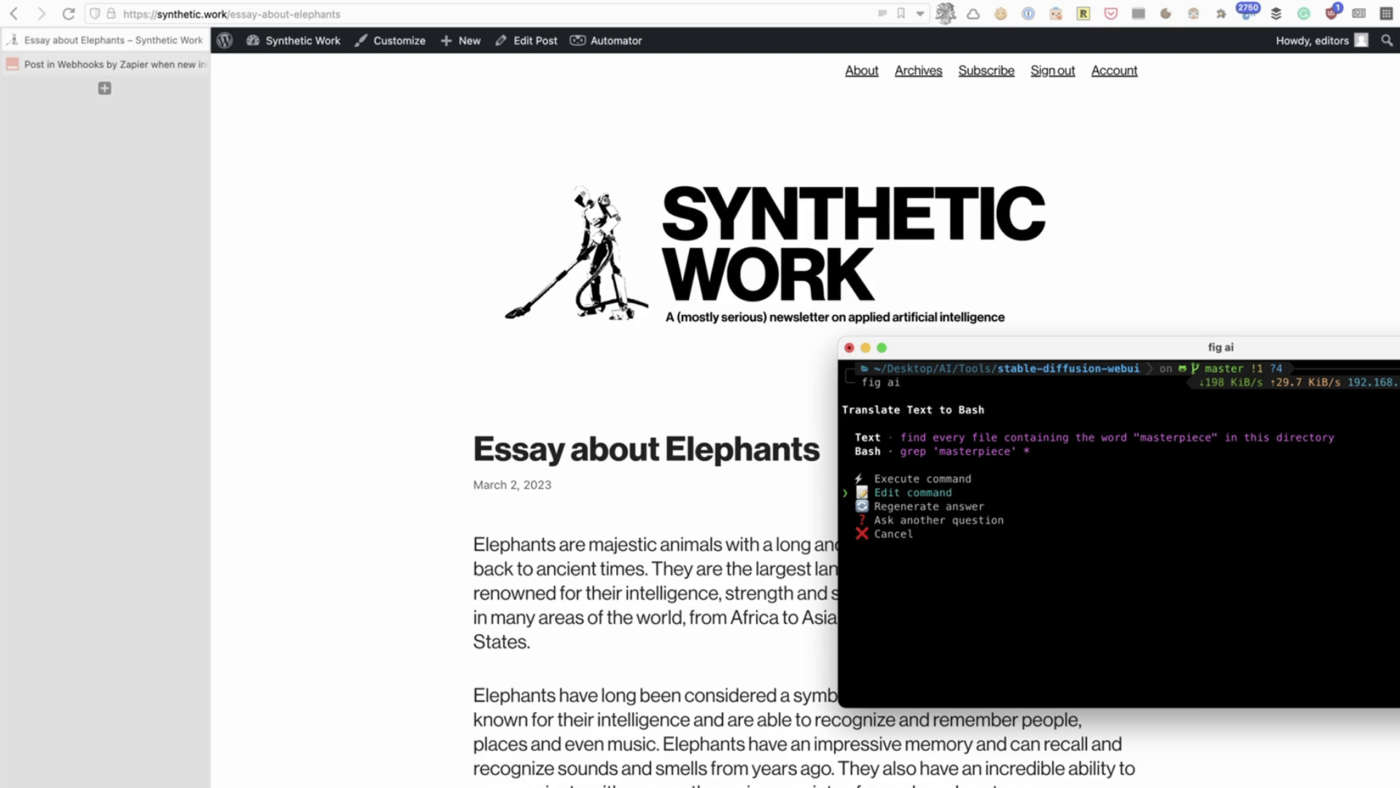

A questo punto andiamo a vedere se all’interno dei post di Synthetic work c’è un nuovo post sugli elefanti. Eccolo qua, l’essay sugli elefanti. Andiamo a vedere il contenuto di questo post. Scopriamo che OpenAI ha creato un bellissimo articolo sugli elefanti. Ecco fatto.

Rivoluzione command line

Okay, adesso vi faccio vedere un altro prodotto che si integra con OpenAI che io personalmente considero rivoluzionario.

Si chiama Fig.

I fondatori di Fig hanno trasformato uno dei sistemi più vecchi e statici del mondo dell’informatica, il command prompt, in una piattaforma.

E come tutte le piattaforme che si rispettino, una volta installato Fig, il command prompt si può arricchire con funzionalità critiche per molti ruoli dell’IT.

La cosa più banale ma più utile che Fig offre è la capacità di autocompletare i comandi inseriti dall’utente per una serie sterminata di applicazioni da Git a Docker a Terraform, altri cinquecento diversi sistemi.

Tutto questo è bellissimo e aiuta gli sviluppatori, i DevOps, gli esperti di sicurezza informatica, a lavorare molto più velocemente.

Ma che succede per chi comincia da zero? Lo sapete benissimo.

Qualunque ruolo IT che richieda l’interazione con la linea di comando ha una certa curva di apprendimento, e una delle difficoltà più grandi è memorizzare tutta una serie di comandi e sintassi per i vari sistemi con cui si interagisce da quella linea di comando; e quindi Fig ha integrato l’accesso ai Large Language Model di OpenAI.

E adesso si può richiedere al sistema di scrivere comandi complessi partendo da una richiesta in linguaggio naturale.

Anche i fondatori di Fig sono stati gentili e mi hanno dato accesso al pacchetto che attiva questa funzione. Vediamo che succede. Bellissimo.

Come potete immaginare, questa cosa riduce drasticamente i tempi di apprendimento per le nuove risorse aziendali e incrementa la produttività di quelle risorse che sanno già fare, ma non ricordano esattamente la sintassi di questo o quel sistema in un dato momento.

Ok: qui siamo all’interno di un’applicazione terminal che io uso spesso per macOS, Che è iTerm.

Fig si integra con iTerm, Visual Studio Code e con il terminal di default di macOS, e quindi possiamo contattare OpenAI direttamente da iTerm.

Ma come facciamo? Prima di tutto vediamo che se vogliamo fare una lista dei file delle directory all’interno di questa directory dove mi trovo e cominciamo a scrivere il comando; vedete che Fig fa l’auto-complete e spiega qual è il risultato che otterremo a seconda delle varie opzioni che sono disponibili. Ok, questo non ci interessa. Proprio ci interessa l’integrazione con openAI.

Quindi, a questo punto puliamo la finestra, entriamo nella modalità di interazione con openAI con il comando che è “fig ai”.

A questo punto chiediamo al sistema di tradurre la nostra richiesta in linguaggio naturale in una sintassi corretta che può essere usata nel terminal.

Quello che vogliamo ottenere qui è la lista di tutti quanti i file che sono in questa directory che contengono la parola masterpiece e quindi scriviamo esattamente questo. Eccoci.

Come vedete Fig ha chiesto a openAI di tradurre questa richiesta in un comando per il terminal che io posso eseguire, modificare, fare una domanda completamente diversa o cancellare.

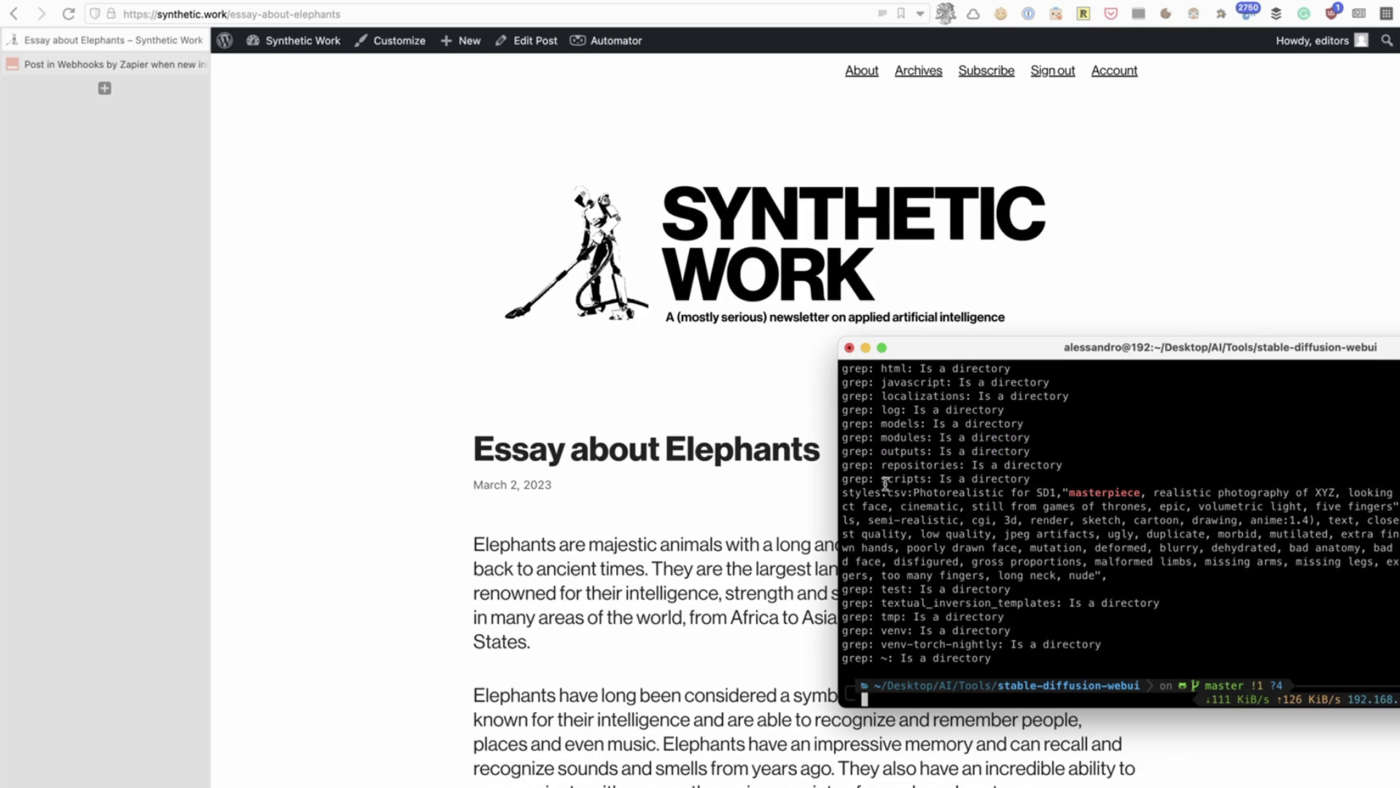

Eseguiamo il comando e questo comando trova il file che ci interessa, che è questo qui.

Questi due esempi che vi ho fatto vedere non usano ancora le Api ChatGPT 3.5 Turbo, ma lo faranno presto.

Quello che è più importante è che adesso che queste API sono disponibili a un costo significativamente più basso che in passato, vedremo un’esplosione di idee innovative come queste che vi ho fatto vedere oggi in ogni aspetto dell’IT.

Ok, ci fermiamo qui per questa settimana.

Scrivetemi i vostri commenti, domande e suggerimenti.

Alla prossima!

Alessandro Perilli è un esperto di tecnologie emergenti e di frontiera. Negli ultimi nove anni, Alessandro ha lavorato in Red Hat come Senior Director responsabile per la strategia di business e prodotto nella divisione di automazione di Red Hat. Alessandro ha fatto parte del team che ha eseguito l’acquisizione di Ansible nel 2015 e del team che ha coordinato la fusione di Red Hat con IBM nel 2019. Prima di lasciare Red Hat, Alessandro ha lavorato per oltre un anno con l’ex CTO di IBM Watson e il suo team di

Alessandro Perilli è un esperto di tecnologie emergenti e di frontiera. Negli ultimi nove anni, Alessandro ha lavorato in Red Hat come Senior Director responsabile per la strategia di business e prodotto nella divisione di automazione di Red Hat. Alessandro ha fatto parte del team che ha eseguito l’acquisizione di Ansible nel 2015 e del team che ha coordinato la fusione di Red Hat con IBM nel 2019. Prima di lasciare Red Hat, Alessandro ha lavorato per oltre un anno con l’ex CTO di IBM Watson e il suo team di