Nel gran parlare intorno all’intelligenza artificiale, si affronta il discorso sempre dal passo conclusivo, la generazione di un contenuto. In realtà solo una delle numerose applicazioni possibili, per buona parte diffuse da tempo, e soprattutto la cui qualità dipende da tutto quanto si trova alle spalle.

Una struttura tecnologica particolarmente articolata e complessa, per la quale serve mettere in campo competenze non comuni. «L’intelligenza artificiale generativa, quella di cui tanto si discute oggi, è basata principalmente sui Foundation Models – spiega Raoul Rocher, Data & AI Technical Sales IBM Italia. di IBM –. Creare ogni volta nuovi modelli richiede tempo e risorse, mentre la lunga esperienza accumulata con Watson permette invece di contare su una base affidabile e versatile, pronta a sfociare nell’offerta watsonx».

Per inquadrare il problema, basti pensare per esempio a una realtà alle prese con la concessione di un mutuo a un cliente. A ogni cambiamento di scenario, se non per ogni possibile situazione, è necessario creare un nuovo modello se si vuole contare su un supporto affidabile. «Inoltre, questi Foundation Models possono essere sviluppati per settori verticali – aggiunge Glauco Cenciotti, Senior Client Engineering Solution Architect di Ibm –. Watsonx nasce proprio da questa esigenza tecnologia per aiutare il tuning nella risoluzione dei problemi aziendali».

Tre moduli per un obiettivo

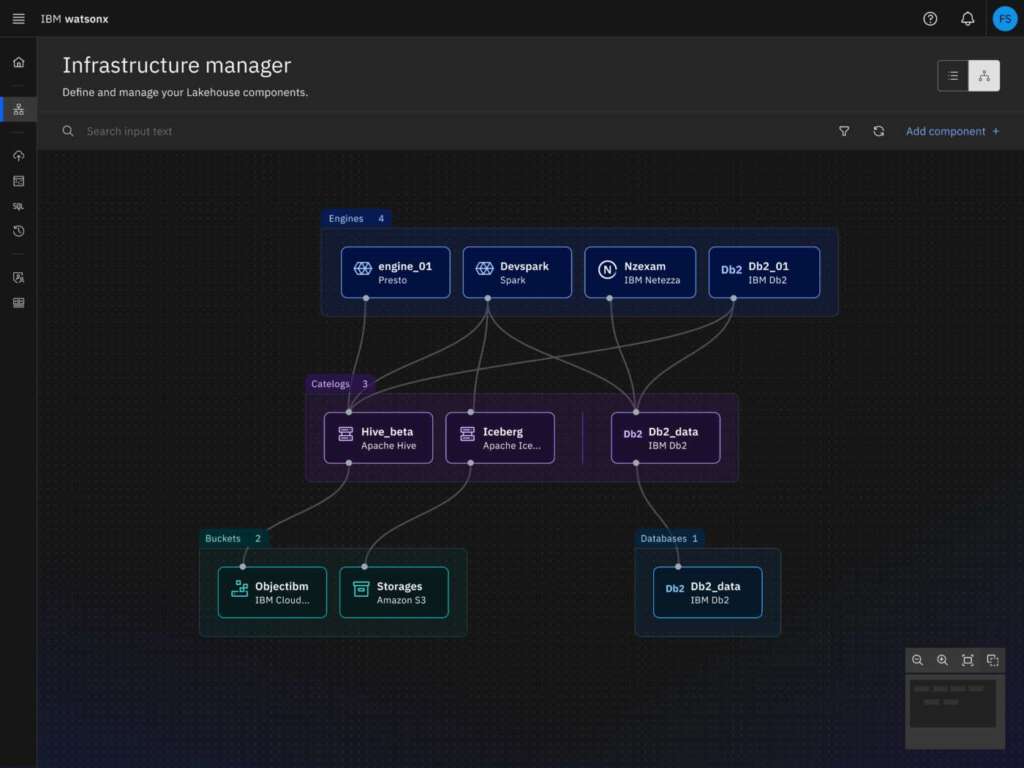

Sotto l’ombrello watsonx, sono racchiusi tre moduli, distinti ma all’occorrenza complementari a seconda delle esigenze. watsonx.data è la parte più strettamente collegata alle informazioni. Una sorta di connessione tra il mondo data warehouse e l’intelligenza artificiale. «Prende tutte le caratteristiche di un archivio dati, strutturati, non strutturati, storici, in cloud o on premise – sottolinea Rocher –, e li combina in un sistema destinato ad alimentare il sistema di intelligenza artificiale».

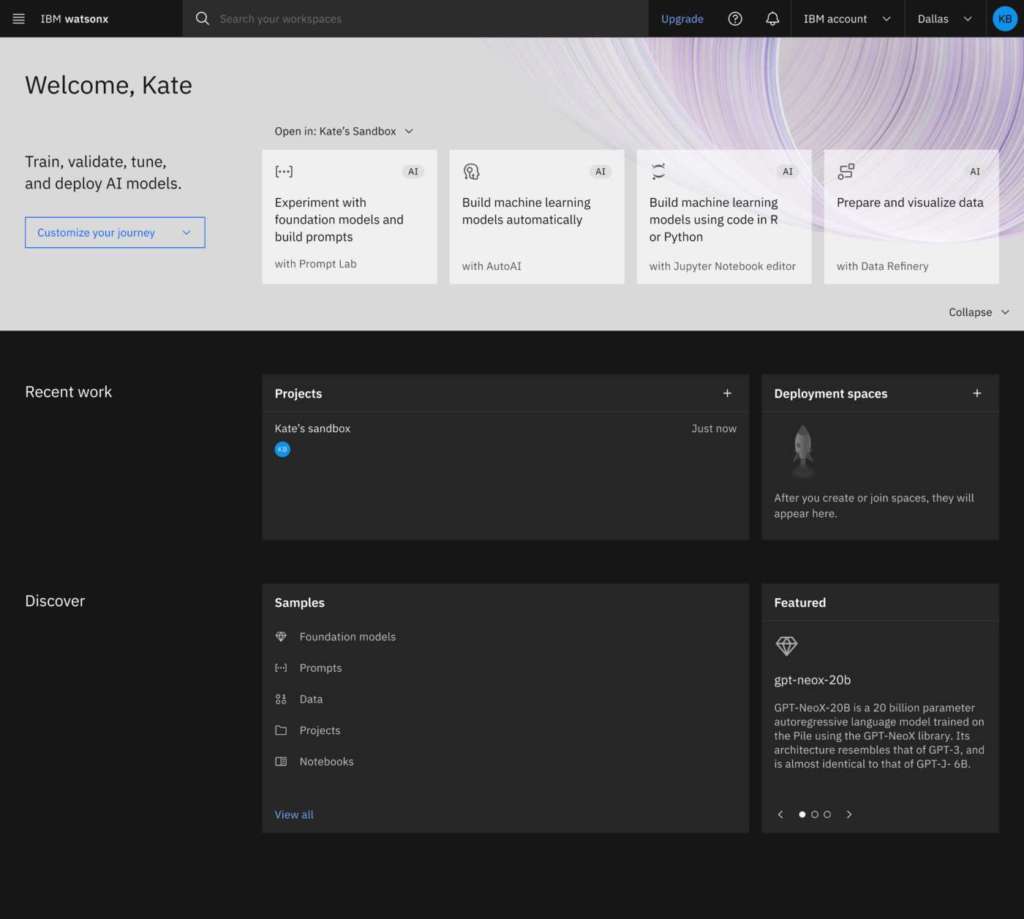

Nel caso specifico, si parla di watsonx.ai, la piattaforma evoluzione di IBM Watson Studio pensata per gestire sia i modelli tradizionali sia quelli più attuali generativi. Per chi sfrutta già gli strumenti IBM, si tratta di un’aggiunta all’offerta esistente. Cloud Pak for Data rimane comunque in catalogo. Per chi lo desidera, ora è però disponibile un livello architetturale superiore.

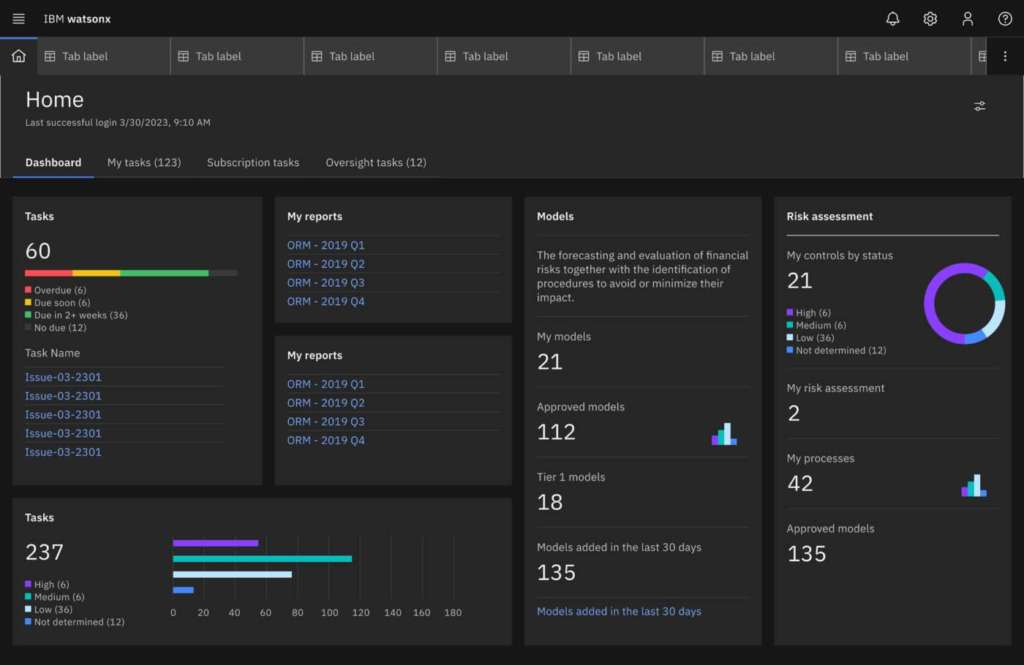

L’ultimo tassello, watsonx.governance, è incaricato di supportare il ciclo di vita di un modello. «In questo caso non parliamo più dei dati ma del vero e proprio modello di machine learning – precisa Rocher –. Quindi, il monitoraggio nel tempo per individuare la degradazione delle performance, il monitoraggio etico e in generale la capacità di prendere decisioni ponderate».

Nell’insieme tre moduli distinti, ma tra loro collegati. L’idea è supportare l’intero ciclo di vita dei dati affinché sia qualitativamente all’altezza degli algoritmi generativi. Niente impedisce però al cliente di organizzarsi come meglio crede. «L’obiettivo è creare modelli trasparenti, dove sia visibile come siano stati costruiti – osserva Cenciotti –. Modelli con i quali poi si lavora sia in fase di training sia in fase di inferenza. Tutto questo è possibile al meglio solo sfruttando tutti e tre i moduli. Fermo restando di fronte a un’esigenza specifica di sfruttarli in maniera indipendente».

Nuove prospettive

Oltre all’affidabilità per le applicazioni professionali di intelligenza artificiale generativa più note, a partire dal linguaggio parlato o scritto, è interessante guardare al potenziale dell’architettura watsonx per altre applicazioni. Tra le più interessanti, il linguaggio applicativo.

Parliamo infatti di una nuova generazione di strumenti a supporto della codifica. «Insieme a Red Hat abbiamo già sviluppato una piattaforma per facilitare la scrittura di codice per automazione e agevolare il lavoro degli sviluppatori, che potranno così contare su una sorta di semilavorato – comunica Rocher –. In questo modo, più di doversi concentrare sulla correttezza di ogni riga, sarà possibile dedicarsi maggiormente all’efficacia di un software, con la garanzia di partire da una bozza di programma già allineato con le esigenze di un particolare ambito di business».

Un’intelligenza artificiale su misura

Un esempio chiaro del potenziale dei Foundation Models. In pratica, strumenti al servizio di un’intelligenza artificiale diversificata per settore e per attività. In futuro, l’intenzione è organizzarli anche per lingua. Come facile prevedere, si moltiplica rapidamente anche l’impegno necessario per produrre non una ma un numero crescente di sorgenti e relativi processi. Dove però, IBM è convinta di avere tutto il potenziale e possa rivelarsi proprio un fattore distintivo dai sistemi di generazione basati invece su un apprendimento meno specializzato.

«Attraverso Watson Assistant, un assistente virtuale perimetrato, arrivo a prendere una decisione – riprende Rocher –. Nel caso non trovasse la risposta, non prova neppure a inventare ma semplicemente contatta il nostro modello generativo per ottenere un input pertinente. La differenza è proprio in un modello verticale, creato su misura».

Una procedura più mirata già in partenza, con questa possibilità di predisporre una serie di modelli da interrogare all’occorrenza utile per verificare l’affidabilità di un sistema di intelligenza artificiale già i primi passi, e arrivare più rapidamente, a una soluzione in linea con i requisiti di una messa in produzione.

I large language model IBM

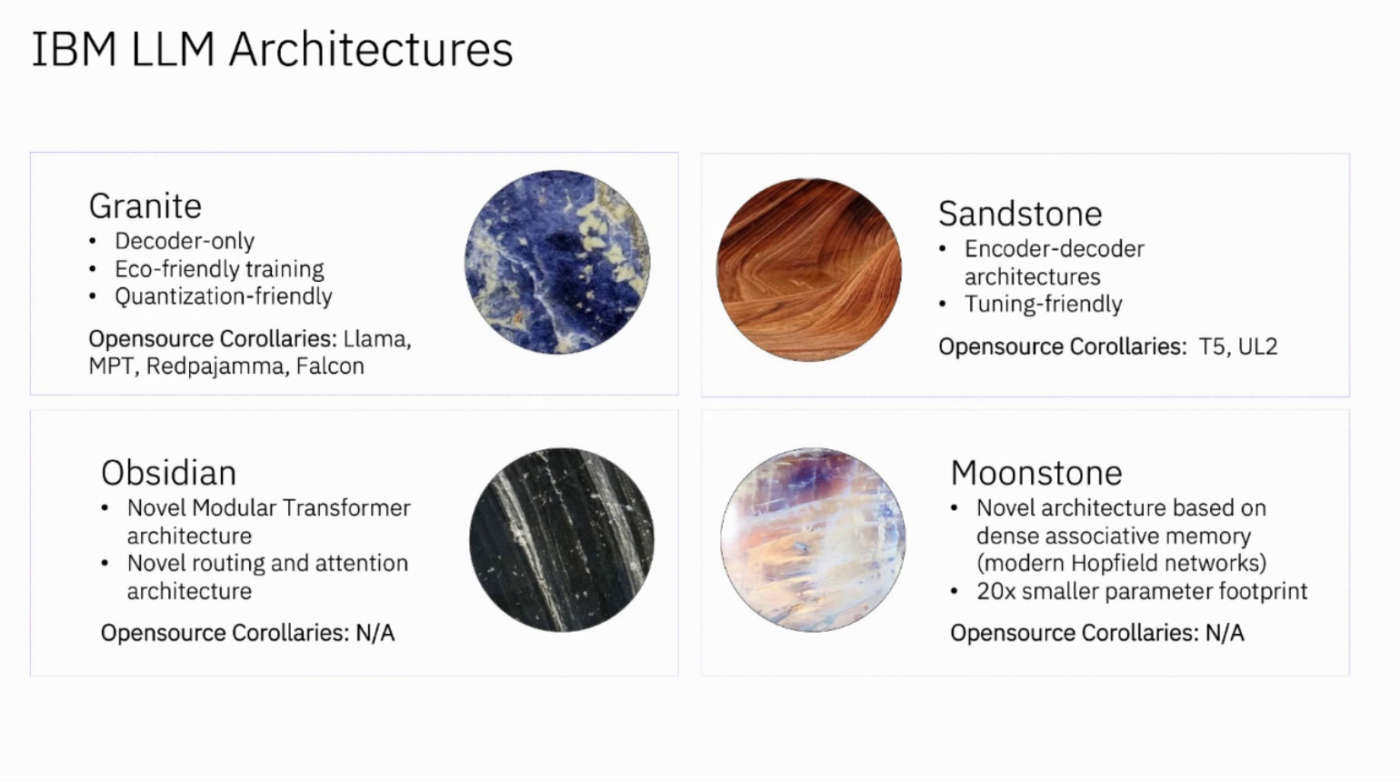

IBM sta addestrando un paio di architetture diverse di modelli linguistici di grandi dimensioni. Alcune di queste hanno corollari open source, mentre altre sono architetture nuove, sviluppate da IBM.

La serie di modelli Granite è decoder-only, ispirata a modelli open source, come LLaMA, MPT, Redpajamma e Falcon. Questi modelli sono stati addestrati con tecniche eco-compatibili e sono quantization friendly, il che significa che è possibile comprimerli e farli funzionare con una precisione di calcolo inferiore quando si esegue l’inferenza, il che permette di metterli su GPU più piccole e di farli funzionare in modo più efficiente e a un costo inferiore.

Con Granite e per ciascuno dei modelli in corso di sviluppo IBM sta addestrando una serie di dimensioni diverse che vanno da circa 200 milioni di parametri a 40 miliardi di parametri. Per ognuno di questi modelli, poi, saranno addestrati sottoinsiemi specializzati in domini diversi. Per esempio, il modello Granite.3b.finance, un modello che per metà dei suoi dati di addestramento è costituito da dati specificamente finanziari. Documenti SEC, regolamenti finanziari, relazioni 10K e altri documenti finanziari. L’intuizione è che se si ha una domanda di tipo medico, si preferisce chiedere al proprio medico e non alla persona più colta e intelligente disponibile, ma non specializzata. È meglio chiedere a un esperto con conoscenze e competenze mirate; seguendo questo ragionamento, è possibile anche utilizzare e trarre vantaggio da un modello più piccolo con un’impronta di calcolo più leggera.

La serie Sandstone di modelli encoder-decoder presenta dei vantaggi, in particolare per quanto riguarda la possibilità di metterli a punto e adattarli facilmente, consentendo un’ampia varietà di usi e casi d’uso diversi. Sono molto simili alle controparti open source, come la serie T5 e UL2 di Google.

Attraverso le serie di modelli Granite e Sandstone IBM ritiene di essere in grado di fornire molto valore immediato.

I modelli della classe Obsidian sono quelli che IBM sta sviluppando in modo del tutto nuovo e che non sono ancora stati visti nel campo dell’open source enterprise. Questi modelli si basano su un’interessante architettura a transformer modulare. Ciò che facciamo è prendere diversi moduli di parametri che è possibile addestrare: un modulo finanziario, un modulo sulla sostenibilità, un modulo basato su informazioni proprietarie del cliente. E poi si possono assemblare questi moduli come si farebbe con i Lego e creare il modello esatto con l’esatta competenza di cui si ha bisogno per svolgere il proprio compito senza avere parametri estranei per cose che non interessano. Inoltre, questi modelli funzionano in modo molto efficiente, utilizzando solo i parametri necessari al momento dell’inferenza e massimizzando quindi l’efficienza che i modelli di classe Obsidian offriranno. Ci sono altri vantaggi ancora in corso di valutazione, come i link contestuali infiniti, che consentono di inserire in questi modelli tutto il testo che si desidera e di far sì che il modello sia in grado di comprendere le informazioni che gli vengono presentate.

Infine, un po’ più lontana nella disponibilità, ma altrettanto promettente, è la serie basata sull’architettura Moonstone. Questi non sono affatto Transformer, benché i Transformer siano una delle aree principali per i modelli linguistici di grandi dimensioni. Secondo IBM c’è la possibilità di ottenere un’impronta di parametri 20 volte più piccola e un enorme risparmio di efficienza con modelli basati su un tipo di modello chiamato rete Hopfield moderna. Si tratta quindi di ricerche ancora in fase di incubazione, ma sulle quali IBM sta lavorando per portarli in futuro in Watsonx.

Dal punto di vista economico, un progetto di intelligenza artificiale a supporto di un’attività aziendale, attualmente si parla di investimenti di una certa importanza. Un altro obiettivo di watsonx e dei Foundation Models. «In questo modo si può intervenire anche su piccoli task con poco sforzo – conferma Cenciotti –. Diventa possibile affrontare più scenari e più sfide senza ogni volta dover ripartire da zero».

Tra le diverse potenziali applicazioni, le più comuni riguardano operazioni text-to-speech e viceversa, ma anche traduzioni con un importante salto di qualità di termini di affidabilità dei risultati. Grazie alla verticalizzazione, con buone notizie anche sul fronte delle risorse di calcolo. Rispetto a un sistema generalista, i requisiti sono decisamente inferiori. Quindi, all’occorrenza fruibili anche in cloud e alla portata di aziende di ogni dimensione.

«In una prima fase sarà un team interno dedicato a studiare insieme ai clienti la configurazione migliore per sfruttare la tecnologia watsonx – conclude Rocher –. Subito dopo, il coinvolgimento dei partner sarà indispensabile per allargarne l’adozione, mettendoli anche in grado di conoscerla poterla promuovere».