Google continua a spingere sull’intelligenza artificiale e, dopo aver svelato Bard, il servizio sperimentale di AI conversazionale basato su LaMDA, presenta le ultime innovazioni di Maps, Translate e Lens.

Molte delle nuove funzionalità dimostrano i progressi della nuova generazione di tecnologia basata sull’intelligenza artificiale di Google, e la loro capacità di rendere sempre più naturale e intuitivo il modo in cui le persone interagiscono con le informazioni, in qualsiasi momento, sottolinea la società di Mountain View.

Fin dai primi giorni della Ricerca Google, l’intelligenza artificiale ha aiutato nell’elaborazione del linguaggio, fornendo risultati sempre più utili. Oggi, l’AI di Google è in grado di comprendere le informazioni nelle loro forme più varie: dal linguaggio naturale alle immagini, ai video, fino a comprendere il mondo reale, reimmaginando il modo di cui cercare, esplorare e interagire ogni giorno.

Google Lens: se lo si può vedere, lo si può cercare

Le fotocamere sono diventate uno strumento importante per esplorare e comprendere il mondo che ci circonda. Oggi – sottolinea Google – Lens viene utilizzato più di 10 miliardi di volte ogni mese mentre le persone cercano ciò che vedono utilizzando la fotocamera o le immagini.

Lens mette le persone in contatto con il mondo intorno a loro e le sue informazioni, un’immagine alla volta. È già possibile utilizzare Lens per cercare dalla fotocamera del telefono o dalle foto, partendo direttamente dalla barra di ricerca. Ora Google sta introducendo un importante aggiornamento per aiutare gli utenti a cercare ciò che vedono sullo schermo del cellulare.

Nei prossimi mesi, gli utenti saranno in grado di utilizzare Lens con la funzione “Search your screen” su Android in tutto il mondo. Con questa tecnologia, è possibile cercare ciò che si vede in una foto o in un video sul web e nelle proprie app preferite, come le app di messaggistica e video, senza dover uscire dall’app o dall’esperienza specifica.

Ad esempio, se un amico ci manda un messaggio con un video in cui visita la città di Parigi e vogliamo saperne di più sul monumento sullo sfondo, sarà possibile semplicemente toccare e tenere premuto il pulsante di accensione o il pulsante Home sul proprio telefono Android (che richiama l’Assistente Google) e quindi toccare “search screen“. Lens lo identifica e l’utente può cliccare per saperne di più.

Con la Ricerca multipla è possibile cercare partendo da un’immagine e un testo allo stesso tempo, aprendo modalità completamente nuove. Ora Google ha annunciato che la Ricerca multipla è disponibile in tutto il mondo sui dispositivi mobili, in tutte le lingue e i Paesi in cui è disponibile Lens, quindi anche in Italia.

Di recente Google ha anche migliorato ulteriormente la Ricerca multipla aggiungendo la possibilità di cercare vicino all’utente. Le persone possono scattare una foto e aggiungere “vicino a me” per trovare ciò di cui hanno bisogno. Attualmente questa funzione è disponibile in inglese negli Stati Uniti e nei prossimi mesi verrà estesa a livello globale.

Inoltre, nei prossimi mesi gli utenti saranno in grado di utilizzare la Ricerca multipla su qualsiasi immagine visualizzata nella pagina dei risultati di ricerca sui dispositivi mobili.

Ad esempio, se cerchiamo “idee per un soggiorno moderno” e vediamo un tavolino che ci piace, ma lo preferiremmo in un’altra forma, ad esempio rettangolare anziché rotondo, sarà possibile utilizzare la Ricerca multipla per aggiungere il testo “rettangolare” e trovare lo stile che più ci piace.

Google Maps diventa più immersiva e sostenibile

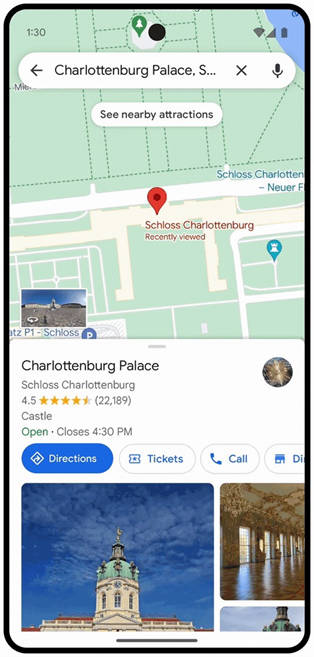

Ci sono molte novità anche per Google Maps: dalla visualizzazione immersiva agli aggiornamenti di Live View fino ai nuovi strumenti per la ricarica dei veicoli elettrici e altro ancora.

La visualizzazione immersiva è un modo completamente nuovo di esplorare un luogo: fa sentire come se si fosse proprio lì, anche prima di visitarlo. Utilizzando i progressi dell’intelligenza artificiale e della computer vision, spiega Google, la visualizzazione immersiva fonde miliardi di immagini di Street View e immagini aeree per creare un modello digitale del mondo incredibilmente ricco. E sovrappone informazioni utili come il tempo, il traffico e quanto è affollato un luogo.

Ad esempio, se stiamo programmando una visita al Rijksmuseum di Amsterdam, possiamo sorvolare virtualmente l’edificio e vedere dove si trovano gli ingressi del museo. Con il dispositivo di scorrimento temporale, è possibile vedere come appare l’area nelle diverse ore del giorno e che tempo farà. Sarà anche possibile individuare i luoghi più affollati, in modo da avere tutte le informazioni necessarie per decidere dove e quando andare. Se si ha fame, si può scendere al livello strada per esplorare i ristoranti vicini, e dare anche un’occhiata all’interno per capire rapidamente l’atmosfera di un locale prima di prenotare.

Per creare queste scene fedeli alla realtà, Google utilizza i campi di radianza neurale (NeRF, neural radiance fields), una tecnica avanzata di intelligenza artificiale che trasforma le immagini ordinarie in rappresentazioni 3D. Con NeRF, si può ricreare con precisione l’intero contesto di un luogo, compresa l’illuminazione, la consistenza dei materiali e lo sfondo.

La ricerca con Live View utilizza l’intelligenza artificiale e la realtà aumentata per aiutare gli utenti a trovare le cose che li circondano, come bancomat, ristoranti, parchi e stazioni di transito, semplicemente mettendo il telefono in posizione verticale mentre sono per strada. Recentemente Google ha lanciato la ricerca con Live View a Londra, Los Angeles, New York, Parigi, San Francisco e Tokyo. Nei prossimi mesi l’azienda inizierà a estendere questa funzione a Barcellona, Dublino e Madrid.

La realtà aumentata può essere particolarmente utile quando si naviga in luoghi difficili, come un aeroporto sconosciuto. Nel 2021 Google ha introdotto negli Stati Uniti, a Zurigo e a Tokyo Live View al chiuso per aiutare gli utenti in questo senso. Permette di usare frecce alimentate dalla realtà aumentata per indicare la direzione giusta, in modo che si possa trovare rapidamente e con sicurezza i servizi igienici, le sale d’attesa, le stazioni dei taxi, gli autonoleggi e molto altro ancora.

Ora Google sta dando il via alla più grande espansione di Live View al chiuso, che porterà nei prossimi mesi in più di 1.000 nuovi aeroporti, stazioni ferroviarie e centri commerciali a Barcellona, Berlino, Francoforte, Londra, Madrid, Melbourne, Parigi, Praga, San Paolo, Singapore, Sydney, Taipei e Tokyo.

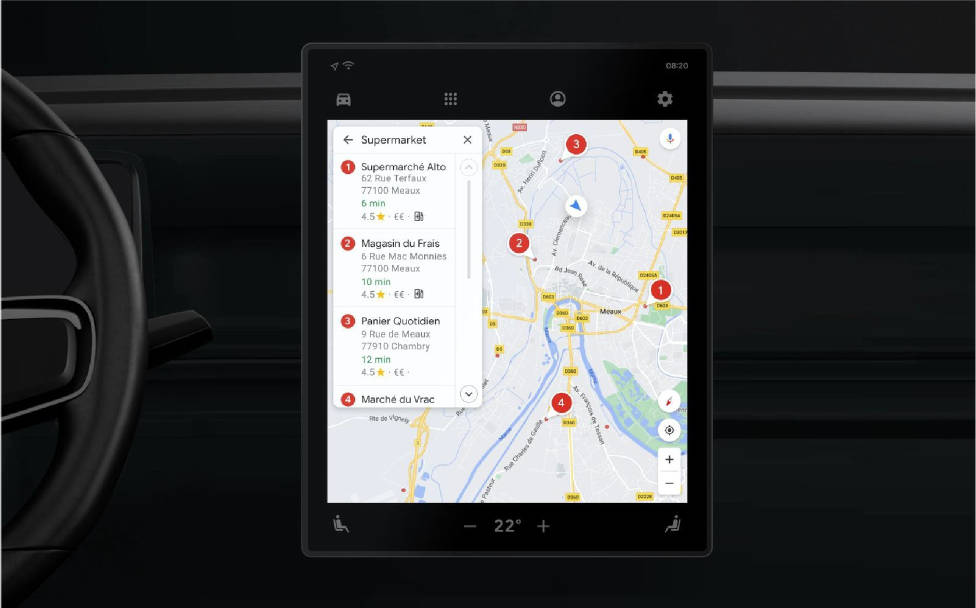

Un’altra novità: l’azienda sta introducendo nuove funzionalità per i conducenti di veicoli elettrici con veicoli dotati di Google Maps integrato.

Per qualsiasi viaggio che richieda una sosta di ricarica, Maps suggerirà il punto migliore in base a fattori quali il traffico in quel momento, il livello di carica e il consumo di energia previsto. E se non si vuole sostare in quel punto, bastano pochi tap per passare al successivo.

Il filtro di ricarica “molto veloce” aiuterà a trovare facilmente le stazioni con caricatori da 150 kilowatt o superiori. Per molte autovetture, ciò consente di avere energia sufficiente per fare il pieno e tornare in strada in meno di 40 minuti.

Google mostrerà anche nei risultati di ricerca quando luoghi come un supermercato hanno stazioni di ricarica in loco.

Con le indicazioni a colpo d’occhio, è possibile seguire il viaggio direttamente dalla panoramica del percorso o dalla schermata di blocco. Sarà possibile vedere i tempi di arrivo previsti e la prossima svolta, informazioni che prima erano visibili solo sbloccando il telefono, aprendo l’app e utilizzando la modalità di navigazione completa.

E se si decide di prendere un’altra strada, il viaggio sarà aggiornato automaticamente. Le indicazioni a colpo d’occhio inizieranno a essere disponibili in tutto il mondo su Android e iOS nei prossimi mesi e saranno compatibili anche con le Attività Live su iOS 16.1.

Le nuove funzionalità di Translate

L’intelligenza artificiale ha contribuito anche a realizzare alcuni dei maggiori progressi nella traduzione con Google Translate, sottolinea l’azienda. E ora viene lanciato un numero ancora maggiore di funzioni basate sull’intelligenza artificiale per fornire una consapevolezza utile e contestuale quando si utilizza Translate su dispositivi mobili e sul web.

Questo mese, Translate offrirà un maggior numero di opzioni di traduzione contestuali con descrizioni ed esempi vari nella lingua prevista per la traduzione. In questo modo, gli utenti avranno a disposizione il contesto necessario per tradurre accuratamente e utilizzare i giusti giri di parole, le espressioni idiomatiche locali o le parole appropriate a seconda delle proprie intenzioni, con lingue quali inglese, francese, tedesco, giapponese e spagnolo che verranno introdotte nelle prossime settimane.

Di recente, l’app Google Translate su Android si è rifatta il look e tra qualche settimana Google porterà un nuovo design anche su iOS. L’esperienza di Translate ridisegnata offre una superficie più ampia per la digitazione e punti di accesso più accessibili per la traduzione delle conversazioni, l’inserimento vocale e la traduzione con la fotocamera Lens.

Sono in arrivo nuovi gesti per rendere Translate più accessibile, tra cui la possibilità di selezionare una lingua con un minor numero di tocchi, di tenere premuto il pulsante della lingua per scegliere rapidamente una lingua usata di recente e di scorrere verso il basso nell’area di testo della schermata iniziale per visualizzare rapidamente le traduzioni recenti.

Anche i risultati delle traduzioni sono ora più leggibili, grazie a un font dinamico che si adatta automaticamente alla digitazione del testo. Traduzioni alternative e definizioni del dizionario (quando disponibili) contribuiscono a facilitare l’esplorazione dei diversi significati.

Arriva poi un’espansione delle lingue on-device: 33 lingue aggiuntive sono ora disponibili anche sul dispositivo nell’app Translate, tra cui basco, corso, hawaiano, hmong, curdo, latino, lussemburghese, sundanese, yiddish e zulu, per dare la possibilità di scaricare ancora più lingue da usare quando non c’è una connessione di rete o ci si trova in una zona con scarsa connettività.

Se Google Translate è stato un ottimo strumento per la traduzione di testi, i progressi dell’intelligenza artificiale hanno permesso di tradurre le immagini con Lens, cosa che consente di cercare ciò che si vede utilizzando la fotocamera del dispositivo.

Con un ulteriore grande passo avanti, l’apprendimento automatico avanzato permette anche di integrare il testo tradotto in immagini complesse, in modo da ottenere un aspetto e una sensazione molto più naturali. Di recente Google ha anche ampliato la traduzione di immagini sul web per offrire più opzioni di traduzione di contenuti basati su immagini, indipendentemente dalla modalità di ricerca.