Fino a oggi, creare musica interessante è stata una sfida particolarmente ardua per i sistemi di intelligenza artificiale (AI): ma ora, in collaborazione con YouTube, Google DeepMind ha annunciato Lyria, il suo modello AI di generazione musicale più avanzato finora, e due esperimenti AI progettati per aprire nuove strade per la creatività.

Il primo di questi è Dream Track, un esperimento di YouTube Shorts progettato per aiutare ad approfondire le connessioni tra artisti, creator e fan attraverso la creazione di musica.

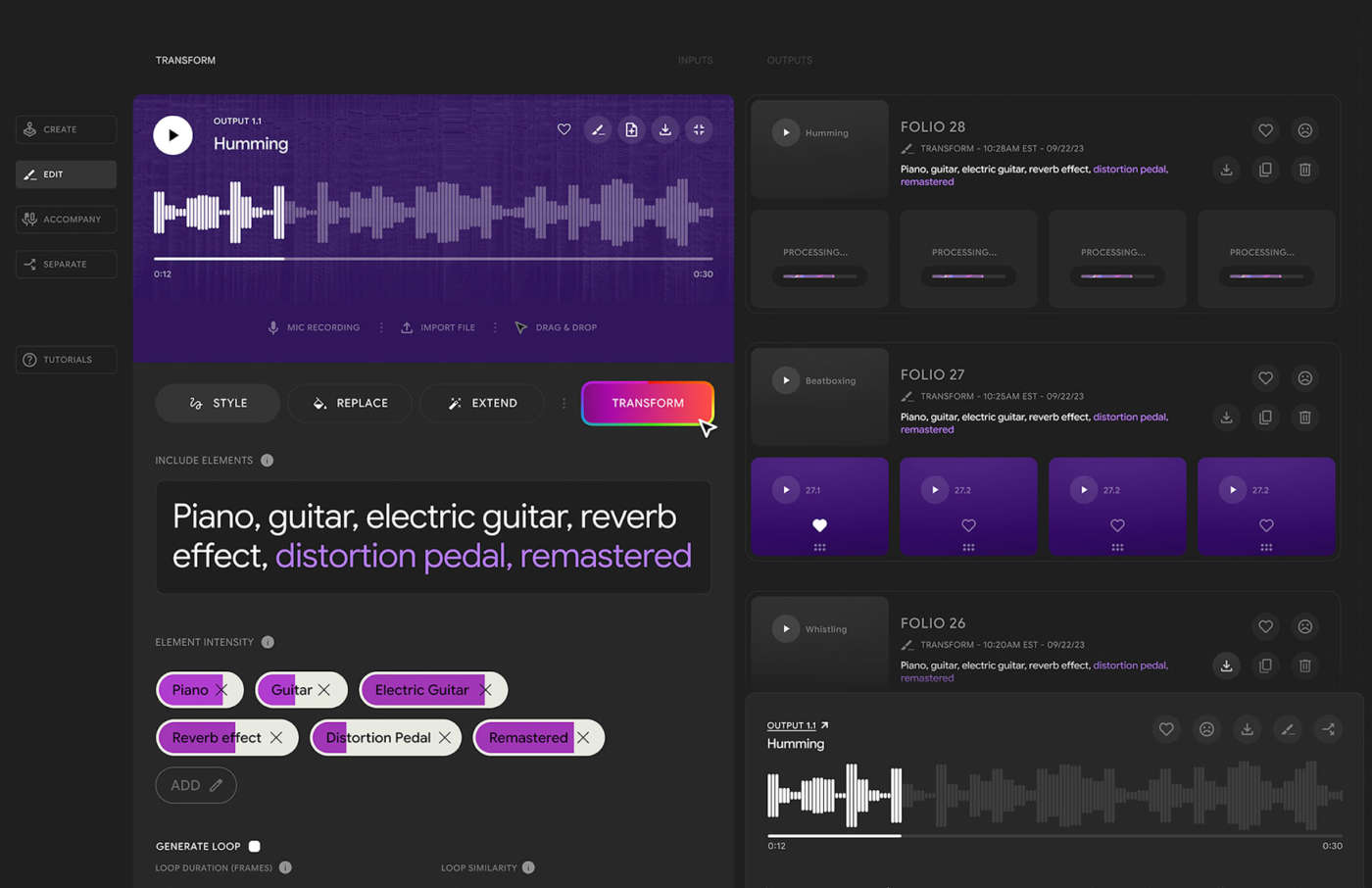

Music AI tools è invece un set di strumenti che Google DeepMind sta progettando con artisti, autori e produttori per contribuire a rafforzare i loro processi creativi.

Per sviluppare questi progetti, Google ha riunito esperti tecnici dell’azienda e una serie di artisti e compositori di fama mondiale per esplorare come le tecnologie musicali generative possano plasmare responsabilmente il futuro della creazione musicale, al fine di migliorare il lavoro dei musicisti professionisti e della community degli artisti.

La musica – sottolinea l’azienda – contiene enormi quantità di informazioni: si pensi a ogni battuta, nota e armonia vocale in ogni secondo. Quando si generano lunghe sequenze di suoni, è difficile per i modelli di intelligenza artificiale mantenere la continuità musicale attraverso strofe, ritornelli o passaggi prolungati. Poiché spesso la musica comprende più voci e strumenti contemporaneamente, è molto più difficile da creare rispetto al parlato.

Sviluppato da Google DeepMind, il modello Lyria eccelle nella generazione di musica di alta qualità con strumenti e voci, nell’esecuzione di compiti di trasformazione e continuazione e nel fornire agli utenti un controllo più sfumato dello stile e della performance dell’output.

Google sta sperimentando Lyria in un esperimento chiamato Dream Track, progettato per testare nuovi modi in cui gli artisti possono connettersi con i loro fan e sviluppato in collaborazione con YouTube.

Nell’ambito dell’esperimento, un gruppo limitato di creator potrà utilizzare Dream Track per produrre una colonna sonora unica con la voce e lo stile musicale generati dall’intelligenza artificiale, di artisti come Alec Benjamin, Charlie Puth, Charli XCX, Demi Lovato, John Legend, Sia, T-Pain, Troye Sivan e Papoose. Ogni artista partecipante ha stretto una partnership con Google e aiuterà l’azienda a testare e imparare per plasmare il futuro dell’intelligenza artificiale nella musica.

Gli utenti di Dream Track possono semplicemente inserire un topic e scegliere un artista per generare una colonna sonora di 30 secondi per il loro Short. Utilizzando il modello Lyria, Dream Track genera simultaneamente il testo, la colonna sonora e la voce generata dall’intelligenza artificiale nello stile dell’artista selezionato.

I ricercatori di Google hanno esplorato con artisti, autori e produttori nel Music AI Incubator di YouTube il modo in cui l’intelligenza artificiale generativa può supportare al meglio il processo creativo e hanno lavorato insieme per progettare responsabilmente una suite di strumenti di intelligenza artificiale musicale.

Con i music AI tools di Google DeepMind, gli utenti possono creare nuova musica o sezioni strumentali da zero, trasformare l’audio da uno stile musicale o da uno strumento a un altro e creare accompagnamenti strumentali e vocali.

Il team di Google DeepMind sta anche svolgendo un lavoro all’avanguardia nella diffusione responsabile delle sue tecnologie con strumenti allo stato dell’arte per il watermarking e l’identificazione dei contenuti generati sinteticamente. Tutti i contenuti pubblicati dal modello Lyria saranno filigranati con SynthID, lo stesso toolkit tecnologico che l’azienda sta utilizzando per identificare le immagini generate da Imagen su Vertex AI di Google Cloud.

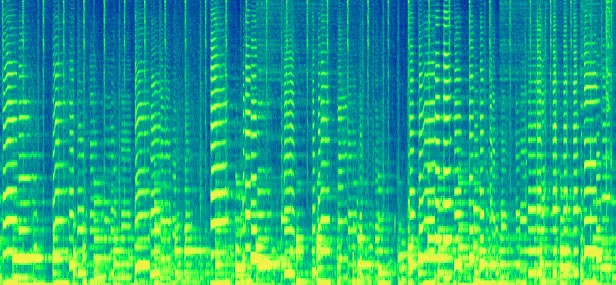

SynthID incorpora un watermark nei contenuti audio generati dall’intelligenza artificiale che non è udibile dall’orecchio umano e non compromette l’esperienza di ascolto. Lo fa convertendo l’onda audio in una visualizzazione bidimensionale che mostra come lo spettro delle frequenze di un suono si evolve nel tempo. Questo metodo innovativo è diverso da qualsiasi altro esistente oggi, soprattutto nel contesto dell’audio, sostiene Google DeepMind.

Il watermark è progettato per mantenere la rilevabilità anche quando il contenuto audio subisce molte modifiche comuni, come l’aggiunta di rumore, la compressione MP3 o la velocizzazione e il rallentamento della traccia. SynthID è anche in grado di rilevare la presenza di un watermark all’interno di una traccia per aiutare a determinare se alcune parti di un brano sono state generate da Lyria.