Aleph Alpha, fornitore di soluzioni tecnologiche per l’AI con sede in Germania, ha annunciato una nuova architettura innovativa per gli LLM, per affrontare una delle sfide più critiche dell’intelligenza artificiale.

Insegnare agli attuali LLM closed o open-source nuovi linguaggi o conoscenze settoriali uniche (spesso cruciali per imprese e governi) tende a produrre risultati insoddisfacenti e il fine-tuning si rivela spesso inefficace, spiega l’azienda tedesca, che aggiunge: uno dei motivi principali è che i pattern appresi da questi LLM si basano sulla versione tokenizzata del testo su cui sono stati addestrati. Se un nuovo testo differisce notevolmente dai dati di addestramento originali, non può essere tokenizzato in modo efficiente.

“La nostra architettura di modelli tokenizer-free è una soluzione chiave per affrontare una delle principali sfide dell’AI: ilfine-tuning e la creazione di modelli sovrani per alfabeti diversi, lingue con scarse risorse ed esigenze industriali altamente specifiche – aree in cui gli sforzi di personalizzazione sono stati finora insufficienti. Abbinata all’efficienza rivoluzionaria della più recente tecnologia AMD AI, questa soluzione segna un salto di qualità, sbloccando opportunità strategiche prima irraggiungibili“, afferma Jonas Andrulis, Fondatore e CEO di Aleph Alpha.

La nuova architettura LLM di Aleph Alpha non richiede un tokenizer, estendendo le capacità di LLM oltre i dati di addestramento originali. Questo approccio – sottolinea l’azienda – risolve un problema fondamentale delle attuali architetture dei modelli linguistici, che di solito possono essere addestrati in modo efficiente solo su dati che utilizzano token simili ai dati di training originali. Il fine-tuning dei modelli attuali su dati out-of-distribution richiede insiemi di dati molto grandi (spesso non disponibili per le lingue meno comuni) e quantità massicce di calcolo, il che si traduce in un modello con costi di inferenza e un’impronta ambientale di livello insostenibile, afferma l’azienda tedesca.

Secondo Aleph Alpha, questo sviluppo innovativo è destinato a gettare le basi per una nuova generazione di soluzioni AI sovrane che consentano ai governi e alle imprese di costruire le proprie soluzioni AI sovrane basate sulla propria lingua madre, sulle specifiche culturali e sulle conoscenze e terminologie specializzate. Di conseguenza, ciò democratizzerà l’accesso a questa tecnologia e promuoverà la pluralità economica e culturale.

“Ho fondato Aleph Alpha con la missione di rafforzare la sovranità dei Paesi e delle aziende di tutto il mondo nell’era dell’AI. Per i nostri clienti, questo significa integrazione open-source, massima trasparenza e affidabilità per una nuova era di collaborazione uomo-macchina, soluzioni AI trasformative a prova di futuro e libera scelta dell’ambiente di esecuzione“, afferma Jonas Andrulis, Fondatore e CEO di Aleph Alpha.

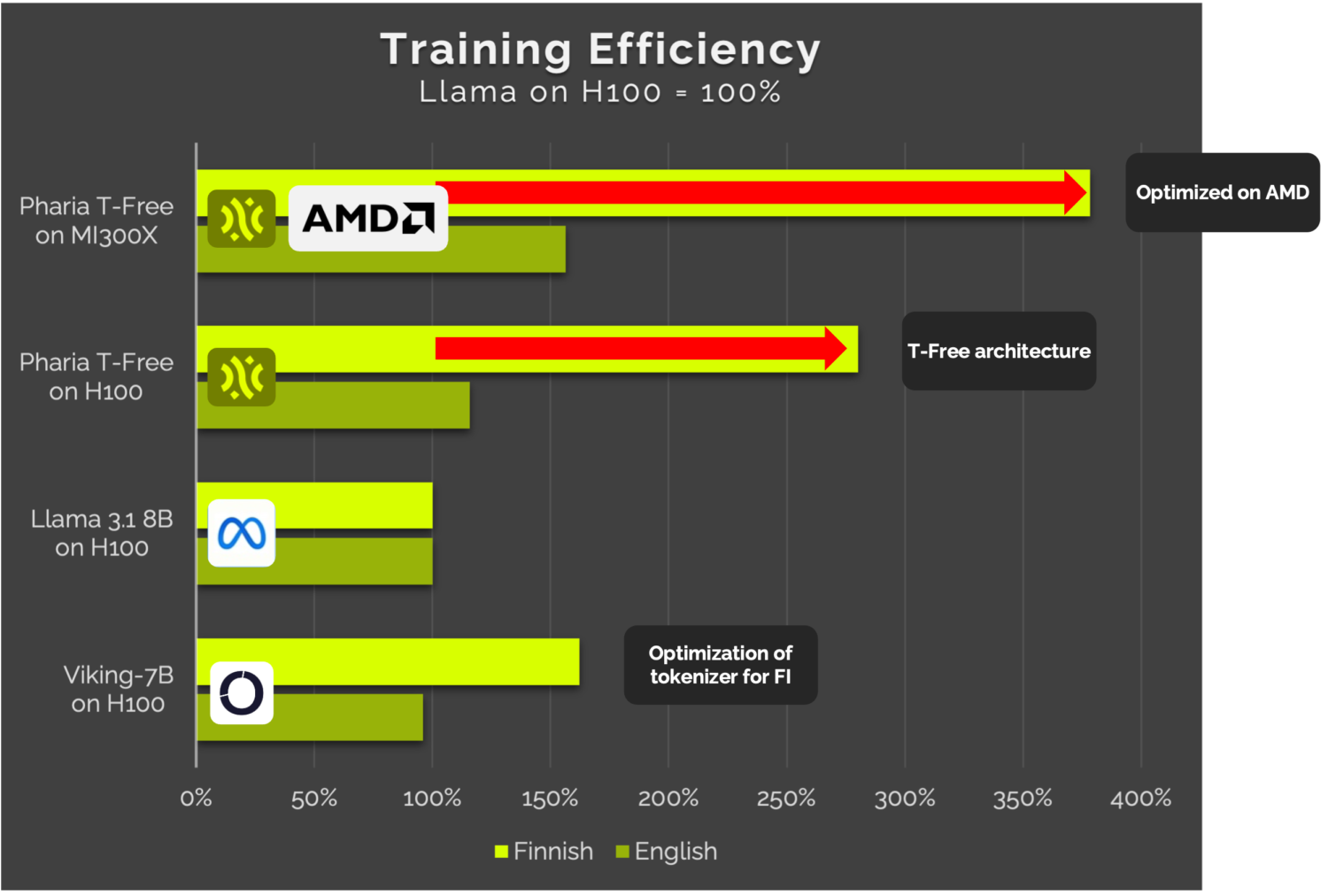

Combinando la tecnologia GenAI all’avanguardia di Aleph Alpha con le prestazioni e l’efficienza degli acceleratori AMD Instinct della serie MI300 e le ottimizzazioni per lo stack software aperto AMD ROCm, l’azienda afferma di aver ottenuto progressi significativi nelle prestazioni GenAI. Sfruttando la notevole capacità di memoria degli acceleratori AMD Instinct, questa soluzione chiavi in mano offre vantaggi sia in termini di prestazioni che di efficienza, in particolare per i linguaggi a basse risorse.

Ad esempio, afferma l’azienda, utilizzando il finlandese, questa innovativa architettura di intelligenza artificiale è in grado di ridurre del 70% i costi di training e l’impronta di carbonio rispetto alle opzioni alternative

“Questa collaborazione porta molto di più dell’AI: offre resilienza e innovazione all’ecosistema europeo dell’AI“, afferma Keith Strier, SVP, Global AI Markets, AMD. “Siamo entusiasti di collaborare con Aleph Alpha e Schwarz Digits per potenziare le capacità di AI native dell’Europa e creare una nuova triplice combinazione vincente di AI per i governi: una piattaforma GenAI iper-trasparente, sviluppata e addestrata in Europa, che offre un’efficienza eccezionale sulla nostra infrastruttura AMD AI“.

Oltre a una piattaforma di calcolo ad alte prestazioni basata sulle GPU AMD Instinct e sullo stack software aperto AMD ROCm, Aleph Alpha si avvale anche del team AMD SiloAI di Helsinki, che ha contribuito a dimostrare le innovative capacità multilingue della sua nuova architettura di modelli. Questa iniziativa è ulteriormente rafforzata dal data center e dalle capacità di fornitura tecnica di STACKIT, il cloud sovrano di Schwarz Digits, la divisione IT e digitale del Gruppo Schwarz, il più grande retailer europeo con 575.000 dipendenti, con sede in Germania.

Le funzionalità AI del sistema operativo Pharia di Aleph Alpha, ora ottimizzate su AMD, creano un’offerta sovrana full-stack che combina software e hardware AI. Ciò consentirà di ottenere vantaggi significativi in termini di costi di elaborazione e di impronta ambientale, dichiara l’azienda. Oltre alla nuova generazione Pharia LLM di modelli foundation tokenizer-free, sperimentata da Aleph Alpha, PhariaAI incorpora diverse innovazioni uniche che consentono livelli di spiegabilità, trasparenza ed efficienza senza precedenti, facilitando la rapida integrazione di GenAI affidabile nelle operazioni industriali e governative.

È possibile consultare l’ultimo paper di ricerca peer-reviewed sul language modelling tokenizer-free (T-Free); inoltre, sono disponibili ulteriori dettagli tecnici nel blog di Aleph Alpha.