Ricercatori Apple hanno presentato un modello di intelligenza artificiale foundation per la stima metrica della profondità monoculare a zero scatti.

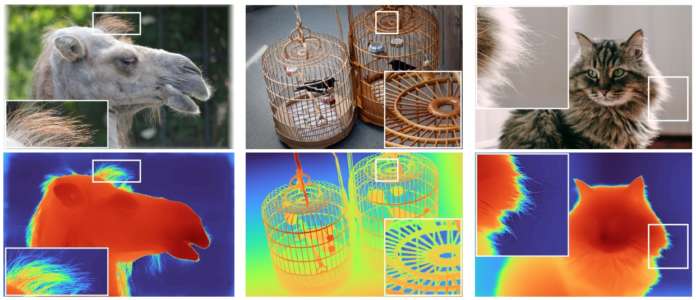

Il modello Depth Pro – spiegano i ricercatori nel paper di ricerca che hanno pubblicato –, sintetizza mappe di profondità ad alta risoluzione con una nitidezza senza pari e dettagli ad alta frequenza. Le previsioni sono metriche, con scala assoluta, senza dipendere dalla disponibilità di metadati come quelli intrinseci della telecamera.

E il modello – sottolineano gli autori del paper – è veloce: produce una mappa di profondità da 2,25 megapixel in 0,3 secondi su una GPU standard.

Queste caratteristiche sono rese possibili da una serie di contributi tecnici, tra cui un efficiente multi-scale vision transformer per una previsione densa, un protocollo di addestramento che combina insiemi di dati reali e sintetici per ottenere un’elevata accuratezza metrica insieme a un fine tracciamento dei bordi, metriche di valutazione dedicate per l’accuratezza vincolata delle mappe di profondità stimate e una stima della lunghezza focale all’avanguardia da una singola immagine.

Gli esperimenti approfonditi analizzano le scelte progettuali specifiche e secondo i ricercatori Apple dimostrano che Depth Pro supera i lavori precedenti su più dimensioni.

I ricercatori hanno inoltre rilasciato il codice e i pesi del modello Depth Pro su GitHub. Il modello nel repository di GitHub è un’implementazione di riferimento, che è stata ri-addestrata. Le sue prestazioni si avvicinano al modello riportato nel paper, ma non corrispondono esattamente ad esse, sottolineano i ricercatori.

La stima della profondità monoculare a zero scatti è la capacità dell’intelligenza artificiale di stimare la profondità di una scena utilizzando una singola immagine, senza bisogno di campioni di addestramento specifici per il contesto, quindi di rilevare la profondità solo con l’immagine di input. È alla base di una crescente varietà di applicazioni, come l’editing avanzato delle immagini, la sintesi della vista e la generazione di immagini condizionali.

Gli autori del paper sono: Aleksei Bochkovskii, Amaël Delaunoy, Hugo Germain, Marcel Santos, Yichao Zhou, Stephan R. Richter e Vladlen Koltun.