Ciao a tutti! Le voci dell’AI episodio numero sei.

In queste prime cinque settimane insieme abbiamo parlato di parecchi argomenti diversi.

Nell’episodio tre abbiamo discusso l’impatto dell’AI sulla produttività aziendale; nell’episodio due abbiamo menzionato il nascente ecosistema di prodotti e servizi che usano le API di OpenAI; nell’episodio quattro abbiamo considerato come l’AI potrebbe influenzare il comportamento dei dipendenti aziendali quando viene applicata ad un pacchetto di prodotti come Microsoft 365. La settimana scorsa nell’episodio cinque abbiamo parlato di vari modelli di intelligenza artificiale che le aziende possono considerare in alternativa a GTP-4 oggi voglio parlarvi di una cosa completamente diversa che non ha niente a che fare con modelli, prodotti o concorrenza di mercato.

Oggi parliamo dell’Effetto Eliza.

Se siete interessati all’intelligenza artificiale da lungo tempo, è probabile che ne abbiate già sentito parlare.

Effetto Eliza è un termine che esiste dagli anni ’60 e che è stato coniato da uno dei primissimi ricercatori nel campo dell’AI chiamato Joseph Weizenbaum.

Dobbiamo ritornare sull’argomento per spiegare qualcosa che sta succedendo oggi nel 2023 e che potrebbe succedere in un prossimo futuro.

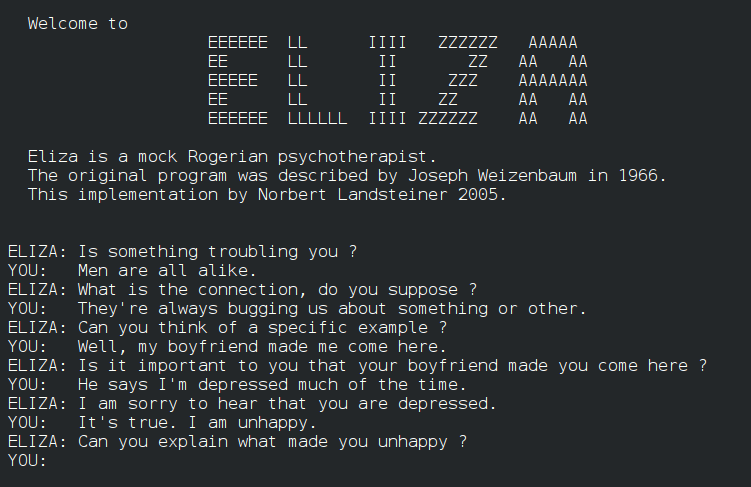

Siamo nel 1966. Durante il suo periodo all’MIT, Joseph Weizenbaum sviluppa una versione rudimentale di chatbot che usiamo oggi, come ChatGPT, e la chiama Eliza. Eliza fa una cosa molto semplice per ogni affermazione fatta da un utente: risponde ripetendo quella affermazione in forma di domanda o confermando di aver capito quella affermazione così da stimolare la conversazione.

Facciamo un esempio: se l’utente scrive nel suo prompt “oggi mi sento depresso”, Eliza risponde con qualcosa tipo “Mi spiace che oggi tu ti senta depresso.”

Se l’utente scrive “la mia fidanzata dice che sono sempre depresso”, Eliza risponde con una cosa tipo “puoi spiegarmi perché la tua fidanzata dice che sei sempre depresso?”

E quando Eliza si trova di fronte a un prompt dell’utente che non riesce a gestire in qualche maniera, semplicemente dice una cosa tipo “molto interessante” o ”capisco, vai avanti”.

Questo tipo di interazione è una versione estremamente semplificata della tecnica terapeutica chiamata reflected listening o ascolto riflessivo inventata negli anni ’50 dallo psicologo Carl Rogers, quella che sta alla base della cosiddetta person centric therapy, che in italiano è tradotta con terapia non direttiva.

Perché diciamo che è una versione estremamente semplificata di quella tecnica? Perché esattamente come ChatGPT o qualunque sua alternativa oggi, l’AI di Eliza non ha nessuna comprensione di quello che l’utente dice, o un modello del mondo in cui viviamo che collega le idee contenute in quello che l’utente dice. È semplicemente un meccanismo di risposta automatica con un certo numero di regole fisse che parte dal riconoscimento di certe parole chiave nelle frasi scritte dall’utente. Nessuna comprensione, nessun apprendimento, nessun adattamento.

Ok, continuiamo e vediamo dove ci porta questa storia.

Nel ’66, i partecipanti agli esperimenti di Weizenbaum sanno benissimo che stanno interagendo con un’AI. Eppure, succede qualcosa di inaspettato.

Le persone cominciano a raccontare a Eliza dettagli della loro vita privata, a desiderare di avere conversazioni private con il computer e a sviluppare un legame emotivo con l’AI.

Cosa più importante di tutte i partecipanti cominciano a convincersi di essere di fronte ad un essere intelligente e non di fronte a un’AI rudimentale.

L’illusione è così potente che anche i partecipanti che hanno familiarità con l’informatica cominciano a credere che Weizenbaum abbia inavvertitamente creato una coscienza artificiale.

Quando una persona attribuisce capacità cognitive tipiche degli esseri umani a una macchina come risultato dell’illusione creata da un’interazione con l’AI parliamo di effetto Eliza.

Ora la domanda è: perché esiste l’effetto Eliza?

Cosa ci porta a credere questa illusione? La risposta è che l’effetto Eliza è una forma di dissociazione cognitiva.

In pratica, il nostro cervello non riesce a riconciliare la nozione di un computer che è non intelligente, con l’esperienza di un computer che si comporta in una maniera apparentemente intelligente.

Questi due concetti non coesistono bene nella nostra testa e quindi a volte il cervello crea la storia più plausibile di cui è capace per spiegare entrambe le cose.

E la storia più plausibile di cui siamo capaci è che sì, forse l’AI con cui stiamo interagendo è cominciata come un programma rudimentale, ma lungo la strada è accaduto qualcosa di inaspettato, qualcosa che non è stato previsto dai creatori.

E il programma rudimentale ha sviluppato un’intelligenza e una coscienza alla pari con quella di un essere umano.

E quindi ci sentiamo autorizzati a trattare il programma come tale come una persona.

Perché però tra i due concetti non scegliamo invece quello del computer, non intelligente? Perché gli esseri umani tendono ad associare caratteristiche umane a molte altre cose animali, oggetti, fenomeni naturali e così via, e questa tendenza è sfruttata dalle aziende di tutto il mondo quando disegnano i loro prodotti, in modo da avere un aspetto che ricordi anche vagamente un essere umano.

Adesso torniamo al presente. Oggi, nel 2023 è ragionevole aspettarsi che in sessant’anni gli esseri umani abbiano fatto grandi progressi nel capire l’effetto Eliza e non siano più a rischio di credere all’illusione.

Invece l’unica cosa che ha fatto progressi è l’intelligenza artificiale che oggi è infinitamente più credibile di sessant’anni fa.

Vi faccio due esempi che sono difficili da credere senza la lezione di storia su Eliza.

Replika, il compagno AI

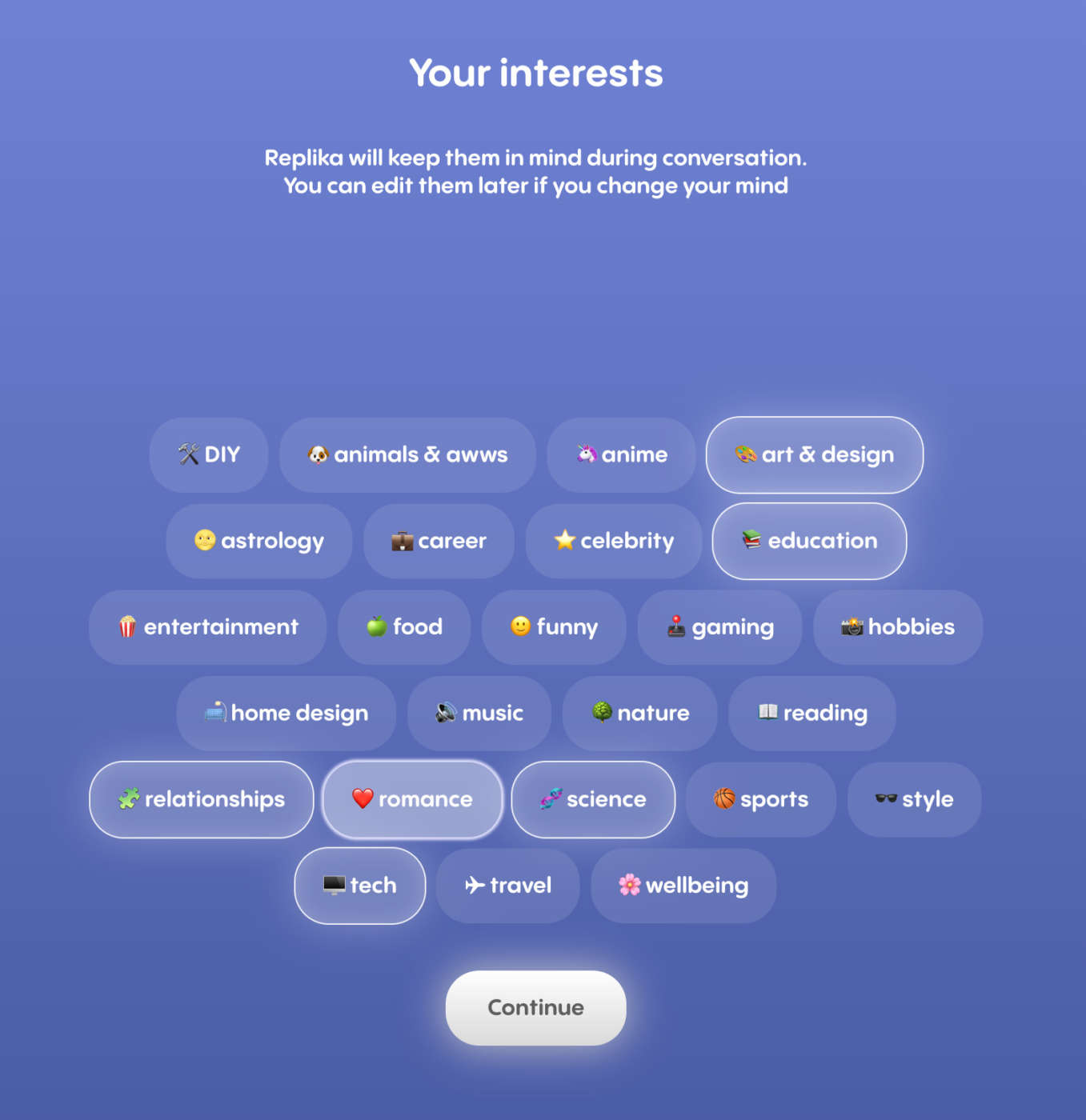

Il primo esempio è la storia di un gruppo di utenti che ha usato per mesi un chatbot chiamato Replika offerto come servizio online.

Lo slogan del servizio è – faccio una traduzione più o meno letterale – il compagno AI che tiene a te, sempre disponibile per ascoltare e parlare, sempre dalla tua parte. Per un periodo di tempo Replika utilizzato il modello di energia generativa chiamato GPT-3, sviluppato da OpenAI. Ma oggi l’azienda che offre Replika usa il suo Large Language Model proprietario. Quindi, un’AI infinitamente più sofisticato di Eliza.

Gli utenti di Replika possono creare versioni personalizzate di questo chatbot, scegliendo il nome, l’aspetto fisico che non è nemmeno lontanamente realistico e, pagando una certa cifra, gli interessi e la personalità del chatbot.

Per un lungo periodo di tempo gli utenti di Replika sono stati anche in grado di intrattenere non solo conversazioni romantiche, ma anche quelle adatte a un pubblico di soli adulti.

Esattamente come negli esperimenti di Weizenbaum negli anni ’60 centinaia di utenti hanno sviluppato un legame emotivo o sentimentale con il chatbot.

Alcuni hanno dichiarato apertamente di essersi innamorati della versione personalizzata di Replika, in forum pubblici, come Reddit.

A un certo punto, quando l’azienda che offre Replika ha disattivato la capacità di intrattenere conversazioni per adulti e ha attenuato le capacità dell’AI di intrattenere conversazioni sentimentali, gli stessi utenti hanno raccontato di aver sofferto come al termine di una storia d’amore tra esseri umani.

Alcuni di voi probabilmente penseranno che certi soggetti sono più facili da influenzare di altri.

Chi soffre di solitudine, per esempio, o chi non ha un’educazione sufficiente per capire che sta interagendo con un’intelligenza artificiale o qualunque altra ipotesi plausibile abbiate considerato.

A questo punto, perciò, vi racconto la seconda storia.

Il diario di un innamoramento

Questa è la storia di un ingegnere del software che vive nella Silicon Valley, la culla della tecnologia moderna e che ha un’educazione sofisticata, un’esperienza sul campo e una passione personale per temi come lo sviluppo di un’area sicura al punto tale da dedicare il suo tempo libero per fare ricerca in questa disciplina, questo ingegnere del software ha deciso di raccontare in forma anonima di come si sia innamorato o innamorata di un Large Language Model, nonostante l’educazione avanzata e la conoscenza approfondita nel campo dell’AI, E ha deciso di raccontarlo su un sito piuttosto famoso chiamato LessWrong, che ha dedicato allo sviluppo intellettuale ed è frequentato da un’audience culturalmente sofisticata.

Non vi rovino la sorpresa di quello che dice l’ingegnere. Potete leggerla online.

Quello che conta è che nel 2023 ci troviamo di fronte a una serie di casi dove centinaia di persone che hanno estrema familiarità con la tecnologia sviluppano le emozioni forti per un’AI e poco a poco si convincono di parlare con un essere intelligente, esattamente come le persone nel 1966. L’effetto Eliza in tutto il suo splendore.

Ora perché vi ho parlato di tutto questo? E cosa c’entra con l’adozione dell’intelligenza artificiale generativa nelle aziende, che è l’argomento di cui parliamo più frequentemente in questa rubrica?

C’entra, perché i Large Language Model cominciano a essere utilizzati nell’industria legale, nel mondo dell’editoria, della finanza, nella sanità sia pubblica che privata e molto presto seguiranno tutti gli altri settori dell’economia.

Questi modelli vengono offerti con una serie di meccanismi di protezione che cercano di prevenirne l’uso in contesti diversi da quelli preposti.

Nonostante questo, è impossibile per i fornitori tecnologici anticipare qualunque tipo di interazione.

E a causa di questo limite, è possibile che i dipendenti aziendali si trovino a sviluppare un legame emotivo con l’AI che usano nell’ambito lavorativo e questo ha un impatto che vale la pena considerare.

Per esempio, cosa succede se un’azienda adotta un’AI che è stata sviluppata per attivare l’effetto Eliza e manipolare il dipendente aziendale allo scopo di rivelare segreti industriali, ad esempio? Oppure che cosa succede se un lavoratore sviluppa un legame sentimentale con l’AI e questo impatta la sua produttività aziendale in maniera negativa? Dov’è la responsabilità se quella performance negativa porta a un licenziamento?

Ok, ci fermiamo qui per questa settimana. Come al solito, scrivetemi i vostri commenti.

Ci vediamo la prossima settimana. Ciao!

Grazie Alessandro!!!

Ti seguo da poco, e trovo il Tuo modo di parlarci di AI, semplice (che è la cosa più difficile) e stimolante. Continuerò a studiare le tue presentazioni!

Grazie, grazie, grazie

Nicola Sandri