“Abbiamo creato GPT-4, l’ultima pietra miliare nello sforzo di OpenAI di scalare il deep learning”: con questa frase, OpenAI annuncia il lancio ufficiale di ChatGPT 4.

GPT-4 è un modello multimodale di grandi dimensioni (accetta input di immagini e testo, emette output di testo) che, pur essendo meno capace degli esseri umani in molti scenari del mondo reale, mostra prestazioni di livello umano in vari benchmark professionali e accademici.

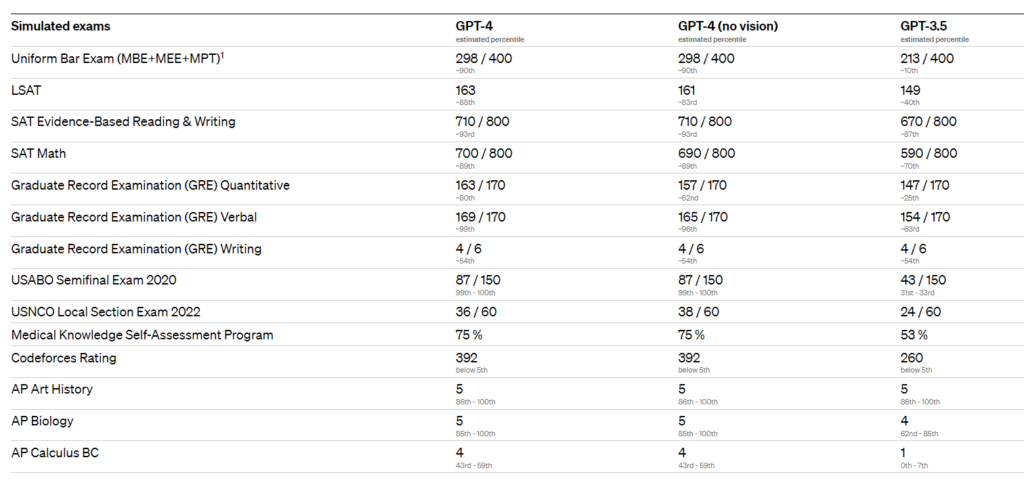

Ad esempio, supera un esame di abilitazione all’esercizio della professione con un punteggio che si aggira intorno al 10% dei migliori partecipanti al test; al contrario, il punteggio di GPT-3.5 si aggirava intorno all’ultimo 10%. “Abbiamo trascorso 6 mesi ad allineare iterativamente il GPT-4 utilizzando le lezioni del nostro programma di test avversariali e di ChatGPT, ottenendo i migliori risultati di sempre” afferma la società.

Le capacità di GPT-4

In una conversazione casuale, la distinzione tra GPT-3.5 e GPT-4 può essere sottile. La differenza emerge quando la complessità del compito raggiunge una soglia sufficiente: GPT-4 è più affidabile, creativo e in grado di gestire istruzioni molto più complesse rispetto al GPT-3.5.

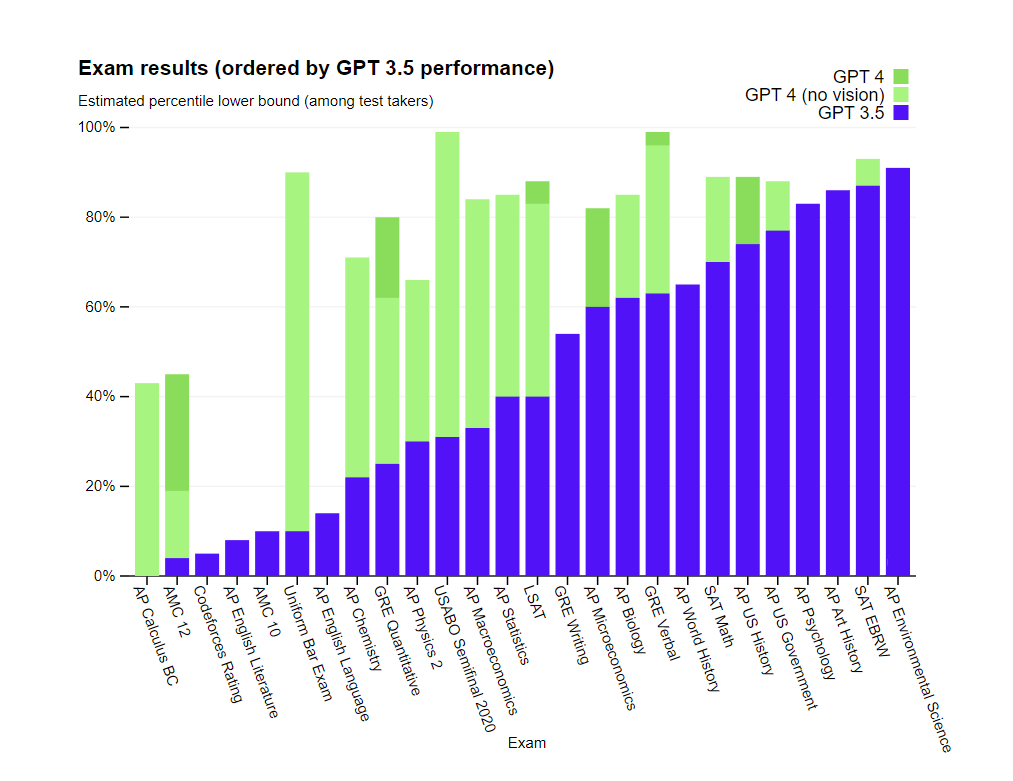

“Per capire la differenza tra i due modelli, abbiamo effettuato dei test su una serie di benchmark, tra cui la simulazione di esami originariamente progettati per gli esseri umani.” OpenAI ha proceduto utilizzando i test più recenti disponibili pubblicamente (nel caso delle Olimpiadi e delle domande a risposta libera AP) o acquistando le edizioni 2022-2023 degli esami pratici. Non è stato fatto alcun training specifico per questi esami.

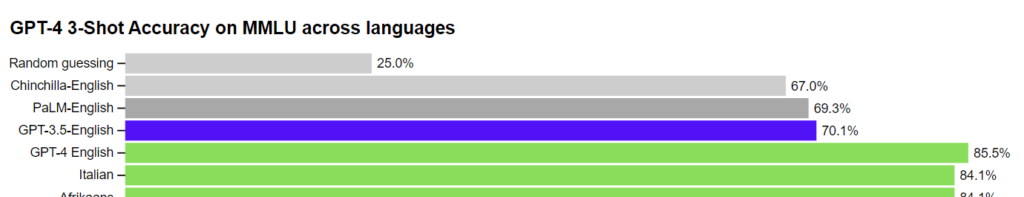

Molti benchmark ML esistenti sono scritti in inglese. “Per avere un’idea iniziale delle capacità in altre lingue, abbiamo tradotto il benchmark MMLU – una suite di 14.000 problemi a scelta multipla che coprono 57 argomenti – in diverse lingue utilizzando Azure Translate”. In 24 delle 26 lingue testate, GPT-4 supera le prestazioni in lingua inglese di GPT-3.5. In particolare, fra le lingue non inglesi, è proprio l’italiano quello ad ottenere le migliori performance, come potete vedere qui sotto:

Input visivi

GPT-4 può accettare un prompt di testo e immagini che, parallelamente all’impostazione di solo testo, consente all’utente di specificare qualsiasi compito visivo o linguistico. In particolare, genera output testuali (linguaggio naturale, codice, ecc.) con input costituiti da testo e immagini intercalati. In una serie di domini, tra cui documenti con testo e fotografie, diagrammi o schermate, GPT-4 mostra capacità simili a quelle degli input di solo testo. Inoltre, può essere potenziato con le tecniche di test-time sviluppate per i modelli linguistici di solo testo, tra cui il prompt di pochi colpi e la catena di pensieri. Gli input di immagini sono ancora un’anteprima di ricerca e non sono disponibili al pubblico.

La flessibilità di GPT-4

“Abbiamo lavorato su ogni aspetto del piano delineato nel nostro post sulla definizione del comportamento delle IA, compresa la guidabilità”, sottolinea OpenAI. Piuttosto che la classica personalità di ChatGPT con una verbosità, un tono e uno stile fissi, gli sviluppatori (e presto anche gli utenti di ChatGPT) possono ora prescrivere lo stile e il compito della loro IA descrivendo tali indicazioni nel messaggio “di sistema”. I messaggi di sistema consentono agli utenti dell’API di personalizzare in modo significativo l’esperienza dei propri utenti entro certi limiti. “Continueremo ad apportare miglioramenti (e in particolare sappiamo che i messaggi di sistema sono il modo più semplice per “rompere” l’attuale modello, vale a dire che l’aderenza ai limiti non è perfetta), ma vi invitiamo a provarlo e a farci sapere cosa ne pensate.”

I limiti attuali della tecnologia di OpenAI

Nonostante le sue capacità, GPT-4 presenta limiti simili a quelli dei modelli GPT precedenti. Soprattutto, non è ancora completamente affidabile (può “inventare” i fatti e commette errori di ragionamento). È necessario prestare molta attenzione quando si utilizzano i risultati dei modelli linguistici, in particolare in contesti ad alto rischio, e il protocollo esatto (come la revisione umana, la messa a terra con un contesto aggiuntivo o l’evitare del tutto gli usi ad alto rischio) deve corrispondere alle esigenze di un caso d’uso specifico.

Pur essendo ancora un problema reale, GPT-4 riduce significativamente le allucinazioni rispetto ai modelli precedenti (che a loro volta sono migliorati a ogni iterazione). GPT-4 ha ottenuto un punteggio superiore del 40% rispetto a GPT-3.5 nelle valutazioni interne.

Il modello può avere diverse distorsioni nei suoi risultati: “abbiamo fatto progressi in questo senso, ma c’è ancora molto da fare”. L’obbiettivo dichiarato di OpenAI è fare in modo che i sistemi di intelligenza artificiale che costruiamo abbiano comportamenti predefiniti ragionevoli che riflettano un’ampia gamma di valori degli utenti, consentendo a questi sistemi di essere personalizzati entro ampi limiti e ottenendo il contributo del pubblico su quali dovrebbero essere questi limiti.

GPT-4 generalmente non conosce gli eventi che si sono verificati dopo che la maggior parte dei suoi dati si è interrotta (settembre 2021) e non impara dalla sua esperienza. A volte può commettere semplici errori di ragionamento che non sembrano compatibili con la competenza in così tanti ambiti, o essere eccessivamente ingenuo nell’accettare dichiarazioni palesemente false da parte di un utente. E a volte può fallire in problemi difficili proprio come fanno gli esseri umani, ad esempio introducendo vulnerabilità di sicurezza nel codice che produce.

GPT-4 può anche sbagliare con sicurezza le sue previsioni, non preoccupandosi di ricontrollare il lavoro quando è probabile che commetta un errore. È interessante notare che il modello di base pre-addestrato è altamente calibrato (la fiducia prevista in una risposta corrisponde generalmente alla probabilità di essere corretta). Tuttavia, grazie al processo di post-training, la calibrazione è stata affinata.

Rischi e mitigazioni

OpenAI ha migliorato GPT-4 per renderlo più sicuro e allineato fin dall’inizio della formazione, con sforzi che comprendono la selezione e il filtraggio dei dati di pre-formazione, le valutazioni e il coinvolgimento di esperti, i miglioramenti alla sicurezza del modello, il monitoraggio e l’applicazione.

GPT-4 presenta rischi simili a quelli dei modelli precedenti, come la generazione di consigli dannosi, codice difettoso o informazioni imprecise. Tuttavia, le capacità aggiuntive di GPT-4 comportano nuove situazioni di rischio.

“Per comprendere l’entità di questi rischi, abbiamo coinvolto oltre 50 esperti di settori quali i rischi di allineamento dell’IA, la sicurezza informatica, il biorischio, la fiducia e la sicurezza e la sicurezza internazionale per testare il modello in modo avverso”, chiarisce la società.

I loro risultati hanno permesso di testare il comportamento del modello in aree ad alto rischio che richiedono competenze specifiche per essere valutate. Il feedback e i dati forniti da questi esperti hanno contribuito a mitigare e migliorare il modello; ad esempio, Sono stati raccolti ulteriori dati per migliorare la capacità del GPT-4 di rifiutare richieste su come sintetizzare sostanze chimiche pericolose.

GPT-4 incorpora un ulteriore segnale di ricompensa per la sicurezza durante l’addestramento RLHF per ridurre gli output dannosi (come definito dalle linee guida d’uso) addestrando il modello a rifiutare le richieste di tali contenuti.

Le mitigazioni hanno migliorato significativamente molte delle proprietà di sicurezza di GPT-4 rispetto a GPT-3.5. “Abbiamo diminuito la tendenza del modello a rispondere alle richieste di contenuti non consentiti dell’82% rispetto a GPT-3.5, e GPT-4 risponde alle richieste sensibili (ad esempio, consigli medici e autolesionismo) in conformità con le nostre politiche il 29% in più”, dichiara con orgoglio OpenAI

ChatGPT Plus

Gli abbonati a ChatGPT Plus avranno accesso a GPT-4 su chat.openai.com con un limite di utilizzo. “Modificheremo l’esatto limite di utilizzo in base alla domanda e alle prestazioni del sistema, ma prevediamo di essere fortemente limitati nella capacità (anche se scaleremo e ottimizzeremo nei prossimi mesi).”

A seconda dei modelli di traffico osservati, OpenAI potrà introdurre un nuovo livello di abbonamento per l’utilizzo di GPT-4 con un volume più elevato; la società si augura anche di offrire un certo numero di query GPT-4 gratuite in modo che anche chi non ha un abbonamento possa provarlo.

API

Per ottenere l’accesso all’API GPT-4 (che utilizza la stessa API ChatCompletions di GPT-3.5-turbo), OpenAI invita ad iscriversi alla lista d’attesa.” Inizieremo a invitare alcuni sviluppatori già da oggi e aumenteremo gradualmente per bilanciare la capacità con la domanda. Se sei un ricercatore che studia l’impatto sociale dell’IA o i problemi di allineamento dell’IA, puoi anche richiedere un accesso sovvenzionato tramite il nostro Researcher Access Program“.

Una volta ottenuto l’accesso, è possibile effettuare richieste di solo testo al modello GPT-4 (gli input di immagini sono ancora in alfa limitata), che aggiorneremo automaticamente al nostro modello stabile raccomandato man mano che ne realizzeremo nuove versioni (è possibile bloccare la versione corrente chiamando il numero gpt-4-0314, che sarà supportato fino al 14 giugno). Il prezzo è di 0,03 dollari per 1.000 gettoni di richiesta e 0,06 dollari per 1.000 gettoni di completamento. I limiti di velocità predefiniti sono 40k token al minuto e 200 richieste al minuto.

“GPT-4 ha una lunghezza di contesto di 8.192 token. Forniamo anche un accesso limitato alla nostra versione da 32.768 contesti (circa 50 pagine di testo), gpt-4-32k, che sarà aggiornata automaticamente nel tempo (la versione attuale gpt-4-32k-0314, anch’essa supportata fino al 14 giugno). Il prezzo è di 0,06 dollari per 1K prompt token e 0,12 dollari per 1k completion token. Stiamo ancora migliorando la qualità del modello per i contesti lunghi e ci piacerebbe ricevere un feedback su come si comporta nel vostro caso d’uso. Stiamo elaborando le richieste per i motori da 8K e 32K a ritmi diversi in base alla capacità, quindi potreste ricevere l’accesso a questi motori in momenti diversi.”