Come afferma NVIDIA sul proprio blog RTX AI Garage, i modelli linguistici di grandi dimensioni (LLM), addestrati su dataset composti da miliardi di token, sono in grado di generare contenuti di alta qualità e rappresentano il motore di molte delle applicazioni AI più diffuse, come chatbot, assistenti virtuali, generatori di codice e strumenti di analisi: uno dei modi più accessibili oggi per utilizzare gli LLM in locale è AnythingLLM.

AnythingLLM è un’app desktop pensata per gli appassionati di AI che cercano un assistente intelligente completo, incentrato sulla privacy e interamente eseguibile sul proprio PC. Con il nuovo supporto ai microservizi NVIDIA NIM su GPU NVIDIA GeForce RTX e NVIDIA RTX PRO, AnythingLLM offre ora prestazioni ancora più elevate, rendendo i flussi di lavoro AI locali più rapidi e reattivi.

AnythingLLM – spiega NVIDIA – è una piattaforma AI all-in-one che permette di eseguire modelli linguistici localmente, sfruttare sistemi di generazione aumentata dal recupero (RAG) e strumenti agentici, fungendo da ponte tra gli LLM preferiti dall’utente e i suoi dati personali.

Tra le principali funzionalità offerte:

- Risposte alle domande: ottenere risposte da modelli come Llama e DeepSeek R1, senza costi di utilizzo.

- Query sui propri dati: interrogare in modo privato file PDF, documenti Word, repository di codice e altri contenuti grazie al sistema RAG.

- Sintesi di documenti: generare sintesi di documenti lunghi, come articoli accademici.

- Analisi dei dati: caricare file, estrarre insight e interagire con i dati tramite LLM.

- Azioni agentiche: utilizzare tool generativi, automatizzare azioni basate sui prompt e fare ricerche dinamiche su risorse locali o online.

AnythingLLM supporta numerosi modelli open source locali e può anche connettersi a LLM cloud-based di fornitori come OpenAI, Microsoft e Anthropic. Inoltre, grazie al suo hub della community, è possibile espandere le funzionalità con skill aggiuntive per attività agentiche avanzate.

L’app può essere installata con un solo clic e funziona sia come programma standalone che come estensione del browser, offrendo un’interfaccia intuitiva, senza configurazioni complesse. È ideale per gli utenti GeForce RTX e NVIDIA RTX PRO che vogliono sfruttare appieno le capacità della propria GPU.

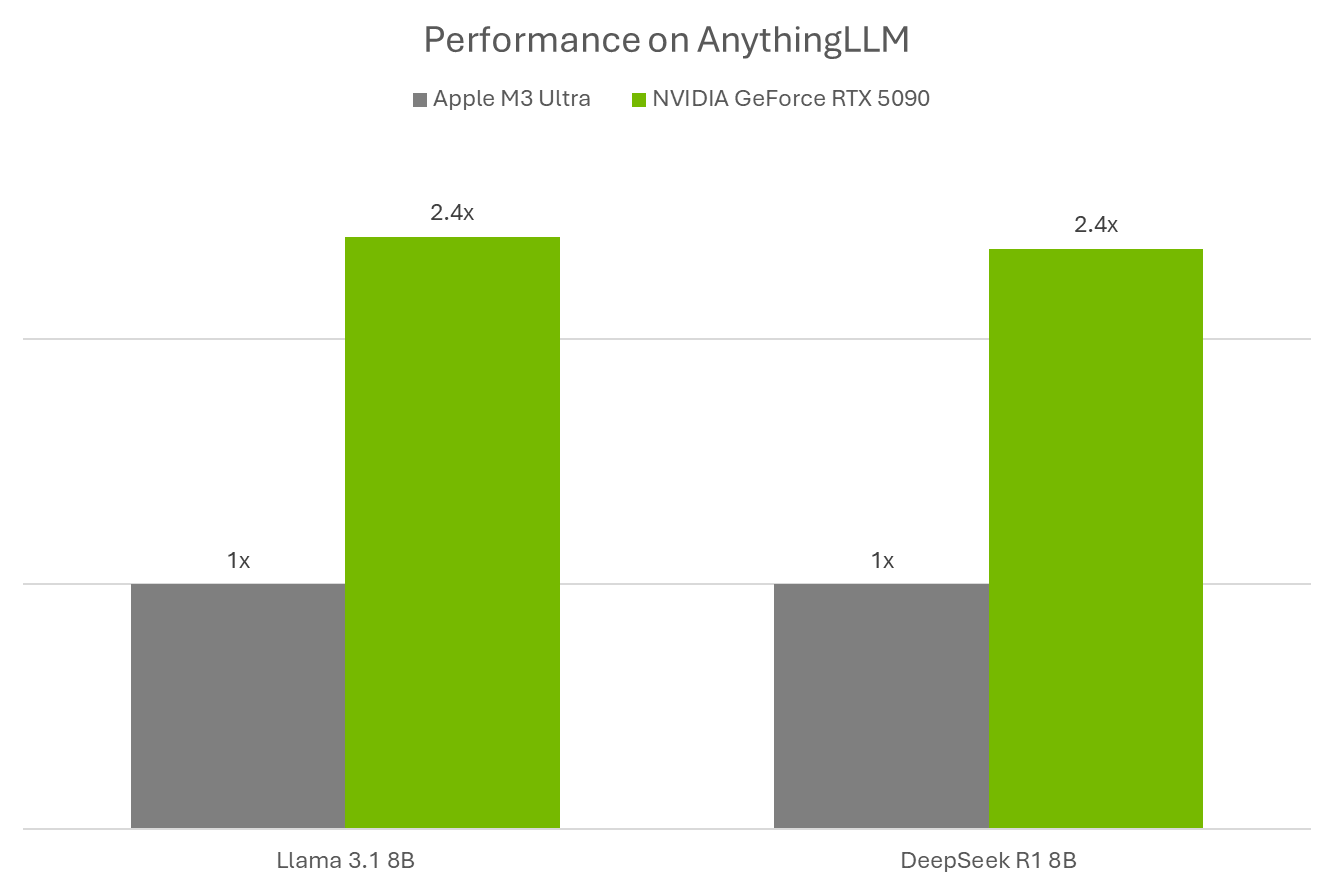

Le GPU GeForce RTX e NVIDIA RTX PRO garantiscono prestazioni eccellenti nell’esecuzione di LLM e agenti AI all’interno di AnythingLLM, sottolinea NVIDIA, che aggiunge: grazie ai Tensor Core, progettati per accelerare i carichi di lavoro AI, l’inferenza è molto più veloce rispetto a soluzioni CPU o non ottimizzate.

AnythingLLM sfrutta Ollama per gestire l’esecuzione locale dei modelli, utilizzando Llama.cpp e le librerie ggml tensor per il machine learning. Queste tecnologie sono ottimizzate per le GPU NVIDIA RTX e i Tensor Core di quinta generazione, offrendo un notevole vantaggio prestazionale: su una GeForce RTX 5090, afferma NVIDIA, le performance sono 2,4 volte superiori rispetto a un Apple M3 Ultra.

AnythingLLM, ora con supporto a NVIDIA NIM

Con l’introduzione di nuovi microservizi NVIDIA NIM e flussi di lavoro di riferimento, come la sempre più ampia libreria di AI Blueprints, tool come AnythingLLM sono pronti ad abilitare un numero crescente di applicazioni legate all’intelligenza artificiale multimodale.

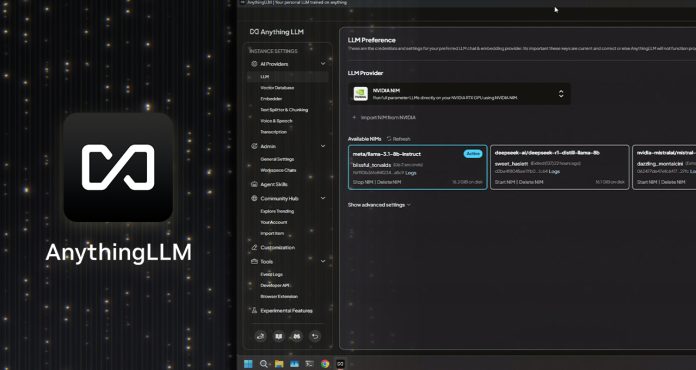

AnythingLLM ha recentemente integrato il supporto per i microservizi NVIDIA NIM, modelli di AI generativa preconfigurati e ottimizzati per massime prestazioni, pensati per semplificare l’avvio dei flussi di lavoro AI su PC con GPU RTX AI, grazie a un’API semplice e immediata.

I NIM offrono una soluzione ideale per sviluppatori e creator che vogliono testare rapidamente modelli di AI generativa all’interno di un flusso di lavoro. Invece di dover cercare il modello corretto, scaricare file e configurare manualmente l’ambiente, i NIM forniscono tutto il necessario all’interno di un unico contenitore eseguibile, pronto all’uso. Possono funzionare sia in locale che su cloud, agevolando la prototipazione sul proprio PC e la successiva distribuzione in ambienti cloud-based.

Grazie all’interfaccia user-friendly di AnythingLLM, gli utenti possono esplorare i NIM in pochi passaggi, testarli rapidamente e integrarli nei propri flussi di lavoro. In alternativa, possono collegarli ad applicazioni personalizzate utilizzando gli AI Blueprints di NVIDIA e il materiale fornito (documentazione, codice d’esempio e guide pratiche) per sviluppi su misura.

Sono disponibili NIM per una vasta gamma di funzionalità AI, tra cui generazione di testo e immagini, visione artificiale, riconoscimento vocale e altro ancora, offrendo infinite possibilità per potenziare i flussi di lavoro creativi, produttivi e interattivi.