Come afferma Mistral AI, nell’ultimo anno gli assistenti AI per il coding hanno introdotto potenti funzionalità, come il ragionamento multi-file, i suggerimenti contestuali e gli agenti in linguaggio naturale, tutte direttamente all’interno dell’IDE. Nonostante questi miglioramenti, tuttavia, l’adozione all’interno degli ambienti aziendali è stata lenta. Le ragioni – secondo lo specialista dell’AI – hanno meno a che fare con le prestazioni del modello o l’interfaccia, e più con il modo in cui questi strumenti sono costruiti, implementati e governati.

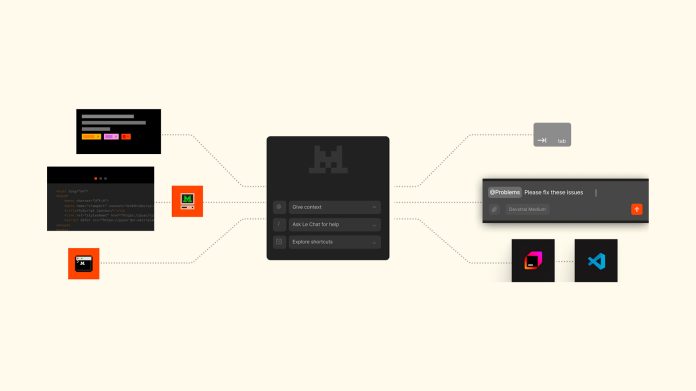

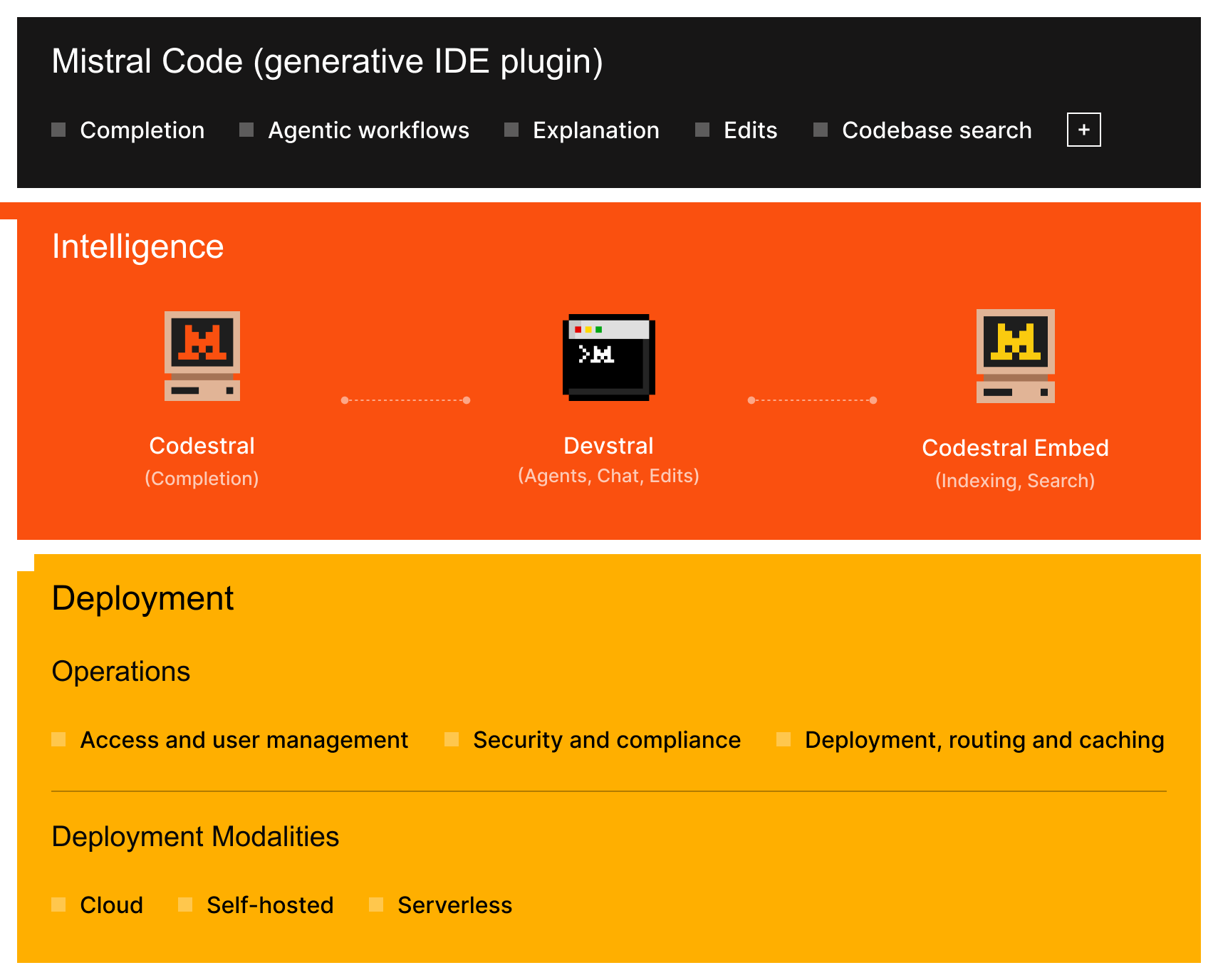

L’approccio al coding enteprise di Mistral AI, spiega l’azienda, non è un insieme di strumenti isolati, ma piuttosto un sistema integrato progettato per supportare lo sviluppo di software di livello aziendale in ogni fase, dai suggerimenti di codice alle pull request autonome.

Alla base dello stack c’è Codestral, la famiglia di modelli di generazione di codice di Mistral, creata appositamente per il completamento FIM (fill-in-the-middle) ad alta precisione. Questi modelli sono ottimizzati per gli ambienti di production engineering: sensibili alla latenza, consapevoli del contesto e autoinstallabili.

Ora l’azienda ha annunciato annunciamo l’ultimo aggiornamento: Codestral 25.08 secondo Mistral offre miglioramenti misurabili rispetto alle versioni precedenti:

- +30% di completamenti accettati

- +10% di codice conservato dopo il suggerimento

- 50% in meno di generazioni incontrollate, migliorando la fiducia nelle modifiche più lunghe

- Prestazioni migliorate nei benchmark accademici per il completamento FIM a contesto breve e lungo

Questi miglioramenti – sottolinea Mistral – sono stati convalidati nell’uso live dell’IDE su basi di codice di produzione. Il modello supporta un’ampia gamma di linguaggi e attività ed è implementabile su cloud, VPC o ambienti on-premise, senza necessità di modifiche architetturali. Inoltre, Codestral-2508 apporta anche miglioramenti alla modalità chat.

Il completamento automatico è più veloce, ma solo se il modello comprende il codice, evidenzia Mistral, che afferma: Codestral Embed fissa un nuovo standard in questo campo. Progettato apposta per il codice invece che per il testo in generale, secondo Mistral fa meglio dei modelli embedding di OpenAI e Cohere nei test di recupero del codice nel mondo reale.

Il completamento automatico è più veloce, ma solo se il modello comprende il codice, evidenzia Mistral, che afferma: Codestral Embed fissa un nuovo standard in questo campo. Progettato apposta per il codice invece che per il testo in generale, secondo Mistral fa meglio dei modelli embedding di OpenAI e Cohere nei test di recupero del codice nel mondo reale.

I vantaggi principali includono:

- Ricerca ad alto richiamo e bassa latenza su monorepos e poly-repos di grandi dimensioni. Gli sviluppatori possono trovare logica interna, routine di convalida o utilità specifiche del dominio utilizzando il linguaggio naturale.

- Output di embedding flessibili, con dimensioni configurabili (ad esempio, 256 dimensioni, INT8) che bilanciano la qualità del recupero con l’efficienza di archiviazione, superando le alternative anche a dimensionalità inferiori.

- Implementazione privata per il massimo controllo, garantendo l’assenza di fughe di dati tramite API di terze parti. Tutte le inferenze di embedding e l’archiviazione degli indici possono essere eseguite all’interno dell’infrastruttura aziendale.

Questo livello di embedding funge sia da base contestuale per i flussi di lavoro agentici sia da motore di recupero che alimenta le funzionalità di ricerca del codice nell’IDE, senza sacrificare la privacy, le prestazioni o la precisione.

Una volta individuato il contesto pertinente, l’IA può intraprendere azioni significative. Devstral, basato sullo lo scaffold per agenti OpenHands, abilita flussi di lavoro di coding agentici pronti per l’uso aziendale. È stato progettato specificamente per attività di ingegneria (rifattorizzazione tra file, generazione di test e authoring PR) utilizzando un ragionamento strutturato e ricco di contesto.

Fornire l’automazione agenziale all’interno dell’infrastruttura privata consente alle organizzazioni di ingegneria di ridurre gli attriti, garantire la conformità e accelerare la consegna con flussi di lavoro AI ripetibili e verificabili.

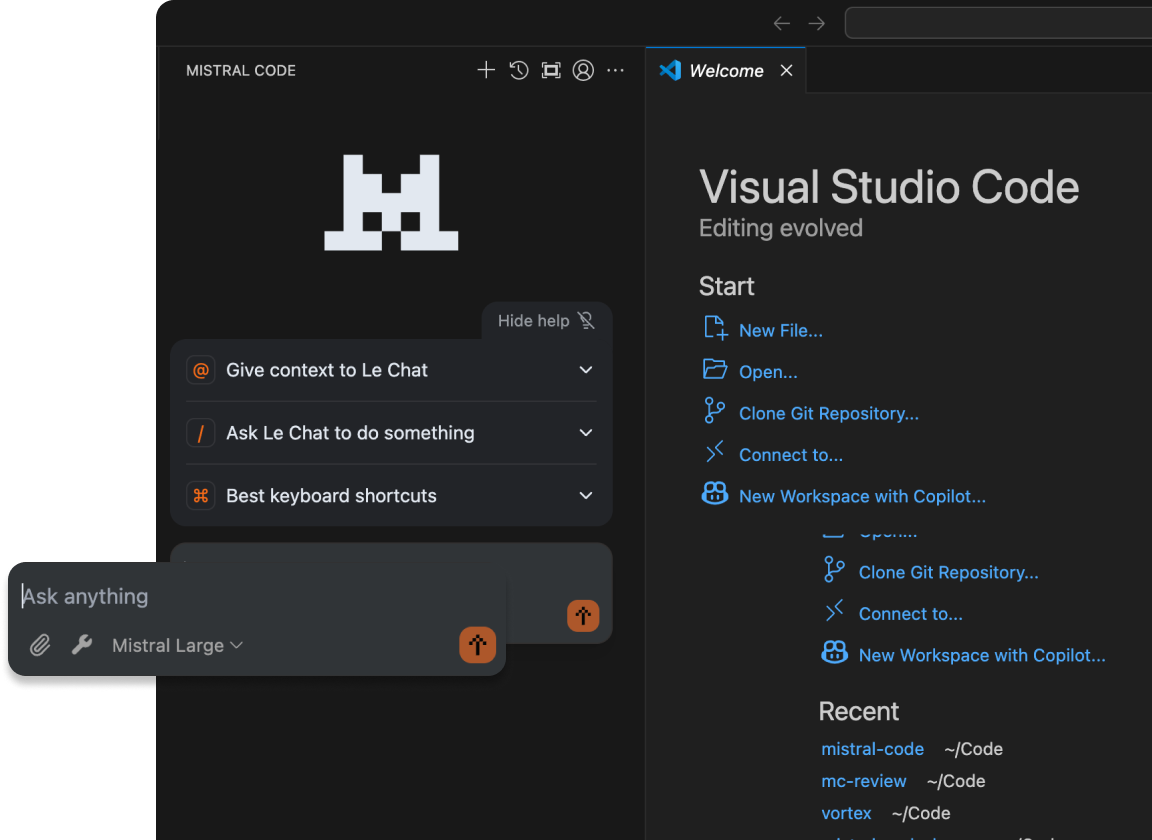

Tutte le funzionalità dello stack Mistral (completamento, ricerca semantica e flussi di lavoro agentici) sono disponibili tramite Mistral Code, un plugin nativo per JetBrains e VS Code.

Tutte le funzionalità dello stack Mistral (completamento, ricerca semantica e flussi di lavoro agentici) sono disponibili tramite Mistral Code, un plugin nativo per JetBrains e VS Code.

Questo fornisce:

- Completamenti in linea utilizzando Codestral 25.08, ottimizzati per FIM e editing multi-righe.

- Automazioni delle attività con un solo clic come “Scrivi messaggio di commit”, “Correggi funzione” o “Aggiungi stringa di documentazione”, basate su Devstral.

- Consapevolezza del contesto basata su Git diff, cronologia del terminale e strumenti di analisi statica

- Ricerca semantica integrata, supportata da Codestral Embed

Mistral Code è progettato per supportare i requisiti di implementazione enterprise:

- Deployment in qualsiasi ambiente: cloud, VPC autogestito o completamente on-premise (GA nel terzo trimestre)

- Nessuna telemetria obbligatoria e nessuna chiamata API esterna per inferenza o ricerca

- SSO, audit logging e controlli di utilizzo per un’adozione sicura e conforme alle policy

- Osservabilità dell’utilizzo tramite la Mistral Console, incluse metriche sul codice generato dall’IA, accettazione dei suggerimenti e utilizzo degli agenti

Queste funzionalità offrono ai team engineering, piattaforma e sicurezza la possibilità di implementare strumenti di IA in modo sicuro, incrementale e con piena visibilità, sottolinea Mistral AI.

Lo stack di sviluppo completo Mistral, composto da Codestral 25.08, Devstral, Codestral Embed e l’estensione Mistral Code IDE, è ora disponibile per l’implementazione enterprise.

I team possono iniziare con il completamento automatico e la ricerca semantica, per poi passare ai flussi di lavoro agentici e alle implementazioni private secondo i propri ritmi.

Per iniziare, spiega Mistral, è possibile installare Mistral Code dal marketplace di JetBrains o VS Code; poi connettersi alla modalità di deployment preferita (cloud, VPC o on-prem).

Maggiori informazioni sul coding stack di Mistral AI sono disponibili nel blog ufficiale dell’azienda.