Ciao a tutti, sono Vincenzo Lomonaco ricercatore e docente all’Università di Pisa.

Nella puntata di oggi vorrei parlarvi del nuovo recentissimo modello di AI rilasciato la scorsa settimana da OpenAI.

Parliamo di OpenAi o3-mini, di che cosa si tratta e perché può essere considerato come una risposta immediata di OpenAI al recente dibattutissimo rilascio di DeepSeek-R1 Scopriamolo insieme in questa puntata di Le Voci dell’AI.

OpenAI ha recentemente lanciato o3-mini, il modello più efficiente della sua serie dedicata al ragionamento.

Disponibile sia su ChatGPT sia tramite le sue API o interfacce di programmazione, questo modello è stato ottimizzato per compiti di ragionamento complesso, quindi di programmazione matematica e scienze, offrendo prestazioni superiori rispetto ai modelli precedenti della serie o1, con tempi di risposta paragonabili a quelli di 01-mini.

Il rilascio di o3-mini può essere interpretato come una risposta diretta all’emergere di DeepSeek-R1, l’assistente AI di ragionamento sviluppato da una start-up tecnologica cinese che ha sconvolto l’industria tecnologica grazie alla sua potenza, capacità e convenienza economica.

Come abbiamo discusso nella puntata precedente di Le Voci dell’AI, DeepSeek-R1, con un costo di sviluppo di circa 6 milioni di dollari, ha dimostrato che modelli ad alte prestazioni non richiedono necessariamente investimenti massicci, sfidando così i giganti tecnologici statunitensi.

In questo contesto competitivo, o3-mini rappresenta quindi la risposta diretta di OpenAI che il 31 gennaio lo ha ufficialmente rilasciato, offrendo un modello più potente ed economico rispetto a qualsiasi suo modello pubblicato in passato.

E questa rapida evoluzione nel campo dell’intelligenza artificiale evidenzia ancora una volta la necessità per le aziende in questo settore di adattarsi rapidamente ai progressi tecnologici per mantenere la loro competitività.

Tra le caratteristiche più interessanti di OpenAI o3-mini vi sono l’avanzato supporto per il Function Calling – chiamata di funzioni terze, gli structured outputs – output di risposte strutturate e i developer messages – messaggi degli sviluppatori per migliorare il comportamento del sistema che lo rendono, se vogliamo, molto più pronto per l’uso in produzione fin dal primo momento.

Non solo: o3 anche rende visualizzabile per la prima volta la Chain of Thoughts, ossia la catena dei pensieri o il ragionamento sostanzialmente che lo ha condotto a una particolare risposta.

Questo significa che le aziende possono integrare o3-mini direttamente nelle loro applicazioni senza dover sviluppare infrastrutture personalizzate per interpretare le risposte non strutturate o gestire l’interfaccia con altre componenti software.

Questa prontezza operativa rappresenta un netto vantaggio rispetto a DeepSeek-R1 che, pur essendo open source e altamente flessibile, richiede configurazione, hosting, quindi l’utilizzo di piattaforme cloud e ottimizzazione da parte degli sviluppatori.

Nel futuro prossimo è probabile che molte aziende e sviluppatori indipendenti scelgano di auto ospitare il modello DeepSeek-R1 nelle loro infrastrutture hardware per personalizzarlo secondo le proprie esigenze, ma ciò comporta sicuramente costi e complessità che o3-mini elimina grazie alla sua architettura già pronta per l’ambiente di produzione.

Questo approccio riduce il tempo di implementazione e permette alle imprese di concentrarsi sulla creazione di valore piuttosto che sulla gestione vera e propria del modello di intelligenza artificiale.

Quindi, in un panorama in cui la velocità di integrazione è cruciale, OpenAI si posiziona come fornitore di soluzioni ai immediatamente operative usabili, differenziandosi dalle alternative open source e self hosted che, sebbene promettenti, richiedono un notevole sforzo tecnico per essere competitive a livello aziendale e operazionale.

Ma soffermiamoci un attimo sulla funzionalità di Function Calling offerta da OpenAI o3-mini, che a mio modo di vedere costituisce una delle innovazioni più eccitanti in questo contesto, soprattutto relativo alla interoperabilità di queste soluzioni.

Essa consente al modello di riconoscere intenzioni strutturate nelle richieste degli utenti e di interagire con funzioni definite dagli sviluppatori per ottenere risposte più precise.

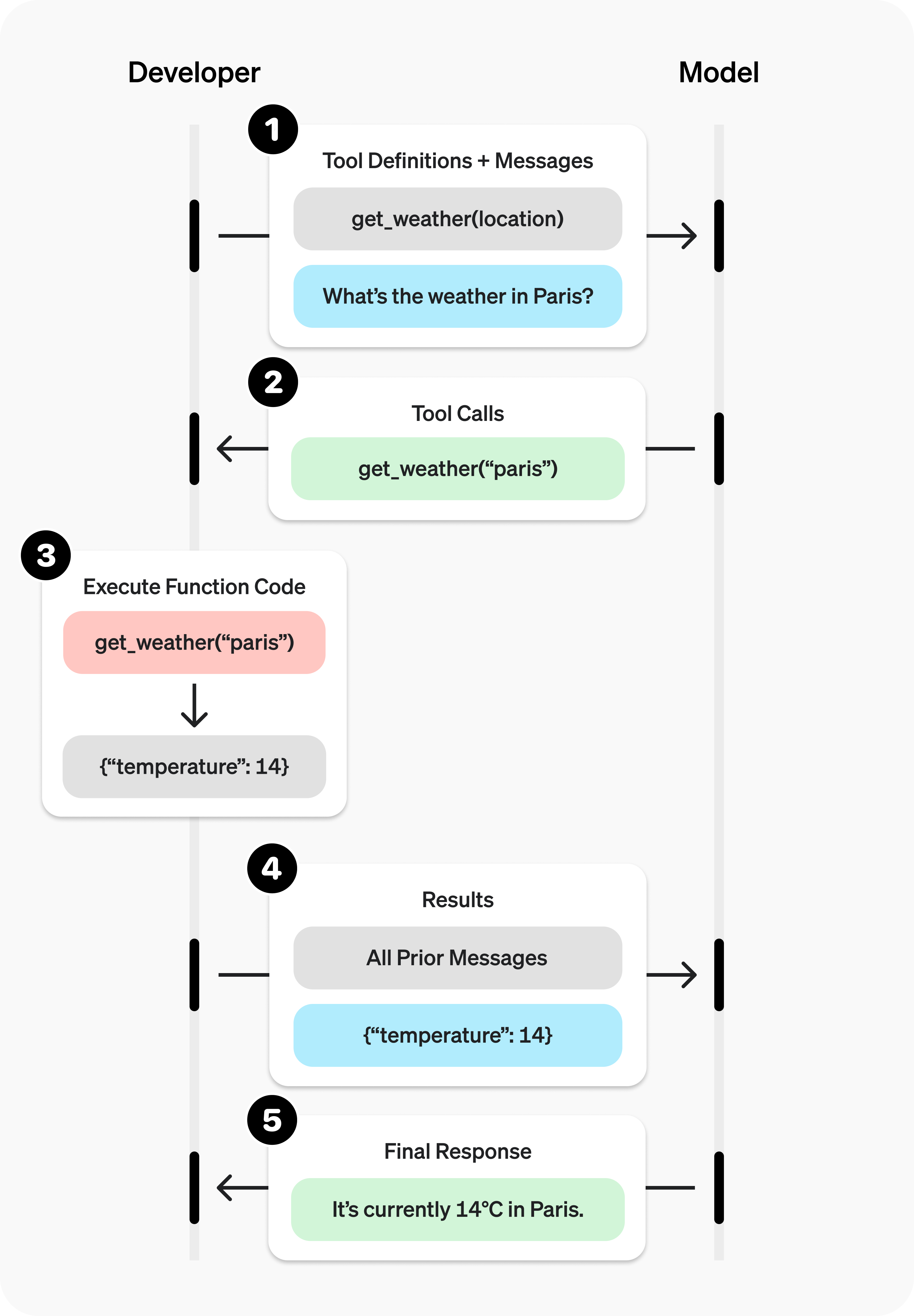

Quindi, come mostrato in questa immagine, il processo inizia con il modello che interpreta un messaggio dell’utente in linguaggio naturale, ad esempio, ”qual è il tempo a Parigi?” e abbina questa richiesta ad una funzione predefinita come get_weather, data una location.

Successivamente, il modello genera una chiamata di funzione specifica, ad esempio, get_weather(“Paris”) come input.

Questa chiamata viene inviata al codice in backend, quindi un software con una funzione già implementata che la esegue e restituisce un risultato strutturato, in questo caso un oggetto in formato Json con il dato {“temperature”: 14}.

Il modello infine, utilizza il risultato per costruire una risposta finale che combina il contesto della conversazione con i dati ricevuti, restituendo all’utente una frase chiara sempre in linguaggio naturale: “Attualmente a Parigi ci sono 14 gradi Celsius”.

Questa funzionalità è particolarmente utile perché consente di integrare il modello di interazione in linguaggio naturale con sistemi esterni come database ed API di altre componenti, software proprietario, funzioni personalizzate, rendendo le risposte più accurate e affidabili.

In un contesto aziendale il Function Call quindi accelera lo sviluppo di applicazioni complesse, riducendo gli errori e migliorando la qualità delle interazioni automatizzate, semplificando allo stesso tempo l’implementazione del tutto per gli sviluppatori.

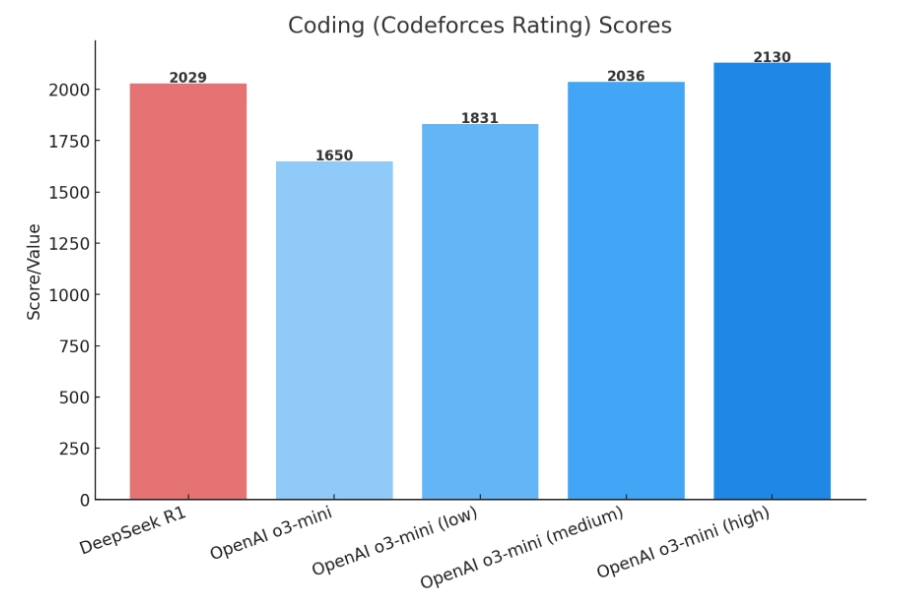

In questa immagine, invece, vediamo il confronto tra le performance di DeepSeek-R1 con OpenAI o3-mini in termini di punteggio di programmazione automatica utilizzando un sistema di valutazione basato sul rating di CodeForces.

Per ulteriori informazioni circa le capacità di o3-mini vi invito a consultare la documentazione ufficiale di OpenAI che lo ha testato in molti altri contesti, dimostrando migliorie analoghe.

Vediamo che in questo caso di DeepSeek-R1 raggiunge un punteggio di 2029 posizionandosi come una soluzione robusta in questo contesto, mentre OpenAI o3-mini mostra una maggiore flessibilità con tre livelli di configurazione basso, medio e alto.

Questa capacità di adattamento permette a o3-mini di bilanciare prestazioni, costi e velocità di risposta in base alle esigenze dell’utente o del caso d’uso specifico.

Quindi, quando si punta all’efficienza o3-mini nelle configurazioni più basse, offra una soluzione economica e veloce ma con prestazioni inferiori a quelle di R1, ma delle configurazioni medie e alte o3-mini supera R1, dimostrando di essere la scelta ideale quando le performance hanno la priorità rispetto ai costi o al tempo di elaborazione.

Questo livello di personalizzazione rende o3-mini particolarmente utile in scenari di produzione, ancora una volta, dove possono variare i vincoli di budget o le richieste di qualità delle risposte.

Al contrario DeepSeek-R1, pur essendo open source e performante, non dispone di questa flessibilità integrata, richiedendo agli sviluppatori di ottimizzare manualmente per specifici scenari d’uso.

In sintesi, o30-mini si distingue per la sua capacità di adattarsi, quindi la sua flessibilità, mantenendo costi paragonabili a R1 ed essendo circa 15 volte più economico e 5 volte più veloce di OpenAI o1, che abbiamo descritto in una precedente puntata, l’episodio 68, di Le Voci dell’AI.

In questa puntata abbiamo discusso di OpenAI o3-mini, un modello generativo specializzato nel ragionamento complesso. Un tema piuttosto caldo nel mondo dell’intelligenza artificiale d’oggi.

Questo modello, rilasciato così tempestivamente da OpenAI molto probabilmente per contrastare l’avanzata di DeepSeek, risulta essere estremamente competitivo con DeepSeek-R1, essendo molto economico e veloce, ma soprattutto rendendosi molto usabile e robusto in contesti applicativi e commerciali reali.

Che sia un avanzamento nel contesto di modelli aperti come DeepSeek-R1 o un avanzamento in termini di modelli production ready come o3-mini, nel futuro non possiamo che aspettarci una più che significativa espansione del mercato delle api generativa e la sua applicazione pervasiva in ogni ambito della nostra infosfera.

Ciao! Alla prossima puntata di Le Voci dell’AI!