Nel campo della tecnologia, ma probabilmente non solo, il 2020 è stato indicato da più parti come l’anno dell’intelligenza artificiale. Dopo anni di studi infatti, il nuovo approccio alla realizzazione e applicazione di software è pronto a cambiare le regole del gioco in diversi campi.

Di questo si è voluta occupare CB Insights, analizzando i principali possibili campi di applicazione dell’intelligenza artificiale e le relative implicazioni. Dalla necessità di trattare e gestire quantitativi di dati decisamente maggiori, alle questioni legate alla privacy.

Dai risvolti più concreti pronti a modificare abitudini quotidiane, alle applicazioni per buona parte ancora da scoprire, sono diversi gli scenari intriganti. Così come i rischi legati a una tecnologia di cui si fatica tenere il pieno controllo.

Deepfake, arma a doppio taglio

Non a caso, uno degli argomenti più comuni quando si parla di intelligenza artificiale è il deepfake. La capacità di simulare comportamenti umani, sia visivi sia vocali, in modo decisamente realistico, ha diverse implicazioni.

Nel caso migliore, si tratta semplicemente di nuovi strumenti al servizio di settori come il cinema e della televisione. Per esempio, per affiancare un attore del passato a uno recente. Il tutto, riducendo anche la presenza sul set degli attori e spostando buona parte delle produzioni negli studi dotati di risorse di calcolo adeguate.

Oppure, per realizzare produzioni televisive con una nuova generazione di grafiche particolarmente realistiche. In pratica, simulando un comportamento umano basandosi solamente su dati acquisiti in precedenza e opportunamente elaborati con reti neurali e algoritmi di machine learning.

Proprio da questo però, nascono anche i problemi. Senza andare molto lontano, diventa possibile creare dei veri e propri cloni delle persone. Restando in argomento, costruire scene totalmente inventate di un personaggio conosciuto, per attribuire gesti o affermazioni a uso e consumo di potenziali rivali o detrattori.

Nel caso peggiore, si arriva invece alle vere e proprie truffe. Hanno ormai già fatto storia i casi di ordini di importanti operazioni finanziarie dettati per telefono o anche per videoconferenza da deepfake, con livelli di precisione abbastanza alti da convincere i malcapitati di turno a procedere.

Attacco all’antivirus

Di fronte a situazioni del genere il mondo della sicurezza IT non sta certamente a guardare. La complessità della sfida e la mancanza di riferimenti con il passato, la rendono tuttavia particolarmente impegnativa.

Le soluzioni, a partire dagli antivirus, in grado di analizzare i sistemi di intelligenza artificiale non mancano. Tuttavia, la relativa poca esperienza al riguardo al momento favorisce il lavoro degli hacker. Le possibilità di superare le protezioni con accesso agli enormi archivi necessari al machine learning e alle reti neurali sono già stati dimostrate.

All’orizzonte però, si affacciano anche nuovi tipi di minacce. Proprio l’importanza dei dati come vero e proprio carburante per tutto quanto ruota intorno all’intelligenza artificiale, li rende oggetto di attacco diretto. In questo caso, non tanto per rubarli, quanto invece per modificarli, falsando quindi l’intera catena dei processi. Oppure, più semplicemente per camuffare un codice malevolo in dato all’apparenza perfettamente sicuro.

Punto di ingresso ancora elevato

In ogni caso, c’è un aspetto fondamentale da considerare, l’accesso alla tecnologia. Trasformare l’intelligenza artificiale da curiosità o promessa a strumento di lavoro richiede risorse importanti, e non solo di calcolo. Anche in termini economici, il livello attuale dell’investimento richiesto resta alto.

Una situazione destinata però a cambiare. Messa a punto da Google, AutoML è infatti una suite di strumenti dedicati, in grado di supportare a partire dalla progettazione, la realizzazione e la fase di apprendimento di una rete neurale, fondamentale per un sistema di IA.

Abbordabile soprattutto dal punto di vista delle competenze, AutoML permette infatti di cimentarsi con la materia anche senza dover necessariamente contare su competenze ai massimi livelli. In pratica, si può inquadrare come una sorta di libreria di architetture disponibili, tra le quali individuare la più adatta al singolo progetto ed evitare così di doverne progettare una nuova partendo da zero.

Nella sua scia, sono inoltre già diverse le startup pronte a sviluppare dei plugin in grado di aumentare il livello di personalizzazione dell’applicazione e quindi la sua utilità.

Come dividersi i compiti con il federated learning

Anche agevolando l’accesso alla tecnologia intelligenza artificiale, rimane però un altro problema non secondario, la gestione dei dati. In tutti i sensi, sia per quanto riguarda qualità, disponibilità e relativa elaborazione sia per le delicate implicazioni sulla privacy.

Anche in questo caso, un’indicazione interessante arriva da Google, tra i principali sostenitori del federated learning. Per intendersi, la stessa soluzione utilizzata per prevedere l’inserimento del testo nella tastiera Android o la ricerca in un browser. In questo caso, tecnologia già sfruttata anche da Firefox.

Per il machine learning servono ingenti quantità di dati. Tante aziende ne hanno a volontà, ma spesso non sono sufficienti o non abbastanza di qualità. Da qui, la prospettiva di organizzarsi meglio per suddividersi gli oneri del calcolo.

D’altra parte, si presenta la necessità di tutelare la privacy degli utenti. Molti di questi dati infatti, sono riservati o risiedono fisicamente sui dispositivi. Proprio qui interviene il nuovo approccio.

I dati restano saldamente conservati sul dispositivo utente. Viene invece trasferito dal cloud l’algoritmo di intelligenza artificiale. Il calcolo viene quindi effettuato localmente e i relativi aggiornamenti rimandati al server, in modo anonimo.

In pratica, i dati comportamentali verranno separati dai profili personali, contribuendo comunque allo sviluppo delle reti neurali, ma senza riferimenti diretti a chi li ha prodotti. A ulteriore tutela, l’invio dell’algoritmo di calcolo non è indiscriminato, in ogni occasione viene infatti trasmesso a un numero casuale di account.

In questo modo, cresce anche il valore delle partnership. Oltre alla quantità di dati, è fondamentale la diversità. Diventa quindi importante condividere le informazioni raccolte tra settori e aree geografiche.

La città del futuro è più vicina

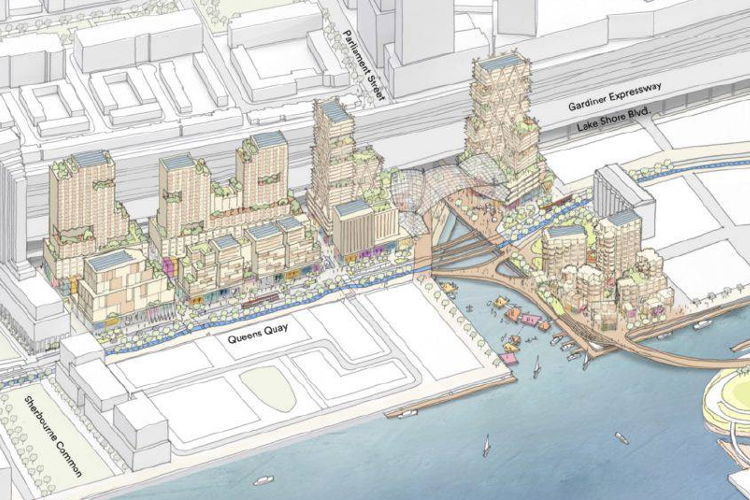

La vivibilità delle città del futuro dipende per buona parte anche dall’Intelligenza Artificiale e i primi risultati sono già vicini. Un intero quartiere di Toronto è infatti n corso di riprogettazione affidandosi proprio a soluzioni di intelligenza artificiale tra cui spicca quella di Sidewalk Lab, altra realtà della galassia Google. L’idea è individuare a priori la combinazione ideale tra infrastrutture e servizi. Combinare cioè edifici residenziali, ospedali, sistemi di trasporto e di sorveglianza in modo da migliorare la qualità della vita e diminuire aspetti negativi come costi di gestione e traffico.

Si tratta in pratica di consolidare e riunire diverse esperienze già realizzate. Per esempio, analizzando il comportamento di pendolari in modo da rendere più attraente il trasporto pubblico, oppure ottimizzare l’accesso ai servizi. L’insieme, produce impatti considerevoli anche sulla qualità dell’aria.

Il conto salato dell’energia

Tutto questo però ha un prezzo, non solo limitato agli aspetti economici. Fin dalle fasi di ricerca e sviluppo, l’intelligenza artificiale richiede infatti una quantità particolarmente elevata di risorse computazionali. Abbastanza grande da chiedersi se una parte considerevole dei vantaggi ottenuti in tema di sostenibilità non rischi di essere vanificato.

Per rendere l’idea, in occasione dell’esperimento BigGAN condotto da Google nel 2018 con l’intendo di riprodurre artificialmente diverse scene realistiche, Fast Company ha stimato un consumo di energia pari a quello di sei mesi per un’utenza domestica statunitense media.

Due i punti sui quali intervenire. Da una parte l’ingegneria, riducendo il consumo dei dispositivi. L’interesse in questo senso è già elevato. Dalla più specifica Kneron pronta a distribuire processori AI a basso consumo, fino a Apple, con l’acquisizione di Xnor.ai.

D’altra parte, con una maggiore attenzione alle energie rinnovabili come fonte di alimentazione per i data center. Nell’occasione, anche con l’aiuto della stessa intelligenza artificiale. Per esempio, DeepMind supporta Google nel prevedere la direzione del vento e orientare quindi per tempo le turbine eoliche.

Troppi dati da trattare

Al problema della sostenibilità si può arrivare anche per via indiretta. Comunque lo si prenda, un progetto di intelligenza artificiale attualmente necessita di una enorme quantità di dati per sviluppare le reti neurali e i sistemi di apprendimento sui quali costruire i sistemi predittivi.

Tra gli obiettivi attuali della ricerca, anche soluzioni in grado di contenere questa esigenza. Due in particolare, le direttrici di studio. Da una parte, riuscire a produrre dati artificialmente attraverso un altro algoritmo, partendo da un insieme più piccolo. Oppure, costruire proprio procedure del tutto nuove in grado di garantire gi stessi risultati con un volume di informazioni iniziali inferiore.

Anche quando le risorse possono esser disponibili, spesso è la materia prima a mancare. Non sempre, si può contare su abbastanza dati indicizzati e in grado di alimentare un sistema di intelligenza artificiale. Un esempio su tutti, le autovetture a guida autonoma. A oggi infatti, i possibili scenari da affrontare, ambientali e comportamentali, sono prevalentemente ipotetici. In assenza di una obiettiva possibilità di analizzarli dal vivo tutti, non resta altro se non affidarsi ai simulatori.

Un aiuto può arrivare anche da una sorta di condivisione dei dati. Prendere cioè un database già organizzato e classificato per trasferirne alcuni concetti alla soluzione di uno scenario simile. Restando nel caso della circolazione, sfruttare i risultati di una ricerca realizzata intorno alle autovetture, per applicarla anche ai camion.

Verso un’intelligenza artificiale quantistica

Quando si parla di Intelligenza Artificiale, merita attenzione anche un argomento al momento discusso prevalentemente a livello accademico, ma con buona probabilità determinante in futuro, il computer quantistico e la conseguente intelligenza artificiale quantistica.

In realtà, per il momento si parla più di modelli ibridi, capaci cioè di combinare gli algoritmi classici con quelli quantistici. In questo caso, alcuni esperimenti sono già a buon punto. Per arrivare a ottenere i primi risultati, sarà comunque necessario sviluppare architetture dedicate. Perché, se è vero che i computer quantistici sono già reali, per sfruttarli servono algoritmi del tutto nuovi e insieme di dati iniziali preparati in modo diverso.

Quello che conta però, sono le potenzialità, sulle quali i dubbi non mancano. Si tratta in pratica di poter contare su un netto salto di scala in termini di potenza di calcolo, punto di partenza cruciale per qualsiasi applicazione sofisticate, e quelle di IA in modo particolare, aumentando ulteriormente il livello di affidabilità dei modelli predittivi, accorciando al tempo stesso i tempi di risposta.

Sinergie non scontate

C’è un’ultima potenziale sinergia dove l’Intelligenza Artificiale può rivelarsi utile. Nel tempo, sono infatti emerse strette analogie tra il linguaggio naturale e lo studio del genoma, entrambi composti da dati sequenziali. Quindi, un algoritmo di IA sviluppato per uno dei due campi, può essere adattato anche all’altro.

Nell’insieme significa se non dimezzare, almeno ridurre considerevolmente, l’esigenza di dati e risorse di calcolo. Se nel caso del linguaggio gli obiettivi della ricerca sono individuare e prevedere parole, nel caso delle proteine, si punta a scoprire di più cosa ci sia all’interno degli amminoacidi.

Su questa strada si sta già muovendo DeepMind, proprio per affrontare una delle maggiori sfide nel settore e individuare la composizione delle proteine per ricostruirne la struttura in 3D. L’ostacolo maggiore in questo caso è l’enorme numero di possibilità da esplorare. Con i mezzi attuali, servirebbe infatti un tempo maggiore rispetto all’età dell’Universo come è noto attualmente.

Da un punto di vista molto più concreto, significherebbe prima di tutto un passo avanti importante nello sviluppo dei medicinali, con anche maggiore flessibilità rispetto alle singole esigenze.