Il CES 2026 segna per NVIDIA un punto di non ritorno. Non perché presenti una singola tecnologia “rivoluzionaria”, ma perché rende evidente una scelta industriale ormai irreversibile: il rendering in tempo reale, così come lo abbiamo conosciuto per trent’anni, non è più il centro del sistema. Al suo posto c’è una pipeline ibrida, profondamente guidata dall’intelligenza artificiale, in cui il frame finale non è necessariamente il risultato diretto di ciò che viene rasterizzato o tracciato, ma di ciò che viene ricostruito, predetto, stabilizzato e sincronizzato.

DLSS 4.5, G-SYNC Pulsar, RTX Remix Logic, GeForce NOW e RTX AI su PC non sono annunci separati. Sono tasselli di un’unica architettura concettuale che sposta il valore dalla forza bruta al controllo intelligente del flusso visivo e computazionale.

DLSS 4.5: dal rendering assistito al rendering delegato

Con DLSS 4.5 NVIDIA compie un passaggio sottile ma cruciale. Nelle generazioni precedenti, l’AI “aiutava” il rendering: ricostruiva dettagli, aumentava la risoluzione apparente, interpolava frame. Con la Multi Frame Generation dinamica 6X, invece, l’AI diventa responsabile diretta di una parte maggioritaria dell’output temporale.

Generare fino a cinque frame aggiuntivi per ogni frame renderizzato in modo tradizionale significa che la GPU non produce più una sequenza continua di immagini complete, ma una serie di ancore temporali da cui il sistema neurale ricostruisce il flusso visivo percepito. È un cambio di paradigma che ha conseguenze profonde su prestazioni, latenza e stabilità.

La dinamica 6X non è una semplice estensione numerica della 4X. Il sistema valuta in tempo reale carico, complessità della scena, movimenti e variazioni luminose per decidere quanto “delegare” alla rete neurale. Questo approccio consente di spingere il framerate oltre i 240 fps anche con path tracing attivo, ma soprattutto riduce la variabilità percettiva, uno dei limiti storici delle tecniche di interpolazione.

Accanto a questo, il nuovo modello Transformer di seconda generazione per la Super Resolution lavora meno sull’accentuazione dei dettagli e più sulla coerenza temporale. È un aspetto chiave: a risoluzioni elevate e con illuminazione fisicamente corretta, il problema non è più la nitidezza statica, ma la stabilità dell’immagine in movimento.

DLSS come infrastruttura, non come feature

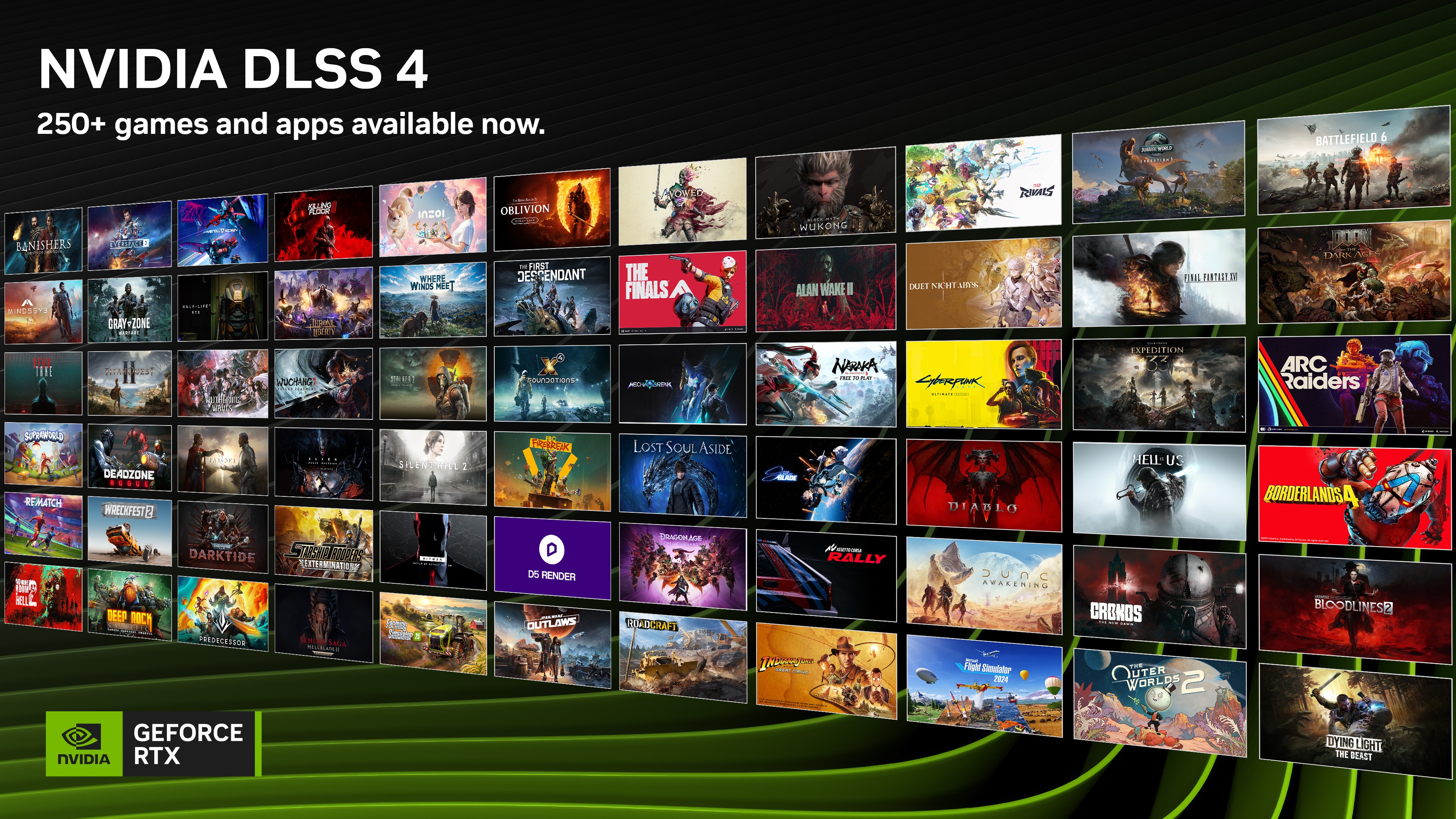

Il dato più rilevante non è tecnico, ma sistemico. Oltre 250 giochi e applicazioni supportano già DLSS Multi Frame Generation, e la traiettoria porta rapidamente oltre i 400 titoli compatibili con DLSS 4.5. Questo sposta DLSS da tecnologia opzionale a infrastruttura implicita dello sviluppo PC.

Sempre più studi progettano le pipeline grafiche dando per scontata la presenza di DLSS, path tracing e ricostruzione neurale. In altre parole, il rendering “nativo” torna a essere un mezzo, non un fine. È un passaggio simile a quello che, anni fa, ha trasformato il mipmapping o l’anisotropic filtering da opzioni avanzate a prerequisiti invisibili.

G-SYNC Pulsar: il frame non basta più, conta come lo vedi

Se DLSS 4.5 lavora sul tempo computazionale, G-SYNC Pulsar interviene sul tempo percettivo. La promessa di una chiarezza di movimento effettiva superiore a 1.000 Hz può sembrare marketing, ma il principio tecnico è solido: la stroboscopia a frequenza variabile consente di allineare emissione luminosa e aggiornamento dell’immagine in modo dinamico.

A differenza delle tecniche di strobing tradizionali, che operano a frequenza fissa e introducono compromessi evidenti, Pulsar adatta il comportamento del pannello al flusso reale dei frame. Il risultato non è solo meno motion blur, ma una maggiore leggibilità dei dettagli in movimento rapido, un aspetto critico tanto negli e-sport quanto nei giochi con path tracing spinto.

L’integrazione di G-SYNC Ambient Adaptive aggiunge un ulteriore livello: il display non è più un dispositivo statico, ma parte attiva della pipeline visiva, capace di adattarsi all’ambiente e alle condizioni di utilizzo. È un’estensione naturale dell’idea che la qualità dell’immagine non dipende solo dal rendering, ma dall’intero percorso che porta il fotone all’occhio.

RTX Remix Logic: il modding come linguaggio grafico

RTX Remix aveva già ridefinito il concetto di modding, permettendo di applicare path tracing e asset moderni a giochi classici senza accesso al codice sorgente. Con Remix Logic, NVIDIA fa un passo ulteriore: introduce una logica reattiva programmabile che consente alle mod di rispondere agli eventi di gioco.

Oltre 900 parametri configurabili significano che l’illuminazione, gli effetti e il comportamento visivo possono cambiare in funzione del contesto, trasformando titoli legacy in esperienze dinamiche. Non è solo una questione estetica: è una forma di preservazione attiva del software, in cui il passato videoludico viene reinterpretato con strumenti contemporanei, senza riscriverlo.

In prospettiva, RTX Remix Logic crea un ponte tra modding e sviluppo professionale, abbassando la soglia di accesso a tecniche che prima richiedevano engine moderni e team strutturati.

NVIDIA App: il controllo come requisito industriale

La maturità dell’ecosistema RTX passa anche dagli strumenti. NVIDIA App non è più un semplice launcher o pannello di impostazioni, ma il punto di controllo centrale di una piattaforma complessa. L’introduzione di modalità di debug, opzioni developer e gestione avanzata dei display indica chiaramente che il target non è solo il gamer, ma anche creator, sviluppatori e supporto tecnico.

Centralizzare overclock, driver, DLSS e funzionalità broadcast in un’unica interfaccia riduce la frammentazione e rende gestibile un ecosistema che, senza questo livello di controllo, rischierebbe di diventare ingestibile.

GeForce NOW: il cloud come moltiplicatore, non come alternativa

Con l’espansione di GeForce NOW su PC Linux e Amazon Fire TV, NVIDIA rafforza una visione precisa del cloud gaming: non sostituzione del PC, ma estensione. Portare prestazioni di classe RTX 5080 nel cloud significa rendere accessibile path tracing e DLSS anche dove l’hardware locale non lo consentirebbe.

È una risposta indiretta a due limiti strutturali: il costo crescente delle GPU di fascia alta e i vincoli energetici. In questo senso, GeForce NOW diventa uno strumento di democratizzazione tecnologica, più che un semplice servizio di streaming.

RTX AI: il ritorno dell’AI locale

Forse l’aspetto più strategico del CES 2026 è l’enfasi sull’AI locale. Ottimizzazioni come il supporto nativo alle precisioni NVFP4 e FP8, l’integrazione con ComfyUI e l’accelerazione della generazione video 4K mostrano una direzione chiara: riportare sul PC flussi di lavoro che negli ultimi anni erano migrati quasi esclusivamente sul cloud.

Le ragioni sono concrete: latenza ridotta, maggiore controllo sui dati, costi prevedibili. La possibilità di generare video AI in 4K partendo da scene 3D o di eseguire small language models con inferenze più rapide rafforza il ruolo del PC RTX come workstation AI personale, non come semplice terminale.

Una strategia senza scorciatoie

Il CES 2026 non è stato uno show di effetti speciali, ma una dichiarazione di intenti. NVIDIA non promette miracoli, ma propone un’architettura coerente in cui l’intelligenza artificiale diventa il tessuto connettivo di rendering, display, cloud e creazione di contenuti.

Il messaggio, per chi guarda oltre l’hype, è chiaro e anche scomodo: il futuro del real-time graphics non sarà più una gara a chi calcola più triangoli, ma a chi controlla meglio il flusso di informazione visiva. E su questo terreno, NVIDIA ha deciso di giocare la partita fino in fondo.