Alla Worldwide Developers Conference 2025, Apple ha presentato una nuova generazione di modelli linguistici foundation sviluppati appositamente per migliorare le funzionalità di Apple Intelligence nelle ultime versioni dei software. L’azienda ha anche introdotto il nuovo framework Foundation Models, che offre agli sviluppatori di app l’accesso diretto al modello linguistico di base integrato nel dispositivo, cuore pulsante di Apple Intelligence.

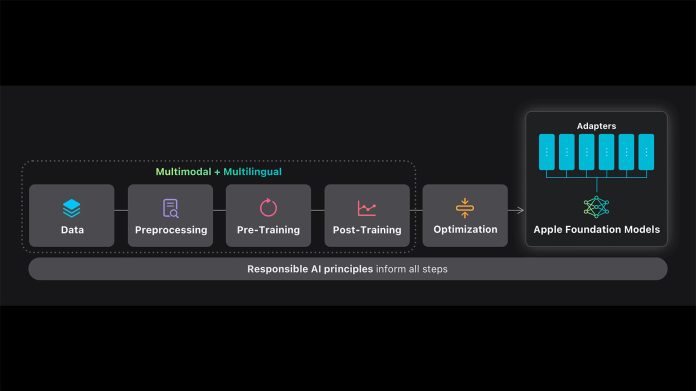

Apple ha di recente offerto maggiori dettagli e pubblicato un tech report sui due foundation language model multilingue e multimodali che alimentano le funzionalità di Apple Intelligence sui dispositivi e nei servizi dell’azienda, e su come l’azienda ha eseguito il training e il tuning dei modelli.

Il primo è un modello da circa 3 miliardi di parametri eseguibile on-device, cioè direttamente sul dispositivo, ottimizzato per i chip Apple silicon grazie a innovazioni architetturali come KV-cache sharing – una tecnica di condivisione intelligente della cache delle coppie chiave e valore (“Key” e “Value”) nei Transformer, migliorando velocità ed efficienza – e 2-bit quantization-aware training, un metodo che riduce la precisione numerica dei pesi del modello a soli 2 bit durante l’addestramento, mantenendo però buone prestazioni, e che serve a far girare il modello in modo leggero e veloce, ideale per i dispositivi mobili.

Il secondo è un modello server scalabile costruito su un nuovo transformer chiamato Parallel-Track Mixture-of-Experts (PT-MoE). Questo approccio unisce:

- Track parallelism: separazione del flusso computazionale in “tracce” parallele per ottimizzare l’efficienza.

- Mixture-of-Experts (MoE) sparse computation: un’architettura in cui solo alcuni “esperti” (sottoreti specializzate) vengono attivati a ogni passo, riducendo il carico computazionale.

- Interleaved global–local attention: un tipo di attenzione che alterna il focus globale (su tutto il testo) e locale (su segmenti specifici), migliorando la comprensione con costi contenuti.

Questo secondo modello viene eseguito sulla piattaforma Private Cloud Compute di Apple, che garantisce privacy e sicurezza, e queste tecniche servono per fornire un’alta qualità a costi competitivi.

Entrambi i modelli – spiega Apple – sono stati addestrati su grandi quantità di set di dati multilingue e multimodali (testo e immagini), provenienti da: crawling responsabile del web; corpora con licenza; e dati sintetici di alta qualità.

Successivamente, i dati sono stati affinati su una nuova piattaforma asincrona attraverso supervised fine-tuning, un ulteriore addestramento con esempi annotati da umani, e reinforcement learning, ottimizzazione tramite apprendimento per rinforzo.

I modelli ottenuti supportano numerose lingue aggiuntive e al contempo comprendono le immagini e possono eseguire tool calls (cioè invocare strumenti o funzioni esterne. Apple afferma che entrambi questi modelli – sia quello per il server che quello per l’elaborazione on-device – ottengono risultati paragonabili o superiori a modelli open di dimensioni simili, sia nei benchmark pubblici sia nelle valutazioni umane.

Apple ha introdotto anche un nuovo framework per modelli Foundation incentrato su Swift, che include guided generation, constrained tool calling e LoRA adapter fine-tuning: gli sviluppatori possono integrare queste capacità con poche righe di codice.

Nel presentare i nuovi modelli, la società di Cupertino ha sottolineato che gli ultimi progressi nei modelli di Apple Intelligence si basano sull’approccio “Responsible AI” dell’azienda, con misure di sicurezza quali il filtraggio dei contenuti e la valutazione specifica per lingua e cultura, nonché sull’impegno a proteggere la privacy degli utenti con innovazioni quali Private Cloud Compute.

Per informazioni approfondite sui modelli, è possibile consultare l’”Apple Intelligence Foundation Language Models – Tech Report 2025” pubblicato da Apple.

L’azienda ha anche aggiornato il documento di approfondimento sul sito Machine Learning Research at Apple.