La prima leva della strategia agent-first di AWS è infrastrutturale. Quando un agente lavora per obiettivi complessi, non fa una singola inferenza: ne concatena molte, spesso in parallelo, con loop di verifica e correzione. Questo trasforma costo per token e latenza in vincoli strutturali. Garman mette quindi l’infrastruttura AI al centro della filiera: prima si riduce l’attrito economico e prestazionale dell’inferenza, poi si costruiscono modelli e agenti sopra quella base.

È da questa esigenza che nasce l’idea di UltraServer, cioè un cambio di scala nel modo in cui AWS costruisce le istanze AI: non più solo somma di nodi piccoli (scale-out), ma domini scale-up ad altissima densità in cui decine o centinaia di acceleratori lavorano come un unico computer logico, con rete interna dedicata e stack software co-progettato. In un contesto agentico — fatto di inferenze multi-step e tool-calling parallelo — questo serve a ridurre la frammentazione del calcolo e a contenere la latenza di comunicazione e l’overhead di parallelismo, che diventano rapidamente il vero collo di bottiglia quando la scala cresce.

Nel keynote questa idea si declina in due famiglie. La prima è sul fronte GPU: AWS introduce EC2 P6e-GB300 UltraServers basati su NVIDIA GB300 NVL72, posizionandoli come piattaforma per training e soprattutto inferenza frontier di modelli enormi. Sono i sistemi GPU più avanzati in EC2, progettati per servire modelli da trilioni di parametri con un profilo di latenza più stabile grazie alla densità NVL72 e all’interconnessione interna di classe NVLink. In più, restano istanze cloud-native: isolamento e I/O su Nitro e integrazione diretta con EKS, così da portare workload frontier in ambienti Kubernetes gestiti senza architetture dedicate.

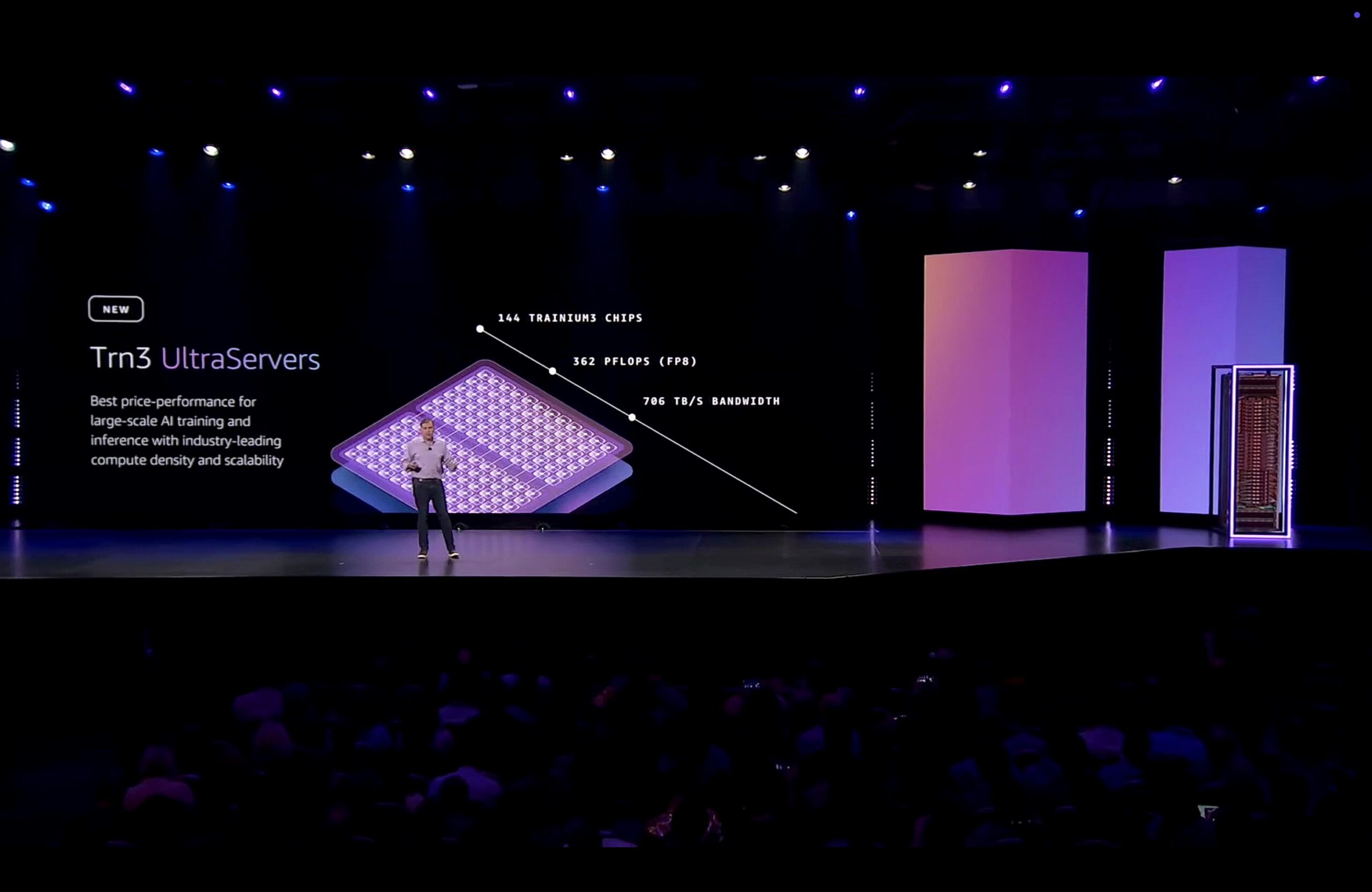

La seconda famiglia è proprietaria: Trn3 UltraServers, costruiti intorno al chip Trainium3 a 3 nm. Qui il salto è ancora più esplicito sul piano architetturale. Ogni Trn3 UltraServer integra fino a 144 acceleratori Trainium3 in un unico dominio scale-up connesso tramite NeuronSwitch, in modo che l’intero pacco appaia come una sola istanza per il framework di training o serving. Garman quantifica il progresso: rispetto a Trainium2 la piattaforma offre 4,4× capacità di calcolo, 3,9× banda memoria HBM e fino a 5× più token per megawatt, con l’obiettivo dichiarato di comprimere costo e consumi quando l’inferenza multi-step degli agenti cresce di ordine di grandezza.

Il tratto distintivo dei Trn3 UltraServers è la rete interna, perché è lì che oggi si gioca l’efficienza reale del calcolo AI. Trainium3 integra NeuronSwitch-v1 (banda intra-server raddoppiata) e Neuron Fabric, una rete chip-to-chip con latenza sotto i 10 microsecondi. AWS collega questa architettura a workload moderni come MoE, multimodale e reinforcement learning, dove i continui scambi fra acceleratori determinano la latenza end-to-end più del solo FLOPs. In pratica: l’UltraServer riduce il “costo nascosto” del parallelismo e rende più lineare la scalabilità sia nel training sia nell’inferenza.

Con questa base hardware e di rete, AWS annuncia UltraClusters 3.0: domini di training che aggregano migliaia di UltraServer e possono arrivare fino a un milione di chip Trainium in un unico cluster.

È un salto di ordine di grandezza rispetto alle generazioni precedenti, progettato per sostenere l’addestramento di foundation model multimodali più grandi e più costosi, ma anche per rendere praticabile inferenza distribuita in scenari ad alta concorrenza.

Qui il punto è duplice: da un lato la capacità di costruire modelli proprietari (Nova e Novella), dall’altro un serving room-scale che possa ospitare popolazioni di agenti senza che il costo per token diventi proibitivo quando l’uso entra davvero nei processi aziendali.

La road map si completa con Trainium4, annunciato come nuova generazione per il 2026. AWS dichiara incrementi di almeno 6× in FP4, 3× in FP8 e 4× banda memoria rispetto a Trainium2, oltre a una progettazione esplicita per i workload di inferenza di nuova generazione. La novità architetturale più significativa è il supporto a NVIDIA NVLink Fusion, che consente domini hardware misti in rack MGX: GPU per i modelli più esigenti, Trainium per il price-performance, Graviton per le componenti general purpose.

Questo rende l’infrastruttura componibile: training e inferenza possono spostarsi tra piattaforme scegliendo quelle più efficienti per tipo di modello, finestra temporale e budget, senza costringere a duplicare stack software o a riscrivere pipeline.

Dentro lo stesso livello infrastrutturale, AWS introduce le AI Factories come estensione on-prem della capacità AI. Sono infrastrutture AI dedicate installate nei data center del cliente e gestite come una private AWS Region: il cliente fornisce spazio, potenza elettrica e connettività, mentre AWS si occupa di progettazione, deployment e gestione dell’intero stack.

La proposta è full-stack: acceleratori NVIDIA di ultima generazione affiancati ad ASIC Trainium; rete ad alte prestazioni della stessa famiglia UltraCluster; storage e database integrati; disponibilità locale di Bedrock e SageMaker con lo stesso modello operativo, API e governance del cloud pubblico.

Il blocco è destinato in modo esplicito a governi e settori regolati, dove i vincoli di sovranità del dato, compliance o latenza impediscono di usare solo public cloud ma costruire una filiera AI completa da zero richiederebbe anni. AWS indica compatibilità con carichi fino a livelli Secret e Top Secret, quindi con un posizionamento evidente per difesa e intelligence.

AWS lega il modello a una prova su scala nazionale già in corso: l’AI Zone costruita con HUMAIN in Arabia Saudita, fino a 150.000 chip AI (inclusi GB300) e servizi AWS in loco, usata come blueprint per un’offerta replicabile.

Il livello infrastrutturale di re:Invent 2025 non è una lista di istanze nuove: è un tentativo di chiudere il triangolo prestazioni massime (GB300), efficienza economica (Trainium3/4) e sovranità operativa (AI Factories) dentro una piattaforma coerente. L’obiettivo è sostenere l’inferenza multi-step degli agenti a costi prevedibili e con latenza compatibile con workflow reali, sia nel public cloud sia in perimetri regolati.

Leggi anche:

-

- AWS re:Invent 2025: potenziare l’infrastruttura AI per ridurre il costo marginale degli agenti e la latenza operativa

- AWS re:Invent 2025: consolidare l’inferenza multi-modello per scegliere il modello giusto per ogni processo

- AWS re:Invent 2025: innestare i dati proprietari nel training e nel retrieval per trasformarli in vantaggio competitivo

- AWS re:Invent 2025: governare gli agenti in produzione con controlli deterministici e qualità misurabili

- AWS re:Invent 2025: portare gli agenti nei workflow aziendali per modernizzare applicazioni e automatizzare operations