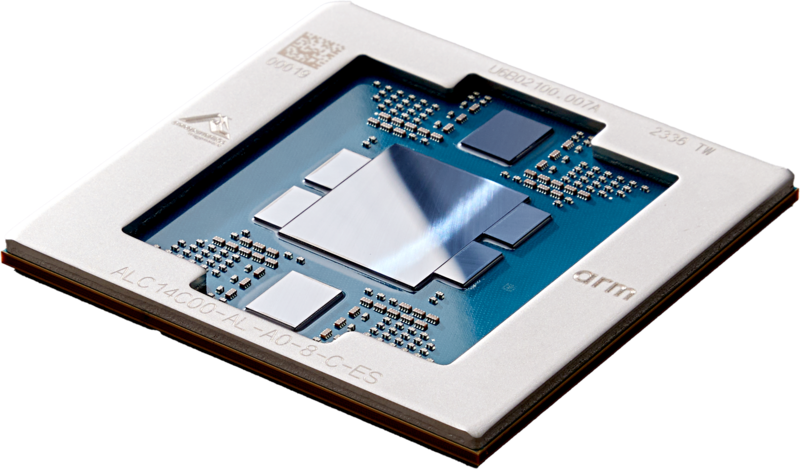

Nel corso del suo keynote ad AWS re:Invent 2023, il Ceo Adam Selipsky ha annunciato la nuova generazione di due famiglie di chip progettati da AWS – AWS Graviton4 e AWS Trainium2 – che offrono progressi in termini di prestazioni di prezzo ed efficienza energetica per un’ampia gamma di carichi di lavoro dei clienti, tra cui l’addestramento del Machine Learning e le applicazioni di GenAI. Graviton4 e Trainium2 rappresentano le ultime innovazioni nella progettazione dei chip di AWS.

Con ogni generazione successiva di chip, AWS offre prestazioni migliori in termini di prezzo e di efficienza energetica, offrendo ai clienti un numero ancora maggiore di opzioni – oltre alle combinazioni di chip/istanze con i più recenti chip di terze parti come AMD, Intel e NVIDIA – per eseguire praticamente qualsiasi applicazione o carico di lavoro su Amazon EC2.

Graviton4 offre prestazioni di calcolo fino al 30% superiori, il 50% in più di core e il 75% in più di larghezza di banda della memoria rispetto all’attuale generazione di processori Graviton3, offrendo le migliori prestazioni in termini di prezzo e di efficienza energetica per un’ampia gamma di carichi di lavoro in esecuzione su Amazon EC2.

Trainium2 è progettato per fornire un addestramento fino a 4 volte più veloce rispetto ai chip Trainium di prima generazione e potrà essere distribuito in UltraCluster EC2 fino a 100.000 chip, rendendo possibile l’addestramento di foundation model e di LLM in una frazione del tempo, migliorando al contempo l’efficienza energetica fino a 2 volte.

“Il silicio è alla base di tutti i carichi di lavoro dei clienti, il che lo rende un’area critica di innovazione per AWS”, ha dichiarato David Brown, vicepresidente di Compute and Networking di AWS. Concentrando i progetti dei nostri chip sui carichi di lavoro reali che interessano ai clienti, siamo in grado di offrire loro l’infrastruttura cloud più avanzata”. Graviton4 segna la quarta generazione che abbiamo consegnato in soli cinque anni ed è il chip più potente ed efficiente dal punto di vista energetico che abbiamo mai costruito per un’ampia gamma di carichi di lavoro. Con l’aumento dell’interesse per l’IA generativa, Tranium2 aiuterà i clienti ad addestrare i loro modelli di ML più velocemente, a costi inferiori e con una migliore efficienza energetica”.

Graviton4 alza il livello delle prestazioni e dell’efficienza energetica per un’ampia gamma di carichi di lavoro.

Oggi AWS offre più di 150 diversi tipi di istanze Amazon EC2 alimentate da Graviton a livello globale e su scala, ha costruito più di 2 milioni di processori Graviton e più di 50.000 clienti, tra cui i primi 100 clienti EC2, utilizzano istanze basate su Graviton per ottenere le migliori prestazioni in termini di prezzo per le loro applicazioni. Clienti come Datadog, DirecTV, Discovery, Formula 1 (F1), NextRoll, Nielsen, Pinterest, SAP, Snowflake, Sprinklr, Stripe e Zendesk utilizzano le istanze basate su Graviton per eseguire un’ampia gamma di carichi di lavoro, come database, analytics, web server, elaborazione batch, ad serving, application server e microservizi. Man mano che i clienti portano nel cloud database in-memory e carichi di lavoro analitici più grandi, i loro requisiti di calcolo, memoria, storage e rete aumentano. Di conseguenza, hanno bisogno di prestazioni ancora più elevate e di istanze di dimensioni maggiori per eseguire questi carichi di lavoro impegnativi, gestendo al contempo i costi. Inoltre, i clienti vogliono opzioni di calcolo più efficienti dal punto di vista energetico per i loro carichi di lavoro, per ridurre l’impatto sull’ambiente. Graviton è supportato da molti servizi gestiti da AWS, tra cui Amazon Aurora, Amazon ElastiCache, Amazon EMR, Amazon MemoryDB, Amazon OpenSearch, Amazon Relational Database Service (Amazon RDS), AWS Fargate e AWS Lambda, portando i vantaggi di Graviton in termini di prezzo e prestazioni agli utenti di questi servizi.

I processori Graviton4 offrono prestazioni di calcolo fino al 30% superiori, il 50% in più di core e il 75% in più di larghezza di banda della memoria rispetto a Graviton3. Graviton4 alza anche il livello di sicurezza grazie alla crittografia completa di tutte le interfacce hardware fisiche ad alta velocità. Graviton4 sarà disponibile nelle istanze Amazon EC2 R8g ottimizzate per la memoria, consentendo ai clienti di migliorare l’esecuzione dei loro database ad alte prestazioni, delle cache in-memory e dei carichi di lavoro di analisi dei big data. Le istanze R8g offrono istanze di dimensioni maggiori, con un numero di vCPU e di memoria fino a tre volte superiore rispetto alla generazione attuale di istanze R7g. Ciò consente ai clienti di elaborare grandi quantità di dati, scalare i carichi di lavoro, migliorare il time-to-results e ridurre il costo totale di proprietà. Le istanze R8g alimentate da Graviton4 sono disponibili da oggi in anteprima, mentre la disponibilità generale è prevista nei prossimi mesi.

Gli UltraCluster EC2 di Trainum2 sono progettati per offrire l’infrastruttura di addestramento dei modelli di IA più performante ed efficiente dal punto di vista energetico nel cloud.

I modelli FM e LLM che stanno alla base delle attuali applicazioni di IA generativa sono addestrati su enormi set di dati. Gli FM e gli LLM più avanzati oggi hanno un numero di parametri che va da centinaia di miliardi a trilioni, e richiedono una capacità di calcolo affidabile ad alte prestazioni in grado di scalare su decine di migliaia di chip ML. AWS offre già la scelta più ampia e profonda di istanze Amazon EC2 con chip di ML, tra cui le più recenti GPU NVIDIA, Trainium e Inferentia2. Oggi, clienti come Databricks, Helixon, Money Forward e il team di Amazon Search utilizzano Trainium per addestrare modelli di deep learning su larga scala, sfruttando le elevate prestazioni, la scalabilità, l’affidabilità e il basso costo di Trainium. Ma anche con le istanze accelerate più veloci oggi disponibili, i clienti desiderano maggiori prestazioni e scala per addestrare questi modelli sempre più sofisticati in modo più rapido, a un costo inferiore e riducendo al contempo la quantità di energia utilizzata.

I chip Trainium2 sono stati creati appositamente per l’addestramento ad alte prestazioni di FM e LLM con un massimo di trilioni di parametri. Trainium2 è progettato per offrire prestazioni di addestramento fino a 4 volte più veloci e una capacità di memoria 3 volte superiore rispetto ai chip Trainium di prima generazione, migliorando al contempo l’efficienza energetica (prestazioni/watt) fino a 2 volte. Trainium2 sarà disponibile in istanze Amazon EC2 Trn2, contenenti 16 chip Trainium in una singola istanza. Le istanze Trn2 sono destinate a consentire ai clienti di scalare fino a 100.000 chip Trainium2 in UltraCluster EC2 di nuova generazione, interconnessi con la rete AWS Elastic Fabric Adapter (EFA) su scala petabit, fornendo fino a 65 exaflop di calcolo e dando ai clienti accesso on-demand a prestazioni da supercomputer. Con questo livello di scala, i clienti possono addestrare un LLM da 300 miliardi di parametri in settimane anziché in mesi. Offrendo le più elevate prestazioni di addestramento ML su scala ridotta a costi significativamente inferiori, le istanze Trn2 possono aiutare i clienti a sbloccare e accelerare la prossima ondata di progressi nell’IA generativa.

Anthropic, leader nella diffusione responsabile dell’IA generativa, è un’azienda di ricerca e sicurezza sull’IA che crea sistemi di IA affidabili, interpretabili e orientabili. Cliente AWS dal 2021, Anthropic ha recentemente lanciato Claude, un assistente AI che si concentra sull’essere utile, innocuo e onesto. “Dal lancio su Amazon Bedrock, Claude ha visto una rapida adozione da parte dei clienti AWS”, ha dichiarato Tom Brown, co-fondatore di Anthropic. “Stiamo lavorando a stretto contatto con AWS per sviluppare i nostri futuri modelli di base utilizzando i chip Trainium. Trainium2 ci aiuterà a costruire e addestrare i modelli su scala molto ampia e ci aspettiamo che sia almeno 4 volte più veloce dei chip Trainium di prima generazione per alcuni dei nostri carichi di lavoro principali. La nostra collaborazione con AWS aiuterà le organizzazioni di tutte le dimensioni a sbloccare nuove possibilità, utilizzando i sistemi AI all’avanguardia di Anthropic insieme alla tecnologia cloud sicura e affidabile di AWS”.