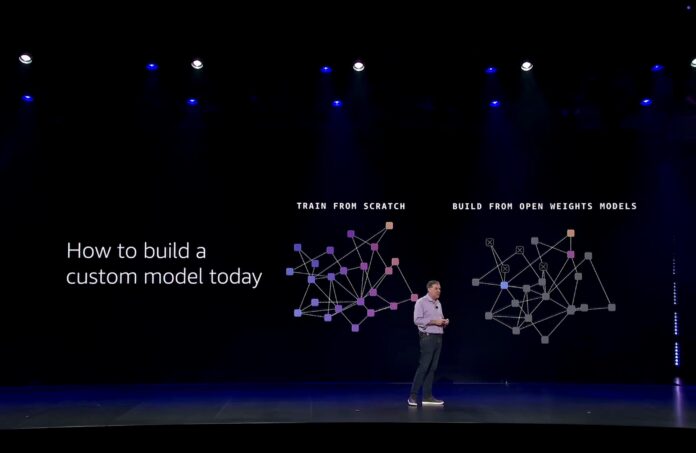

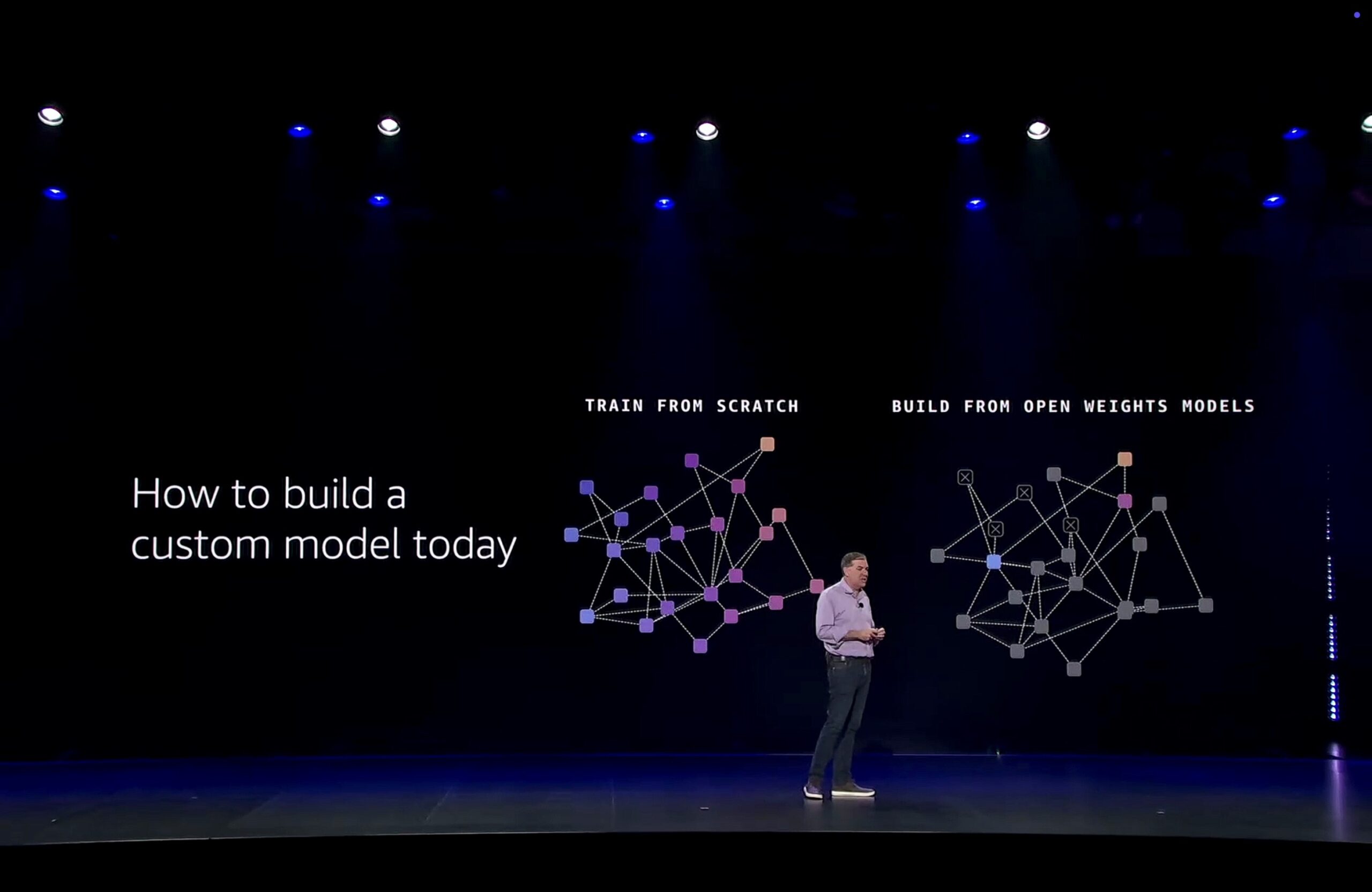

Dopo aver definito nel livello precedente l’inferenza come strato stabile e multi-modello, il terzo livello della filiera agent-first entra nel punto che rende un agente davvero utile in azienda: la capacità di ragionare sul dominio specifico e di recuperare contesto reale dai dati interni. Garman lo inquadra con una distinzione netta. Il fine-tuning tradizionale è importante, ma ha un limite strutturale: migliora un modello già formato senza trasferire davvero competenza fondazionale su un dominio. “Il fine-tuning può portarti avanti solo fino a un certo punto”, osserva, perché se i dati proprietari non entrano nel pre-training il modello resta generalista e l’azienda non costruisce un vantaggio cumulativo nel tempo.

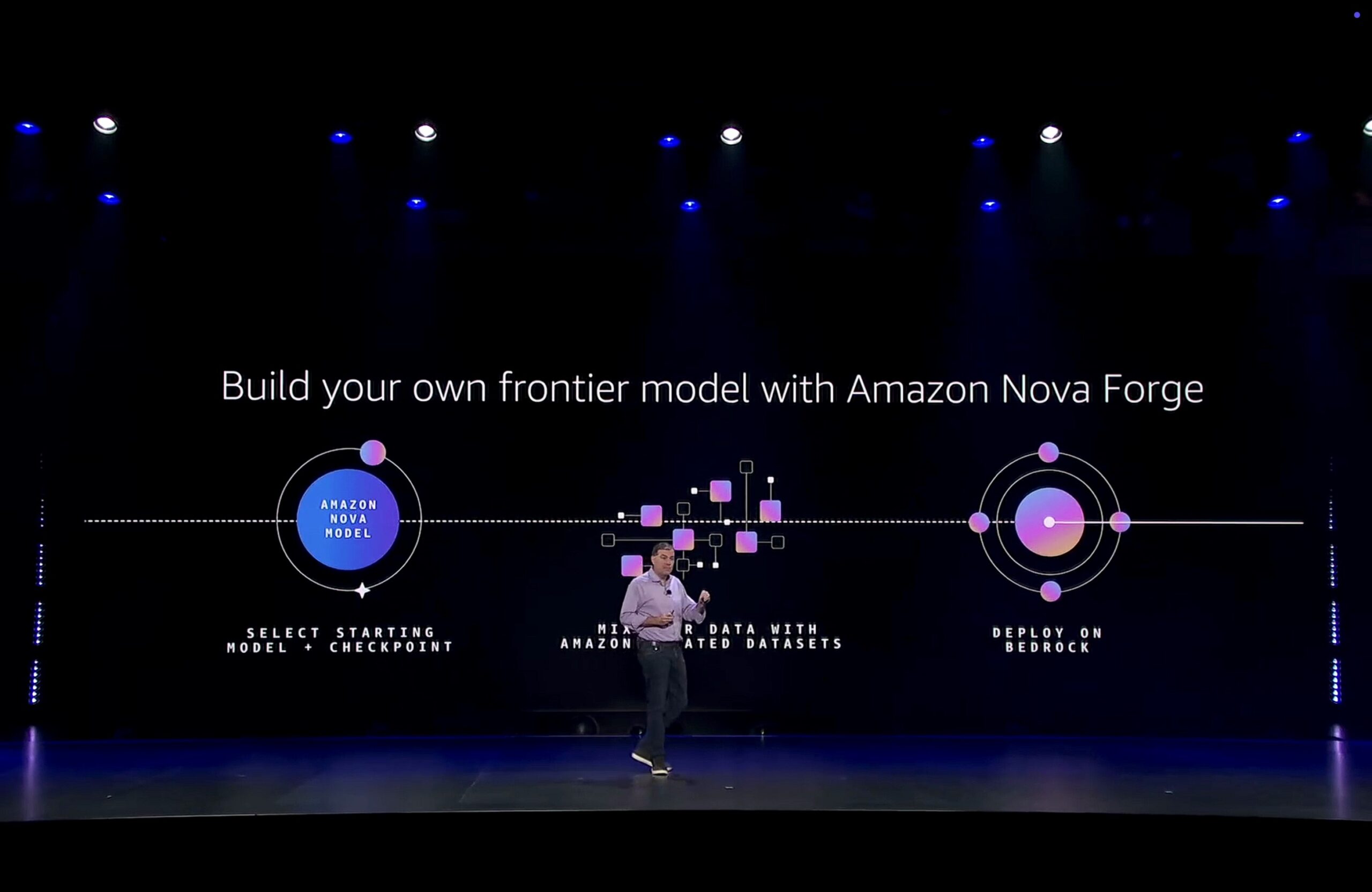

Da qui discendono due mosse presentate a re:Invent 2025: Nova Forge per innestare i dati aziendali dentro la costruzione del modello, e una serie di evoluzioni S3 che rendono il data layer più “AI-ready” quando i dataset diventano enormi e continuamente movimentati dagli agenti.

Nova Forge: specializzazione profonda a partire dai checkpoint di training

Nova Forge è costruito sugli open training models di Amazon Nova. L’idea è offrire accesso a checkpoint intermedi del training, non solo al modello finale. Invece di fare fine-tuning “a valle”, l’azienda può ripartire da un punto della traiettoria di pre-training dei Nova 2 e inserire i propri dati lungo il percorso. Garman descrive Forge come un modo per “fondere i vostri dati proprietari con un dataset curato da Amazon in ogni fase del training”, così da trasferire capacità generali di reasoning dentro un contesto di dominio senza distruggerle.

Il risultato sono foundation model privati che AWS chiama Novella (o “novellas”), pubblicabili poi in Bedrock come modelli interni e utilizzabili con gli stessi strumenti di inferenza e governance dei modelli pubblici. Il passaggio è strategico: il dato proprietario non serve solo a “personalizzare” un modello, ma a creare un FM aziendale che entra nella piattaforma operativa quotidiana.

Garman porta un esempio pratico per rendere tangibile il salto. Un produttore hardware parte da un checkpoint Nova 2 Lite pre-addestrato all’80%, vi innesta centinaia di GB di dati interni — progetti, failure mode, note di review, ticket storici — e completa il training con le ricette Nova Forge. Il risultato è un modello che non solo risponde, ma ragiona nel linguaggio tecnico dell’azienda, sugli oggetti e sui problemi che quella specifica organizzazione affronta.

Forge include anche un meccanismo di remote reward functions e reinforcement fine-tuning. In pratica, l’azienda può collegare al training del modello metriche operative proprie (precisione su task critici, preferenze di stile, regole di business) e usarle come segnale di ricompensa, così da allineare il modello non solo ai dati ma ai criteri di successo concreti dell’organizzazione.

Il quadro che Garman traccia è quindi questo: Nova Forge serve a portare l’intelligenza generale in un dominio specifico “dall’interno”, creando un foundation model di proprietà che diventa fondazione operativa per agenti e applicazioni Bedrock.

Dal modello ai dati “a scala AI”: perché S3 viene aggiornato

Più avanti nel keynote Garman riapre la questione dei dati, ma su un piano diverso. Dopo aver mostrato come i dati proprietari entrino nel training con Forge, spiega che quegli stessi dati devono essere gestiti in modo più efficiente perché l’AI di produzione li usa con frequenza e volume mai visti prima. Qui introduce una serie di innovazioni che definisce “incrementali”, ma che segnano un innalzamento necessario delle soglie operative quando training, inferenza e retrieval insistono sullo stesso data lake.

Il primo cambio è la dimensione massima dei singoli oggetti S3, portata a 50 TB. È un salto che risponde a dataset multimodali monolitici, archivi video industriali e checkpoint di modelli enormi che non possono essere spezzati senza costi aggiuntivi di orchestrazione.

Il secondo aggiornamento riguarda le S3 Batch Operations, ora fino a 10× più veloci. Su scala S3, dove i bucket possono contenere trilioni di oggetti, job di replica, tagging, checksum, riorganizzazione o migrazione diventano operazioni quotidiane per l’AI: servono a riplasmare i data lake mentre modelli e agenti evolvono. La velocità qui incide direttamente sul time-to-experiment e sul time-to-production.

Terzo passaggio: S3 Tables per Apache Iceberg. Garman ricorda l’adozione già ampia di Iceberg e introduce due elementi che rendono questa modalità più adatta ai workload AI. Da un lato Intelligent-Tiering applicato automaticamente alle tabelle, che può ridurre i costi fino all’80% quando i pattern di accesso oscillano tra “caldo” e “freddo”. Dall’altro la replica automatica cross-region e cross-account, che permette di tenere copie locali coerenti senza orchestration manuale, utile per training distribuiti e per applicazioni RAG globali.

Nello stesso filone rientra l’estensione degli S3 Access Points per FSx for NetApp ONTAP, che espone dataset NAS legacy come oggetti S3. È un dettaglio operativo con un effetto forte: consente di portare nel perimetro AI-ready porzioni di patrimonio dati che vivono ancora su storage tradizionale, senza migrazioni preventive lente prima di poterle usare in Bedrock o in pipeline di training.

S3 Vectors: memoria semantica nativa per RAG e agenti

Dentro le innovazioni S3, il pezzo più direttamente legato alla GenAI di produzione è S3 Vectors, ora GA. AWS lo descrive come capacità di storage e query vettoriale nativa in S3, con indici fino a 2 miliardi di vettori e scala fino a 20 trilioni di vettori per bucket. Aggiunge prestazioni 2–3× migliori sulle query frequenti e riduzioni di costo fino al 90% rispetto a soluzioni vettoriali dedicate.

Il punto di collegamento con Bedrock è esplicito: S3 Vectors si integra con Amazon Bedrock Knowledge Bases e OpenSearch per costruire retrieval, grounding e memoria semantica degli agenti senza gestire un database vettoriale separato. In termini di filiera, Forge produce un modello che “sa” un dominio; S3 Vectors fornisce al modello la memoria viva di quel dominio, aggiornata minuto per minuto dai dati reali.

Una doppia strategia sul dato: competenza e memoria

Il terzo livello della filiera agent-first si chiude quindi con una doppia mossa coerente. N\e così completato: Forge trasforma i dati proprietari in competenza linguistica e di reasoning incorporata nel foundation model; le evoluzioni S3 e S3 Vectors rendono quei dati maneggiabili e recuperabili quando gli agenti li usano a scala industriale. In sintesi: prima si costruisce il proprio modello (Novella), poi si rende il data lake capace di alimentarlo continuamente con contesto e memoria semantica.

Leggi anche:

- AWS re:Invent 2025: potenziare l’infrastruttura AI per ridurre il costo marginale degli agenti e la latenza operativa

- AWS re:Invent 2025: consolidare l’inferenza multi-modello per scegliere il modello giusto per ogni processo

- AWS re:Invent 2025: innestare i dati proprietari nel training e nel retrieval per trasformarli in vantaggio competitivo

- AWS re:Invent 2025: portare gli agenti nei workflow aziendali per modernizzare applicazioni e automatizzare operations

- AWS re:Invent 2025: governare gli agenti in produzione con controlli deterministici e qualità misurabili