Se l’infrastruttura riduce il costo marginale dell’AI agentica, il livello successivo è quello che rende l’inferenza governabile come componente stabile delle applicazioni. Matt Garman insiste sul fatto che l’AI di produzione non può dipendere da un singolo modello “vincente” del momento: la qualità cambia, i costi di serving cambiano, e i casi d’uso richiedono profili diversi di latenza, contesto e multimodalità. Per questo Bedrock viene posizionata come runtime che separa l’evoluzione dei modelli dall’evoluzione delle applicazioni, offrendo scelta e portabilità senza riscritture continue.

La trazione è già da workload permanenti. In un anno i clienti Bedrock sono più che raddoppiati e oltre cinquanta aziende hanno superato la soglia di un trilione di token ciascuna sulla piattaforma, segno di un’inferenza non episodica ma “di linea”, orchestrata dentro processi reali. Garman collega esplicitamente questa scala all’emergere degli agenti: se l’applicazione diventa una catena di inferenze, allora ciò che conta è avere un livello di inferenza che regga variazioni di modelli e carichi senza introdurre attrito operativo o rischi di governance.

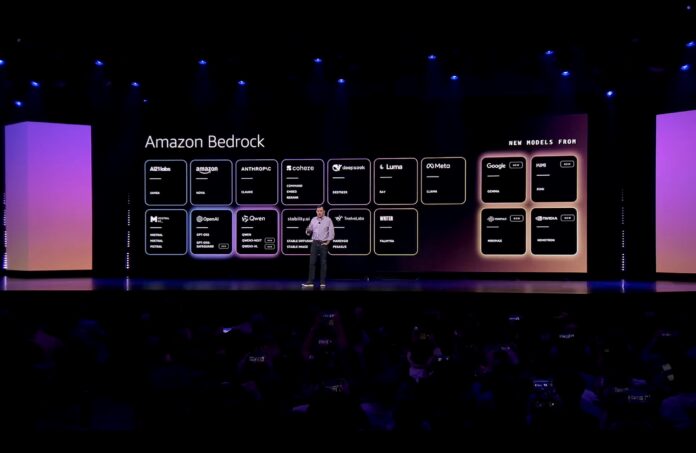

Apertura dell’ecosistema: 18 modelli open-weight in un unico rilascio

La prima mossa di re:Invent 2025 è espandere Bedrock come piattaforma multi-modello con un rilascio unico di 18 nuovi modelli open-weight. È un segnale strategico: AWS non vuole più presentare Bedrock come “collana di modelli partner”, ma come catalogo vasto che copre fasce diverse di reasoning, costo e multimodalità, lasciando al cliente la libertà di costruire architetture composite.

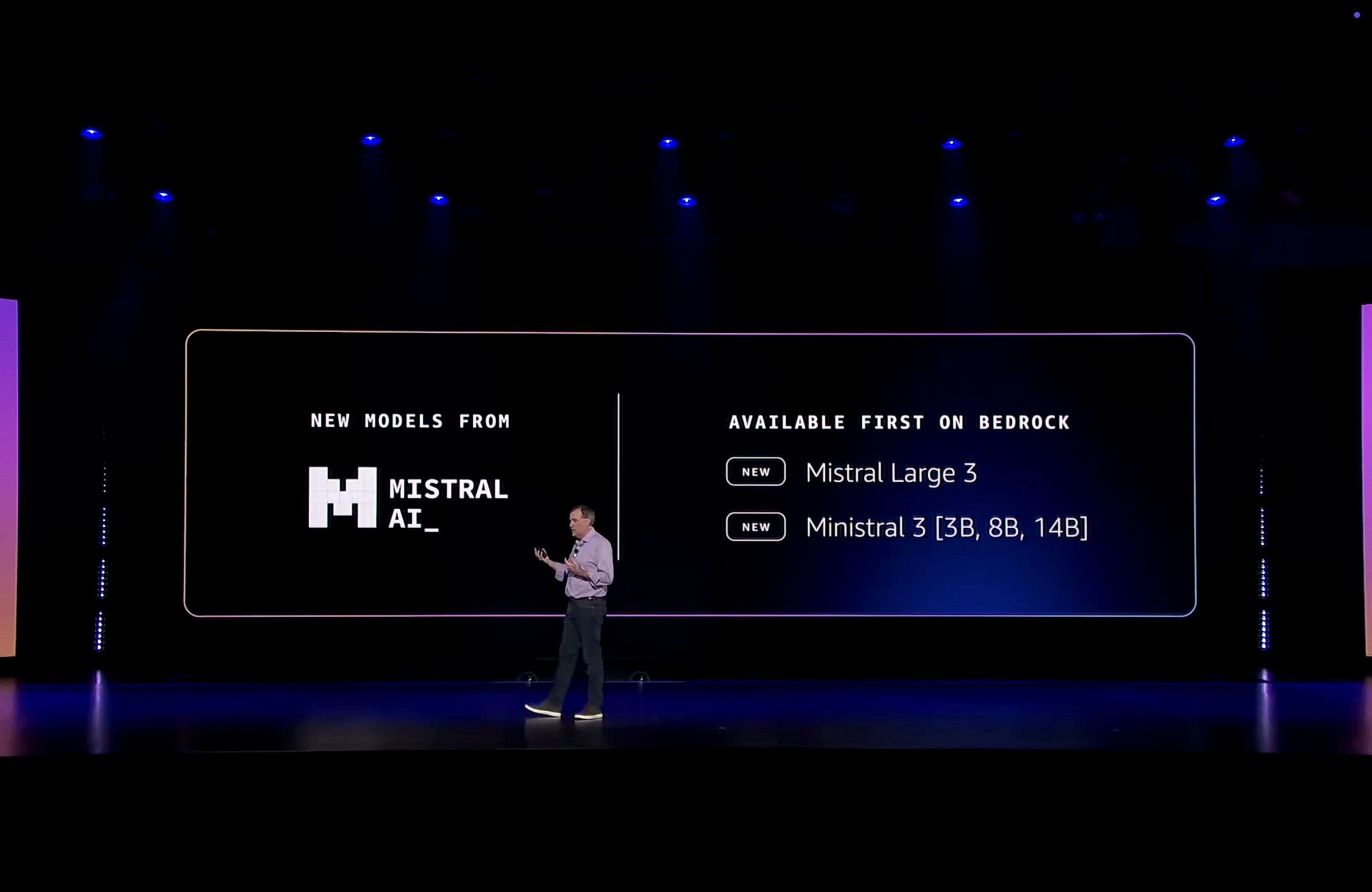

Tra gli ingressi evidenziati ci sono i nuovi Mistral in anteprima. Mistral Large 3 viene presentato come open-weight frontier multimodale e con contesto lungo; Ministral 3 come famiglia compatta, generalista e anch’essa multimodale. L’idea è offrire due estremi complementari: un modello grande per task complessi e un modello leggero per workload a bassa latenza o ad alto volume. Inserirli nello stesso strato Bedrock serve a renderli intercambiabili a parità di API, guardrail e strumenti di valutazione, così da scegliere modello per modello lungo la catena inferenziale senza frammentare governance o costi operativi.

Coerenza interna nella pluralità: perché esiste Nova 2

Accanto alla spinta open-weight, AWS rafforza una seconda colonna della strategia multi-modello: una famiglia proprietaria ottimizzata nativamente per Bedrock e per requisiti industriali di costo e latenza. Nova 2 arriva proprio qui. Garman la introduce ricordando che Nova, in un anno, ha già sbloccato casi d’uso specifici come speech-to-speech realtime e embeddings multimodali, poi annuncia “una nuova generazione… Nova 2”, costruita per offrire “price-performance ottimizzato con intelligenza a livello frontier”. Il ruolo è complementare, non sostitutivo: un set di modelli interni che permettono ad AWS di controllare a fondo la curva costo-prestazioni e l’integrazione con l’infrastruttura Trainium/GPU.

La famiglia Nova 2 si articola in quattro profili che coprono in modo coerente le esigenze dell’inferenza agentica: due modelli di ragionamento (Lite e Pro), un modello per conversazione vocale realtime (Sonic) e un modello multimodale unificato (Omni).

Nova 2 Lite: il “workhorse” per inferenza economica e agenti

Nova 2 Lite è il modello rapido e costo-efficiente che Garman descrive come adatto a “un ampio insieme di workload”, con un profilo pensato per essere la base operativa quotidiana. La sua funzione è chiara: massimizzare throughput e ridurre il tempo di risposta su task generalisti, mantenendo qualità sufficiente per far girare a scala larga applicazioni e agenti. Garman sottolinea che Lite è costruito per instruction following robusto, tool-calling, generazione e trasformazione di codice e comprensione di documenti, cioè le capacità che, in una catena agentica, fungono da “motore di esecuzione” più che da puro generatore testuale.

Il valore dell’approccio sta nel costo marginale. In un mondo dove un agente può fare decine di chiamate per completare un obiettivo, un modello Lite con price-performance aggressivo diventa essenziale per evitare che l’automazione agentica resti confinata a casi d’uso di nicchia. Garman lo esplicita quando lo posiziona come modello che “offre un price-performance incredibile per molti workload” ed è competitivo rispetto ai pari fascia di mercato.

Nova 2 Pro: ragionamento pesante e stabilità per workflow complessi

Nova 2 Pro è il gradino superiore della stessa architettura, dedicato a compiti a elevata complessità logica. Garman lo definisce “il nostro modello di ragionamento più intelligente per workload altamente complessi” e lo collega alla necessità di agenti affidabili in catene lunghe. Qui non conta solo la qualità del testo, ma la capacità di mantenere coerenza e precisione quando il modello deve gestire istruzioni articolate e scelte di strumenti. Pro viene presentato come particolarmente forte proprio in instruction following per agenti, con performance di benchmark in cui “spesso esce al primo posto” nel segmento high-end.

Due implicazioni operative emergono da questo posizionamento. La prima è che Pro diventa il candidato naturale per i passaggi critici di una pipeline agentica (decisioni, orchestrazione, verifica). La seconda è che un modello Pro proprietario permette ad AWS di ottimizzare serving e costi su Trainium e GPU senza dipendere dalle roadmap di provider terzi.

Nova 2 Sonic: voice-to-voice realtime come inferenza nativa

Nova 2 Sonic colloca la famiglia nel dominio conversazionale in tempo reale. Garman lo presenta come “prossima generazione di speech-to-speech” in grado di offrire AI conversazionale realtime “con tono umano per tutte le applicazioni”. L’elemento tecnico distintivo è la natività speech-to-speech: non un sistema che trascrive, poi ragiona, poi sintetizza, ma un modello progettato per minimizzare passaggi intermedi e quindi abbattere la latenza percepita nelle interazioni vocali. Per i casi d’uso agentici questo vuol dire poter usare la voce non solo come interfaccia utente, ma come canale operativo in contact center, assistenza tecnica, ambienti industriali o retail, dove il tempo di risposta è un requisito funzionale.

Nova 2 Omni: multimodalità unificata, non “a collage”

Il salto più distintivo della generazione è Nova 2 Omni. Garman parte da una constatazione sui limiti attuali dei modelli multimodali: tipicamente ragionano bene su una modalità per volta, mentre la realtà aziendale obbliga a collegare segnali diversi nello stesso contesto. Da qui la proposta di un modello unico per ragionamento e generazione multimodale: Omni viene definito “un modello unificato per ragionamento multimodale e generazione di immagini” e soprattutto “il primo modello di ragionamento del settore che supporta input testo, immagine, video e audio e output di testo e immagine”. Il punto non è solo l’ampliamento delle modalità, ma la loro co-presenza in un unico contesto di inferenza, evitando architetture dove si concatenano modelli diversi con perdita di contesto o incoerenze.

Per gli agenti questa è una condizione abilitante: se l’obiettivo operativo dipende da segnali visivi, audio e testuali nello stesso workflow (ad esempio assistenza tecnica su video, monitoraggio qualità, analisi documentale con immagini, interazioni voce-campo), Omni evita di spezzare la catena inferenziale in componenti eterogenei. La multimodalità diventa quindi proprietà del runtime, non integrazione artigianale.

Governance portabile: Guardrails come “piano di controllo” dell’inferenza

In un ambiente multi-modello, la governance deve restare uniforme. Garman richiama il ruolo dei Bedrock Guardrails come piano di controllo applicabile a modelli di provider diversi, evitando che cambiare modello costringa a rifare policy di sicurezza o compliance. Il senso è operativo: in una catena agentica l’azienda può usare modelli diversi per step diversi, ma vuole applicare le stesse regole di sicurezza, privacy e comportamento. Guardrails fornisce questa continuità.

Un runtime per un’AI fatta di scelte

Il quadro complessivo del livello inferenziale resta coerente con la tesi agent-first. Bedrock cresce perché l’inferenza diventa infrastruttura di processo, non endpoint sperimentale. L’ampliamento open-weight spinge varietà e adattabilità; Nova 2 garantisce una linea interna ottimizzata per costi, latenza e integrazione profonda con lo stack AWS, con profili diversi per scala economica (Lite), compiti critici (Pro), voce realtime (Sonic) e multimodalità unificata (Omni). Il collante è un runtime che rende queste scelte progettuali e governabili, invece che episodiche.

Leggi anche:

- AWS re:Invent 2025: potenziare l’infrastruttura AI per ridurre il costo marginale degli agenti e la latenza operativa

- AWS re:Invent 2025: consolidare l’inferenza multi-modello per scegliere il modello giusto per ogni processo

- AWS re:Invent 2025: innestare i dati proprietari nel training e nel retrieval per trasformarli in vantaggio competitivo

- AWS re:Invent 2025: portare gli agenti nei workflow aziendali per modernizzare applicazioni e automatizzare operations

- AWS re:Invent 2025: governare gli agenti in produzione con controlli deterministici e qualità misurabili