Dopo circa un semestre dalla pubblicazione del suo report 2024: The State of Generative AI in the Enterprise, Menlo Ventures condivide un aggiornamento di metà anno 2025 sul mercato LLM e sul panorama dei modelli foundation.

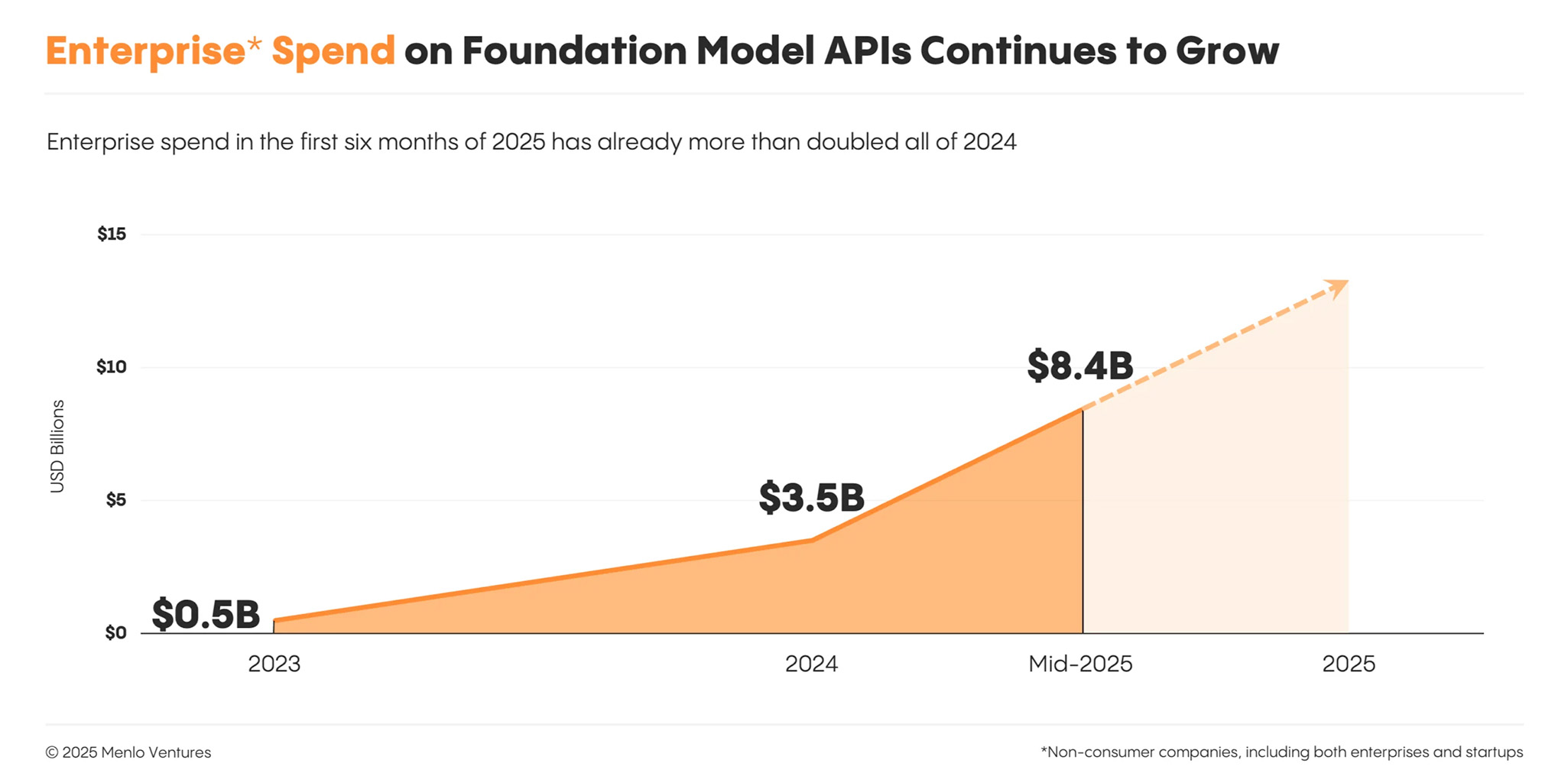

Secondo l’analisi di Menlo Ventures, la spesa per le API dei modelli è più che raddoppiata in questo breve periodo, passando da 3,5 miliardi di dollari (su una spesa totale di 13,8 miliardi di dollari per l’IA generativa stimata lo scorso anno) a 8,4 miliardi di dollari. Le imprese stanno aumentando l’inferenza di produzione piuttosto che limitarsi allo sviluppo di modelli, segnando un cambiamento rispetto agli anni precedenti.

La generazione di codice è diventata il primo caso d’uso di successo dell’IA, sottolinea inoltre la società di venture capital. Oltre al pre-addestramento, i modelli di base si stanno ora espandendo lungo un secondo asse: l’apprendimento per rinforzo con verificatori. E mentre l’open source continua a progredire, il rallentamento delle innovazioni all’avanguardia da parte dei laboratori occidentali ha temperato quella che in precedenza era stata una crescita nell’adozione da parte delle imprese.

Di conseguenza, gli investimenti delle imprese si stanno ora consolidando attorno ad alcuni modelli chiusi ad alte prestazioni, dando vita a un nuovo leader di mercato, secondo Menlo Ventures: Anthropic.

Per cogliere lo stato attuale del mercato LLM, il team di Menlo Ventures ha intervistato oltre 150 leader tecnici di startup e aziende sul livello di base dello stack AI moderno: chi sta guadagnando quote di mercato, cosa è in produzione e quali sono i criteri di selezione che determinano l’intero stack.

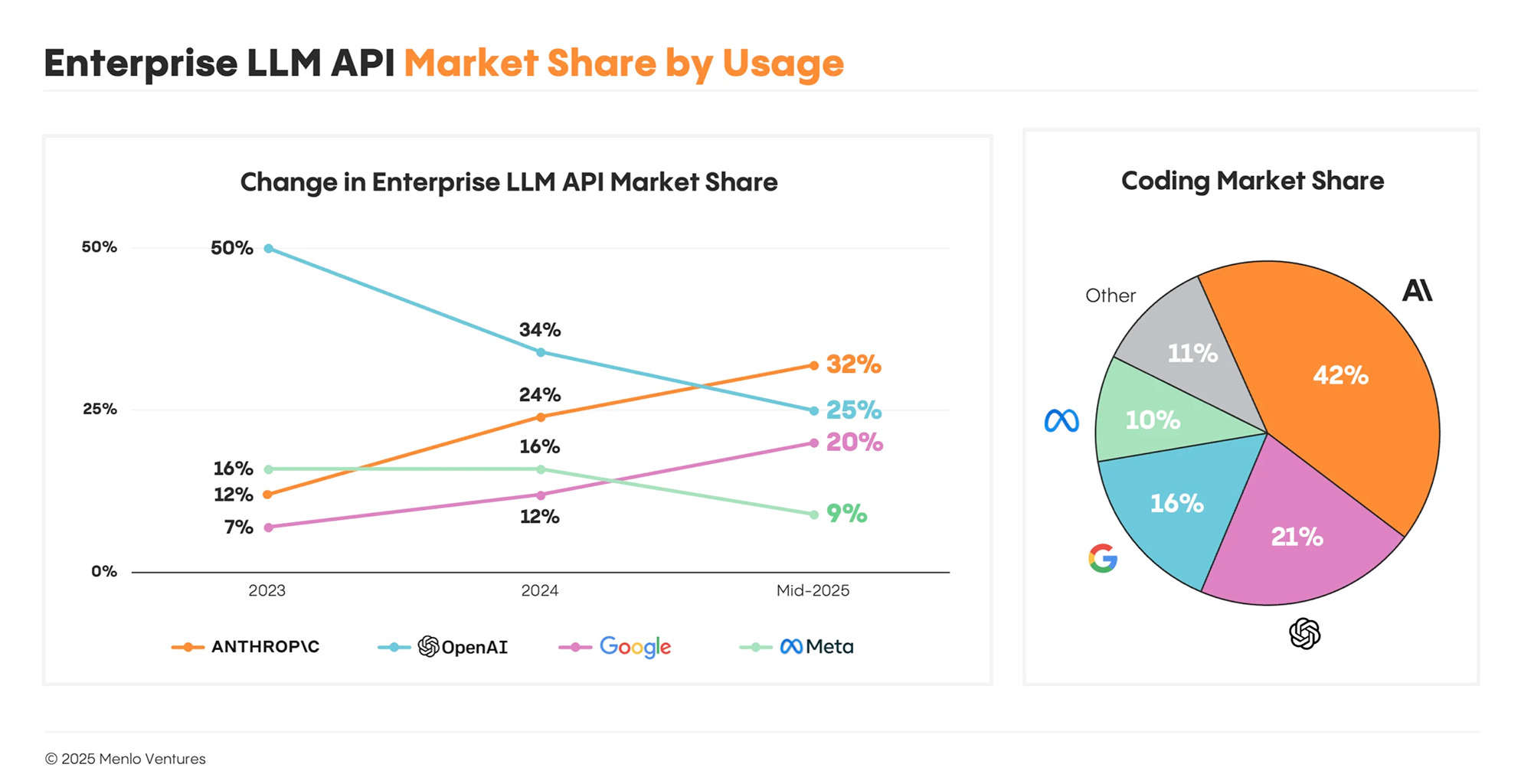

Alla fine del 2023, OpenAI controllava il 50% del mercato LLM enterprise, ma il suo vantaggio iniziale si è ridotto. Oggi, secondo il report di Menlo Ventures, detiene solo il 25% dell’utilizzo aziendale, la metà di quello che deteneva due anni fa.

Alla fine del 2023, OpenAI controllava il 50% del mercato LLM enterprise, ma il suo vantaggio iniziale si è ridotto. Oggi, secondo il report di Menlo Ventures, detiene solo il 25% dell’utilizzo aziendale, la metà di quello che deteneva due anni fa.

Anthropic è il nuovo leader nei mercati dell’AI enterprise con il 32%, davanti a OpenAI e Google (20%), che ha registrato una forte crescita negli ultimi mesi. Llama di Meta detiene il 9%, mentre DeepSeek, nonostante il suo lancio di alto profilo all’inizio dell’anno, rappresenta solo l’1%.

Lo slancio che ha portato Anthropic in cima alla classifica LLM è iniziato sul serio con il rilascio di Claude Sonnet 3.5 nel giugno 2024. Tale slancio ha subito un’accelerazione con Claude Sonnet 3.7 nel febbraio 2025, che ha introdotto il primo vero assaggio di un LLM agent-first. Nel maggio 2025, Claude Sonnet 4, Opus 4 e Claude Code hanno consolidato il primato di Anthropic.

Menlo Ventures individua tre tendenze in grado di definire il settore LLM, che hanno alimentato lo slancio di Anthropic.

Il primo trend è che la generazione di codice è diventata la prima killer app dell’IA. Claude è diventato rapidamente la scelta preferita dagli sviluppatori per la generazione di codice, conquistando il 42% della quota di mercato, più del doppio di OpenAI (21%). In appena un anno, Claude ha contribuito a trasformare uno spazio monoprodotto (GitHub Copilot) in un ecosistema da 1,9 miliardi di dollari. Il rilascio di Claude Sonnet 3.5 nel giugno 2024 ha dimostrato come le innovazioni a livello di modello possano influenzare i mercati delle applicazioni, rendendo possibili categorie completamente nuove come gli IDE di IA (Cursor, Windsurf), gli app builder (Lovable, Bolt, Replit) e gli agenti di coding enterprise (Claude Code, All Hands).

Secondo trend: l’apprendimento per rinforzo con verificatori è il nuovo percorso per scalare l’intelligenza. Nel 2024, il modo principale per scalare l’intelligenza era pre-addestrare modelli sempre più grandi con sempre più dati. La portata dei dati Internet sta ora diventando un limite. Il post-addestramento utilizzando l’apprendimento rinforzato con ricompense verificabili (RLVR, reinforcement learning with verifiable rewards) è stato il passo successivo per superare i limiti. Questa strategia funziona particolarmente bene in campi come la programmazione, che è più facile da verificare in modo deterministico.

Infine, la terza tendenza consiste nel fatto che addestrare i modelli come “agenti” per utilizzare strumenti li rende molto più utili. Gli LLM sono stati inizialmente progettati per fornire risposte complete in un’unica risposta. Tuttavia, consentire loro di pensare passo dopo passo, ragionare sui problemi e utilizzare strumenti esterni in più interazioni, creando ciò che è noto come agente, li rende notevolmente più efficaci per le applicazioni nel mondo reale.

Il 2025 è diventato noto come “l‘anno degli agenti“. Anthropic ha aperto la strada all’addestramento di modelli per migliorare iterativamente le loro risposte e integrare strumenti come motori di ricerca, calcolatrici, ambienti di coding e altre risorse attraverso l’MCP (model context protocol), aumentando significativamente sia le loro capacità che l’adozione da parte degli utenti.

Il 2025 è diventato noto come “l‘anno degli agenti“. Anthropic ha aperto la strada all’addestramento di modelli per migliorare iterativamente le loro risposte e integrare strumenti come motori di ricerca, calcolatrici, ambienti di coding e altre risorse attraverso l’MCP (model context protocol), aumentando significativamente sia le loro capacità che l’adozione da parte degli utenti.

Sempre in base al report di Menlo Ventures, l’adozione dell’open source nelle aziende si sta stabilizzando. Il 13% dei carichi di lavoro di IA oggi utilizzerebbe modelli open source, in leggero calo rispetto al 19% di sei mesi fa. Il leader di mercato rimane il popolare modello Llama di Meta, anche se il lancio di Llama 4 ad aprile ha deluso le aspettative in contesti reali.

Inoltre, passare da un fornitore all’altro è relativamente facile, ma sempre più raro, secondo Menlo Ventures. La maggior parte dei team rimane con il proprio fornitore e si limita ad aggiornare il modello più recente non appena disponibile. Una volta che i costruttori si impegnano con una piattaforma, tendono a rimanere, ma passano rapidamente ad aggiornare i modelli più recenti e più performanti quando vengono rilasciati.

Le prestazioni guidano le decisioni. I builder scelgono costantemente modelli all’avanguardia rispetto ad alternative più economiche e veloci. Danno priorità alle prestazioni e sono disposti a pagare per averle. Quando escono nuovi modelli, il passaggio avviene nel giro di poche settimane. Ad esempio, entro un mese dal rilascio di Claude 4, Claude 4 Sonnet ha conquistato il 45% degli utenti di Anthropic, mentre la quota di Sonnet 3.5 è scesa dall’83% al 16%.

Questo crea una dinamica di mercato inaspettata: anche se il prezzo dei singoli modelli scende di 10 volte, i builder non ottengono risparmi utilizzando modelli più vecchi, ma si spostano semplicemente in massa verso quello con le migliori prestazioni.

La spesa per l’AI si sta spostando dalla formazione all’inferenza, prosegue l’analisi di Menlo Ventures. La spesa per l’elaborazione dati si sta spostando progressivamente dalla creazione e formazione dei modelli all’inferenza, con modelli effettivamente in esecuzione nella produzione. Questo cambiamento è più evidente tra le startup: il 74% dei builder afferma ora che la maggior parte dei propri carichi di lavoro riguarda l’inferenza, rispetto al 48% di un anno fa.

Le grandi imprese non sono molto indietro. Quasi la metà (49%) riferisce che la maggior parte o quasi tutta la propria elaborazione è guidata dall’inferenza, in aumento rispetto al 29% dello scorso anno.

È possibile consultare il report originale completo sul sito di Menlo Ventures.