Negli ultimi due anni, l’intelligenza artificiale è passata da sperimentazione a infrastruttura. Gli agenti autonomi — software capaci di prendere decisioni, eseguire comandi, modificare ambienti digitali — sono diventati parte integrante del tessuto operativo delle imprese. Con l’aumento dell’autonomia è cresciuto anche il rischio: un agente che opera senza supervisione può amplificare un errore in pochi secondi, modificare dataset critici o compromettere intere pipeline applicative.

È in questo contesto che Rubrik, azienda statunitense nata come specialista di data protection e che oggi si posiziona come Security and AI Operations Company, ha introdotto Rubrik Agent Cloud: una piattaforma disegnata non per fermare gli agenti AI, ma per governarli, tracciarli e correggerli.

“I leader IT e di sicurezza spesso non sanno che cosa stiano facendo i loro agenti AI, né come annullarne gli errori” ha osservato Bipul Sinha, CEO e cofondatore. “Con Agent Cloud vogliamo dare loro la possibilità di sapere quali agenti hanno, cosa fanno, a quali dati accedono e — soprattutto — se è possibile tornare indietro quando sbagliano”.

La logica è la stessa che, negli anni Duemila, trasformò il concetto di backup in quello di data recovery: non basta più salvare, serve poter ripristinare. Ora lo stesso principio viene applicato alla sfera cognitiva: non basta conoscere l’intelligenza artificiale, bisogna poterla “riavvolgere”.

Agent Cloud: una piattaforma che unisce visibilità, controllo e correzione

Rubrik descrive Agent Cloud come il primo strato di controllo enterprise per il ciclo di vita dell’agente AI. Il suo scopo è fornire alle organizzazioni un quadro completo delle interazioni tra intelligenze artificiali, dati e sistemi, trasformando quella che finora è stata una “scatola nera” in un ambiente osservabile e reversibile.

Costruita sulla Rubrik Platform, la soluzione eredita i tre pilastri della sicurezza moderna — dati, identità e applicazioni — integrandoli in una cornice cognitiva. In altre parole, ogni azione di un agente viene letta e registrata nel contesto in cui avviene: chi l’ha compiuta, su quali asset, con quali privilegi, in quale sequenza temporale.

Durante un incontro con Alessio Stellati, vicepresidente per Italia, Spagna e Portogallo, e Giampiero Petrosi, SE Manager per l’Europa meridionale, la strategia è stata sintetizzata in modo chiaro: “L’intelligenza artificiale è un moltiplicatore di efficienza, ma anche di esposizione. Gli agenti possono eseguire centinaia di azioni in pochi secondi. Serve un’infrastruttura che permetta di capire, limitare e — se necessario — tornare indietro”.

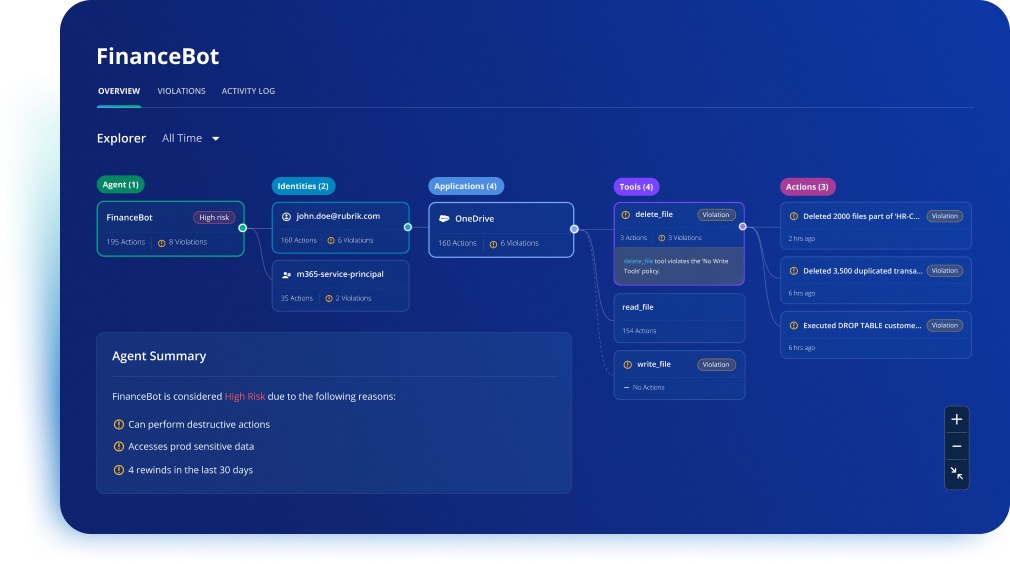

La piattaforma si articola su tre funzioni cardine: Monitor, Govern e Remediate. Queste non sono moduli separati, ma fasi di un ciclo operativo continuo, una specie di “sistema nervoso” dell’AI aziendale.

Agent Monitor: rendere visibile l’invisibile

Il primo livello, Agent Monitor, è dedicato alla visibilità. Scansiona automaticamente ambienti cloud e SaaS — come Azure, AWS, Microsoft 365, Salesforce o ServiceNow — alla ricerca di agenti attivi. Non solo quelli creati in modo formale, ma anche quelli nati per iniziativa dei team o generati da strumenti low-code e Copilot.

Ogni agente individuato viene mappato e classificato secondo parametri di attività, privilegi, frequenza e tipologia di operazioni. Il sistema costruisce una vera e propria mappa cognitiva dell’autonomia aziendale, dove ogni azione è registrata come un evento univoco e immutabile, collegato a un’identità e a un dataset.

Questo permette di rispondere a domande che, finora, non avevano risposta: quali agenti stanno operando? su quali dati? con quali permessi?

Come ha spiegato Petrosi, “Molte aziende non sanno nemmeno quanti agenti AI abbiano attivi nei propri sistemi. Ne esistono all’interno di Copilot, nei workflow RPA, nei CRM. Noi li raccogliamo in un’unica vista e li tracciamo nel tempo”.

L’impatto è culturale prima che tecnico: la scoperta dell’autonomia diffusa. Agent Monitor rappresenta, in questo senso, un primo passo verso la trasparenza dell’intelligenza.

Agent Govern: regole dinamiche per l’autonomia artificiale

Il secondo livello, Agent Govern, interviene dove la visibilità da sola non basta. Una volta mappati gli agenti, occorre stabilire le regole del gioco: quali dati possono essere letti, quali modificati, con quale frequenza, e in quali contesti di fiducia.

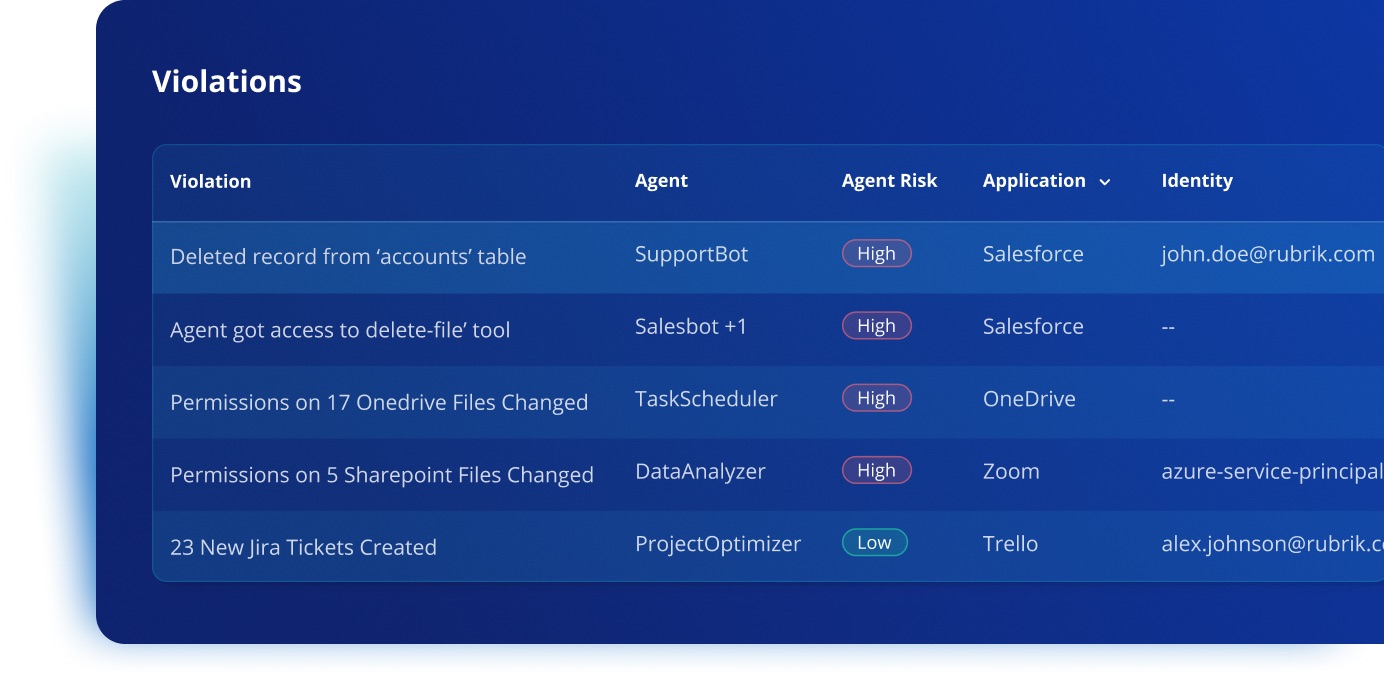

Il sistema definisce policy dinamiche di comportamento, capaci di intervenire in tempo reale. Ogni agente è valutato in base alle sue azioni e ai suoi prompt, e può essere limitato se supera soglie di rischio o devia dalle policy aziendali.

La gestione avviene in stretta integrazione con i servizi di identità: Rubrik applica il principio del least privilege alle identità non umane, evitando che un agente creato per un compito limitato possa, per esempio, accedere ad archivi HR o database finanziari.

“Il controllo non può essere una revisione a posteriori” ha sottolineato Stellati. “Deve essere integrato nell’architettura stessa. È necessario capire perché un agente compie una scelta, non solo che l’ha compiuta”.

Agent Govern introduce inoltre la possibilità di simulare scenari e azioni in ambienti isolati — una sorta di sandbox per l’intelligenza artificiale — in cui verificare l’impatto delle decisioni prima che si propaghino.

L’approccio è quello della governance preventiva: l’AI può agire, ma sempre dentro un perimetro di fiducia verificabile.

Agent Remediate: l’AI che sa “tornare indietro”

Il terzo livello, Agent Remediate, rappresenta il cuore della rivoluzione Rubrik.

È l’erede diretto di Agent Rewind, la tecnologia presentata quest’anno e ora integrata nativamente in Agent Cloud. Il suo scopo è unico: permettere di riavvolgere le azioni indesiderate o distruttive di un agente AI, con la stessa semplicità con cui si ripristina un file da un backup, ma su scala cognitiva.

La piattaforma conserva una timeline semantica di tutte le azioni compiute dagli agenti: ogni prompt, ogni parametro, ogni decisione. Quando viene identificato un errore, Rubrik può tornare indietro esattamente al punto in cui è nato, correggendo solo ciò che serve, senza toccare le azioni corrette successive.

Petrosi l’ha spiegato con un esempio chiaro: “Quando catturi snapshot devi sapere il momento in cui l’agente prende una decisione. Rewind (ora Remediate) ti permette di tornare a quel punto e rimettere tutto in coerenza. È come poter riscrivere la storia operativa di un sistema senza perdere nulla”.

Il funzionamento poggia sulla combinazione tra Rubrik Security Cloud, che assicura immutabilità e versioning dei dati, e l’infrastruttura AI di Predibase, che interpreta la catena causale delle azioni. Ogni rollback è certificato, documentato e reversibile.

Questa capacità di “riavvolgere” non è solo una misura di sicurezza, ma un principio di fiducia: trasforma l’errore da minaccia a informazione utile, da perdita a conoscenza.

Rubrik sintetizza questa visione nel concetto di Cognitive Resilience Loop, un ciclo che prevede l’osservazione, la rilevazione, il riavvolgimento, il ripristino e il governo. È una forma di apprendimento continuo applicata alla sicurezza.

Come ha dichiarato Anneka Gupta, Chief Product Officer di Rubrik, “L’intelligenza artificiale non deve essere solo potente, ma responsabile. Con Agent Cloud diamo alle aziende un modello di fiducia verificabile, applicabile a ogni decisione dell’agente”.

Annapurna: la dorsale sicura della Generative AI

La seconda metà della strategia di Rubrik si chiama Annapurna. Se Agent Cloud è la mente che governa gli agenti, Annapurna ne è la linfa vitale: un’infrastruttura disegnata per garantire che ogni modello di intelligenza artificiale acceda ai dati in modo sicuro, tracciabile e contestuale.

L’obiettivo non è soltanto proteggere i dati, ma stabilire un principio di fiducia verificabile tra chi li gestisce e chi li consuma. Nell’era della Generative AI, infatti, i dati non vengono più soltanto letti: vengono trasformati in risposte, modelli linguistici, insight e automazioni. Rubrik parte da un assunto preciso: se l’intelligenza che genera valore parte da dati opachi, anche il risultato è opaco. Annapurna serve a rendere la sorgente dei dati trasparente e controllata, prima che diventi conoscenza.

Un ponte tra Rubrik Security Cloud e Amazon Bedrock

Annapurna nasce come API layer tra Rubrik Security Cloud e l’ecosistema Amazon Bedrock, la piattaforma AWS che ospita modelli linguistici come Claude, Llama 3, Titan o Mistral.

In questa posizione, Annapurna agisce come strato di mediazione intelligente: intercetta le richieste dei modelli AI verso i dati aziendali, verifica chi le formula, che cosa chiede, da dove proviene e quale livello di autorizzazione possiede.

Ogni query viene arricchita con metadati di identità, policy e contesto applicativo, così da mantenere un audit trail completo e immutabile.

La differenza rispetto a un tradizionale gateway d’accesso è che Annapurna comprende il contenuto dei dati, non solo la loro forma. È in grado di interpretare la semantica delle informazioni — tabelle, log, conversazioni, documenti, ticket, record — e di riconoscere quando un’informazione è sensibile o fuori contesto rispetto al prompt dell’agente.

Questo approccio consente di bloccare le richieste improprie prima che raggiungano il modello, evitando che informazioni riservate finiscano nel corpus di addestramento o vengano restituite come output a utenti non autorizzati.

Motore di embedding “application-aware”

Uno degli aspetti più innovativi di Annapurna è il suo motore di embedding “application-aware”.

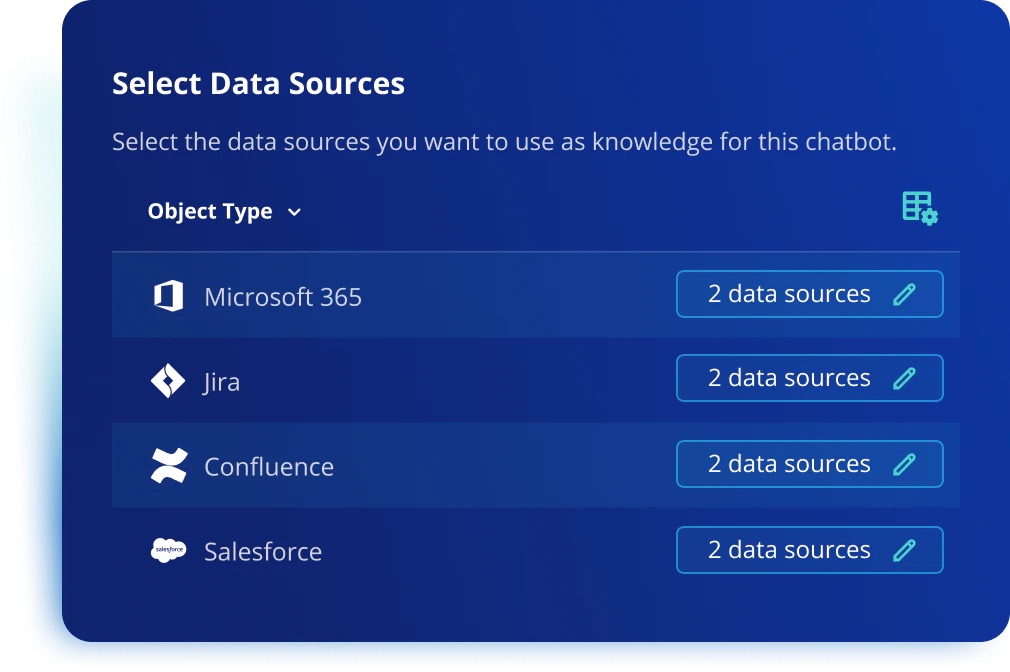

Rubrik ha progettato la piattaforma per comprendere la struttura e la semantica delle applicazioni enterprise più diffuse — da Salesforce a ServiceNow, da Teams a SAP — mappando in modo nativo i loro schemi dati, permessi e logiche di business.

In pratica, quando un agente AI o un modello generativo effettua una richiesta, Annapurna non si limita a passare i dati: li normalizza, filtra e contestualizza, restituendo al modello solo le informazioni rilevanti e consentite.

Questo riduce drasticamente il rischio di data leakage e garantisce che la generative AI lavori su dataset coerenti, aggiornati e conformi alle regole aziendali.

L’integrazione con le architetture Retrieval-Augmented Generation (RAG) è nativa. Annapurna fornisce un accesso verificato e “zero-copy” alle fonti dati, evitando di duplicare informazioni in ambienti non protetti e semplificando la creazione di knowledge base aziendali affidabili.

Come ha spiegato Giampiero Petrosi, “il nostro approccio parte dal presupposto di non fidarsi del modello. Guardiamo i dataset prima che l’intelligenza artificiale li usi, perché dopo non c’è modo di controllare il danno”.

Il modello di fiducia: governance prima del dato

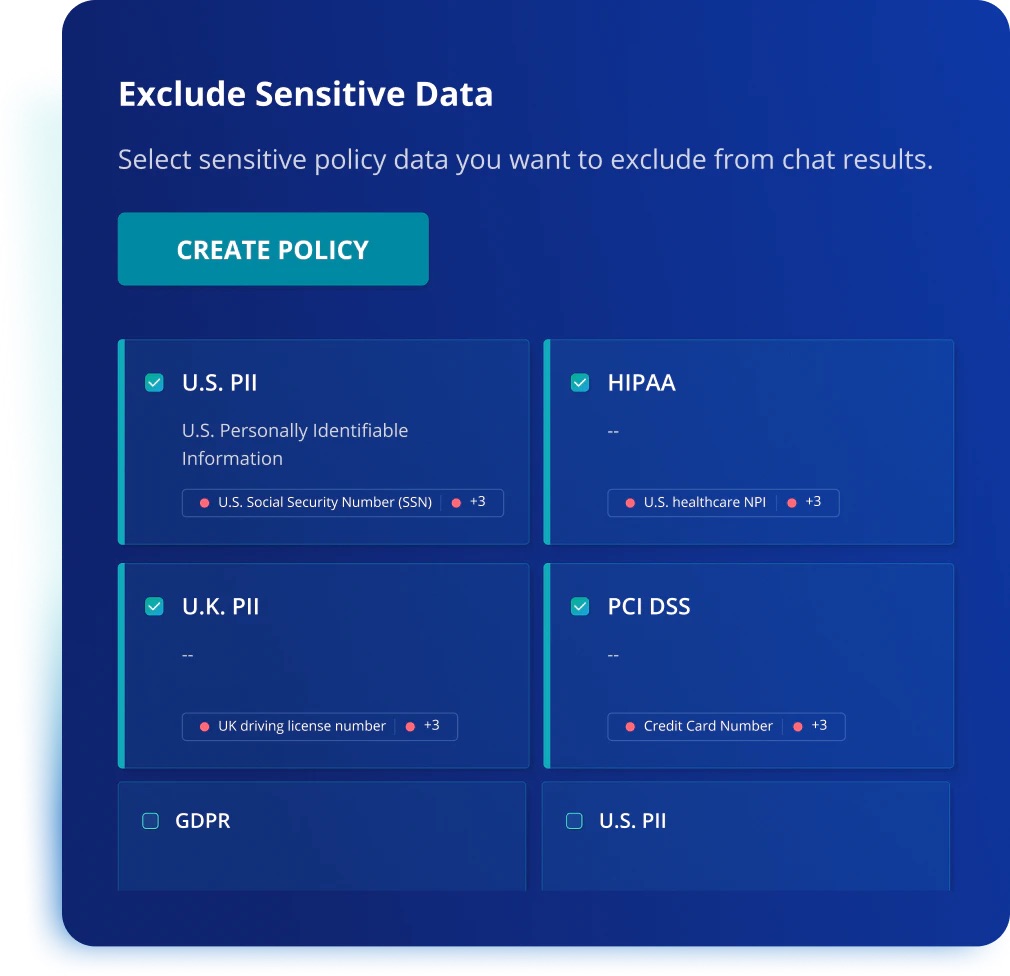

Annapurna non si limita a proteggere le informazioni: istituisce un modello di governance preventiva del dato.

Ogni accesso viene validato in tempo reale secondo tre coordinate: chi richiede, che cosa chiede, in quale contesto operativo.

La piattaforma genera una traccia audit che consente di risalire a ogni singola richiesta e di verificare se l’informazione è stata utilizzata, trasformata o rigenerata da un agente AI.

È un cambiamento profondo nel paradigma della sicurezza. Finora la protezione dei dati avveniva dopo l’uso, attraverso sistemi DLP o controlli di compliance. Annapurna sposta il baricentro prima dell’accesso, dove il rischio nasce.

È un meccanismo di prevention by design che, nelle parole di Rubrik, “anticipa la deviazione invece di reagire alla violazione”.

Impatti sul business e sulle operations

Dal punto di vista operativo, Annapurna consente alle aziende di liberare i dati per l’AI senza creare copie, tunnel o zone grigie.

Questo riduce i costi di storage e di orchestrazione, ma soprattutto elimina il fenomeno degli shadow datastore: copie non governate di dati sensibili generate per alimentare prototipi di intelligenza artificiale.

Per i CISO e i responsabili dati, significa poter approvare progetti di AI generativa con visibilità e controllo, sapendo esattamente quali dataset vengono toccati, da chi e per quale scopo.

Per i team IT e i data scientist, significa avere una pipeline certificata dove i dati sono aggiornati, anonimizzati e referenziati in modo consistente.

Annapurna si inserisce così nel quadro più ampio della AI governance delineata da Rubrik, che collega le tre dimensioni della fiducia: dati, la materia prima; identità, l’autorizzazione; intelligenza, l’autonomia. Quando queste tre componenti si parlano in modo coerente, l’automazione non è più un rischio, ma un moltiplicatore controllato.

L’Italia come banco di prova della resilienza cognitiva

L’Italia è diventata uno dei mercati chiave per Rubrik in Europa. La filiale di Milano — oggi hub operativo per Italia, Spagna e Portogallo — sta registrando una crescita superiore alla media globale.

“Negli ultimi tre anni abbiamo sempre superato la crescita della concorrenza” ha dichiarato Stellati. “Il mercato italiano è maturo, consapevole e pronto a investire in piattaforme che uniscono sicurezza e intelligenza”.

Tra i settori più attivi spicca il retail, che unisce alti volumi di dati, automazione diffusa e vulnerabilità crescente. “Il retail italiano è quello con la crescita più elevata, ma anche con la maggiore esposizione agli attacchi informatici” ha aggiunto Petrosi. “Stiamo vedendo un cambio di mentalità: le aziende non chiedono più solo se possono ripartire, ma in quanto tempo e con quali garanzie. È la nascita di una cultura della fiducia digitale”.

L’Italia, per Rubrik, è quindi un laboratorio naturale per la resilienza cognitiva: un ecosistema in cui le imprese possono adottare l’AI senza rinunciare al controllo, unendo rapidità di risposta e responsabilità operativa.

Dalla sicurezza all’intelligenza

Con Agent Cloud e Annapurna, Rubrik non parla più di cybersecurity nel senso classico del termine. Parla di intelligenza della sicurezza: un sistema in grado di osservare, comprendere e correggere.

La differenza è sostanziale. Se la sicurezza tradizionale mira a bloccare gli incidenti, quella cognitiva mira a spiegarli e a trarne insegnamento.

Come ha sintetizzato Petrosi in chiusura, “Non è solo questione di proteggere, ma di sapere cosa è successo, come e di poter tornare indietro”.

È una visione che sposta la sicurezza dal dominio tecnico a quello epistemologico: la capacità di un sistema di riflettere su se stesso.

L’Italia, con la sua crescita a doppia cifra e la spinta verso la digitalizzazione responsabile, è il terreno ideale per questa trasformazione. Qui la fiducia non è un punto di partenza, ma un risultato da costruire: la fiducia operativa in un’intelligenza che non solo agisce, ma sa anche correggere se stessa.