Facendo seguito al lancio di Phi-4 con 14B parametri, Microsoft ha ora annunciato Phi-4-multimodal e Phi-4-mini, i nuovi modelli della famiglia di modelli linguistici di piccole dimensioni (SLM, Small Language Model) dell’azienda.

Questi modelli – spiega Microsoft – sono stati progettati per offrire agli sviluppatori funzionalità avanzate di intelligenza artificiale. Phi-4-multimodal, con la sua capacità di elaborare simultaneamente parlato, vision e testo, apre nuove possibilità per la creazione di applicazioni innovative e consapevoli del contesto. Phi-4-mini, invece, eccelle nei compiti basati sul testo, offrendo elevata precisione e scalabilità in una forma compatta.

Ora disponibili in Azure AI Foundry, HuggingFace e nell’NVIDIA API Catalog, dove gli sviluppatori possono esplorare tutto il potenziale di Phi-4-multimodal per sperimentare e innovare con facilità.

Il team sottolinea che Phi-4-multimodal segna una nuova pietra miliare nello sviluppo dell’intelligenza artificiale di Microsoft, essendo il primo modello linguistico multimodale dell’azienda che, in risposta al feedback dei clienti, ha sviluppato questo modello con 5,6 miliardi di parametri che integra perfettamente l’elaborazione di parlato, vision e testo in un’unica architettura unificata.

Sfruttando tecniche avanzate di apprendimento cross-modale, questo modello consente interazioni più naturali e consapevoli del contesto, permettendo ai dispositivi di comprendere e ragionare simultaneamente su più modalità di input. Sia che si tratti di interpretare il linguaggio parlato, di analizzare immagini o di elaborare informazioni testuali, il modello offre un’inferenza altamente efficiente e a bassa latenza, sostiene il team, il tutto ottimizzando l’esecuzione sul dispositivo e riducendo i costi di calcolo.

Phi-4-multimodal è un singolo modello con mixture-of-LoRA che include il parlato, la vision e il linguaggio, tutti elaborati simultaneamente nello stesso spazio di rappresentazione. Il risultato è un modello unico e unificato in grado di gestire input testuali, audio e visivi, senza bisogno di pipeline complesse o modelli separati per le diverse modalità.

Phi-4-multimodal è un singolo modello con mixture-of-LoRA che include il parlato, la vision e il linguaggio, tutti elaborati simultaneamente nello stesso spazio di rappresentazione. Il risultato è un modello unico e unificato in grado di gestire input testuali, audio e visivi, senza bisogno di pipeline complesse o modelli separati per le diverse modalità.

Phi-4-multimodal è costruito su una nuova architettura che migliora l’efficienza e la scalabilità, sottolinea inoltre Microsoft. Incorpora un vocabolario più ampio per una migliore elaborazione, supporta funzionalità multilingue e integra il ragionamento linguistico con gli input multimodali. Tutto questo è ottenuto con un modello potente, compatto e altamente efficiente, adatto all’implementazione su dispositivi e piattaforme di edge computing.

Secondo Microsoft questo modello rappresenta un passo avanti per la famiglia di modelli Phi, offrendo prestazioni migliorate in un pacchetto di dimensioni ridotte. Per chi è alla ricerca di funzionalità AI avanzate su dispositivi mobili o sistemi edge, Phi-4-multimodal rappresenta un’opzione ad alta capacità, efficiente e versatile.

Phi-4-mini è invece un modello con 3,8 miliardi di parametri e un transformer denso basato solo sul decoder, con Grouped-Query Attention, 200.000 vocaboli e embeddings di input-output condivisi, progettato per garantire velocità ed efficienza. Nonostante le sue dimensioni compatte, continua a superare modelli più grandi in compiti basati sul testo, tra cui il ragionamento, la matematica, il coding, l’instruction-following e function-calling. Supportando sequenze fino a 128.000 token, offre un’elevata precisione e scalabilità, rendendolo una soluzione potente per le applicazioni AI avanzate.

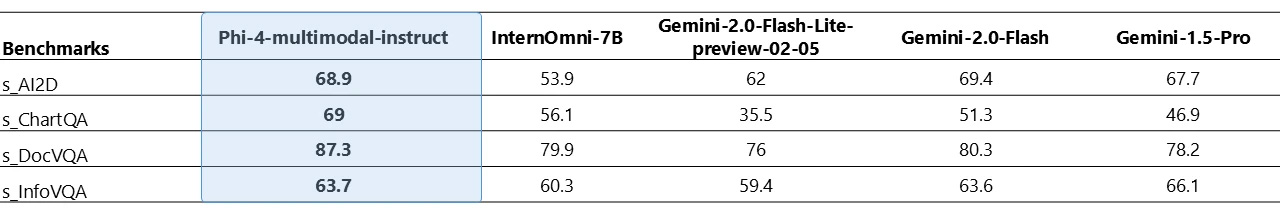

Maggiori informazioni e benchmark sono disponibili nel blog di Microsoft Azure, così come nella scheda del modello per Phi-4-multimodal e Phi-4-mini, e nel paper tecnico.