Microsoft ha annunciato che i primi modelli della famiglia Llama 4 sono ora disponibili in Azure AI Foundry e Azure Databricks, strumenti che consentono di costruire esperienze multimodali più personalizzate.

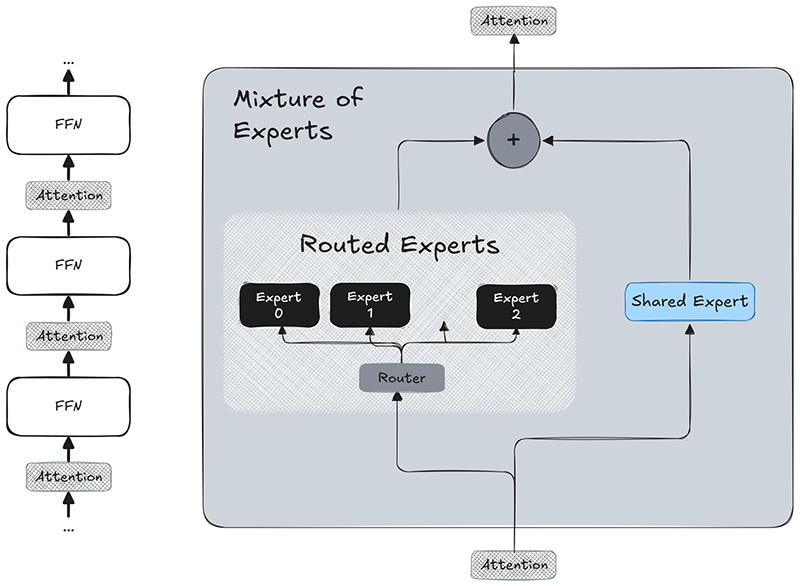

Questi modelli rilasciati di recente da Meta – e di cui anche IBM ha da poco annunciato la disponibilità sulla piattaforma watsonx – sono progettati per integrare perfettamente i token di testo e di visione in una struttura portante unificata. Questo approccio innovativo consente agli sviluppatori di utilizzare i modelli Llama 4 in applicazioni che richiedono grandi quantità di dati testuali, immagini e video non etichettati, creando un nuovo precedente nello sviluppo dell’intelligenza artificiale, sottolinea Microsoft.

Microsoft ha portato i modelli Llama 4 Scout e Maverick di Meta in Azure AI Foundry come offerta di calcolo gestito:

Microsoft ha portato i modelli Llama 4 Scout e Maverick di Meta in Azure AI Foundry come offerta di calcolo gestito:

Modelli Llama 4 Scout:

- Llama-4-Scout-17B-16E

- Llama-4-Scout-17B-16E-Instruct

Modelli Llama 4 Maverick:

- Llama 4-Maverick-17B-128E-Instruct-FP8

Microsoft ha progettato Azure AI Foundry per i casi d’uso multi-agente, consentendo una collaborazione senza soluzione di continuità tra diversi agenti AI. Questo apre nuove frontiere nelle applicazioni AI, dalla risoluzione di problemi complessi alla gestione dinamica dei compiti. Microsoft fa l’esempio di un team di agenti AI che lavorano insieme per analizzare vasti set di dati, generare contenuti creativi e fornire approfondimenti in tempo reale in diversi ambiti, con possibilità pressoché infinite.

Per soddisfare una vasta gamma di casi d’uso e di esigenze degli sviluppatori, i modelli Llama 4 sono disponibili in opzioni più piccole e più grandi. Questi modelli integrano le mitigazioni a ogni livello di sviluppo, dal pre-training al post-training, mette in evidenza Microsoft. Le mitigazioni regolabili a livello di sistema proteggono gli sviluppatori dagli utenti avversari, consentendo loro di creare esperienze utili, sicure e adattabili per le loro applicazioni supportate da Llama.

Per quanto riguarda, Llama 4 Scout, Microsoft sottolinea che i casi d’uso target includono la sintesi, la personalizzazione e il ragionamento. Grazie al suo lungo contesto e alle sue dimensioni efficienti, è particolarmente adatto ai task che richiedono di condensare o analizzare informazioni estese. È in grado di generare sintesi o rapporti da input estremamente lunghi, di personalizzare le risposte utilizzando dati dettagliati specifici dell’utente (senza dimenticare i dettagli precedenti) e di eseguire ragionamenti complessi su grandi insiemi di conoscenze.

Ad esempio, Scout può analizzare tutti i documenti di una libreria SharePoint aziendale per rispondere a una domanda specifica o leggere un manuale tecnico di migliaia di pagine per fornire consigli sulla risoluzione dei problemi. È stato progettato per essere un diligente “esploratore” che attraversa vaste informazioni e restituisce i punti salienti o le risposte necessarie.

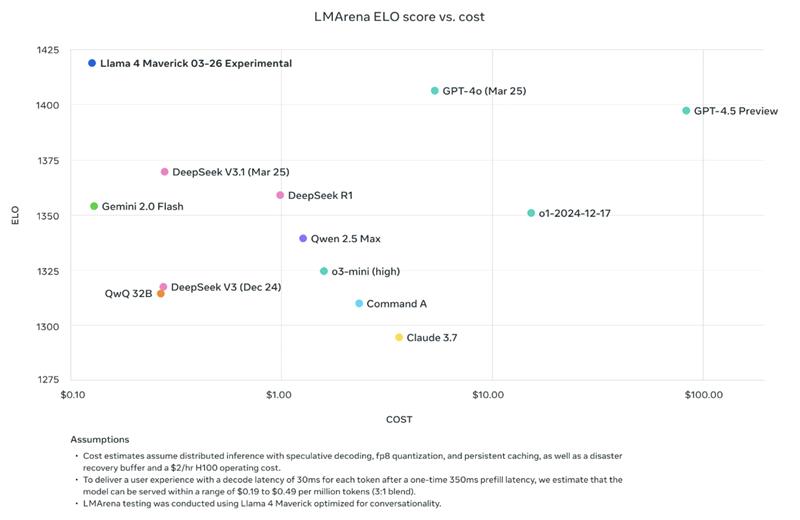

Per Llama 4 Maverick, i casi d’uso target comprendono scenari di chat ottimizzati che richiedono risposte di alta qualità. Meta ha messo a punto Llama 4 Maverick – spiega Microsoft – affinché fosse un eccellente agente di conversazione. È il modello di chat di punta della famiglia Meta Llama 4: Microsoft suggerisce di considerarlo come la controparte multilingue e multimodale di un assistente simile a ChatGPT.

Per Llama 4 Maverick, i casi d’uso target comprendono scenari di chat ottimizzati che richiedono risposte di alta qualità. Meta ha messo a punto Llama 4 Maverick – spiega Microsoft – affinché fosse un eccellente agente di conversazione. È il modello di chat di punta della famiglia Meta Llama 4: Microsoft suggerisce di considerarlo come la controparte multilingue e multimodale di un assistente simile a ChatGPT.

È particolarmente adatto alle applicazioni interattive quali:

- Bot di assistenza clienti che devono comprendere le immagini caricate dagli utenti.

- Partner creativi AI che possono discutere e generare contenuti in varie lingue.

- Assistenti aziendali interni che possono aiutare i dipendenti rispondendo a domande e gestendo input multimediali.

Con Maverick, le aziende possono creare assistenti AI di alta qualità che dialogano in modo naturale (e educato) con una base di utenti globale e sfruttano il contesto visivo quando necessario.

Microsoft mette inoltre in evidenza che Meta ha costruito Llama 4 con le best practice descritte nella Guida all’uso per gli sviluppatori: AI Protections. Ciò include l’integrazione di mitigazioni a ogni livello di sviluppo del modello, dal pre-training al post-training, e mitigazioni regolabili a livello di sistema che proteggono gli sviluppatori da attacchi avversari. Inoltre, rendendo disponibili questi modelli in Azure AI Foundry, essi sono dotati di protezioni di sicurezza comprovate che gli sviluppatori si aspettano da Azure, aggiunge Microsoft.

È ora dunque possibile esplorare i modelli Llama 4 nell’Azure AI Foundry Model Catalog e in Azure Databricks e iniziare a sviluppare con le ultime novità in fatto di AI multimodale e MoE-powered, supportate dalla ricerca di Meta e dalla potenza della piattaforma Azure di Microsoft.