È andata in scena la prima LlamaCon di sempre, l’evento di Meta dedicato agli sviluppatori di tutto il mondo che hanno una cosa in comune: sviluppano con Llama.

LlamaCon 2025 non solo ha visto la presentazione di una serie di innovazioni AI, ha anche celebrato e fatto il punto sullo stato dell’arte della community AI e di quella open source.

La sessione pomeridiana ha ospitato una interessante discussione tra il fondatore e CEO di Meta Mark Zuckerberg e il presidente e CEO di Microsoft Satya Nadella, che hanno esplorato gli sviluppi più all’avanguardia dell’intelligenza artificiale e di come gli sviluppatori possono tenere il ritmo e distinguersi nell’attuale scenario competitivo e in rapido cambiamento.

Sono passati poco più di due anni da quando l’azienda ha lanciato Llama, sottolinea Meta, che ha condiviso di aver superato il miliardo di download in questo periodo. Soprattutto, Llama si è affermato come leader nell’ecosistema dell’intelligenza artificiale open source. Sviluppatori, startup, governi e aziende – sottolinea Meta – stanno adottando con successo Llama, sfruttando le sue capacità per guidare l’innovazione, migliorare l’efficienza e risolvere problemi complessi.

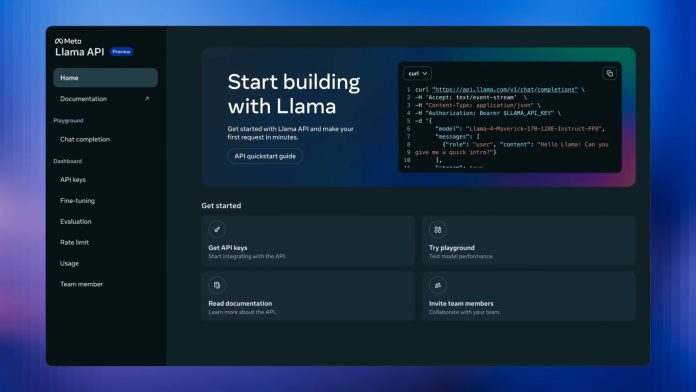

Meta presenta Llama API in preview

Meta presenta Llama API in preview

Meta ha dichiarato di avere l’obiettivo di rendere ancora più facile iniziare a costruire soluzioni rapidamente con Llama, dando allo stesso tempo agli sviluppatori il controllo completo sui propri modelli e pesi senza essere vincolati a un’API. In occasione di LlamaCon 2025 Meta ha annunciato Llama API, la prossima piattaforma per sviluppatori per lo sviluppo di applicazioni Llama, disponibile in anteprima gratuita e limitata.

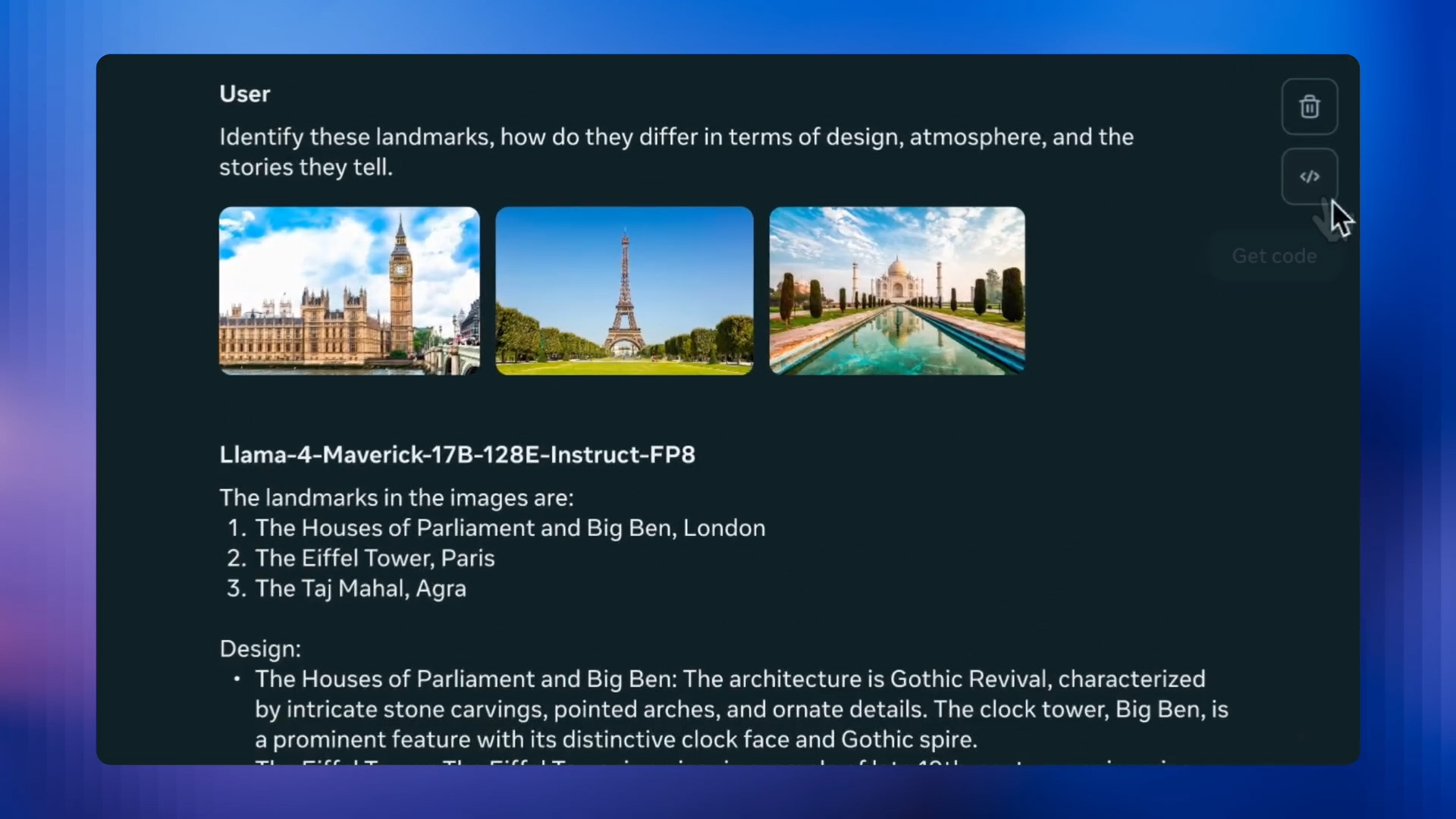

Llama API consente di creare facilmente chiavi API con un solo clic e di creare playground interattivi per esplorare diversi modelli Llama, compresi i modelli Llama 4 Scout e Llama 4 Maverick che sono stati annunciati all’inizio del mese. Quando si è pronti a creare la propria applicazione, Meta fornisce un SDK leggero sia in Python che in Typescript. L’API di Llama è anche compatibile con l’SDK di OpenAI, rendendo facile la conversione delle applicazioni esistenti.

Siccome per gli sviluppatori è importante avere accesso a tool che li aiutino a personalizzare ed eseguire i modelli in modo più efficiente, nell’ambito di questa release Meta condivide gli strumenti per il fine-tuning e la valutazione nella nuova API, dove è possibile mettere a punto le proprie versioni custom del nuovo modello Llama 3.3 8B. L’azienda – sottolinea Meta – condivide questa capacità per aiutare gli sviluppatori a ridurre i costi e al tempo stesso a migliorare la velocità e l’accuratezza.

È possibile generare dati, addestrarli e poi usare la suite di valutazioni per testare facilmente la qualità del proprio nuovo modello. Rendere le valutazioni più accessibili e più facili da eseguire aiuterà a passare dal seguire l’intuito all’affidarsi ai dati, assicurandosi di avere modelli che funzionano bene per soddisfare le proprie esigenze.

La sicurezza e la privacy dei contenuti e dei dati degli utenti sono la massima priorità di Meta, afferma l’azienda, che dichiara di non utilizzare i prompt o le risposte per addestrare i suoi modelli AI. Quando gli sviluppatori sono pronti, i modelli costruiti con l’API di Llama possono essere portati ovunque li si voglia ospitare, e Meta non li tiene bloccati sui suoi server. L’azienda sta introducendo queste funzionalità per alcuni clienti selezionati, ma ha in programma un’estensione più ampia nelle prossime settimane e mesi. Questo aprirà agli sviluppatori nuove possibilità di creare modelli personalizzati per ogni tipo di caso d’uso.

Questa preview è solo il primo passo per l’API Llama, preannuncia Meta, che intende utilizzare il feedback delle persone e delle aziende che la useranno per migliorare le versioni future. Chi è interessato a candidarsi per uno dei primi posti limitati per l’anteprima gratuita, può compilare l’apposito modulo.

Inferenza veloce con l’API Llama e nuove integrazioni di Llama Stack

Inferenza veloce con l’API Llama e nuove integrazioni di Llama Stack

Meta ha poi annunciato una collaborazione con Cerebras e Groq che consentirà a un maggior numero di sviluppatori Llama di raggiungere una maggiore velocità di inferenza utilizzando le API Llama. L’accesso sperimentale anticipato ai modelli Llama 4 alimentati da Cerebras e Groq è ora disponibile su richiesta, e offre un modo conveniente per gli sviluppatori di sperimentare e prototipare casi d’uso prima di scalare con il fornitore scelto.

Selezionando semplicemente i nomi dei modelli Cerebras o Groq nell’API, gli sviluppatori possono sfruttare questa funzionalità e godere di un’esperienza semplificata con tutti gli utilizzi tracciati in un’unica posizione. Questa collaborazione – sottolinea l’azienda – rafforza l’impegno di Meta a promuovere un ecosistema diversificato che offra flessibilità e scelta. Meta si è detta intenzionata a espandere le partnership con altri fornitori per offrire ancora più opzioni.

Gli sviluppatori hanno inoltre chiesto – ha messo in evidenza Meta – di rendere più semplice la fase di deployment delle applicazioni utilizzando diversi fornitori di servizi. L’anno scorso l’azienda ha collaborato con i partner per creare distribuzioni Llama Stack per i loro clienti aziendali a valle.

Quest’anno Meta sta ampliando queste collaborazioni, compresa l’integrazione recentemente annunciata di Llama Stack con i microservizi NVIDIA NeMo, e sta lavorando a stretto contatto con partner come IBM, Red Hat, Dell Technologies e altri su nuove integrazioni che saranno presto annunciate. Insieme ai suoi partner, meta prevede che Llama Stack diventi lo standard del settore per le aziende che desiderano implementare senza problemi soluzioni AI chiavi in mano di livello produttivo.

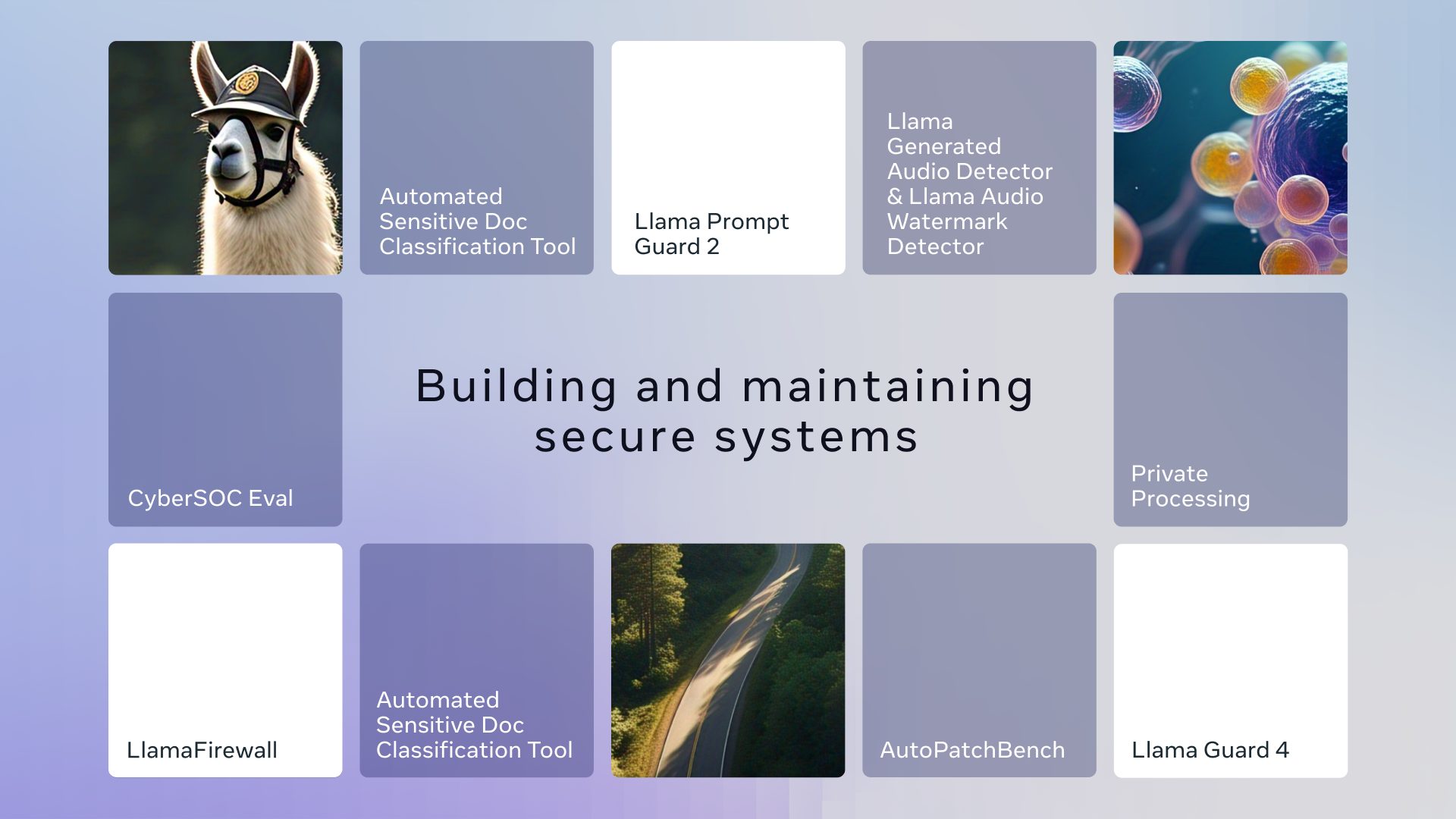

Per quanto riguarda la sicurezza, Meta si impegna a fornire agli sviluppatori i migliori strumenti e risorse per creare applicazioni AI sicure. In occasione di LlamaCon 2025 l’azienda ha rilasciato nuovi strumenti di protezione Llama per la comunità open source, tra cui Llama Guard 4, LlamaFirewall e Llama Prompt Guard 2. Ha condiviso anche gli aggiornamenti per aiutare le organizzazioni a valutare l’efficacia dei sistemi AI nelle operazioni di sicurezza con CyberSecEval 4, oltre ad annunciare il Llama Defenders Program per partner selezionati.

Per quanto riguarda la sicurezza, Meta si impegna a fornire agli sviluppatori i migliori strumenti e risorse per creare applicazioni AI sicure. In occasione di LlamaCon 2025 l’azienda ha rilasciato nuovi strumenti di protezione Llama per la comunità open source, tra cui Llama Guard 4, LlamaFirewall e Llama Prompt Guard 2. Ha condiviso anche gli aggiornamenti per aiutare le organizzazioni a valutare l’efficacia dei sistemi AI nelle operazioni di sicurezza con CyberSecEval 4, oltre ad annunciare il Llama Defenders Program per partner selezionati.

Con la disponibilità di modelli di intelligenza artificiale sempre più performanti, Meta ritiene che questo sia uno sforzo importante per migliorare la robustezza dei sistemi software. Per saperne di più sugli ultimi strumenti di protezione open source e sulle novità in materia di sicurezza dell’intelligenza artificiale è possibile consultare il blog di Meta.

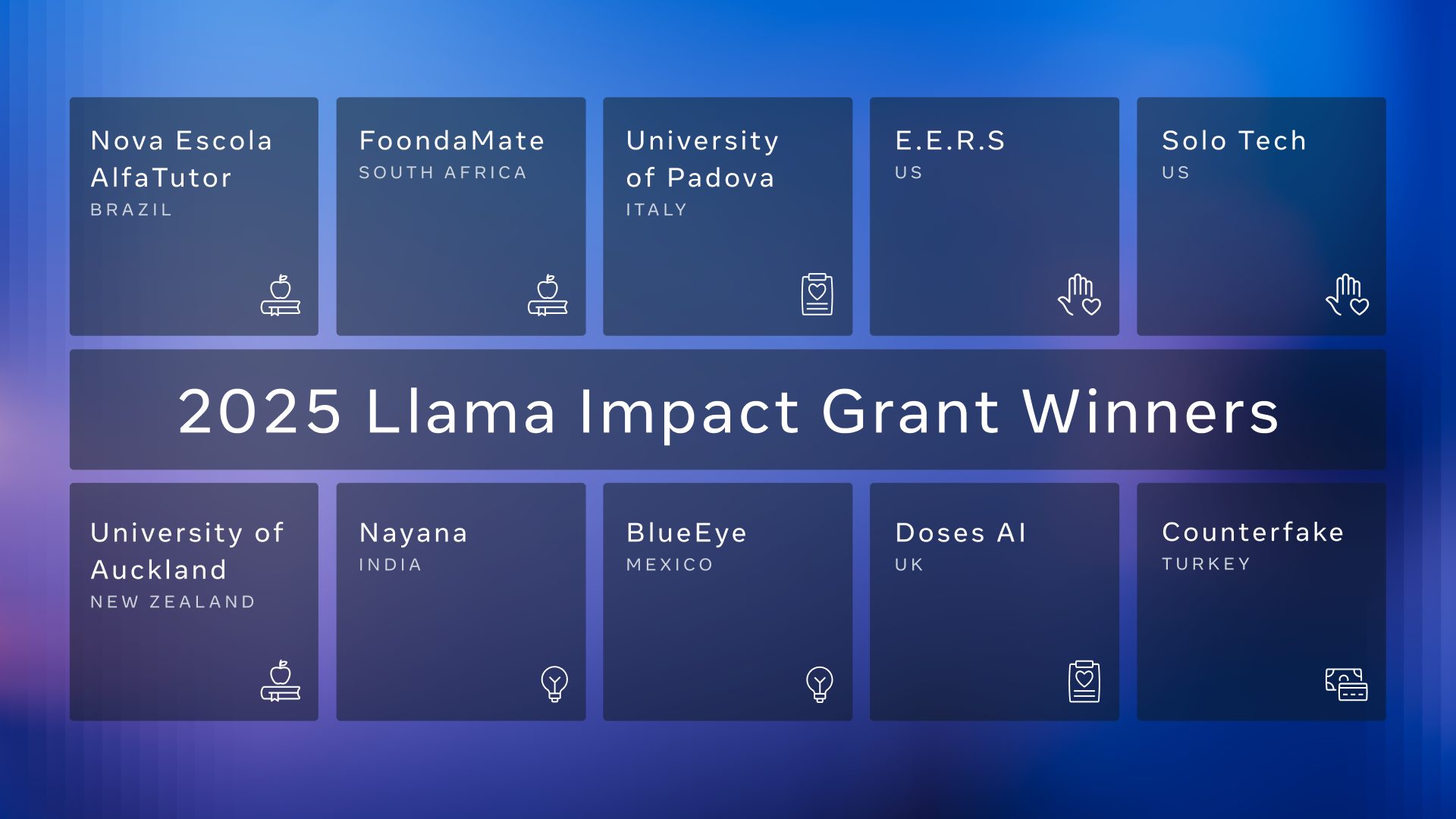

Llama Impact Grants

I Llama Impact Grants hanno l’obiettivo di promuovere l’innovazione e a creare opportunità economiche attraverso l’IA open source. In occasione di LlamaCon 2025 Meta ha annunciato i 10 beneficiari internazionali della seconda edizione dei Llama Impact Grants. Con oltre 1,5 milioni di dollari assegnati a 10 beneficiari internazionali, queste sovvenzioni sostengono le aziende, le startup e le università che utilizzano Llama per promuovere un cambiamento trasformativo.

I beneficiari di quest’anno presentano una gamma diversificata di soluzioni, tra cui E.E.R.S. dagli Stati Uniti, che utilizza un chatbot abilitato a Llama per migliorare l’accesso del pubblico ai servizi civici, e Doses AI nel Regno Unito, che trasforma le operazioni delle farmacie con il rilevamento degli errori in tempo reale. Tra gli altri vincitori spiccano Solo Tech, che fornisce assistenza AI offline nelle comunità rurali degli Stati Uniti, e FoondaMate, uno strumento di studio multilingue che aiuta milioni di studenti in Africa e non solo.

I beneficiari di quest’anno presentano una gamma diversificata di soluzioni, tra cui E.E.R.S. dagli Stati Uniti, che utilizza un chatbot abilitato a Llama per migliorare l’accesso del pubblico ai servizi civici, e Doses AI nel Regno Unito, che trasforma le operazioni delle farmacie con il rilevamento degli errori in tempo reale. Tra gli altri vincitori spiccano Solo Tech, che fornisce assistenza AI offline nelle comunità rurali degli Stati Uniti, e FoondaMate, uno strumento di studio multilingue che aiuta milioni di studenti in Africa e non solo.

C’è anche una realtà italiana: il gruppo di ricerca TaccLab dell’Università di Padova sta utilizzando Llama per trasformare la scoperta degli antibiotici e generare nuove molecole antibiotiche con l’aiuto di grandi insiemi di sequenze chimiche e biologiche. La sovvenzione – mette in evidenza Meta – li aiuterà a rendere più efficiente la scoperta di farmaci e l’innovazione dei materiali assistita dall’intelligenza artificiale, consentendo la convalida di nuovi composti chimici e accelerando le tempistiche di ricerca e riducendo i costi.

Infine, per Meta, il futuro è open source e per l’azienda l’ecosistema Llama è posizionato in prima linea in questa rivoluzione. Con Llama, gli sviluppatori e le aziende hanno la libertà di costruire ciò che vogliono, senza essere vincolati da sistemi proprietari o contratti vincolanti. Questa flessibilità, unita alla portabilità e all’accessibilità, fa di Llama la scelta obbligata per chi vuole sfruttare la potenza dell’intelligenza artificiale, dal punto di vista di Meta.

Meta sottolinea anche che intende impegnarsi a essere un partner a lungo termine per le aziende e gli sviluppatori e a fornire un percorso di transizione senza soluzione di continuità dai modelli chiusi. Secondo Meta, Llama è conveniente, facile da usare e consente a un maggior numero di persone di accedere ai vantaggi dell’IA, indipendentemente dalle loro competenze tecniche o dalle risorse hardware.