Il raffreddamento sta diventando una delle variabili che determinano davvero la scalabilità dei data center orientati ad AI e High Performance Computing. In questo scenario la Formula 1 introduce Lenovo Neptune Liquid Cooling nel proprio Media & Technology Centre (M&TC) di Biggin Hill (Regno Unito), la struttura che concentra le operazioni di broadcasting e gestione dati e che oggi gestisce la maggior parte dell’elaborazione del weekend di gara.

La piattaforma Neptune viene adottata per aumentare la capacità di calcolo e la velocità delle elaborazioni riducendo al tempo stesso i consumi energetici legati al raffreddamento fino al 40%. Tolga Kurtoglu, Chief Technology Officer di Lenovo, collega direttamente la tecnologia alla capacità di scalare i carichi spiegando che “Lenovo Neptune Liquid Cooling rafforza in modo sostanziale l’infrastruttura tecnica della Formula 1, garantendo carichi di lavoro più elevati e maggiore velocità, insieme a significativi risparmi energetici”, e che questo consente di “ampliare con sicurezza la portata e la sofisticazione dei suoi sistemi di broadcasting” mantenendo requisiti di efficienza, affidabilità e sostenibilità.

Dati live e produzione: 600 TB tra pista e Biggin Hill

Nei weekend di gara, la Formula 1 allestisce l’Event Technical Centre (ETC) a bordo pista, la struttura trasportabile definita come la più grande e complessa al mondo nel suo genere. Qui convergono tempi e classifiche in tempo reale, telemetria delle vetture, dati sugli pneumatici, comunicazioni radio, feed video e flussi audio. La potenza di calcolo necessaria a sostenere tutto questo viene garantita dalla piattaforma di virtualizzazione Lenovo.

Nel corso di un tipico weekend, circa 600 TB di dati live vengono trasferiti tra l’ETC e il Media & Technology Centre di Biggin Hill, che porta l’esperienza della Formula 1 ai fan e che si affida all’HPC di Lenovo per trasmettere in diretta a oltre 820 milioni di fan nel mondo. Su base annua, il pubblico cumulativo è indicato in 1,6 miliardi di spettatori.

Il Media & Technology Centre, recentemente rinnovato, esegue oltre 180 sistemi software personalizzati che includono più di quattro milioni di linee di codice, supportati dall’infrastruttura Lenovo. È un ambiente in cui l’elaborazione in tempo reale diventa parte integrante del prodotto broadcast: la capacità di calcolo non è più una commodity, ma un motore che trasforma continuamente dati e segnali in contenuti e servizi.

Come funziona Lenovo Neptune Liquid Cooling, in dettaglio

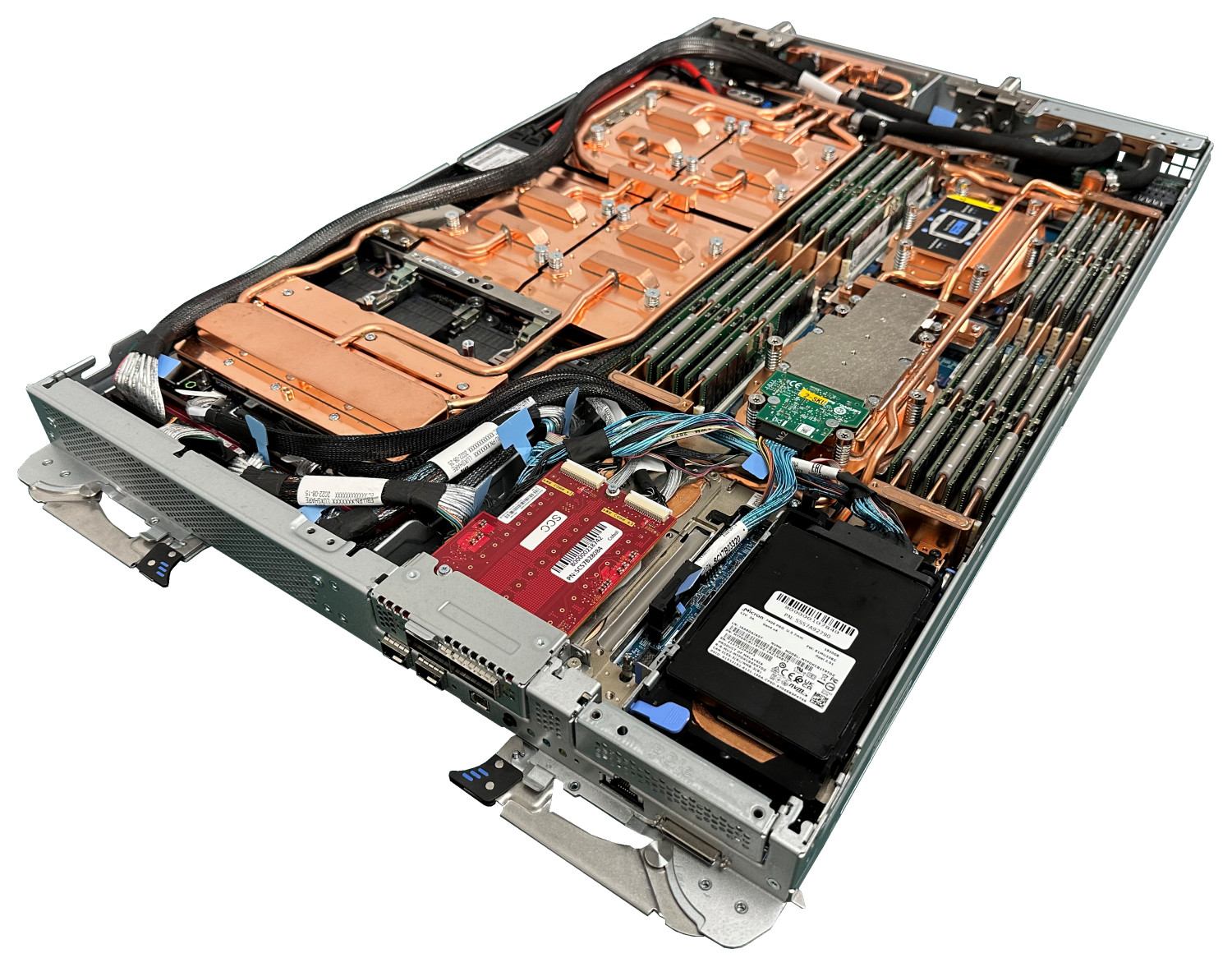

Neptune è la piattaforma Lenovo di raffreddamento a liquido progettata per carichi HPC e AI e basata su un principio chiave: togliere calore nel punto in cui viene generato, spostando la dissipazione dall’aria al liquido. La soluzione utilizza un raffreddamento direct-to-chip, in cui l’acqua attraversa cold plate ad alta efficienza termica montate direttamente su CPU e GPU. Il calore passa dal silicio alla piastra e da lì al fluido, che lo trasporta fuori dal server in modo molto più efficace rispetto al flusso d’aria.

Il vantaggio del direct-to-chip è duplice. Da un lato riduce la quantità di calore che si riversa nell’aria della sala, abbassando la pressione su corridoi caldo/freddo, portate e condizionamento. Dall’altro migliora la stabilità termica dei componenti critici, un aspetto decisivo per workload AI in cui la densità GPU può spingere il sistema verso limiti termici che innescano throttling e riduzioni di frequenza. In un ambiente live, la stabilità termica è direttamente collegata alla prevedibilità operativa: più il sistema resta dentro una finestra termica stabile, più può mantenere prestazioni sostenute senza oscillazioni.

Warm-water e acqua a temperatura ambiente: il cambio di paradigma

Nel progetto Formula 1, Neptune rimuove il calore “a livello di processore” utilizzando acqua a temperatura ambiente, riducendo in modo significativo l’energia necessaria per raffreddare sistemi ad alta densità di calcolo. Questo punto non è soltanto un dettaglio di implementazione: è un cambio di paradigma per l’economia energetica del data center.

L’aria diventa inefficiente quando la densità sale, perché per evacuare più calore bisogna movimentare più aria e lavorare con gradienti termici sempre più difficili. Il raffreddamento a liquido, invece, consente di aumentare la capacità di evacuazione senza moltiplicare i volumi d’aria. In più, quando la soluzione è progettata per lavorare in regime warm-water, aumenta la possibilità di ridurre o limitare l’uso dei chiller e di sfruttare free cooling, perché non serve spingere la mandata verso temperature molto basse per mantenere i chip in una finestra operativa sicura.

Il risultato è un impatto ambientale che cresce di pari passo con la densità: più il data center diventa AI-heavy, più il raffreddamento a liquido tende a essere un fattore di sostenibilità, perché abbatte la quota di energia assorbita dal raffreddamento rispetto all’output computazionale effettivo.

La tecnologia Neptune viene integrata nei server Lenovo ThinkSystem SD665-N V3, posizionati per potenziare l’ambiente HPC e alimentare i sistemi di AI della Formula 1 nel Media & Technology Centre. Il raffreddamento a liquido consente di espandere i carichi di lavoro legati a data analysis e AI mantenendo più sotto controllo l’impatto energetico, migliorando al tempo stesso stabilità termica e continuità prestazionale.

Net Zero 2030 e introduzione nel data center ad aria

Per la Formula 1 l’adozione di Neptune è parte di un percorso ambientale esplicito. Chris Roberts, Director of IT di Formula 1, afferma che “la Formula 1 è orgogliosamente in pista per raggiungere l’obiettivo Net Zero entro il 2030”, e che la partnership con Lenovo consente di “ridurre l’impronta del nostro HPC mentre continuiamo a innovare”. Roberts entra nel merito operativo sostenendo che Neptune “si integra perfettamente nel nostro attuale data center raffreddato ad aria, ci permette di gestire carichi di lavoro legati a dati e AI on-premises e pone le basi per future innovazioni in tutte le nostre operazioni.”

Costi operativi e investimenti: cosa cambia davvero nei data center AI

Il valore del liquid cooling, in una fase di crescita dell’AI, si legge su due piani complementari: i costi operativi e gli investimenti infrastrutturali, entrambi rilevanti per CIO, responsabili infrastrutture e facility manager.

Sul fronte dei costi operativi, ridurre l’energia necessaria al raffreddamento significa abbattere una componente strutturale della bolletta che non produce calcolo ma lo rende possibile. Direct-to-chip e warm-water riducono il lavoro richiesto a ventole e condizionamento e aumentano l’efficienza complessiva del data center. In più, una migliore stabilità termica si traduce in prestazioni più uniformi sotto carico, con un impatto pratico sulla produttività reale delle piattaforme AI: più ore utili a performance sostenuta, meno degradazione nei picchi.

Sul fronte degli investimenti, Neptune può ridurre la pressione su interventi impiantistici tipici dell’espansione ad aria. Portare cluster AI dentro un data center nato per workload tradizionali significa spesso dover potenziare containment, portate e capacità di trattamento dell’aria. Un raffreddamento direct-to-chip consente di spostare una parte del problema “fuori dalla sala”, rendendo più gestibile l’incremento di densità e consentendo una crescita progressiva: i rack più densi vanno su liquid cooling, mentre il resto dell’infrastruttura può continuare a operare con air cooling.

Neptune e le altre tecnologie di raffreddamento

L’adozione del liquid cooling non è una scelta binaria, perché esistono tecnologie diverse con impatti differenti su efficienza, costi e complessità operativa. Il punto è che ogni approccio sposta in modo diverso l’equilibrio tra ciò che resta “aria” e ciò che diventa “acqua”.

Il direct-to-chip come Neptune è la soluzione più efficace quando l’obiettivo è sostenere densità elevate e carichi GPU intensivi. Il liquido raggiunge direttamente CPU e GPU, cattura calore alla sorgente e riduce drasticamente il lavoro dell’aria. È un modello che tende a fornire il miglior compromesso tra efficienza termica e industrializzazione, perché non richiede di cambiare il paradigma del server, ma introduce una filiera di distribuzione del fluido a rack e una governance più rigorosa su qualità dell’acqua, portate e pressioni. Proprio per questo si presta all’adozione enterprise: l’hardware rimane “server-centric”, ma il raffreddamento diventa un elemento progettuale dell’infrastruttura.

I Rear Door Heat Exchanger (RDHx) si collocano come alternativa particolarmente interessante in scenari di retrofit. Qui l’acqua non entra nel server: lo scambiatore è montato sul retro del rack e raffredda l’aria calda in uscita. Dal punto di vista operativo è spesso più facile introdurlo in un data center esistente, perché riduce la necessità di intervenire sul singolo nodo e consente di aumentare la densità mantenendo una logica air-cooled dentro al rack. Il rovescio della medaglia è che resta un raffreddamento mediato dall’aria: efficace, ma potenzialmente meno adatto quando la densità GPU cresce oltre un certo livello e l’airflow interno diventa il limite.

L’immersion cooling è l’opzione più radicale e potenzialmente più “potente” sul piano termico: i server vengono immersi in un fluido dielettrico che assorbe il calore in modo estremamente efficiente. È una soluzione capace di sostenere densità molto elevate e di ridurre drasticamente la dipendenza da ventole e condizionamento tradizionale. Tuttavia richiede un cambio profondo su supply chain, manutenzione e procedure: non è solo un nuovo sistema di raffreddamento, ma una trasformazione del modo in cui si gestiscono i server, con implicazioni su componentistica, ricambi, strumenti e competenze.

Accanto a questi tre filoni principali esistono varianti “ibride”, in cui il liquido assiste il raffreddamento dell’aria attraverso scambiatori in-row o moduli liquid-assisted. Sono tecnologie utili quando la densità cresce ma non arriva ancora ai livelli tipici dei cluster AI di fascia alta: riducono parte dei consumi e alleggeriscono la sala, ma non offrono la stessa capacità di controllo termico del direct-to-chip su CPU e GPU.

In termini di impatto economico e ambientale, il direct-to-chip come Neptune tende a diventare la scelta più lineare quando la densità è già alta o prevista in crescita rapida, perché riduce i costi operativi e rende più gestibile la crescita degli investimenti, evitando che l’espansione dell’AI costringa a riprogettare in modo aggressivo la parte impiantistica. RDHx è spesso il ponte più pragmatico per aumentare densità in data center esistenti, mentre immersion è la soluzione “di rottura” che massimizza le prestazioni termiche ma al prezzo di una trasformazione operativa più profonda.

Una tecnologia che anticipa la traiettoria dei data center AI

La scelta di Neptune a Biggin Hill mostra come il raffreddamento sia diventato un elemento abilitante per l’innovazione data-driven. In un ambiente live globale, dove l’infrastruttura deve reggere continuità, carichi intensi e una pipeline di dati in costante crescita, l’efficienza termica è una condizione per aumentare la potenza di calcolo senza rendere insostenibili consumi e impronta ambientale. Neptune Liquid Cooling porta questo approccio dentro un contesto altamente visibile, ma il tema è generale: nel data center dell’AI, raffreddare meglio non è un vantaggio marginale, è un modo per rendere possibile la prossima scala.