Ciao a tutti!

Sono Vincenzo Lomonaco, un ricercatore e docente presso l’Università di Pisa, dipartimento di Informatica, dove mi occupo principalmente di intelligenza artificiale.

In questa puntata di Le Voci dell’AI parleremo di intelligenza artificiale e sostenibilità, soprattutto dal punto di vista dei costi, delle risorse umane impiegate e dal punto di vista ambientale.

Ma prima di addentrarci in questo entusiasmante argomento, topic principale della discussione di oggi, volevo giusto darvi due informazioni su di me.

Mi occupo di intelligenza artificiale da circa dieci anni e in particolare faccio ricerca qui alll’Università di Pisa su tematiche di apprendimento automatico; quindi machine learning, un po’ la punta di diamante, la metodologia principale dell’intelligenza artificiale di oggi.

Ancor più in particolare, mi occupo di apprendimento automatico continuo, cioè come rendere le nostre soluzioni di intelligenza artificiale più efficienti e sostenibili nell’apprendere continuamente, in maniera incrementale.

Vedremo che è un tema proprio connesso al tema di oggi, cioè la sostenibilità delle nostre soluzioni AI.

Quindi, se siete interessati a saperne di più rispetto a questi temi oppure a quelli che discutiamo durante questi episodi di Le Voci dell’AI, non esitate a contattarmi scrivendo una mail all’indirizzo di posta elettronica vincenzo.lomonaco@unipi.it Ma lanciamoci subito nel tema di oggi.

Innanzitutto le soluzioni di intelligenza artificiale di oggi sono sostenibili o insostenibili dal punto di vista energetico, ambientale e di costi finanziari? La verità è che negli ultimi anni abbiamo assistito a una crescita quasi esponenziale delle risorse necessarie per gestire soluzioni di intelligenza artificiale, sia computazionali sia per l’archiviazione dei dati, così come, in generale, a quelle dei costi energetici e delle risorse umane connesse allo sviluppo di queste soluzioni.

Ma il problema fondamentale su cui vi invito a riflettere è il seguente: i costi non sono necessariamente legati alla creazione della soluzione di intelligenza artificiale, ma piuttosto, e fondamentalmente, al suo mantenimento.

Qualcosa che spesso, soprattutto nel mondo applicativo, viene ignorato.

Mentre uno studio di Dimensional Research suggerisce che circa l’80% dei costi sia legato al mantenimento di soluzioni di intelligenza artificiale piuttosto che alla creazione di una soluzione che funziona in un determinato momento all’inizio dell’utilizzo di questo sistema.

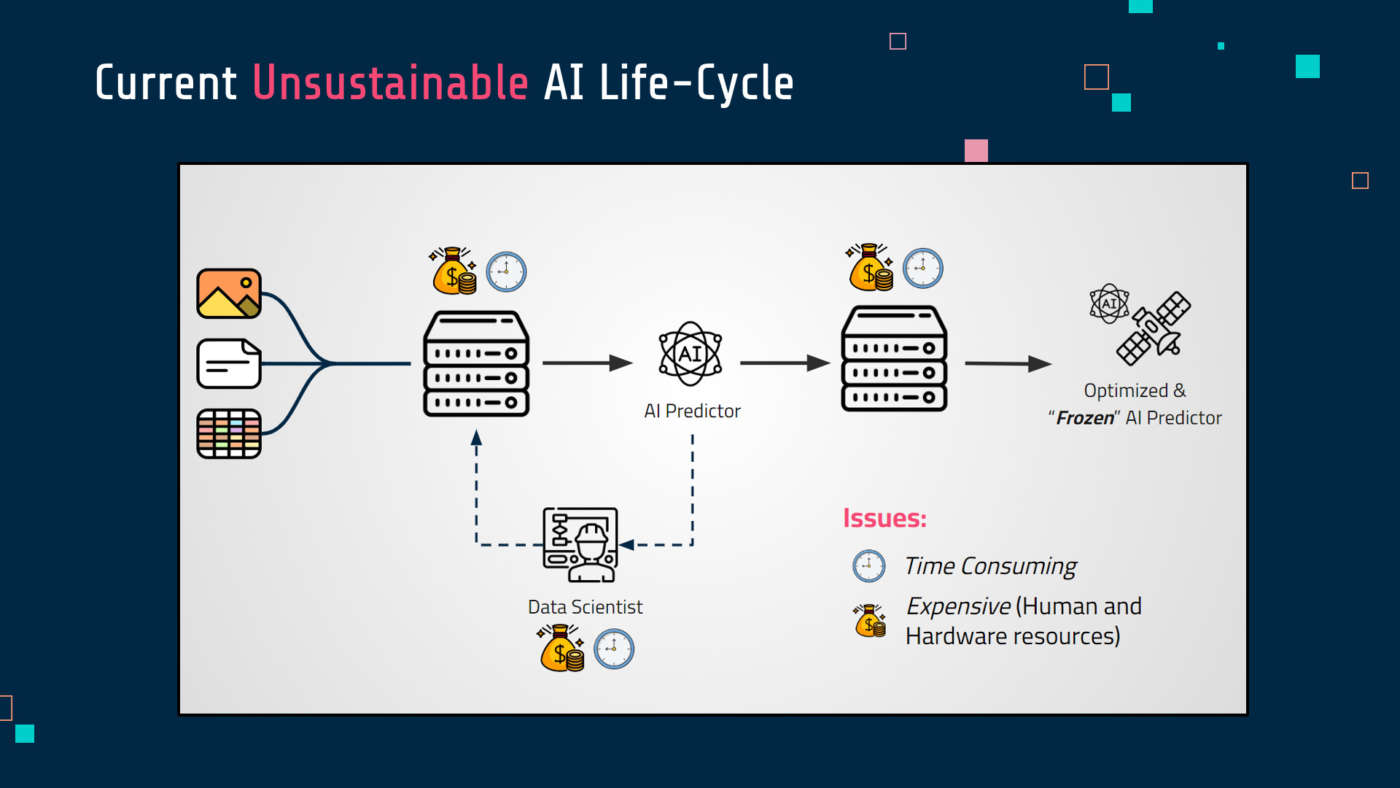

Per meglio comprendere questo mio punto argomentativo volevo aiutarmi con una slide che riassume quello che viene chiamato il ciclo di vita di una soluzione di intelligenza artificiale.

Stiamo spostando l’attenzione dalla creazione di una soluzione di AI basata sull’intelligenza artificiale, l’apprendimento automatico a qualcosa che riguarda l’intero ciclo di vita di questa soluzione.

Per i meno avvezzi, questo ciclo di vita è composto da una serie di passi intermedi: innanzitutto la creazione e cura di un dataset, un insieme di dati di riferimento su cui operare, quindi su cui apprendere, visto che, come dicevamo, le tecnologie di apprendimento automatico rappresentano un po’ la punta di diamante dei recenti sviluppi di intelligenza artificiale, ma subito anche un dispendio significativo in termini di risorse, di tempo, finanziarie per la creazione, attraverso un processo iterativo, di un modello predittivo alla base di questa soluzione di intelligenza artificiale e infine un ulteriore processo di raffinamento per poter effettivamente rendere operazionale questa soluzione in un contesto applicativo specifico con dell’hardware e software di riferimento in sistemi più vasti, con pipeline e processi più complessi legati al business di riferimento.

Questo processo, che in ultima analisi ci dà una soluzione funzionante, non termina alla fine di quest’ultimo passaggio, ma deve anch’esso essere operato iterativamente quando riscontriamo che, per esempio, sul campo questa soluzione non funziona più, non è più utile, non raggiunge più gli obiettivi funzionali che ci aspettavamo, come è naturale che avvenga in un contesto sempre cangiante, che è la vita stessa che ci circonda.

Quindi, per poter mantenere questa soluzione rispetto agli standard di efficacia che ci aspettiamo, dobbiamo continuamente ripetere questi costosi step, passi in cui spendiamo davvero molto da tanti punti di vista.

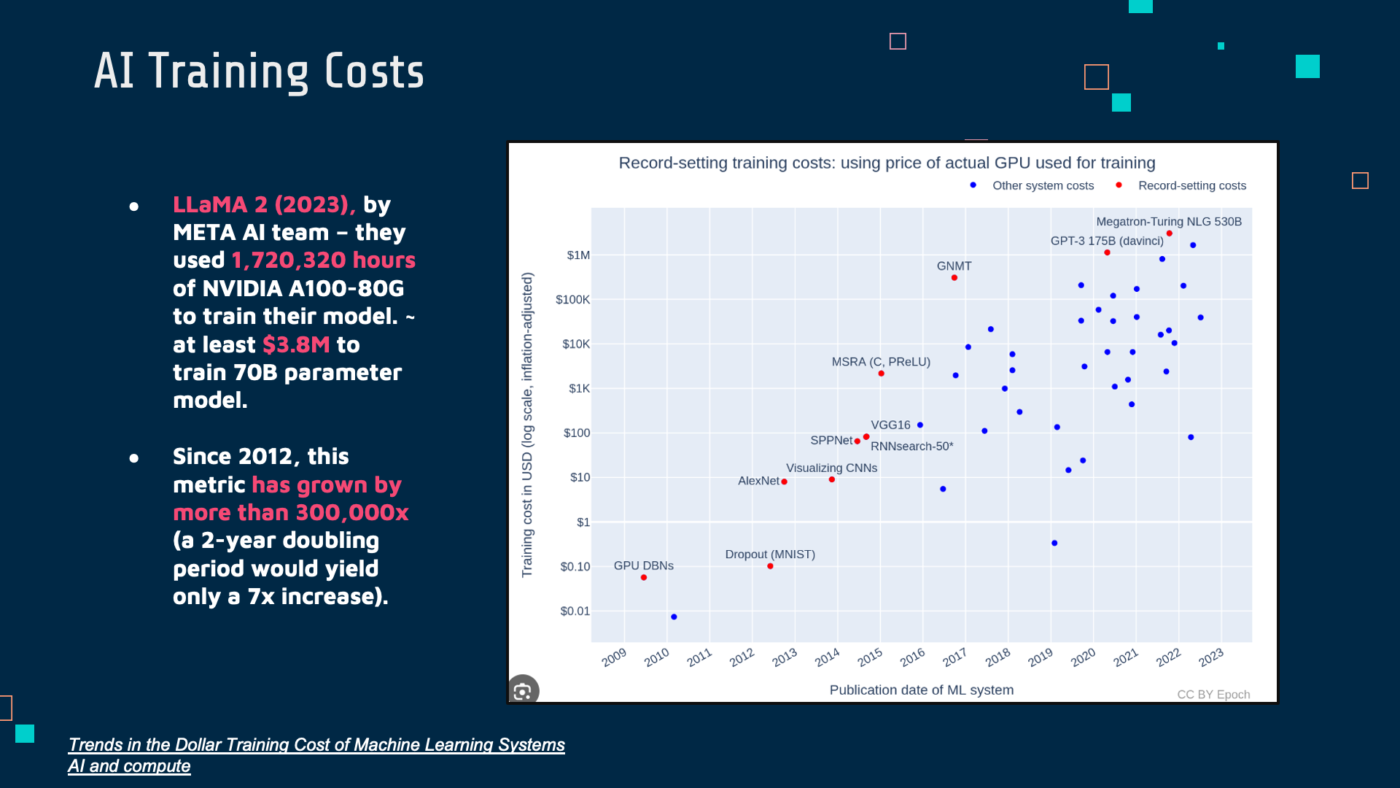

Diamo una quantificazione più corretta a questi costi elevati a cui abbiamo accennato.

Di cosa stiamo parlando? Nello specifico, per esempio, rispetto alle risorse computazionali o ai costi energetici?

Prendiamo, per esempio, uno dei modelli open source più famosi e recentemente pubblicati, LLaMA, un Large Language per l’elaborazione del linguaggio naturale che viene utilizzato per servizi come chatbot o assistenti virtuali.

In questo caso il team di Meta AI, quindi Facebook, ha utilizzato circa un anno, anzi 2 milioni di ore di calcolo su una CPU allo stato dell’arte, ovviamente utilizzando la parallelizzazione per farlo in tempi utili e spendendo circa 4 milioni di dollari, soltanto per addestrare un unico modello, non quindi l’ammontare di modelli utili per svolgere diversi compiti di cui ovviamente necessiterebbe una grande azienda. Un altro elemento importante da considerare: dal 2012 è stato stimato che le richieste di calcolo per la creazione e l’addestramento di questi modelli siano cresciute di 300.000 volte, il che rende questi modelli molto grandi, fondazionali, quindi allo stato dell’arte, appannaggio di poche realtà private.

Ma il punto è che, come accennavo poc’anzi, questi costi per la creazione di una soluzione di intelligenza artificiale non vanno considerati in isolamento.

Questi sistemi, una volta creati, devono essere mantenuti nel tempo ed è lì che si annidano i costi più elevati sia per il loro utilizzo in inferenza, quindi per poter effettuare delle predizioni ma anche per il loro aggiornamento, quindi un riaddestramento periodico per riscontrare ancora una volta le metriche di efficacia che ci aspettiamo, adeguandosi al contesto operativo che nel frattempo è cambiato oppure semplicemente relativo ai nostri obiettivi funzionali.

Si tratta dunque di processi per la creazione e il mantenimento di soluzione di intelligenze artificiali davvero dispendiose dal punto di vista finanziario.

Ma per quanto riguarda l’impatto ambientale o il consumo energetico cosa possiamo dire? Aiutandomi ancora con una slide quello che possiamo vedere rispetto alle emissioni, per esempio di CO₂, è che un modello allo stato dell’arte, nelle sue accezioni più complesse, sorpassa di gran lunga le emissioni legate, ad esempio, a un’automobile nel suo intero ciclo di vita: 626.000 libbre di CO₂ rispetto alle 126.000 delle emissioni legate a un’automobile.

E nell’ottica poi di cercare più soluzioni per la creazione di questi modelli si arriva, come accennavamo prima, a spese di quasi 4 milioni di dollari, soltanto considerando le risorse computazionali legate alle infrastrutture cloud di rilievo, quindi parallelizzate, per le quali i costi energetici sono molto rilevanti.

Per concludere, quindi, oggi abbiamo considerato un tema importante per lo sviluppo dell’intelligenza artificiale del futuro: la sua sostenibilità, considerando che negli ultimi anni abbiamo visto una crescita esponenziale in termini di consumi legati alla creazione e soprattutto il mantenimento di queste soluzioni.

Quindi cosa aspettarci per il futuro? Auspicabilmente un cambiamento metodologico per la gestione dell’intero ciclo di vita dell’intelligenza artificiale, per rendere più efficienti, proprio come il cervello umano, le macchine del futuro.

Guarda tutti gli episodi di Le voci dell’AI