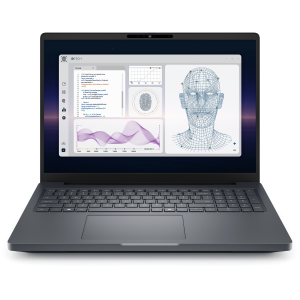

La pressione per portare l’intelligenza artificiale più vicino ai dati sta ridefinendo le workstation mobili. L’obiettivo è ridurre la dipendenza dal cloud, mantenere prestazioni prevedibili e garantire la sicurezza in contesti operativi sempre più frammentati. In questo scenario si colloca il Dell Pro Max 16 Plus, che introduce per la prima volta in un portatile una NPU discreta di livello enterprise basata sulla Qualcomm AI 100 PC Inference Card.

Dell Pro Max 16 Plus, una NPU discreta per modelli su larga scala

Qualcomm AI 100 PC Inference Card, struttura e capacità

La Qualcomm AI 100 PC Inference Card integra due NPU AI-100 su un’unica scheda con 64 GB di memoria dedicata. È progettata per l’inferenza FP16 sostenuta, con un’architettura orientata alla stabilità e alla prevedibilità del carico. La memoria dedicata consente di gestire modelli fino a circa 120 miliardi di parametri, con una combinazione di throughput e fedeltà che mira a replicare il comportamento dei sistemi usati nei datacenter. I 32 core AI sono pensati per scenari multi-istanza e per flussi video complessi, tipici di applicazioni di visione artificiale, diagnostica e modellazione avanzata.Il cuore del dispositivo è una scheda che integra due NPU Qualcomm AI-100 con 64 GB di memoria dedicata. L’architettura è progettata per eseguire inferenze FP16 sostenute, supportando modelli fino a circa 120 miliardi di parametri. È una configurazione orientata a scenari in cui latenza, fedeltà e continuità operativa contano più della pura potenza teorica. L’obiettivo è rendere l’inferenza locale una scelta tecnica praticabile anche per carichi complessi, non più solo per modelli leggeri.

L’approccio è chiaro: avvicinare l’elaborazione all’origine dei dati, mantenendo riservatezza e stabilità, soprattutto dove la connettività è scarsa o assente. L’inferenza on-device evita il roundtrip verso il cloud e consente tempi di risposta immediati anche in ambienti air-gapped.

Perché passare da cloud-dipendente a on-device

L’ultimo decennio ha visto le GPU al centro dell’accelerazione AI grazie alla capacità di addestrare modelli complessi. L’inferenza, però, richiede un profilo diverso: tempi di risposta costanti, accuratezza ripetibile e un comportamento prevedibile sul lungo periodo. L’esecuzione locale soddisfa queste esigenze, riducendo la variabilità introdotta dalla rete e garantendo che ogni elaborazione resti sotto controllo.

Il Dell Pro Max 16 Plus con la Qualcomm AI 100 PC Inference Card risponde a questo tipo di esigenze con un approccio più ingegneristico che commerciale: portare capacità datacenter su un dispositivo portatile per scenari realistici di diagnostica, classificazione, trascrizione e analisi predittiva, senza dipendere da infrastrutture esterne.

Applicazioni nei settori professionali per il Dell Pro Max 16 Plus

Nella sanità, la possibilità di analizzare immagini come MRI o TC direttamente sul Dell Pro Max 16 Plus consente diagnosi immediate in contesti remoti o mobili, mantenendo la piena conformità ai requisiti di privacy. In ambito finanziario, legale e nella Pubblica Amministrazione, l’elaborazione locale permette di gestire dati sensibili, rilevare anomalie o classificare documenti senza rischi di esposizione. Per ingegneri e ricercatori, la capacità di testare e validare modelli in locale riduce i tempi di sviluppo e rende più semplice misurare latenza e comportamento reale dei modelli.

Un’architettura più flessibile per gli ambienti IT

Dell Pro Max 16 Plus supporta sia Windows sia Linux. In ambiente Windows si integra con gli strumenti di gestione dell’ecosistema AI PC di Dell, semplificando la configurazione delle policy aziendali. In Linux consente agli sviluppatori di utilizzare toolchain e framework personalizzati senza vincoli particolari.

NPU discreta, GPU e NPU integrate: cosa cambia davvero

Le NPU integrate nei laptop tradizionali offrono accelerazioni utili per funzioni leggere del sistema operativo, ma sono limitate da memoria e capacità di calcolo. La NPU discreta Qualcomm a bordo del Dell Pro Max 16 Plus mette a disposizione 64 GB dedicati e 32 core AI, aprendo la strada all’esecuzione di modelli non gestibili dalle soluzioni integrate.

Il discorso è diverso rispetto alle GPU: queste restano lo standard per il training e per applicazioni grafiche o di simulazione. La NPU discreta, invece, è costruita per l’inferenza sostenuta, con una maggiore efficienza energetica e prestazioni più prevedibili nei carichi continuativi.