Con l’evoluzione del ruolo del CIO e l’adozione accelerata dell’intelligenza artificiale, le imprese italiane si trovano oggi a dover ripensare profondamente il proprio stack tecnologico. Davide Andreoni, Head of MuleSoft Italy, descrive un mercato in trasformazione dove l’integrazione non è più un problema infrastrutturale, ma un elemento strategico per la competitività aziendale.

“Il nuovo CIO non può più limitarsi alla gestione dell’infrastruttura. Deve comprendere il business, anticiparne le esigenze e trasformare la tecnologia in leva di crescita”, afferma Andreoni. Non si tratta solo di un aggiornamento di responsabilità, ma di una vera transizione identitaria: da custode dell’IT aziendale a orchestratore strategico dell’innovazione digitale.

In molte aziende italiane si osserva ancora una dicotomia tra CIO “classico” – responsabile dei sistemi, della sicurezza, delle operation – e nuove figure come il Chief Innovation Officer o il Chief Transformation Officer, incaricati di esplorare e portare in azienda nuove tecnologie, dalla blockchain all’intelligenza artificiale.

Spesso questi ruoli coesistono in modo separato, ma le aziende più mature stanno convergendo verso un modello unificato, dove la responsabilità dell’IT e quella dell’innovazione risiedono nella stessa persona o sotto lo stesso perimetro di governo.

“È in atto una convergenza – spiega Andreoni – e si sta affermando la figura del Chief Information and Innovation Officer, che ha piena visibilità e influenza sulla strategia aziendale”.

Dalla gestione della complessità alla creazione di valore

Storicamente, il CIO era misurato su metriche di efficienza e disponibilità: uptime, costi, SLA. Ma oggi il board richiede impatti tangibili sul business, in tempi brevissimi. L’IT non è più solo “business enabler”: è business driver.

“Vent’anni fa un progetto IT si ripagava in cinque o sei anni. Oggi il ritorno va dimostrato in sei mesi. A volte in sei settimane. Non c’è più spazio per progetti monolitici”.

La pressione verso la modularità, la velocità di delivery e l’automazione spinge i CIO a ripensare architetture e piattaforme, scegliendo soluzioni che abilitino la composability e la governance in tempo reale. È qui che MuleSoft si propone come leva abilitante: integrare rapidamente sistemi e dati, supportare i team nello sviluppo agile di agenti, servizi e API, riducendo la dipendenza da sviluppi custom.

MuleSoft: dall’integrazione tradizionale alla piattaforma componibile

Nata come soluzione per l’application integration, MuleSoft ha cambiato pelle. “Quando sei anni fa ho assunto il ruolo di country manager, eravamo lo sfidante. Oggi, grazie a un approccio innovativo e a un modello a componenti riutilizzabili, siamo una piattaforma leader per l’integrazione, l’automazione e la gestione delle API”.

Alla base della strategia MuleSoft c’è il concetto di “composable architecture”: non più progetti monolitici ma “building block” riutilizzabili, connettorizzati, orchestrati e scalabili. Questo consente di ridurre drasticamente la customizzazione e di creare un volano di efficienza per ogni nuova iniziativa digitale.

“È una piattaforma amata dagli sviluppatori – spiega Andreoni – perché offre una gestione unificata delle integrazioni e delle API, con dashboard complete, osservabilità nativa e supporto esteso a deployment on-prem, cloud e ibridi”.

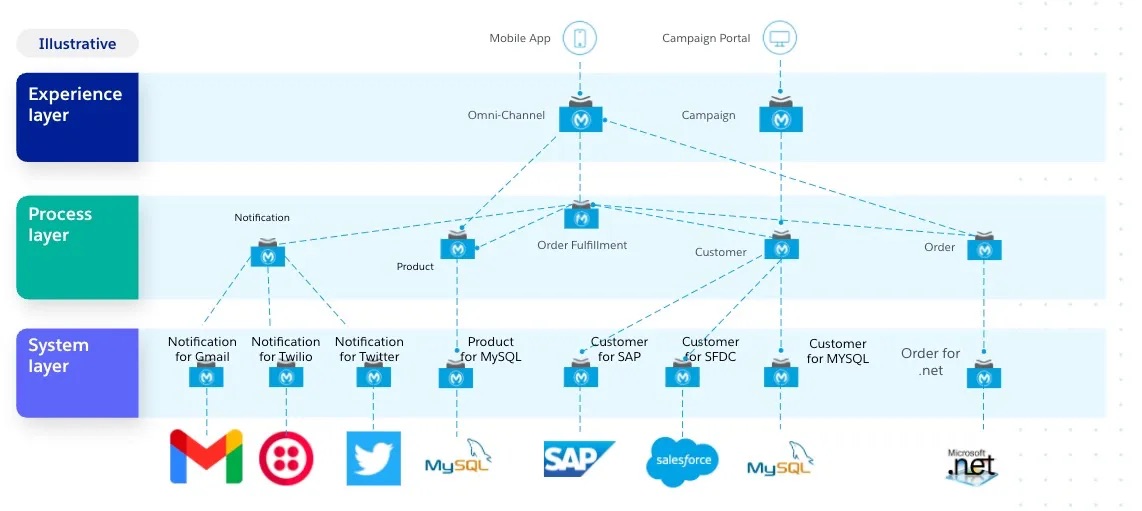

L’API-Led Connectivity di Mulesoft e i tre layer architetturali: system, process e experience

L’architettura di MuleSoft si fonda su un modello a tre layer che separa in modo chiaro i compiti tecnici, logici e di presentazione dei dati. Questo approccio consente riutilizzabilità, scalabilità e governance su larga scala, ed è uno dei principali elementi differenzianti della piattaforma.

Il System Layer è la base dell’integrazione. Questo è lo strato più vicino alle fonti di dati e ai sistemi di back-end. Include: ERP, CRM, database legacy, mainframe; Sistemi cloud (es. Salesforce, SAP, ServiceNow, AWS); API di terze parti, SaaS, sistemi on-premise, con l’obiettivo: rendere accessibili i dati e i servizi di questi sistemi, utilizzando connettori e API. I dati non vengono replicati, ma esposti in modo sicuro e governato. Inoltr, se cambia il sistema sorgente, l’interfaccia API rimane stabile grazie all’intermediazione del connector, evitando refactoring costosi a valle.

Nel Process Layer risiede il cuore funzionale dell’architettura MuleSoft. Questo livello orchestra, arricchisce e trasforma i dati provenienti dal System Layer secondo la logica di business. Si costruiscono flussi (flows) e servizi compositi, si applicano regole aziendali e orchestrazioni e si gestisce l’automazione tra processi e domini (es. vendite, logistica, customer care), isolando la complessità logica dal layer di integrazione e da quello di presentazione e creando building block riutilizzabili da usare in più progetti, in ottica composable. La logica è disaccoppiata dal frontend e dal sistema sorgente, rendendo il tutto più manutenibile, auditabile e scalabile.

L’Experience Layer è l’interfaccia verso l’utente o l’AI, ed è lo strato “esposto”, quello con cui interagiscono i consumatori delle API o dei servizi: applicazioni frontend (portali, mobile app), chatbot e agenti AI, sistemi esterni (clienti, fornitori, business partner) e altri team interni o sviluppatori, con l’obiettivo di presentare i servizi in modo coerente e modulare, adattandoli al contesto di utilizzo. Un’unica logica può essere esposta in molteplici modalità (REST, GraphQL, eventi, ecc.), mantenendo pieno controllo e osservabilità.

“Separare questi strati consente di isolare la complessità, facilitare il riuso, ridurre il time-to-market e migliorare la governance dell’intero ecosistema IT”, aggiunge Andreoni.

Il confronto con i competitor: dove MuleSoft fa la differenza

Andreoni sottolinea con decisione come MuleSoft si sia imposta in un mercato storicamente dominato da player come Software AG, Broadcom (ex CA Technologies), TIBCO, Informatica e IBM App Connect. Questi vendor, pur ancora rilevanti, sono descritti come ancorati a modelli legacy e architetture monolitiche. “Le vecchie scelte tecnologiche, nate per integrare ambienti omogenei come SAP-SAP, funzionano ancora bene… ma non abilitano la trasformazione digitale di oggi, basata su composizione rapida, API, AI e automazione”.

In particolare, Andreoni critica l’incapacità di alcuni concorrenti storici di adattarsi alla logica degli agenti AI e dei progetti agili: “Stanno diventando ‘legnosi’ per i CIO, perché non supportano scenari in cui il go-live è richiesto in 3 settimane o meno”.

Altro tema critico è la ceduta di asset tecnologici core da parte di alcuni vendor a fondi di private equity: “Vedo vendor che spacchettano tecnologie strategiche e le vendono a entità finanziarie. Non sono soggetti industriali, e questo dovrebbe preoccupare i CIO: chi gestisce l’integrazione della tua azienda deve avere una visione tecnologica di lungo termine, non solo logiche speculative”.

AI-ready: come MuleSoft potenzia l’intelligenza artificiale

Uno degli aspetti centrali della trasformazione digitale è l’adozione crescente dell’intelligenza artificiale. Tuttavia, come sottolinea Davide Andreoni, l’AI non può funzionare senza integrazione. “Gli agenti intelligenti hanno bisogno di dati contestualizzati, accessibili e aggiornati. Ma questi dati vivono in ambienti frammentati, su sistemi legacy, ERP, CRM, database e API di terze parti. Ed è qui che entra in gioco MuleSoft”.

La piattaforma MuleSoft permette di costruire un’infrastruttura dati ai-native, in cui i blocchi informativi e i servizi applicativi sono esposti, orchestrati e riutilizzabili dagli agenti di intelligenza artificiale. Questo avviene attraverso: API riutilizzabili e sicure, che fungono da layer di accesso ai dati aziendali; Connettori preconfigurati, per collegarsi rapidamente a sistemi SaaS, database, strumenti di AI e servizi cloud; Flussi di orchestrazione low-code/no-code, che permettono anche a utenti non tecnici di configurare logiche di business e alimentare modelli AI. “Il valore non è solo nel dato, ma nella sua disponibilità a tempo zero. L’AI ha bisogno di essere ‘nutrita’ continuamente. E noi siamo il canale che apre e controlla quel flusso”, spiega Andreoni.

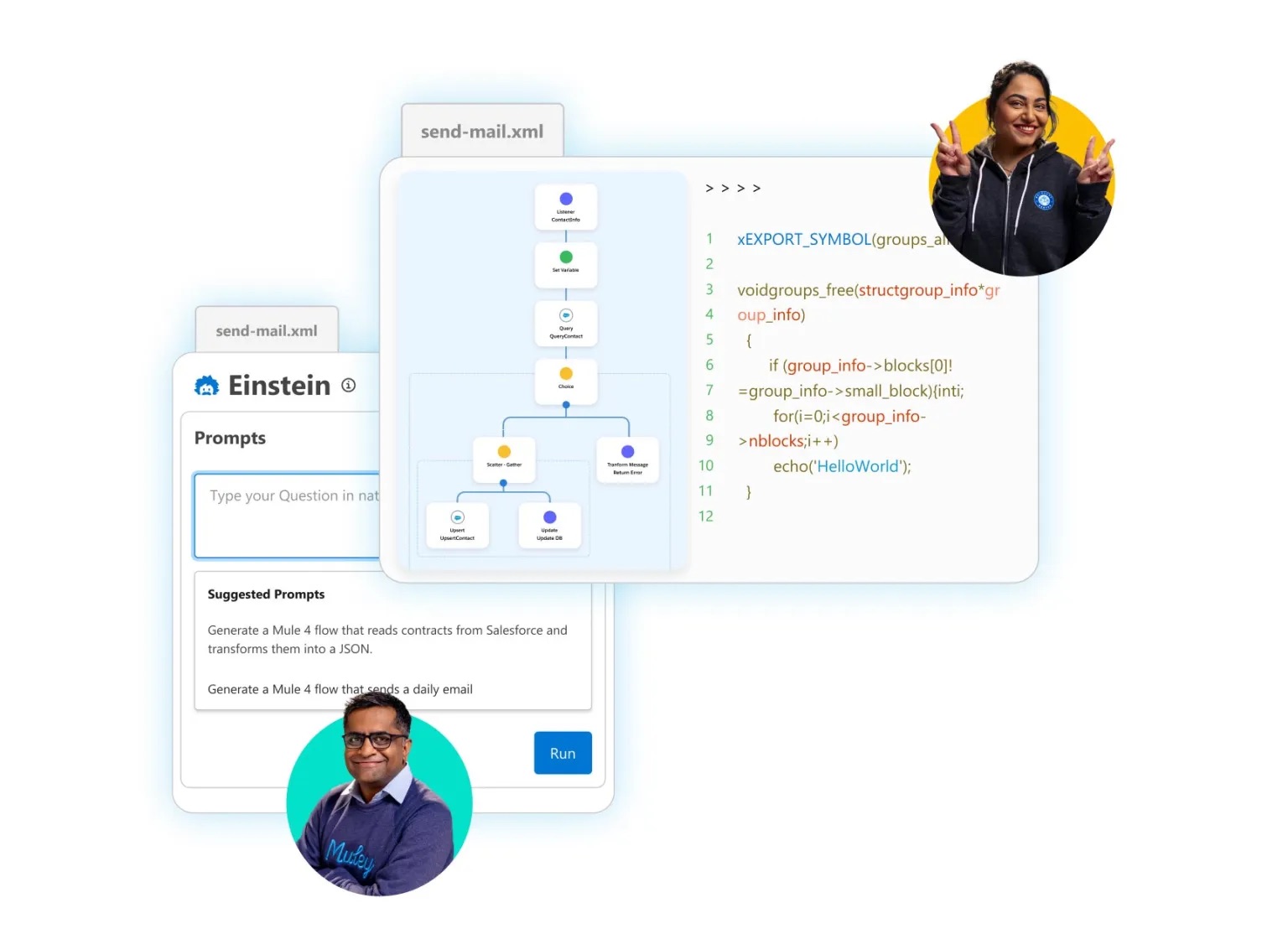

AI generativa: connettori e agenti che creano altri agenti

Un’evoluzione recente particolarmente interessante è l’introduzione di funzionalità di AI generativa all’interno della stessa MuleSoft. La piattaforma oggi consente la generazione automatica di connettori tramite AI, per ridurre drasticamente il tempo necessario a collegare sistemi eterogenei, la sintesi e trasformazione dinamica dei dati da fornire agli LLM (Large Language Models) o ai sistemi di machine learning e l’abilitazione di agenti intelligenti composti, ovvero moduli AI che orchestrano altri agenti per compiti complessi. “La nostra visione è che in futuro gli agenti AI svilupperanno altri agenti. Un ecosistema di agenti interconnessi che collaborano tra loro per raggiungere obiettivi di business. E noi stiamo già preparando l’infrastruttura per questa visione”.

In un mercato dove l’AI viene spesso adottata con approccio pilota, MuleSoft consente di passare rapidamente dall’idea al prototipo, e dal prototipo al deployment. “Non puoi permetterti quattro mesi per implementare un chatbot AI se il tuo concorrente lo lancia in due settimane. Serve agilità, e l’integrazione è la base”.

E per le aziende che puntano su progetti AI, questo significa ridurre il time-to-market delle soluzioni intelligenti, garantire la qualità e la sicurezza dei dati che alimentano i modelli e governare l’intero ciclo di vita degli agenti grazie a dashboard, API lifecycle management e audit trail nativi.

Licensing flessibile e a consumo: la svolta strategica per scalare

Il modello di licensing di MuleSoft ha subito un’evoluzione profonda negli ultimi anni, passando da una logica classica di subscription annuale per capacità a un modello molto più flessibile e scalabile, basato sul consumo effettivo di risorse e funzionalità.

“La complessità attuale dei progetti non consente più di prevedere in anticipo quante API o connessioni saranno utilizzate. I clienti chiedono elasticità. Per questo stiamo andando verso un modello a crediti consumabili su tutto il portafoglio”, spiega Andreoni.

Grazie al consumo flessibile e al supporto per modelli a basso commitment iniziale, MuleSoft oggi riesce a penetrare segmenti che in passato risultavano fuori target.

“Con un punto di ingresso più basso, anche le aziende che stanno facendo una rivoluzione digitale possono partire subito, testare la piattaforma, e crescere in modo modulare. Questo ha ampliato il nostro mercato in modo significativo”.

Il nuovo approccio cambia anche il modo in cui si gestiscono i budget IT. Invece di pianificare spese fisse su licenze statiche, il CIO può allocare budget legati a progetti e risultati, distribuendo i crediti su ciò che serve davvero: un mese si consumano per API, il mese successivo per connettori AI o il il trimestre dopo per orchestrazioni automatizzate.

Questo aumento della flessibilità è un differenziatore chiave rispetto a molte piattaforme conorrenti ancora legate a modelli legacy.

Per le aziende già clienti, la transizione al nuovo licensing avviene in modo progressivo, senza interruzioni operative. I progetti esistenti restano validi e, nel tempo, il cliente può passare al modello a consumo mantenendo la governance, i log e le metriche esistenti.

Partner e governance tecnica: un modello ibrido e scalabile

Il modello di go-to-market italiano è ibrido: vendite dirette, ecosistema di partner certificati (dai grandi system integrator ai boutique partner verticali) e presenza locale forte. “Collaboriamo con i partner sia per trovare opportunità sia per implementare i progetti. Noi forniamo governance tecnica e validazione architetturale, il partner realizza e gestisce”, spiega Andreoni.

L’interoperabilità tra servizi professionali MuleSoft e il lavoro dei partner è pensata per garantire scalabilità e coerenza architetturale. “E se il cliente decide di cambiare il modello di deployment, può farlo in modo quasi seamless, senza riscrivere il codice”.

L’Italia in transizione: pilota oggi, impatto domani

L’adozione dell’AI e delle architetture componibili in Italia è in piena fase di “prototipazione”. “Molte aziende stanno conducendo progetti pilota per misurare l’impatto reale degli agenti AI, perché oggi è difficile stimare i costi e i ritorni. Serve esperienza sul campo per costruire metriche affidabili”, afferma Andreoni.

A differenza degli Stati Uniti, dove i budget sono già allocati per iniziative strutturate, in Italia prevale un approccio tattico e modulare. “Si innova in piccolo, in tempi rapidi, per poi scalare se il ROI è dimostrabile. È una strategia prudente, ma efficace nel nostro contesto”.

Sicurezza, etica e ownership tecnologica

Nel contesto attuale, l’adozione su larga scala di strumenti di intelligenza artificiale e automazione impone alle aziende una riflessione profonda non solo in termini tecnologici, ma anche etici. Davide Andreoni sottolinea come questi temi non possano più essere considerati “accessori” ma vadano affrontati con rigore, a partire dal board aziendale.

“Quando abilitiamo agenti AI ad accedere ai dati aziendali, dobbiamo sapere esattamente dove vanno, cosa fanno e cosa imparano. L’AI non è più un laboratorio sperimentale, ma parte attiva nei processi core”.

Molte soluzioni AI – soprattutto quelle basate su modelli generativi o servizi cloud esterni – prevedono la trasmissione di prompt, documenti e strutture dati a piattaforme gestite da terze parti. Questo apre interrogativi sulla sovranità dei dati: quali informazioni vengono memorizzate? Possono essere utilizzate per addestrare altri modelli? Vengono davvero eliminate dopo l’uso?

Andreoni avverte: “Ci sono già casi pubblici in cui dati sensibili sono stati involontariamente reindicizzati o impiegati in contesti non previsti. È un rischio concreto. E riguarda ogni azienda che espone i propri sistemi a modelli AI pubblici senza un layer di controllo adeguato”.

Un’etica by design: auditability, explainability, controlli granulari

MuleSoft adotta un approccio “etico by design” che prevede il monitoraggio centralizzato delle chiamate API, con logging, tracciabilità e versioning e controlli granulari su scope, permessi, soglie di consumo; l’integrazione espone dati e funzioni, ma la business logic e la sicurezza sono separate e gestibili indipendentemente; il deployment è anche possibile on-prem o in cloud privati, requisito necessario per settori con requisiti normativi forti (es. sanità, finanza, pubblica amministrazione).

“Un agente AI deve potersi spiegare. Deve essere verificabile. E le aziende devono poter stabilire in modo puntuale cosa può o non può fare. Non basta un firewall: serve un’architettura pensata per il controllo”, sottolinea Andreoni.

L’altra faccia dell’etica è l’impatto sull’organizzazione umana. Gli agenti, le automazioni e i modelli generativi devono liberare risorse per attività a maggiore valore aggiunto, non sostituire competenze indiscriminatamente.

“Gli agenti migliorano di giorno in giorno, ma non sono ancora pronti a sostituire l’intelligenza critica umana. L’obiettivo è aumentare la produttività e stimolare l’ingegno, non ridurre le persone a operatori passivi”.

Andreoni evidenzia come molte aziende italiane stiano affrontando questo tema con pragmatismo: “Si parte con progetti pilota, si misura l’impatto e si decide se e come scalare. È una forma di etica operativa, che va incoraggiata”.