Con NVIDIA Blackwell, i microservizi NIM e gli AI Blueprints, gli sviluppatori e gli appassionati possono sfruttare le potenti prestazioni dell’AI locale.

Le GPU GeForce RTX 5090 e 5080 di NVIDIA, basate sull’innovativa architettura NVIDIA Blackwell, garantiscono prestazioni straordinarie con frame rate fino a 8 volte più rapidi grazie a NVIDIA DLSS 4, una latenza ridotta con NVIDIA Reflex 2 e una qualità grafica superiore grazie agli shader neurali NVIDIA RTX.

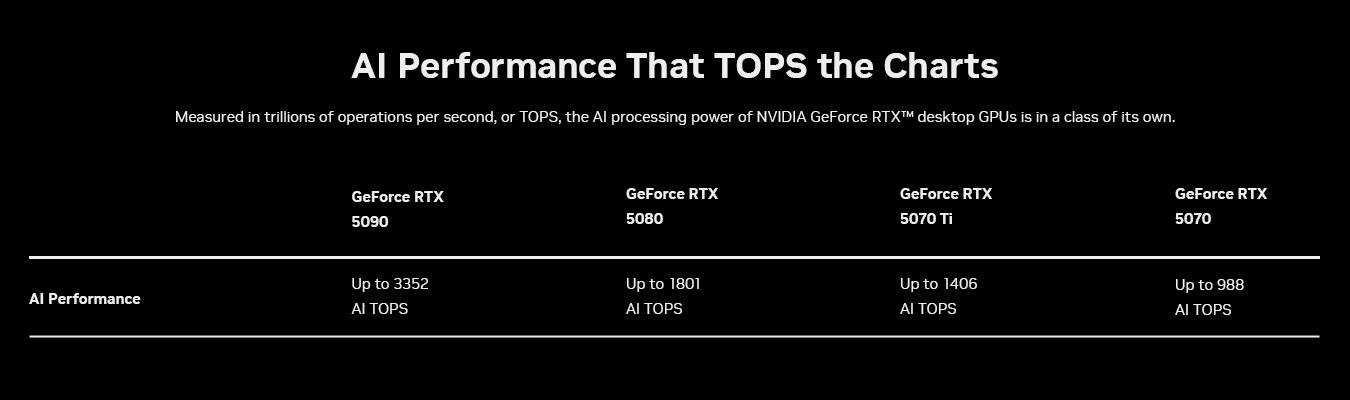

Progettate per accelerare i più recenti carichi di lavoro di intelligenza artificiale generativa, queste GPU offrono fino a 3.352 trilioni di operazioni AI al secondo (TOPS), offrendo esperienze eccezionali a gamer, creator, sviluppatori e appassionati di AI.

Per supportare sviluppatori e appassionati nell’adozione delle nuove capacità AI, NVIDIA ha presentato al CESlo scorso mese NVIDIA NIM e AI Blueprints. I microservizi NVIDIA NIM sono modelli preconfigurati di intelligenza artificiale generativa, pensati per consentire un avvio rapido, iterazioni veloci e sfruttare al massimo la potenza delle GPU RTX per accelerare l’IA su PC Windows.

Gli AI Blueprints, invece, forniscono progetti di riferimento che mostrano come utilizzare i microservizi NIM per creare esperienze AI di nuova generazione.

Entrambe le soluzioni sono ottimizzate per le GPU GeForce RTX Serie 50 e lavorano in perfetta sinergia per consentire a sviluppatori e appassionati di progettare, iterare e offrire esperienze di intelligenza artificiale all’avanguardia sui PC AI.

NVIDIA NIM accelera l’IA generativa sui PC

Nonostante lo sviluppo dei modelli di IA stia progredendo rapidamente, trasferire queste innovazioni sui PC continua a rappresentare una sfida. I modelli pubblicati su piattaforme come Hugging Face necessitano di essere curati, adattati e quantizzati per poter essere eseguiti su PC. Inoltre, devono essere integrati con nuove interfacce di programmazione delle applicazioni (API) per garantirne la compatibilità con i tool esistenti e trasformati in backend di inferenza ottimizzati, così da assicurare prestazioni elevate.

I microservizi NVIDIA NIM per PC e workstation RTX AI semplificano questo processo, offrendo un accesso diretto ai modelli AI sviluppati sia dalla community che da NVIDIA. Facili da scaricare e connettere tramite API standard del settore, questi microservizi coprono le principali funzionalità essenziali per i PC AI e sono compatibili con una vasta gamma di strumenti di IA. Inoltre, offrono opzioni di implementazione flessibili, sia su PC che in data center o nel cloud.

I microservizi NIM includono tutto il necessario per eseguire modelli ottimizzati su PC con GPU RTX, come engine precostituiti per specifiche GPU, il software development kit (SDK) NVIDIA TensorRT, la libreria open-source NVIDIA TensorRT-LLM per l’inferenza accelerata con i Tensor Core e molto altro.

Microsoft e NVIDIA hanno collaborato per integrare i microservizi NIM e i Blueprint AI per RTX nel Windows Subsystem for Linux (WSL2). Grazie a WSL2, i container di AI che tradizionalmente operano sulle GPU dei data center possono ora essere eseguiti in modo efficiente sui PC RTX, semplificando per gli sviluppatori la creazione, il test e la distribuzione dei modelli AI su tutte le piattaforme. Inoltre, NIM e AI Blueprints sfruttano le innovazioni dell’architettura Blackwell, alla base della serie GeForce RTX 50, inclusi i Tensor Cores di quinta generazione e il supporto per la precisione FP4.

I Tensor Core potenziano le prestazioni dell’AI di nuova generazione

I calcoli richiesti dall’intelligenza artificiale sono estremamente complessi e necessitano di enormi capacità di elaborazione. Che si tratti di generare immagini e video, comprendere il linguaggio o prendere decisioni in tempo reale, i modelli di AI si fondano su centinaia di trilioni di operazioni matematiche al secondo. Per affrontare questa sfida, i computer devono disporre di hardware specializzato, progettato appositamente per le esigenze dell’IA.

Nel 2018, le GPU NVIDIA GeForce RTX hanno rivoluzionato il settore introducendo i Tensor Cores, processori dedicati all’intelligenza artificiale progettati per gestire carichi di lavoro altamente intensivi. A differenza dei core di calcolo tradizionali, i Tensor Cores sono ottimizzati per accelerare i calcoli dell’AI, eseguendoli in modo più rapido ed efficiente. Questa innovazione ha reso mainstream l’uso dell’AI nei giochi, nei tool creativi e nelle applicazioni di produttività.

L’architettura Blackwell porta l’accelerazione dell’AI a un nuovo livello. I Tensor Core di quinta generazione delle GPU Blackwell offrono fino a 3.352 AI TOPS, consentendo di gestire compiti di AI ancora più complessi ed eseguire simultaneamente più modelli. Ciò si traduce in esperienze AI più rapide, dal rendering in tempo reale agli assistenti intelligenti, aprendo la strada a nuove opportunità di innovazione nei giochi, nella creazione di contenuti e in molti altri ambiti.

FP4 – Modelli più piccoli, prestazioni più elevate

Un altro modo per ottimizzare le prestazioni dell’AI è la quantizzazione, una tecnica che riduce le dimensioni dei modelli, consentendo loro di funzionare più velocemente e riducendo i requisiti di memoria.

L’FP4 è un formato di quantizzazione avanzato che consente di eseguire i modelli di AI in modo più rapido e snello senza compromettere la qualità dell’output. Rispetto a FP16, riduce le dimensioni dei modelli fino al 60% e migliora le prestazioni, raddoppiandole, con un degrado minimo.

Ad esempio, il modello FLUX.1 [dev] di Black Forest Labs con FP16 richiede oltre 23 GB di VRAM, il che significa che può essere supportato solo dalle GPU GeForce RTX 4090 e professionali. Con FP4, FLUX.1 [dev] richiede meno di 10 GB, quindi può essere eseguito localmente su più GPU GeForce RTX.

Su una GeForce RTX 4090 con FP16, il modello FLUX.1 [dev] può generare immagini in 15 secondi con soli 30 passaggi. Con una GeForce RTX 5090 con FP4, le immagini possono essere generate in poco più di cinque secondi.

Gli AI Blueprints consentono di sviluppare workflow AI avanzati su PC RTX

Gli NVIDIA AI Blueprints, basati su microservizi NIM, offrono implementazioni di riferimento pronte all’uso e ottimizzate, semplificando lo sviluppo di progetti avanzati basati sull’intelligenza artificiale, sia per la creazione di umani digitali che per generatori di podcast o assistenti applicativi.

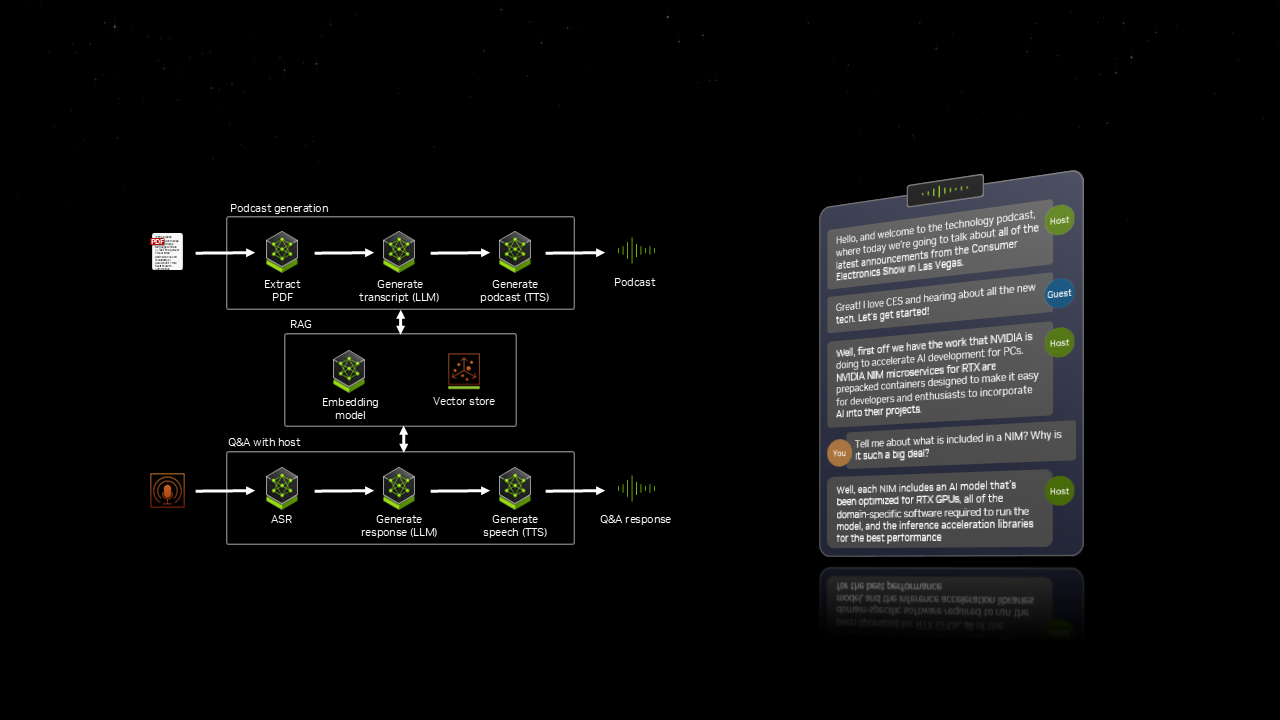

Al CES, NVIDIA ha presentato PDF to Podcast, un blueprint che consente agli utenti di convertire un PDF in un podcast divertente e di creare successivamente un Q&A con l’ospite del podcast AI. Questo workflow integra sette diversi modelli di intelligenza artificiale, che lavorano tutti in sincronia per offrire un’esperienza dinamica e interattiva.

Con AI Blueprints, gli utenti possono passare rapidamente dalla sperimentazione allo sviluppo dell’intelligenza artificiale su PC e workstation RTX.

NIM e AI Blueprints in arrivo su PC e workstation RTX

L’AI generativa sta ampliando le possibilità nei giochi, nella creazione di contenuti e in molti altri ambiti. Grazie ai microservizi NIM e agli AI Blueprints, i più recenti progressi dell’AI non sono più confinati al cloud, ma sono ora ottimizzati per i PC RTX. Con le GPU RTX, sviluppatori e appassionati possono sperimentare, costruire e distribuire soluzioni AI in locale, direttamente dai loro PC e workstation.

I microservizi NIM e gli AI Blueprints sono in arrivo, con supporto iniziale per le GPU GeForce RTX Serie 50, GeForce RTX 4090 e 4080, oltre alle GPU professionali NVIDIA RTX 6000 e 5000. Altre GPU saranno supportate in futuro.