L’intelligenza artificiale è entrata nella sua fase industriale. Non parliamo più di progetti pilota o hackathon interni, ma di piattaforme che alimentano supply chain, customer care, risk management, operations. Lo conferma il recente rapporto di Cloudera “The Evolution of AI: The State of Enterprise AI and Data Architecture”, condotto su oltre 1.500 leader IT in 15 Paesi, con una metodologia mista che combina questionari strutturati e interviste qualitative a CIO, CDO, responsabili data platform e capi sicurezza. Il quadro è chiaro: l’adozione è ormai pervasiva, ma la qualità e la governance dei dati restano la variabile critica. Se il 96% delle aziende ha già introdotto soluzioni di AI nei processi core, solo una quota marginale dichiara piena visibilità e tracciabilità end-to-end delle informazioni che alimentano i modelli. È la contraddizione di questa fase: l’AI è ovunque, spesso però costruita su fondamenta fragili.

Fabio Pascali, Regional Vice President Italy, Greece & Cyprus di Cloudera, è netto: “Stiamo costruendo l’AI su basi non sempre solide. Se non abbiamo fiducia nei dati, non possiamo fidarci dei risultati che l’intelligenza artificiale genera”. Il punto è culturale prima che tecnologico: l’affidabilità non nasce dalla potenza dei modelli, ma dalla qualità informativa e dalla disciplina con cui il dato viene acquisito, arricchito, custodito, distribuito e messo a disposizione dei team. In questa prospettiva, la piattaforma non è un software: è un sistema nervoso che regola l’intero ciclo di vita della conoscenza.

Il 70% dei CIO intervistati prevede di aumentare gli investimenti in data management e data security nei prossimi dodici mesi; oltre la metà sta già implementando framework interni di AI governance: cataloghi attivi, policy di accesso basate su ruoli e attributi, auditing end-to-end degli utilizzi, metriche di drift e di fairness, processi di revisione indipendente.

È il segnale di una maturazione reale: la competizione non è più sull’algoritmo “di moda”, ma sulla disciplina con cui si costruisce e si governa il dato. “L’AI è ovunque, ma non ovunque è matura”, osserva Yari Franzini, Group Vice President Southern Europe di Cloudera. “L’Europa può distinguersi perché ha messo la governance al centro della sua strategia”.

Dal volume al valore

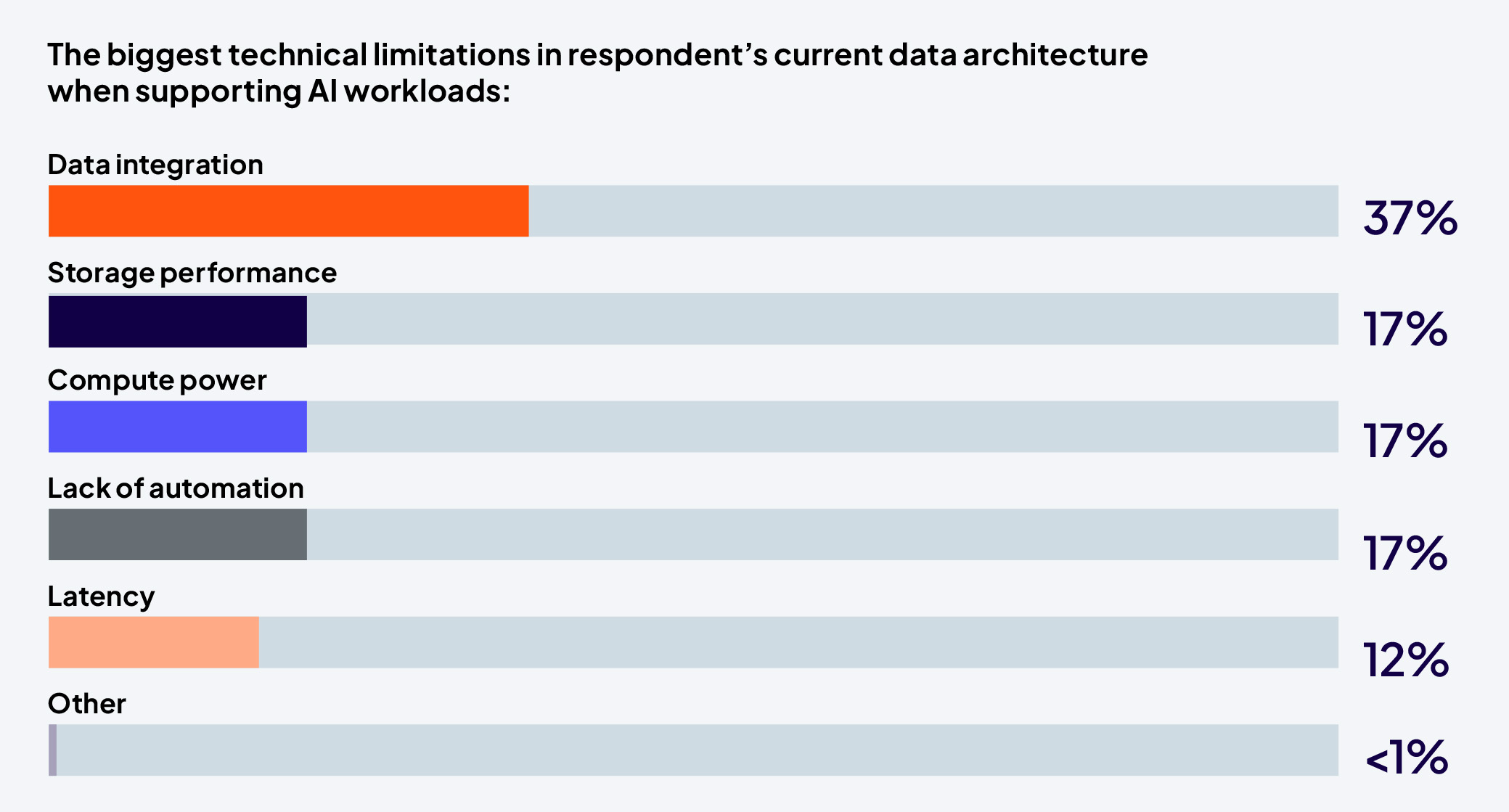

Per un decennio abbiamo misurato la modernità di un’organizzazione dal volume dei dati raccolti. Oggi a fare la differenza è la qualità: coerenza semantica, provenienza verificabile, accessibilità controllata, freschezza e osservabilità. La survey Cloudera indica che la frammentazione dei dataset è percepita come barriera principale all’evoluzione dell’AI: sistemi legacy non dismessi, data mart ridondanti, cloud multipli con policy divergenti, ambienti edge non governati. “Le imprese italiane hanno montagne di dati, ma spesso non sanno da quale versante scalarle”, osserva Pascali. “La svolta avviene quando il dato smette di essere un archivio e diventa una piattaforma condivisa e governata”.

Questa transizione richiede un approccio operativo chiaro. Primo: inventariare e classificare, attribuendo responsabilità (data ownership) e livelli di criticità per privacy, sicurezza, impatto sul business. Secondo: centralizzare i metadati in un catalogo veramente vivo, integrato nei workflow di sviluppo e di esercizio, con API che alimentano automaticamente lineage e quality score. Terzo: standardizzare e pulire, con controlli automatizzati (profiling, deduplica, conformità di schema) e regole di versioning coerenti. Quarto: portare l’AI ai dati, consentendo a modelli e pipeline di lavorare in prossimità della fonte informativa – riducendo latenza, copie e rischi di esposizione. Quinto: misurare il valore con indicatori aderenti al business (accuratezza effettiva in produzione, tempo al risultato, riduzione degli errori operativi, tasso di riuso di feature e pipeline).

L’effetto, nel medio periodo, è una diversa “contabilità dell’innovazione”: i dati e i modelli smettono di essere costo a consumo e diventano capitale cognitivo. Store condivisi, pattern di integrazione riutilizzabili, set di controlli standardizzati creano una base su cui innestare nuovi casi d’uso senza ripartire da zero; l’AI smette di vivere in progetti isolati e assume la forma di una piattaforma di conoscenza che cresce nel tempo.

L’ibrido come normalità operativa

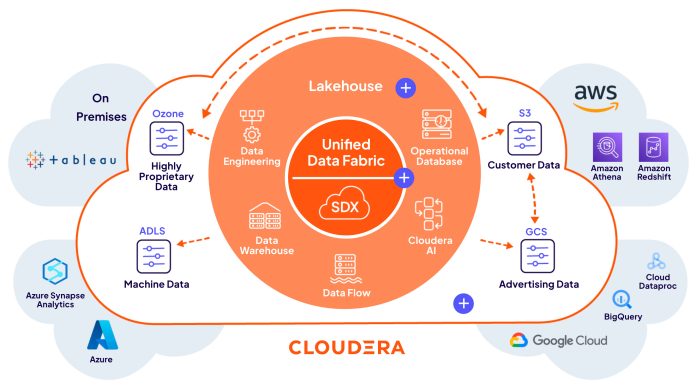

Il modello cloud-only ha ceduto il passo alla realtà dell’ibrido. I dati vivono contemporaneamente in data center, cloud pubblici, cloud privati ed edge. Il punto non è più scegliere “dove” collocare tutto, ma garantire che il dato resti governato “ovunque” e che i controlli si muovano insieme a lui. “Il futuro non sarà né solo cloud né solo on-premise”, spiega Franzini. “Sarà ibrido per definizione, perché le aziende devono poter scegliere dove far vivere i propri dati in base a contesto e regolamentazione”.

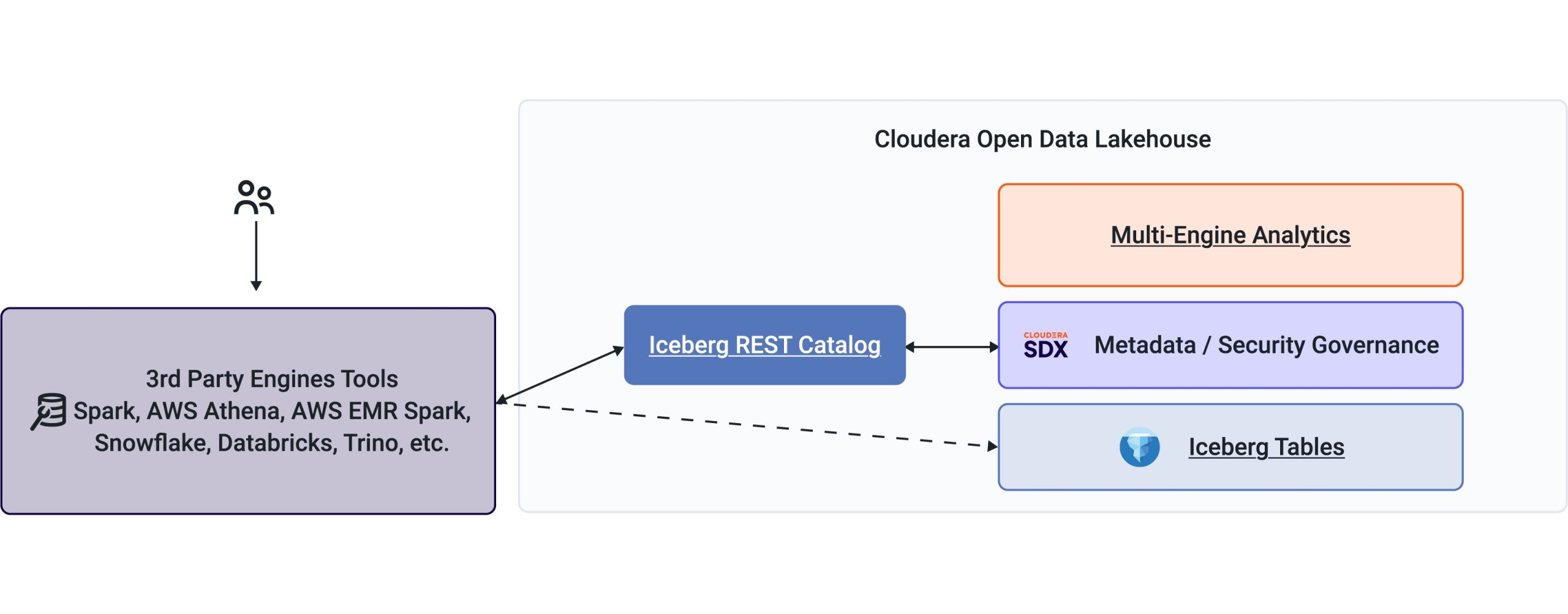

Cloudera traduce questo paradigma in un data lakehouse unificato, basato su Apache Iceberg. Il REST Catalog introduce un linguaggio comune che consente di far lavorare motori diversi – da Databricks a Snowflake, da AWS Athena a Salesforce – sugli stessi dataset, senza copie e senza perdere coerenza transazionale. L’approccio zero-copy riduce i costi di storage, taglia il rischio di fork dei dati e accelera sensibilmente le query. Ma soprattutto elimina la patologia più costosa: i “dati divergenti” che obbligano i team a ricalibrare modelli, riconciliare KPI, risolvere incidenti nati da origini non allineate.

“L’ibrido è un patto tra business e tecnologia”, sintetizza Pascali. “Il valore non sta nella potenza di calcolo, ma nella fiducia nei dati”. In quest’ottica, l’hybrid diventa un livello di orchestrazione: policy, lineage, auditing e sicurezza vengono estesi in modo uniforme grazie al layer di governance SDX (Shared Data Experience), che funge da tessuto connettivo per pipeline, modelli e applicazioni. I controlli non sono più un recinto attorno al dato, ma un “carattere” che lo accompagna ovunque vadano elaborazione e inferenza.

Sul piano economico, l’ibrido consente di bilanciare CapEx e OpEx: sfruttare l’elasticità del cloud quando serve, ma riportare on-prem i carichi stabili o sensibili per governare costi e conformità. Nei progetti di AI industriale, questa “geometria variabile” è spesso l’unica strada per conciliare performance, latenza, sicurezza e prevedibilità finanziaria.

Sovranità e fiducia come architettura europea

Nel mercato europeo la parola chiave è sovranità. Non è sinonimo di chiusura, ma di autonomia operativa e responsabilità. Significa sapere dove risiedono i dati, chi li gestisce, quali leggi li tutelano, come vengono tracciati gli accessi e in che modo si possono esercitare i diritti degli interessati. “Sovranità non significa isolamento, ma garanzia”, chiarisce Pascali. “Le imprese devono poter scegliere dove risiedono i dati e chi vi accede, senza rinunciare alla collaborazione globale”.

La collaborazione tra Cloudera e AWS per l’European Sovereign Cloud rende concreto questo principio: dati e metadati restano all’interno dell’Unione Europea, su infrastrutture fisicamente separate e gestite da personale residente. La piattaforma dati di Cloudera è stata adattata a questo contesto con una logica esplicita – sovereign-by-design – che incorpora residenza, tracciabilità e autonomia come caratteristiche strutturali, non come impostazioni opzionali. “Il cloud sovrano offre un equilibrio concreto tra sicurezza, conformità e innovazione”, aggiunge Franzini. “È la base di un’AI europea autonoma”.

Sotto il profilo operativo, sovereign-by-design significa: controlli di accesso coerenti con la normativa UE, log a prova di audit, separazione dei ruoli tra chi amministra l’infrastruttura e chi può accedere ai dati, conservazione dei metadati in ambito europeo, possibilità di dimostrare in ogni momento residenza, versioning e lineage. Per la PA e i settori regolamentati – sanità, finanza, energia, difesa – questa architettura è spesso l’unica praticabile per scalare i casi d’uso senza frizioni legali.

IDC stima una crescita annua a doppia cifra degli investimenti in cloud sovrani: la fiducia è ormai una variabile economica. Un’azienda che sa dimostrare conformità e tracciabilità entra più facilmente in mercati sensibili, riduce i costi di audit e costruisce reputazione presso clienti e autorità. La governance diventa vantaggio competitivo misurabile.

AI privata come leva di indipendenza

Se la sovranità è il paradigma politico, l’AI privata ne è la declinazione tecnologica. La partnership tra Cloudera e Dell Technologies ha dato vita alla soluzione AI-in-a-Box, che coniuga ObjectScale (architettura a microservizi, S3-compatibile, scalabilità orizzontale) con i servizi della Cloudera Data Platform. La separazione tra livello oggetti e livello tabelle consente di ottimizzare i costi, mentre il supporto nativo a storage-tiering permette di spostare automaticamente i dati tra classi di calore in base a frequenza d’uso e requisiti di latenza. In produzione, i modelli sono esposti tramite endpoint gestiti con policy di rate-limit e autenticazione forte; i registri di modello conservano versioni, metriche e collegamenti al lineage dei dati di training.

“Molte imprese hanno scoperto che il cloud pubblico genera costi imprevedibili e rischi di compliance”, osserva Pascali. “AI-in-a-Box riporta la potenza dell’AI all’interno dell’azienda, in un ambiente governato e sovrano”.

La soluzione consente addestramento, deployment e monitoraggio dei modelli senza esportare dati critici, con auditing continuo e conformità a GDPR e AI Act. La catena è completa: sviluppo in ambienti sicuri (AI Workbench), rilascio controllato (Inference Service), orchestrazione di agenti intelligenti (Agent Studio). È pensata per chi vuole una curva dei costi prevedibile: meno consumo variabile, più controllo su capacità e performance. Ma soprattutto rappresenta una forma di continuità cognitiva: i team lavorano sugli stessi dataset e sugli stessi metadati in ogni fase del ciclo di vita del modello.

Dal punto di vista organizzativo, l’AI privata facilita la separazione dei doveri (segregation of duties), rende più semplice l’applicazione di politiche di minimizzazione del dato e abilita sandbox regolamentari in cui sperimentare tecniche come synthetic data, differential privacy, distillazione di modelli e fine-tuning controllato su domini specifici. È la forma più concreta di AI industriale: potenza, controllo e responsabilità nello stesso perimetro.

Interoperabilità come libertà digitale

L’Europa ha riscoperto gli standard aperti come base della propria autonomia tecnologica. Cloudera è tra i principali contributori di Apache Iceberg, formato aperto per gestire tabelle su scala massiva con versioning, schema evolution e time travel. Il nuovo REST Catalog aggiunge l’elemento mancante: una porta d’accesso uniforme che rende i dati portabili tra motori e ambienti senza riformattazioni né copie. “Più un ecosistema è interoperabile, più è resiliente”, afferma Pascali. “Gli standard aperti non sono un favore ai competitor, ma un patto con il futuro”.

Lo zero-copy data sharing consente a team differenti di interrogare lo stesso dato con strumenti diversi, evitando “isole analitiche” e “modelli cannibali” che competono sulla verità dei numeri. Integrato con SDX, il catalogo mantiene lineage e controlli granulari anche quando i dati sono interrogati da strumenti terzi. Franzini lega esplicitamente l’open al tema politico: “L’open source è la ricetta concreta per la libertà digitale. Solo standard aperti ci permettono di costruire un’AI europea indipendente”. Sul piano della sostenibilità, l’apertura produce un effetto di lungo periodo: riduce il lock-in, stabilizza i costi, prolunga la vita utile dei dati perché li rende indipendenti dalla piattaforma che li elabora. Un dataset salvato oggi in Iceberg sarà accessibile domani da strumenti che ancora non esistono, senza migrazioni traumatiche.

Sicurezza by design, dal training all’inferenza

Se l’interoperabilità è la libertà, la sicurezza è la fiducia. Cloudera la concepisce come principio di progetto. “La sicurezza non è un add-on”, ribadisce Pascali. “Se la si costruisce a valle, i modelli restano deboli. Se la si progetta a monte, diventa parte della fiducia digitale”. Due sono i momenti critici e un filo rosso li collega: la tracciabilità.

Nel training, ogni spostamento di dati crea superficie d’attacco: copie ridondanti, ambienti non sovrani, tracciamento incompleto, supply chain software opache. L’AI privata consente di mantenere i dataset nei confini aziendali e di operare in “zone di addestramento” isolate, con logging severo e accessi profilati. Tecniche come data masking, tokenizzazione, synthetic data e federated learning riducono l’esposizione senza azzerare la qualità informativa. Modelli e dataset vengono firmati e versionati per ricostruire con precisione contesti e responsabilità.

Nell’inferenza, il rischio si rovescia: prompt, context window e output generativi possono veicolare informazioni sensibili o comportamenti inattesi (prompt injection, data exfiltration, jailbreaking). Qui intervengono policy runtime, filtraggio e osservabilità: SDX estende autenticazione, autorizzazione, lineage e auditing all’interazione con il modello; sistemi di monitoraggio verificano drift, bias e anomalie; i controlli di contenuto impediscono l’uscita di informazioni non autorizzate. L’obiettivo è una sicurezza che non rallenta, ma rende più rapida la messa in produzione perché previene incidenti e consente di dimostrare conformità.

“Non esiste sicurezza senza sovranità, né sovranità senza interoperabilità”, sottolinea Franzini. È il triangolo europeo dell’AI affidabile: protezione by design, dati sotto controllo, apertura governata. Pascali chiude la sintesi con una immagine efficace: “La sicurezza deve essere come la gravità: invisibile ma sempre presente”.

La cultura del dato come capitale cognitivo

La rivoluzione dell’AI è prima di tutto culturale. Solo un’impresa su quattro si definisce davvero data-driven, e questo limita la scalabilità dei progetti. “L’AI non è un costo a consumo, ma un investimento in conoscenza”, afferma Franzini. “Ogni modello addestrato e ogni pipeline validata generano valore che resta”. Il capitale cognitivo è la somma di dataset certificati, feature store consolidati, modelli verificabili, pratiche di MLOps e DataOps diffuse: un patrimonio che cresce nel tempo e riduce l’attrito tra idea e produzione.

Le aziende che possiedono una governance matura riportano ritorni superiori: più riuso di componenti, meno tempo perso in riconciliazioni, meno rischio di decisioni incoerenti. Questo valore si misura anche nella rapidità di risposta ai cambiamenti: chi governa i dati sa dove intervenire quando il modello devia, sa riprodurre esperimenti, sa spiegare le scelte all’audit e al cliente. Pascali lo riassume così: “Non c’è automazione senza controllo umano, né intelligenza artificiale senza intelligenza organizzativa”.

L’Italia come laboratorio dell’AI industriale

Il contesto italiano è un banco di prova ideale. Un tessuto di PMI e grandi gruppi che unisce creatività e disciplina operativa, con filiere complesse e dati ricchi ma spesso frammentati. “Il nostro tessuto produttivo è unico in Europa”, osserva Pascali. “Può trasformare l’esperienza operativa in conoscenza digitale”. La manifattura integra visione artificiale per il controllo qualità in linea, la finanza adotta modelli di rischio spiegabili e stress test basati su scenari generativi, la sanità sperimenta triage digitale e analisi di percorso clinico, la PA spinge su interoperabilità dei registri e automazione documentale.

Franzini nota un cambio di passo: “Oggi le aziende non chiedono più che cos’è l’AI, ma come governarla. È il segno di un mercato che ha capito che la tecnologia va integrata, non solo adottata”. Le partnership con AWS per il cloud sovrano e con Dell per l’AI privata offrono all’Italia un’infrastruttura europea di fiducia: federata, interoperabile, conforme. I dati possono restare locali, le conoscenze circolare: una rete di intelligenza distribuita che rispecchia l’identità produttiva del Paese. A questo si aggiunge il ruolo degli integratori e delle università: la filiera della competenza è l’elemento che trasforma piattaforme in risultati.

Il contesto regolatorio: dall’AI Act al Data Act

Il quadro europeo si sta consolidando attorno a tre pilastri. L’AI Act introduce classificazioni di rischio e obblighi di trasparenza, richiede sistemi di gestione per la qualità e la tracciabilità e impone funzioni di sorveglianza post-market. Il Data Governance Act incentiva la condivisione sicura dei dati, mentre il Data Act rafforza la portabilità e limita i vincoli di uscita dai servizi cloud. La combinazione di questi atti spinge verso architetture spiegabili, osservabili e portabili: è l’orizzonte tecnologico su cui Cloudera ha allineato piattaforma e partnership.

Casi d’uso emblematici in Italia

Nel Manufacturing, l’intelligenza artificiale viene utilizzata direttamente sulle linee produttive per il controllo qualità e la taratura delle macchine. I modelli sono addestrati on-premise, ma l’inferenza avviene in edge per mantenere una latenza inferiore ai 50 millisecondi. Grazie a retraining settimanali su campioni etichettati dal reparto qualità, il sistema riduce progressivamente i falsi positivi e migliora la precisione nel riconoscimento dei difetti.

Nel settore Energy, l’AI serve a prevedere i picchi di domanda e ottimizzare i cicli di manutenzione degli impianti. I modelli vengono calibrati in modo dinamico combinando dati meteo, consumi storici e segnali provenienti dai sensori IoT. La piattaforma SDX di Cloudera assicura la tracciabilità delle decisioni automatiche, consentendo audit puntuali su ogni previsione o azione correttiva.

In ambito Healthcare, la tecnologia supporta il triage digitale e l’analisi dei percorsi clinici attraverso dati pseudonimizzati. L’AI privata permette di mantenere le informazioni all’interno dei confini nazionali, rispettando i principi di residenza e minimizzazione del dato previsti dal GDPR. In questo modo, i modelli possono evolvere senza compromettere la riservatezza dei pazienti.

L’AI come infrastruttura della fiducia

L’intelligenza artificiale europea non sarà la più veloce, ma la più affidabile. È la visione che guida Cloudera: costruire un ecosistema aperto, governato e sicuro, dove ogni dato e ogni modello siano tracciabili e verificabili. “Il futuro dell’AI non sarà deciso da chi ha più GPU, ma da chi saprà orchestrare meglio i propri dati”, osserva Pascali. La fiducia non è un effetto collaterale: è l’infrastruttura portante dell’AI industriale. Ed è su questa architettura – fatta di sovranità, interoperabilità e cultura del dato – che l’Europa può costruire la propria leadership digitale.