Apple ha annunciato le nuove funzioni per l’accessibilità che arriveranno nel corso dell’anno, tra cui Accessibility Nutrition Labels, che fornirà informazioni più dettagliate per le app e i giochi sull’App Store.

Gli utenti ciechi o ipovedenti potranno esplorare, imparare e interagire con la nuova app Magnifier per Mac, prendere appunti ed eseguire calcoli con la nuova funzione Braille Access e sfruttare il potente sistema di fotocamere di Apple Vision Pro con i nuovi aggiornamenti di visionOS.

Altri annunci includono Accessibility Reader, una nuova modalità di lettura per tutto il sistema progettata tenendo conto dell’accessibilità, oltre agli aggiornamenti di Live Listen, Background Sounds, Personal Voice, Vehicle Motion Cues e altro ancora. Sfruttando la potenza del silicio Apple, insieme ai progressi nell’apprendimento automatico e nell’intelligenza artificiale dei dispositivi, gli utenti potranno sperimentare un nuovo livello di accessibilità in tutto l’ecosistema Apple.

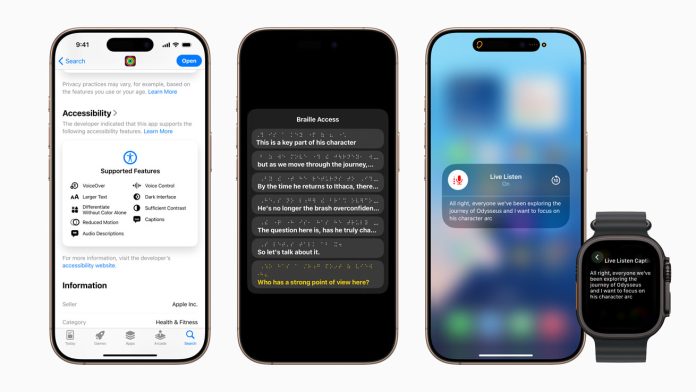

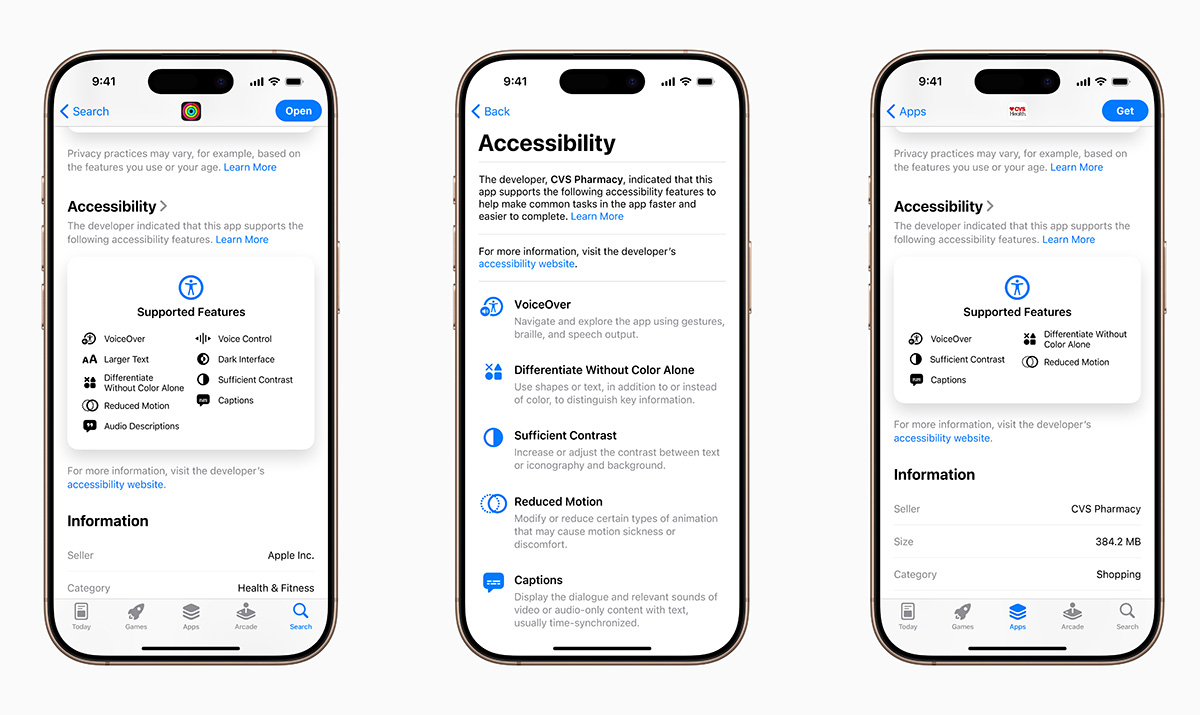

Le “etichette nutrizionali per l’accessibilità”, Accessibility Nutrition Labels, introducono una nuova sezione nelle pagine dei prodotti dell’App Store che evidenzierà le caratteristiche di accessibilità di app e giochi. Queste etichette offrono agli utenti un nuovo modo per sapere se un’applicazione sarà accessibile prima di scaricarla e agli sviluppatori l’opportunità di informare e istruire meglio gli utenti sulle funzionalità supportate dalle loro applicazioni.

Le “etichette nutrizionali per l’accessibilità”, Accessibility Nutrition Labels, introducono una nuova sezione nelle pagine dei prodotti dell’App Store che evidenzierà le caratteristiche di accessibilità di app e giochi. Queste etichette offrono agli utenti un nuovo modo per sapere se un’applicazione sarà accessibile prima di scaricarla e agli sviluppatori l’opportunità di informare e istruire meglio gli utenti sulle funzionalità supportate dalle loro applicazioni.

Queste includono VoiceOver, Voice Control, Larger Text, Sufficient Contrast, Reduced Motion, didascalie e altro ancora. Le etichette sull’accessibilità saranno disponibili sull’App Store in tutto il mondo e gli sviluppatori potranno accedere a maggiori indicazioni sui criteri che le app devono soddisfare prima di visualizzare le informazioni sull’accessibilità nelle pagine dei loro prodotti.

Dal 2016, Lente d’ingrandimento su iPhone e iPad offre agli utenti ciechi o ipovedenti strumenti per ingrandire, leggere il testo e rilevare gli oggetti intorno a loro. Quest’anno Lente d’ingrandimento arriva su Mac per rendere il mondo fisico più accessibile agli utenti ipovedenti. L’applicazione Magnifier per Mac si collega alla fotocamera dell’utente per consentirgli di ingrandire l’ambiente circostante, come uno schermo o una lavagna. Lente d’ingrandimento funziona con Continuity Camera su iPhone e con le fotocamere USB collegate e supporta la lettura di documenti con Desk View.

Dal 2016, Lente d’ingrandimento su iPhone e iPad offre agli utenti ciechi o ipovedenti strumenti per ingrandire, leggere il testo e rilevare gli oggetti intorno a loro. Quest’anno Lente d’ingrandimento arriva su Mac per rendere il mondo fisico più accessibile agli utenti ipovedenti. L’applicazione Magnifier per Mac si collega alla fotocamera dell’utente per consentirgli di ingrandire l’ambiente circostante, come uno schermo o una lavagna. Lente d’ingrandimento funziona con Continuity Camera su iPhone e con le fotocamere USB collegate e supporta la lettura di documenti con Desk View.

Grazie a più finestre live session, gli utenti possono lavorare in multitasking visualizzando una presentazione con la webcam e seguendo contemporaneamente un libro con Desk View. Con le viste personalizzate, gli utenti possono regolare la luminosità, il contrasto, i filtri colore e persino la prospettiva per facilitare la visione di testo e immagini. Le viste possono anche essere catturate, raggruppate e salvate per aggiungervi contenuti in un secondo momento. Inoltre, Lente d’ingrandimento per Mac è integrato con un’altra nuova funzione di accessibilità, Accessibility Reader, che trasforma il testo del mondo fisico in un formato leggibile personalizzato.

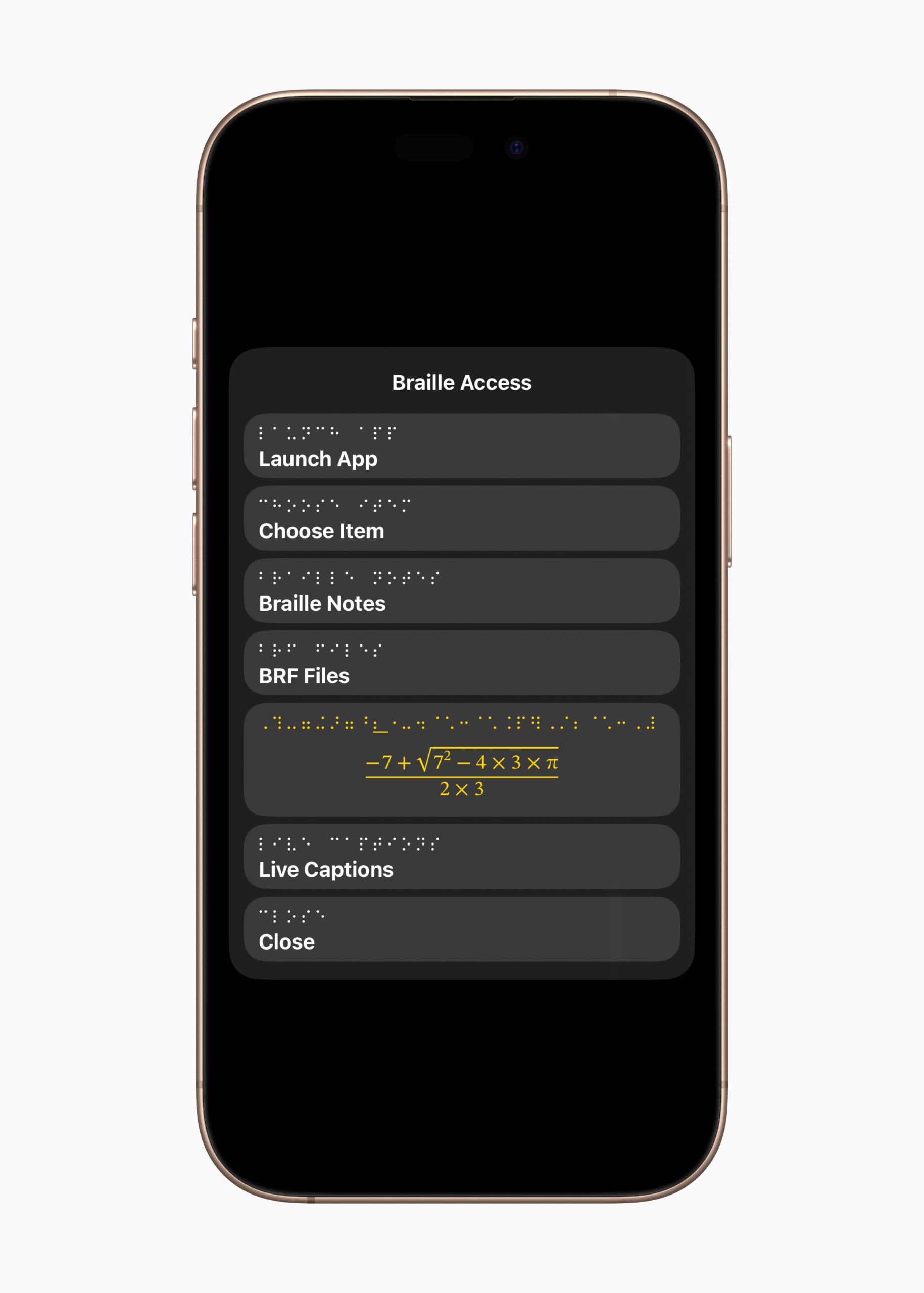

Braille Access è una nuova esperienza che trasforma iPhone, iPad, Mac e Apple Vision Pro in un registratore di note braille completo e profondamente integrato nell’ecosistema Apple. Grazie a un app launcher integrato, gli utenti possono aprire facilmente qualsiasi app digitando con Braille Screen Input o con un dispositivo braille collegato. Con Braille Access, gli utenti possono prendere rapidamente appunti in formato braille ed eseguire calcoli utilizzando il Nemeth Braille, un codice braille spesso utilizzato nelle classi di matematica e scienze. Gli utenti possono aprire i file Braille Ready Format (BRF) direttamente da Braille Access, sbloccando un’ampia gamma di libri e file precedentemente creati su un dispositivo braille per prendere appunti. Inoltre, una forma integrata di Live Captions consente agli utenti di trascrivere le conversazioni in tempo reale direttamente sui display braille.

Braille Access è una nuova esperienza che trasforma iPhone, iPad, Mac e Apple Vision Pro in un registratore di note braille completo e profondamente integrato nell’ecosistema Apple. Grazie a un app launcher integrato, gli utenti possono aprire facilmente qualsiasi app digitando con Braille Screen Input o con un dispositivo braille collegato. Con Braille Access, gli utenti possono prendere rapidamente appunti in formato braille ed eseguire calcoli utilizzando il Nemeth Braille, un codice braille spesso utilizzato nelle classi di matematica e scienze. Gli utenti possono aprire i file Braille Ready Format (BRF) direttamente da Braille Access, sbloccando un’ampia gamma di libri e file precedentemente creati su un dispositivo braille per prendere appunti. Inoltre, una forma integrata di Live Captions consente agli utenti di trascrivere le conversazioni in tempo reale direttamente sui display braille.

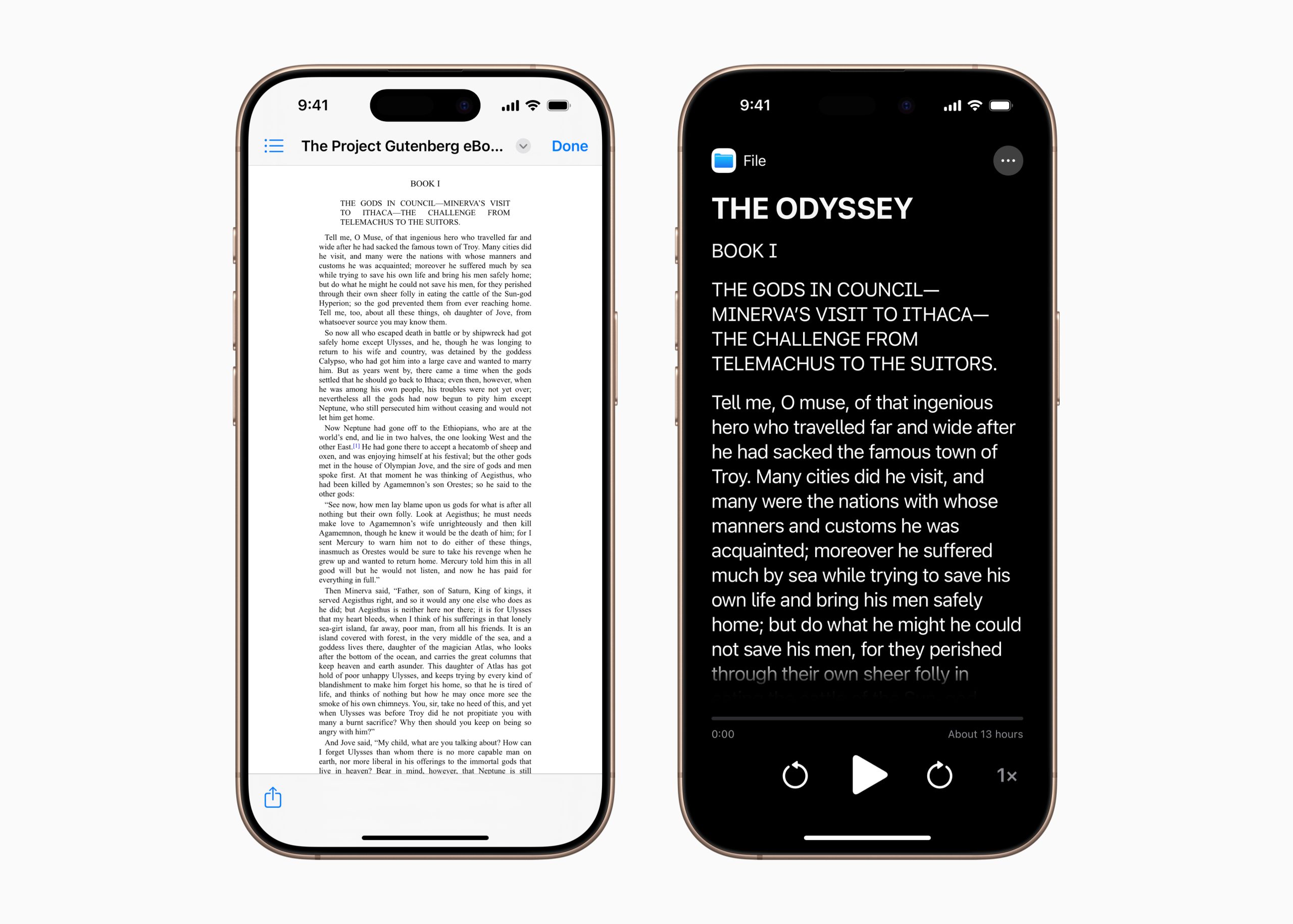

Accessibility Reader è una nuova modalità di lettura a livello di sistema progettata per facilitare la lettura del testo agli utenti con un’ampia gamma di disabilità, come la dislessia o l’ipovisione. Disponibile su iPhone, iPad, Mac e Apple Vision Pro, Accessibility Reader offre agli utenti nuovi modi per personalizzare il testo e concentrarsi sui contenuti che desiderano leggere, con ampie opzioni per i caratteri, il colore e la spaziatura, oltre al supporto per i contenuti vocali. Accessibility Reader può essere lanciato da qualsiasi app ed è integrato nell’app Lente d’ingrandimento per iOS, iPadOS e macOS, in modo che gli utenti possano interagire con il testo nel mondo reale, come nei libri o nei menu dei ristoranti.

Accessibility Reader è una nuova modalità di lettura a livello di sistema progettata per facilitare la lettura del testo agli utenti con un’ampia gamma di disabilità, come la dislessia o l’ipovisione. Disponibile su iPhone, iPad, Mac e Apple Vision Pro, Accessibility Reader offre agli utenti nuovi modi per personalizzare il testo e concentrarsi sui contenuti che desiderano leggere, con ampie opzioni per i caratteri, il colore e la spaziatura, oltre al supporto per i contenuti vocali. Accessibility Reader può essere lanciato da qualsiasi app ed è integrato nell’app Lente d’ingrandimento per iOS, iPadOS e macOS, in modo che gli utenti possano interagire con il testo nel mondo reale, come nei libri o nei menu dei ristoranti.

Per gli utenti non udenti o ipoudenti, i controlli Live Listen (“Ascolto dal vivo”) arrivano su Apple Watch con una nuova serie di funzioni, tra cui le Live Captions in tempo reale. Live Listen trasforma l’iPhone in un microfono remoto per trasmettere contenuti direttamente agli AirPods, agli apparecchi acustici Made for iPhone o alle cuffie Beats. Quando una sessione è attiva sull’iPhone, gli utenti possono visualizzare le didascalie in diretta di ciò che l’iPhone sente su un Apple Watch abbinato, ascoltando l’audio. L’Apple Watch funge da telecomando per avviare o interrompere le sessioni di Live Listen, o per tornare indietro in una sessione per catturare qualcosa che potrebbe essere stato perso. Con Apple Watch, le sessioni di Live Listen possono essere controllate dall’altra parte della stanza, senza doversi alzare nel bel mezzo di una riunione o di una lezione. Live Listen può essere utilizzato insieme alle funzioni per la salute dell’udito disponibili su AirPods Pro 2, tra cui la prima funzione di aiuto all’udito di livello clinico, sottolinea Apple.

Per gli utenti non udenti o ipoudenti, i controlli Live Listen (“Ascolto dal vivo”) arrivano su Apple Watch con una nuova serie di funzioni, tra cui le Live Captions in tempo reale. Live Listen trasforma l’iPhone in un microfono remoto per trasmettere contenuti direttamente agli AirPods, agli apparecchi acustici Made for iPhone o alle cuffie Beats. Quando una sessione è attiva sull’iPhone, gli utenti possono visualizzare le didascalie in diretta di ciò che l’iPhone sente su un Apple Watch abbinato, ascoltando l’audio. L’Apple Watch funge da telecomando per avviare o interrompere le sessioni di Live Listen, o per tornare indietro in una sessione per catturare qualcosa che potrebbe essere stato perso. Con Apple Watch, le sessioni di Live Listen possono essere controllate dall’altra parte della stanza, senza doversi alzare nel bel mezzo di una riunione o di una lezione. Live Listen può essere utilizzato insieme alle funzioni per la salute dell’udito disponibili su AirPods Pro 2, tra cui la prima funzione di aiuto all’udito di livello clinico, sottolinea Apple.

Per gli utenti ciechi o ipovedenti, visionOS amplierà le funzioni di accessibilità visiva utilizzando il sistema avanzato della fotocamera di Apple Vision Pro. Grazie ai potenti aggiornamenti allo Zoom, gli utenti possono ingrandire tutto ciò che vedono, compreso l’ambiente circostante, utilizzando la fotocamera principale. Per gli utenti di VoiceOver, il riconoscimento dal vivo (Live Recognition) di visionOS utilizza l’apprendimento automatico sul dispositivo per descrivere l’ambiente circostante, trovare oggetti, leggere documenti e altro ancora. Per gli sviluppatori di accessibilità, una nuova API consentirà alle app approvate di accedere alla fotocamera principale per fornire assistenza dal vivo da persona a persona per l’interpretazione visiva in app come Be My Eyes, offrendo agli utenti più modi per comprendere l’ambiente circostante a mani libere.

Ulteriori aggiornamenti di Apple per l’accessibilità

La personalizzazione dei suoni di sottofondo diventa più semplice grazie alle nuove impostazioni dell’equalizzatore, all’opzione di arresto automatico dopo un certo periodo di tempo e alle nuove azioni per le automazioni in Shortcuts. I suoni di sottofondo possono contribuire a ridurre al minimo le distrazioni per aumentare il senso di concentrazione e di rilassamento, che secondo alcuni utenti può essere utile per i sintomi dell’acufene.

Per gli utenti che rischiano di perdere la capacità di parlare, Personal Voice diventa più veloce, più facile e più potente che mai, sfruttando i progressi dell’apprendimento automatico e dell’intelligenza artificiale sul dispositivo per creare una voce più fluida e naturale in meno di un minuto, utilizzando solo 10 frasi registrate. Personal Voice aggiungerà anche il supporto per lo spagnolo (Messico).

Vehicle Motion Cues, che può aiutare a ridurre il mal d’auto quando si viaggia in un veicolo in movimento, arriva su Mac, insieme a nuove modalità di personalizzazione dei punti animati sullo schermo su iPhone, iPad e Mac.

Gli utenti dell’Eye Tracking (Tracciamento occhi) su iPhone e iPad possono ora scegliere di utilizzare uno switch o lo sguardo fisso per effettuare le selezioni. La digitazione della tastiera quando si utilizza l’Eye Tracking o lo Switch Control è ora più semplice su iPhone, iPad e Apple Vision Pro, con miglioramenti che includono un nuovo timer per il dwell sulla tastiera, la riduzione dei passaggi quando si digita con gli switch e l’abilitazione di QuickPath per iPhone e Vision Pro.

Con l’Head Tracking, gli utenti potranno controllare più facilmente iPhone e iPad con i movimenti della testa, in modo simile all’Eye Tracking.

Per gli utenti con gravi disabilità motorie, iOS, iPadOS e visionOS aggiungeranno un nuovo protocollo per supportare Switch Control per le interfacce cervello-computer (BCI, Brain Computer Interface), una tecnologia emergente che consente agli utenti di controllare il proprio dispositivo senza movimento fisico.

Accesso assistito aggiunge una nuova app Apple TV personalizzata con un lettore multimediale semplificato. Gli sviluppatori potranno inoltre usufruire di un supporto per la creazione di esperienze personalizzate per gli utenti con disabilità intellettive e dello sviluppo utilizzando le API di Assistive Access.

La funzione Feedback aptici musica su iPhone diventa più personalizzabile con la possibilità di sperimentare l’aptica per un’intera canzone o solo per le voci, oltre alla possibilità di regolare l’intensità complessiva di tocchi, texture e vibrazioni.

Riconoscimento suoni aggiunge il riconoscimento del nome, un nuovo modo per gli utenti ciechi o ipoudenti di sapere quando viene chiamato il loro nome.

Controllo vocale (Voice Control) introduce una nuova modalità di programmazione in Xcode per gli sviluppatori di software con mobilità limitata. Voice Control aggiunge anche la sincronizzazione del vocabolario tra i vari dispositivi e amplierà il supporto linguistico a coreano, arabo (Arabia Saudita), turco, italiano, spagnolo (America Latina), cinese mandarino (Taiwan), inglese (Singapore) e russo.

Trascrizioni live aggiunge il supporto all’inglese (India, Australia, Regno Unito, Singapore), al cinese mandarino (Cina continentale), al cantonese (Cina continentale, Hong Kong), allo spagnolo (America Latina, Spagna), al francese (Francia, Canada), al giapponese, al tedesco (Germania) e al coreano.

Gli aggiornamenti di CarPlay includono il supporto per i testi di grandi dimensioni. Con l’aggiornamento del riconoscimento sonoro in CarPlay, i conducenti o i passeggeri sordi o con difficoltà uditive possono ora essere avvisati del suono di un bambino che piange, oltre che di suoni esterni all’auto come clacson e sirene.

Share Accessibility Settings è un nuovo modo per gli utenti di condividere rapidamente e temporaneamente le proprie impostazioni di accessibilità con un altro iPhone o iPad. È l’ideale per prendere in prestito il dispositivo di un amico o per utilizzare un chiosco pubblico in un ambiente come un bar.

Per celebrare la Giornata mondiale della consapevolezza sull’accessibilità (Global Accessibility Awareness Day), Apple Retail sta introducendo tavoli dedicati che mettono in evidenza le funzioni di accessibilità su una varietà di dispositivi in punti vendita selezionati per tutto il mese di maggio. Inoltre, Apple offre tutto l’anno sessioni di accessibilità attraverso Today at Apple per approfondire le conoscenze, i suggerimenti e la personalizzazione delle funzioni. Le sessioni possono essere programmate in tutti gli Apple Store del mondo attraverso le Prenotazioni di gruppi o visitando uno store nelle vicinanze.